Nie een van ons het verwag dat dit is hoe 2025 in die KI-veld sou begin nie.

DeepSeek R1 is werklik ongelooflik!

Onlangs het die "geheimsinnige Oosterse mag" DeepSeek "hard beheer" van Silicon Valley.

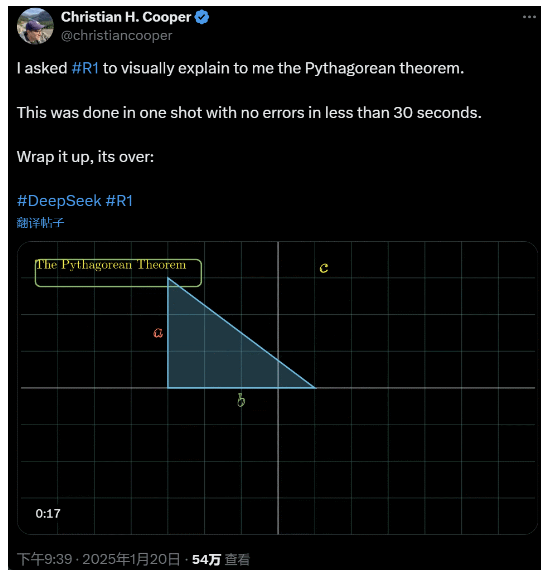

Ek het R1 gevra om die Pythagoras-stelling in detail te verduidelik. Dit alles is deur KI in minder as 30 sekondes gedoen sonder enige foute. Kortom, dit is verby.

In die binnelandse en buitelandse KI-kringe het gewone netizens die wonderlike en kragtige nuwe KI ontdek (wat ook oopbron is), en akademiese kenners het geskree "ons moet inhaal". Daar is ook hoorsê dat oorsese KI-maatskappye reeds 'n groot bedreiging in die gesig staar.

Neem net hierdie DeepSeek R1 wat hierdie week vrygestel is. Sy suiwer versterkingsleerroete sonder enige opleiding onder toesig is skokkend. Van die ontwikkeling van die Deepseek-v3-basis in Desember verlede jaar tot die huidige denkkettingvermoëns vergelykbaar met OpenAI o1, blyk dit 'n kwessie van tyd te wees.

Maar terwyl die KI-gemeenskap besig is om tegniese verslae te lees en werklike metings te vergelyk, twyfel mense steeds oor R1: behalwe dat hulle beter as 'n klomp maatstawwe kan presteer, kan dit werklik lei?

Kan dit sy eie simulasies van "fisiese wette" bou?

Glo jy dit nie? Laat ons die groot model met 'n flipper speel?

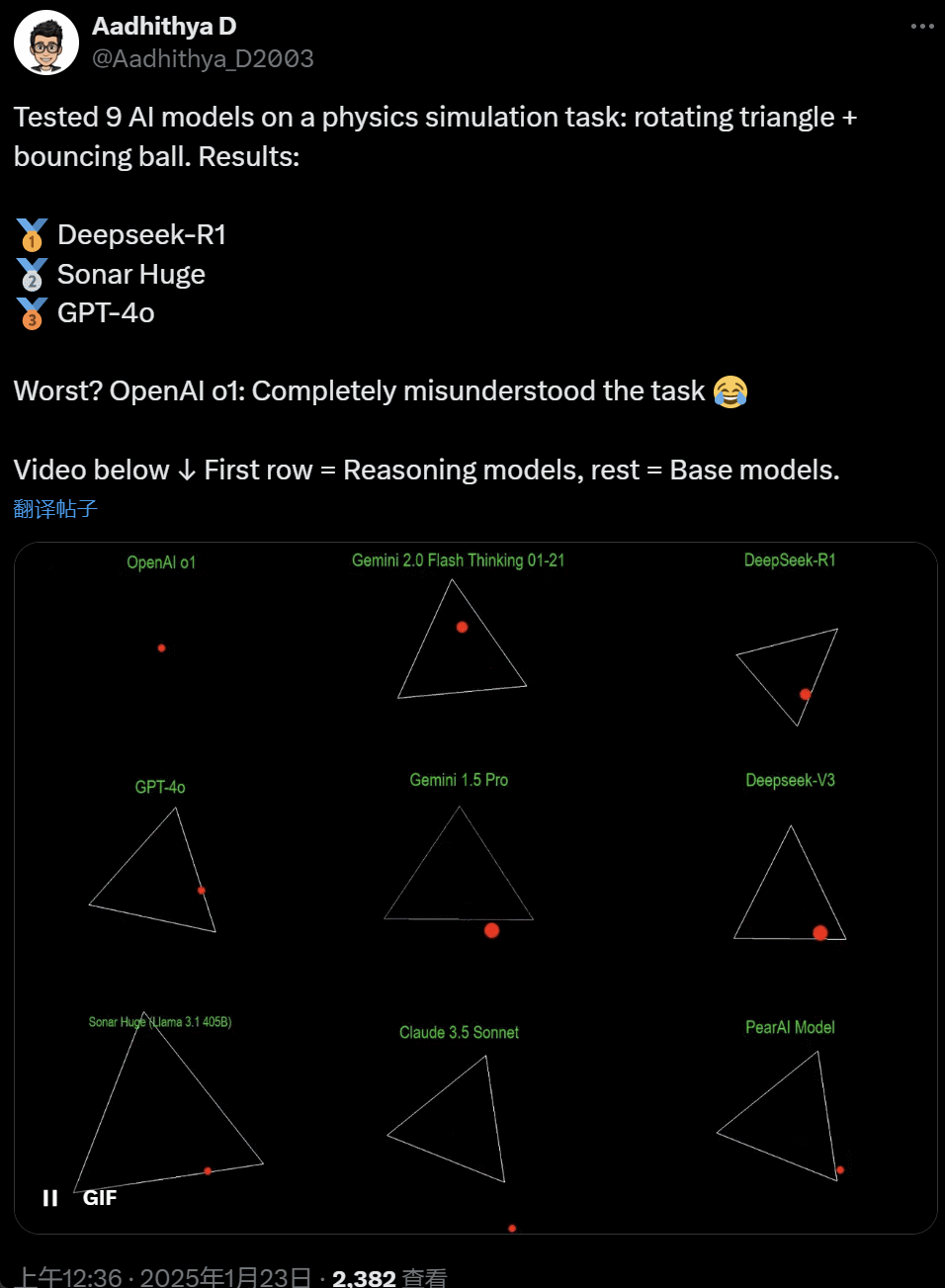

In onlangse dae het sommige mense in die KI-gemeenskap obsessief geraak met 'n toets – om verskillende KI-grootmodelle (veral die sogenaamde redenasiemodelle) te toets om 'n probleem op te los: "Skryf 'n Python-skrif om 'n geel bal in 'n sekere te laat bons. vorm. Laat die vorm stadig draai en maak seker dat die bal binne-in die vorm bly.”

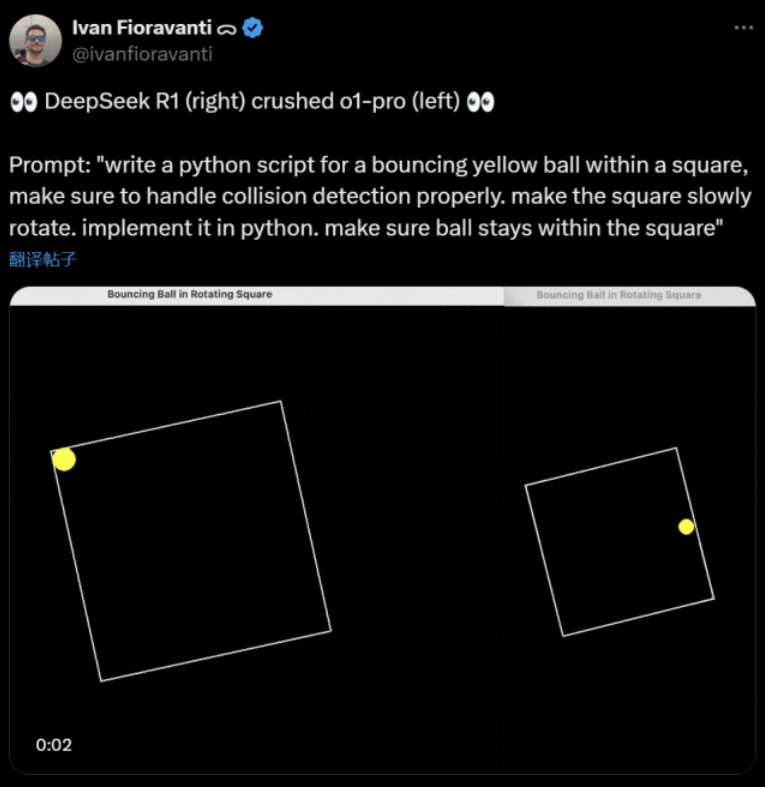

Sommige modelle vaar beter as ander in hierdie "roterende bal" maatstaf. Volgens CoreView CTO Ivan Fioravanti, het DeepSeek, 'n huishoudelike kunsmatige intelligensie-laboratorium, 'n oopbron-groot model R1 wat OpenAI se o1 pro-model klop, wat $200 per maand kos as deel van OpenAI se ChatGPT Pro-program.

Aan die linkerkant is OpenAI o1, en aan die regterkant is DeepSeek R1. Soos hierbo genoem, is die opdrag hier: "Skryf 'n luislangskrif vir 'n bonsende geel bal binne 'n vierkant, maak seker dat jy botsingsopsporing behoorlik hanteer. laat die vierkant stadig draai. implementeer dit in python. maak seker die bal bly binne die vierkant.”

Volgens 'n ander gebruiker op X het die Antropiese Claude 3.5 Sonnet en Google se Gemini 1.5 Pro-modelle verkeerde oordeel oor fisiese beginsels gemaak, wat veroorsaak het dat die bal van sy vorm afwyk. Sommige gebruikers het ook gerapporteer dat Google se nuutste Gemini 2.0 Flash Thinking Experimental, sowel as die relatief ouer OpenAI GPT-4o, die assessering dadelik geslaag het.

Maar daar is 'n manier om die verskil hier te onderskei:

Netizens onder hierdie twiet het gesê: o1 se vermoë was oorspronklik baie goed, maar dit het swakker geword nadat OpenAI die spoed geoptimaliseer het, selfs met die $200/maand lidmaatskap weergawe.

Om 'n bonsbal te simuleer is 'n klassieke programmeringsuitdaging. Akkurate simulasie kombineer botsingsopsporingsalgoritmes, wat moet identifiseer wanneer twee voorwerpe (soos 'n bal en die sy van 'n vorm) bots. 'n Onbehoorlik geskrewe algoritme kan die prestasie van die simulasie beïnvloed of ooglopende fisiese foute veroorsaak.

N8 Programs, 'n navorser by die KI-opstartonderneming Nous Research, het gesê dit het hom ongeveer twee uur geneem om 'n bonsende bal in 'n roterende sewehoek van nuuts af te skryf. "Verskeie koördinaatstelsels moet nagespoor word, 'n begrip van hoe botsings in elke stelsel hanteer word, en die kode moet van nuuts af ontwerp word om robuust te wees."

Alhoewel bonsballe en draaiende vorms 'n redelike toets van programmeringsvaardighede is, is dit steeds nuwe projekte vir groot modelle, en selfs klein veranderinge in die aanwysings kan verskillende resultate lewer. As dit dus uiteindelik deel van die maatstaftoets vir groot KI-modelle moet word, moet dit steeds verbeter word.

In elk geval, na hierdie vlaag praktiese toetse, het ons 'n gevoel van die verskille in vermoëns tussen groot modelle.

DeepSeek is die nuwe "Silicon Valley-mite

DeepSeek veroorsaak paniek" oor die Stille Oseaan.

Meta-werknemers het geplaas dat "Meta-ingenieurs DeepSeek woes ontleed om te probeer om enigiets wat hulle kan daaruit te kopieer."

Alexandr Wang, stigter van KI-tegnologie-opstart Scale AI, het ook in die openbaar verklaar dat die werkverrigting van DeepSeek se KI-groot model min of meer gelykstaande is aan die beste model in die Verenigde State.

Hy glo ook dat die Verenigde State dalk die afgelope dekade voor China was in die KI-kompetisie, maar DeepSeek se vrystelling van sy KI-groot model kan "alles verander."

X Blogger @8teAPi glo dat DeepSeek nie 'n "syprojek" is nie, maar soos Lockheed Martin se voormalige "Skunk Works" is.

Die sogenaamde "Skunk Works" verwys na 'n hoogs vertroulike, relatief onafhanklike klein span wat Lockheed Martin oorspronklik op die been gebring het om baie gevorderde vliegtuie te ontwikkel, wat betrokke is by die nuutste of onkonvensionele tegnologienavorsing en -ontwikkeling. Van die U-2-verkenningsvliegtuie en SR-71 Blackbird tot die F-22 Raptor en F-35 Lightning II-vegvliegtuig, hulle het almal van hier af gekom.

Later het die term geleidelik ontwikkel tot 'n generiese term wat gebruik word om "klein maar fyn", relatief onafhanklike en meer buigsame innovasiespanne wat binne groot maatskappye of organisasies opgestel is, te beskryf.

Hy het twee redes gegee:

- Aan die een kant het DeepSeek 'n groot aantal GPU's, na bewering meer as 10 000, en Alexandr Wang, uitvoerende hoof van Scale AI, het selfs gesê dit kan 50 000 bereik.

- Aan die ander kant werf DeepSeek net talent van die top drie universiteite in China, wat beteken dat DeepSeek so mededingend soos Alibaba en Tencent is.

Hierdie twee feite alleen toon dat DeepSeek duidelik kommersiële sukses behaal het en bekend genoeg is om hierdie hulpbronne te bekom.

Wat DeepSeek se ontwikkelingskoste betref, het die blogger gesê dat Chinese tegnologiemaatskappye 'n verskeidenheid subsidies kan ontvang, soos lae elektrisiteitskoste en grondgebruik.

Daarom is dit baie waarskynlik dat die meeste van DeepSeek se koste in 'n rekening buite die kernbesigheid of in die vorm van 'n soort datasentrumkonstruksiesubsidie “geplaas” is.

Selfs behalwe die stigters, verstaan niemand al die finansiële reëlings ten volle nie. Sommige ooreenkomste kan bloot "mondelinge ooreenkomste" wees wat op grond van reputasie alleen gefinaliseer word.

Ongeag, 'n paar dinge is duidelik:

- Die model is uitstekend, vergelykbaar met die weergawe wat OpenAI twee maande gelede vrygestel het, en natuurlik is dit moontlik dat dit nie so goed is soos die nuwe modelle wat OpenAI en Anthropic nog moet vrystel nie.

- Vanuit die huidige perspektief word die navorsingsrigting steeds deur Amerikaanse maatskappye oorheers. Die DeepSeek-model is 'n "vinnige opvolg" van die o1-weergawe, maar DeepSeek se navorsings- en ontwikkelingsvordering is baie vinnig en haal vinniger in as wat verwag is. Hulle plagiaat of bedrieg nie, hulle is hoogstens omgekeerde ingenieurswese.

- DeepSeek lei hoofsaaklik sy eie talent op, eerder as om op Amerikaans-opgeleide PhD's staat te maak, wat die talentpoel aansienlik vergroot.

- In vergelyking met Amerikaanse maatskappye, is DeepSeek onderhewig aan minder beperkings in terme van intellektuele eiendomslisensies, privaatheid, sekuriteit, politiek, ens., en daar is minder kommer oor die onregmatige gebruik van data waaroor mense nie opgelei wil word nie. Daar is minder regsgedinge, minder prokureurs en minder bekommernisse.

Daar is geen twyfel dat al hoe meer mense glo dat 2025 'n beslissende jaar sal wees nie. Intussen maak maatskappye hulle gereed daarvoor. Meta bou byvoorbeeld 'n 2GW+-datasentrum, met 'n geraamde belegging van $60-65 miljard teen 2025, en sal teen die einde van die jaar meer as 1,3 miljoen GPU's hê.

Meta het selfs 'n grafiek gebruik om sy 2-gigawatt-datasentrum met Manhattan, New York te vergelyk.

Maar nou het DeepSeek beter gevaar met laer koste en minder GPU's. Hoe kan dit mense nie angstig maak nie?

Yann LeCun: Ons moet die CTO en medestigter van bedank die oopbron

Hiperboliese, Yuchen Jin, vir die plasing dat DeepSeek-R1 binne net 4 dae 4 feite aan ons bewys het:

- Oopbron KI is slegs 6 maande agter geslotebron KI

- China oorheers die open source KI-kompetisie

- Ons betree die goue era van groot taalmodelversterkingsleer

- Distillasiemodelle is baie kragtig, en ons sal hoogs intelligente KI op selfone gebruik

Die kettingreaksie wat deur DeepSeek veroorsaak is, duur steeds voort, soos OpenAI o3-mini wat vrylik beskikbaar gestel word, die hoop in die gemeenskap om die vae besprekings oor AGI/ASI te verminder, en die gerug dat Meta paniekbevange is.

Hy meen dit is moeilik om te voorspel wie uiteindelik gaan wen, maar ons moenie die krag van die laatkommer se voordeel vergeet nie. Ons weet immers almal dat dit Google was wat Transformer uitgevind het, terwyl OpenAI sy ware potensiaal ontsluit het.

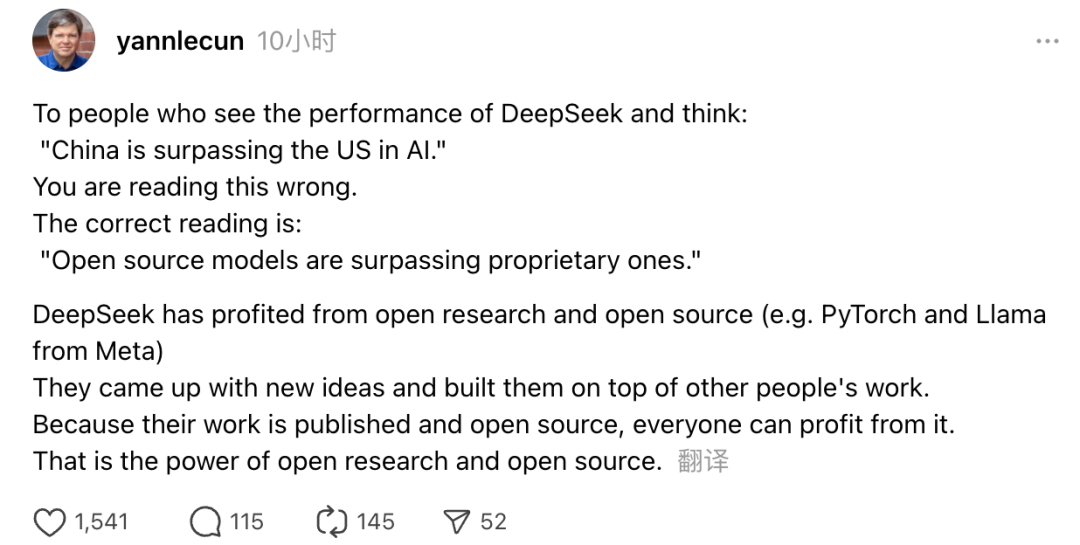

Daarbenewens het die Turing-toekenningwenner en Meta se hoof KI-wetenskaplike Yann LeCun ook sy mening uitgespreek.

“Vir diegene wat, nadat hulle DeepSeek se prestasie gesien het, dink: 'China haal die VSA in KI verby,' jy het dit verkeerd. Die korrekte begrip is dat oopbronmodelle eie modelle verbysteek.”

LeCun het gesê dat die rede waarom DeepSeek hierdie keer so 'n opslae gemaak het, is omdat hulle voordeel getrek het uit oop navorsing en oopbron (soos Meta se PyTorch en Llama). DeepSeek het met nuwe idees vorendag gekom en gebou op die werk van ander. Omdat hul werk in die openbaar vrygestel en oopbron is, kan almal daarby baat. Dit is die krag van oop navorsing en oopbron.

Netizens se refleksies duur voort. Alhoewel hulle opgewonde is oor die ontwikkeling van nuwe tegnologieë, kan hulle ook 'n bietjie atmosfeer van angs voel. Die opkoms van DeepSeekers kan immers 'n werklike impak hê.