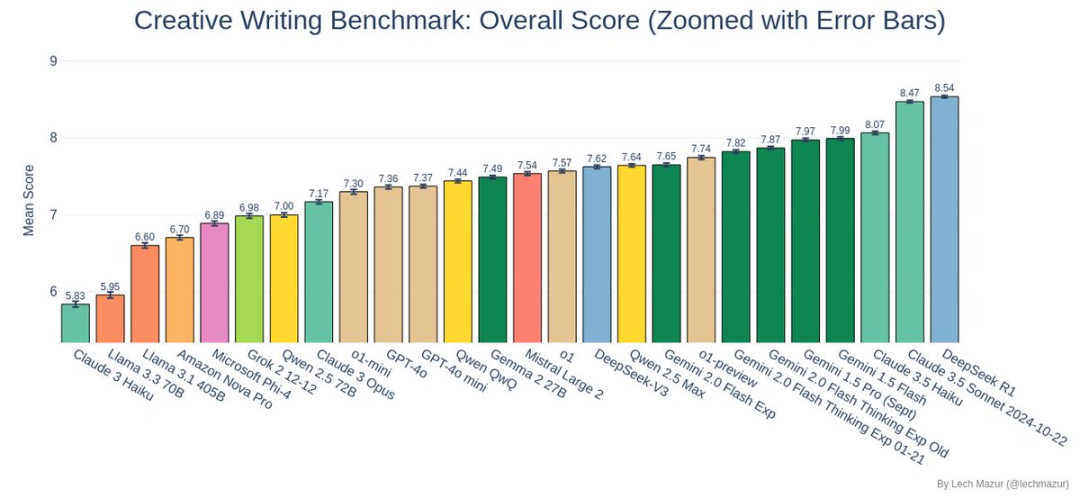

DeepSeek R1 hat den Benchmark-Test zum Schreiben kreativer Kurzgeschichten gewonnen und damit den bisherigen Spitzenreiter Claude 3.5 Sonnet überholt!

Benchmark-Test

Der von dem Forscher Lech Mazur entwickelte Benchmark-Test ist kein gewöhnlicher Schreibwettbewerb.

Jedes KI-Modell musste 500 Kurzgeschichten verfassen, und jede Geschichte musste 10 zufällig zugewiesene Elemente geschickt einbinden. Dies war eine anspruchsvolle, offene Schreibaufgabe für die KI, die nicht nur eine vollständige Handlung erforderte, sondern auch dafür sorgte, dass alle zugewiesenen Elemente auf natürliche Weise integriert wurden

Beurteilungsmethode

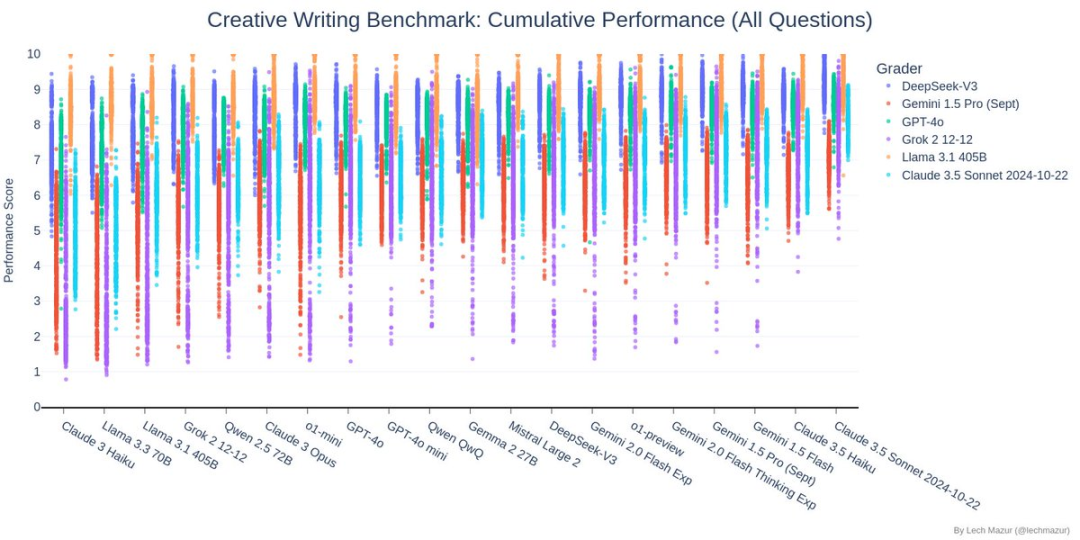

Bei diesem Benchmark-Test kommt ein einzigartiges Bewertungssystem zum Einsatz: Sechs Top-Sprachmodelle fungieren als Richter und bewerten verschiedene Aspekte der Geschichte. Mit anderen Worten: Die KI-Branchenführer beurteilen die KI selbst, was insgesamt einen relativ fairen und systematischen Bewertungsstandard bietet.

Inhalt der Prüfung

Das obige Diagramm zeigt die Korrelationsanalyse der Teilnehmer am Vergleichstest für kreatives Schreiben. DeepSeek hat einen Korrelationskoeffizienten von über 0,93 mit anderen Mainstream-Modellen (Claude, GPT-4o, Gemini und Grok), was darauf hindeutet, dass es bei der Beurteilung der Qualität des kreativen Schreibens sehr konsistente Beurteilungskriterien mit anderen Top-Modellen hat, was indirekt seine Zuverlässigkeit in diesem Test bestätigt.

Das obige Diagramm zeigt die Ergebnisse des Benchmark-Tests zum Schreiben kreativer Kurzgeschichten. Jedes KI-Modell musste 500 Geschichten schreiben, von denen jede 10 vorgegebene Zufallselemente enthalten musste. Die Punkte im Diagramm zeigen die Punkteverteilung jedes teilnehmenden KI-Modells für verschiedene Bewertungsmodelle (dargestellt durch unterschiedliche Farben).

Im Test, TiefSeek (dunkelblaue Punkte) hat gut abgeschnitten, wobei die meisten Punkte in der oberen Hälfte des Diagramms liegen und relativ konzentriert sind, was ein stabiles und hohes Niveau der kreativen Schreibfähigkeiten zeigt.

Dank dieser herausragenden Leistung konnte er den bisherigen Sieger Claude 3.5 Sonnet überflügeln und ist neuer Spitzenreiter bei den Benchmark-Tests.

In diesem Diagramm steht jede Zeile für ein KI-Modell und jede Spalte für eine Bewertungsdimension (z. B. Charakterisierung, Plotkohärenz usw.). DeepSeek befindet sich in der oberen Mitte des Diagramms und hat einen orange-gelben Farbton, was bedeutet, dass es in den meisten Bewertungsdimensionen hervorragende Ergebnisse erzielt hat. Insbesondere hat es in den Schlüsseldimensionen Ausführung (Q6), Charakterisierung (TA) und Entwicklung der Handlung (TJ) hohe Punktzahlen von fast 8 Punkten erreicht. Auch wenn es in einzelnen Dimensionen nicht das hellste Gelb ist, weist es keine offensichtlichen Schwächen auf.

Wie Sie dem Diagramm entnehmen können, liegen die Bewertungen von DeepSeek meist zwischen 7 und 9 Punkten, und die Verteilung ist relativ konzentriert. Interessanterweise verläuft die Trendlinie fast waagerecht, was darauf hindeutet, dass die Qualität der Geschichte von DeepSeek nicht eng mit der Länge der Geschichte zusammenhängt. Mit anderen Worten: Egal, ob es sich um eine lange oder eine kurze Geschichte handelt, DeepSeek kann eine gleichbleibend hohe Qualität beibehalten. Dies zeigt, dass DeepSeek konzentriert sich bei der Erstellung mehr auf Qualität als auf Quantität und kann eine hervorragende Leistung beibehalten in Geschichten von unterschiedlicher Länge.

Warum hat DeepSeek R1 gewinnen?

Nach den Testergebnissen zu urteilen, hat DeepSeek R1 erstaunlich gut abgeschnitten:

- Umfassende Funktionen zur Integration von Geschichten: R1 zeigte erstaunliche Flexibilität und Kreativität im Umgang mit verschiedenen Kombinationen von Story-Elementen.

- Stabile Ausgabequalität: Nach dem Diagramm der Punkteverteilung zu urteilen, hatte R1 nicht nur eine hohe Durchschnittspunktzahl, sondern auch eine stabile Leistung mit geringeren Schwankungen.

- Herausragende kreative Leistung: In diesem Benchmark-Test wurden die von R1 erstellten Geschichten unter den drei besten bewertet, was die herausragenden Fähigkeiten im kreativen Schreiben beweist.

Wie haben die anderen TeilnehmerInnen abgeschnitten?

Neben dem spannenden Kräftemessen zwischen dem DeepSeek R1 und dem Claude 3.5 Sonnet ist auch die Leistung der anderen Modelle erwähnenswert:

- Die Gemini-Serie hat gut abgeschnitten

- Die Llama 3.x-Serie hatte in diesem Test ein wenig zu kämpfen

- Der o3-mini schnitt nicht gut ab und belegte Platz 22.

Endlich

Der Durchbruch von DeepSeek R1 in diesem Test hat uns die unendlichen Möglichkeiten der KI im Bereich der Kreativität gezeigt. Obwohl die KI-Erstellung noch immer auf dem Weg der kontinuierlichen Verbesserung ist, haben uns solche Ergebnisse bereits voller Erwartungen für die Zukunft gemacht.

Wer mehr über die Details des Tests erfahren möchte, kann auf Lech Mazurs GitHub die vollständigen Daten und Beispiele für die besten Geschichten finden. Freuen wir uns gemeinsam auf weitere Durchbrüche im Bereich des kreativen Schreibens mit KI!