Keiner von uns hat erwartet, dass das Jahr 2025 auf dem Gebiet der KI so beginnen würde.

DeepSeek R1 ist wirklich erstaunlich!

In letzter Zeit hat die "geheimnisvolle östliche Macht" DeepSeek das Silicon Valley "hart kontrolliert".

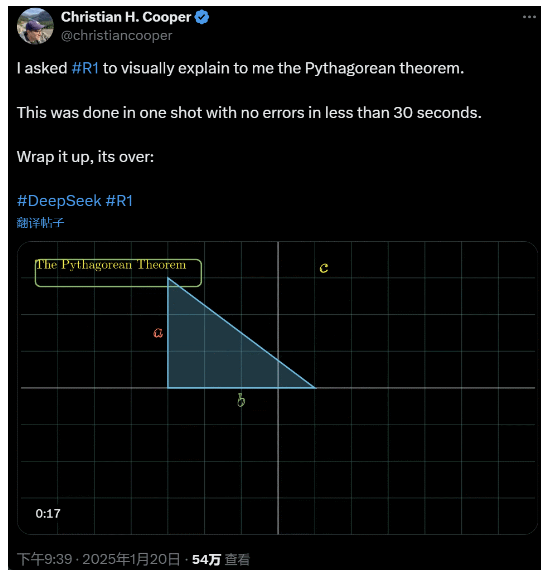

Ich bat R1, den Satz des Pythagoras im Detail zu erklären. All dies wurde von der KI in weniger als 30 Sekunden ohne Fehler erledigt. Kurz gesagt, es ist vorbei.

In den in- und ausländischen KI-Kreisen haben gewöhnliche Internetnutzer die erstaunliche und leistungsstarke neue KI entdeckt (die auch quelloffen ist), und akademische Experten haben gerufen: "Wir müssen aufholen". Es gibt auch Gerüchte, dass KI-Unternehmen in Übersee bereits eine große Bedrohung darstellen.

Nehmen Sie nur dieses DeepSeek R1, das diese Woche veröffentlicht wurde. Sein reiner Reinforcement-Learning-Weg ohne überwachtes Training ist schockierend. Von der Entwicklung der Deepseek-v3-Basis im Dezember letzten Jahres bis zu den aktuellen Fähigkeiten der Denkkette, die mit OpenAI o1 vergleichbar sind, scheint es nur eine Frage der Zeit zu sein.

Aber während die KI-Gemeinschaft fleißig technische Berichte liest und tatsächliche Messungen vergleicht, haben die Menschen immer noch Zweifel an R1: Abgesehen davon, dass es in der Lage ist, eine Reihe von Benchmarks zu übertreffen, kann es wirklich führen?

Kann sie ihre eigenen Simulationen der "physikalischen Gesetze" erstellen?

Du glaubst es nicht? Sollen wir das große Modell mit einem Flipper spielen lassen?

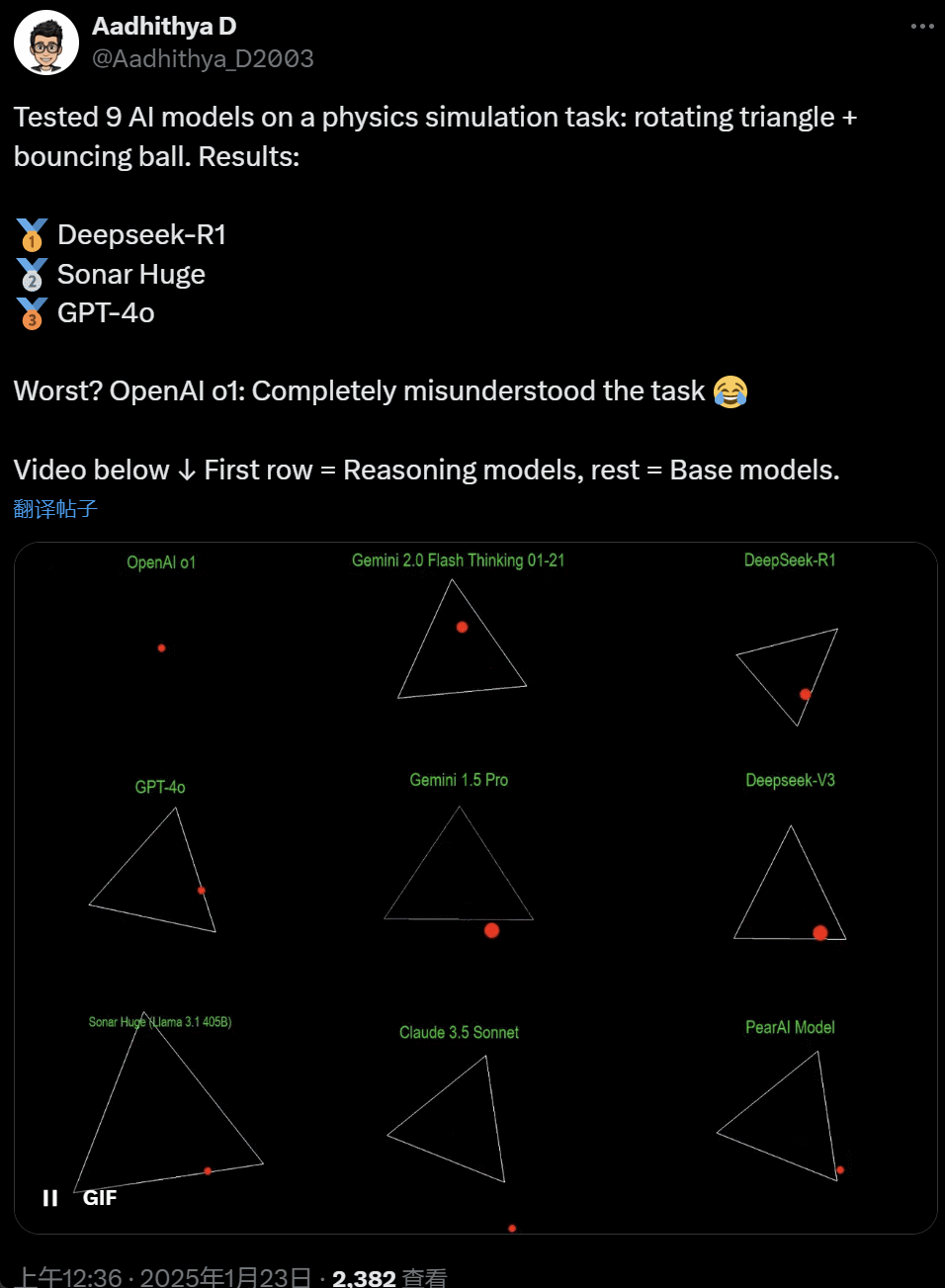

In den letzten Tagen sind einige Leute in der KI-Gemeinschaft besessen von einem Test - dem Testen verschiedener großer KI-Modelle (insbesondere der so genannten schlussfolgernden Modelle), um ein Problem zu lösen: "Schreiben Sie ein Python-Skript, um einen gelben Ball innerhalb einer bestimmten Form hüpfen zu lassen. Lassen Sie die Form langsam rotieren und stellen Sie sicher, dass der Ball innerhalb der Form bleibt."

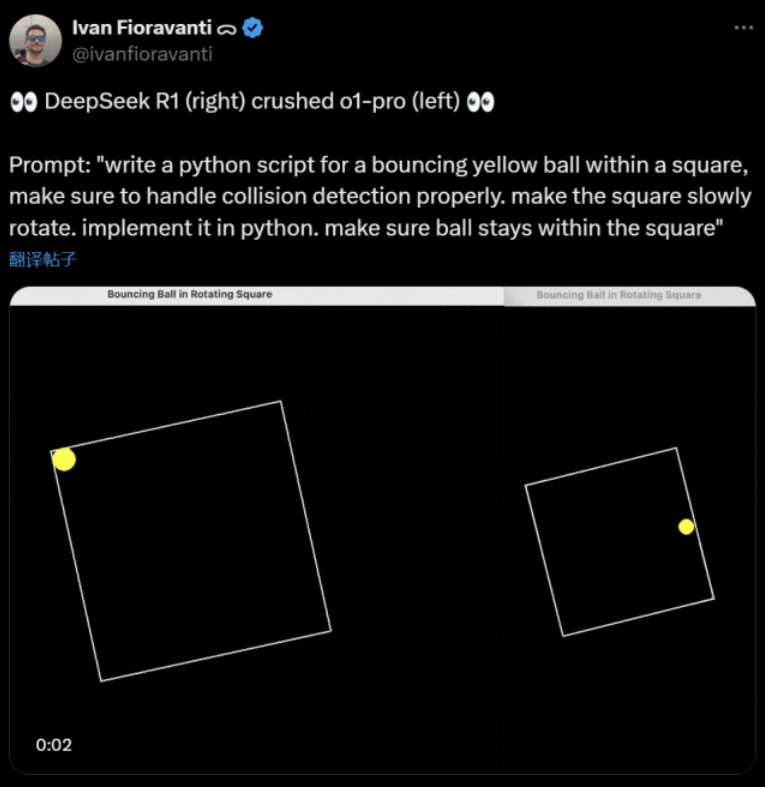

Einige Modelle übertreffen andere in diesem "rotierenden Ball"-Benchmark. Laut Ivan Fioravanti, CTO von CoreView, verfügt DeepSeek, ein inländisches Labor für künstliche Intelligenz, über ein quelloffenes großes Modell R1, das das Modell o1 pro von OpenAI übertrifft, das im Rahmen des ChatGPT Pro-Programms von OpenAI $200 pro Monat kostet.

Auf der linken Seite ist OpenAI o1, auf der rechten Seite ist DeepSeek R1. Wie oben erwähnt, lautet die Aufforderung hier: "schreibe ein python skript für einen hüpfenden gelben ball in einem quadrat, stelle sicher, dass die kollisionserkennung richtig funktioniert. lass das quadrat langsam rotieren. implementiere es in python. stelle sicher, dass der ball im quadrat bleibt."

Einem anderen Nutzer auf X zufolge gaben die Modelle Anthropic Claude 3.5 Sonnet und Google Gemini 1.5 Pro falsche Einschätzungen über physikalische Prinzipien ab, so dass der Ball von seiner Form abwich. Einige Nutzer haben auch berichtet, dass Googles neuestes Gemini 2.0 Flash Thinking Experimental sowie das relativ ältere OpenAI GPT-4o die Prüfung sofort bestanden haben.

Aber es gibt eine Möglichkeit, den Unterschied zu erkennen:

Netizens unter diesem Tweet sagte: o1's Fähigkeit war ursprünglich sehr gut, aber es wurde schwächer, nachdem OpenAI die Geschwindigkeit optimiert, auch mit der $200/Monat Mitgliedschaft Version.

Die Simulation eines hüpfenden Balls ist eine klassische Herausforderung für die Programmierung. Eine genaue Simulation kombiniert Algorithmen zur Kollisionserkennung, die erkennen müssen, wann zwei Objekte (z. B. ein Ball und die Seite einer Form) zusammenstoßen. Ein unsachgemäß geschriebener Algorithmus kann die Leistung der Simulation beeinträchtigen oder offensichtliche physikalische Fehler verursachen.

N8 Programs, ein Forscher beim KI-Startup Nous Research, sagte, er habe etwa zwei Stunden gebraucht, um einen springenden Ball in einem rotierenden Heptagon von Grund auf zu programmieren. "Es müssen mehrere Koordinatensysteme verfolgt werden, man muss verstehen, wie Kollisionen in jedem System behandelt werden, und der Code muss von Grund auf neu entwickelt werden, um robust zu sein.

Obwohl hüpfende Bälle und sich drehende Formen ein angemessener Test für die Programmierfähigkeiten sind, handelt es sich immer noch um neue Projekte für große Modelle, und selbst kleine Änderungen in den Aufforderungen können zu unterschiedlichen Ergebnissen führen. Wenn der Test schließlich Teil des Benchmark-Tests für große KI-Modelle werden soll, muss er also noch verbessert werden.

Auf jeden Fall haben wir nach dieser Welle von Praxistests ein Gefühl für die Unterschiede in den Fähigkeiten der großen Modelle.

DeepSeek ist der neue "Mythos Silicon Valley

DeepSeek sorgt für Panik" im Pazifik.

Meta-Mitarbeiter haben gepostet, dass "Meta-Ingenieure verzweifelt DeepSeek analysieren, um zu versuchen, alles zu kopieren, was sie können."

Alexandr Wang, Gründer des KI-Technologie-Start-ups Scale AI, erklärte ebenfalls öffentlich, dass die Leistung des großen KI-Modells von DeepSeek in etwa der des besten Modells in den USA entspricht.

Er glaubt auch, dass die Vereinigten Staaten China im letzten Jahrzehnt im KI-Wettbewerb voraus waren, aber die Veröffentlichung des großen KI-Modells von DeepSeek könnte "alles ändern".

X Blogger @8teAPi glaubt, dass DeepSeek kein "Nebenprojekt" ist, sondern wie Lockheed Martins frühere "Skunk Works" ist.

Die so genannten "Skunk Works" sind ein streng vertrauliches, relativ unabhängiges kleines Team, das Lockheed Martin ursprünglich für die Entwicklung zahlreicher fortschrittlicher Flugzeuge eingerichtet hat und das sich mit der Erforschung und Entwicklung modernster oder unkonventioneller Technologien beschäftigt. Vom U-2-Aufklärungsflugzeug und der SR-71 Blackbird bis zum F-22 Raptor und dem F-35 Lightning II-Kampfflugzeug - sie alle stammen von hier.

Später entwickelte sich der Begriff allmählich zu einem Oberbegriff für "kleine, aber feine", relativ unabhängige und flexiblere Innovationsteams, die in großen Unternehmen oder Organisationen eingesetzt werden.

Er nannte zwei Gründe:

- Einerseits verfügt DeepSeek über eine große Anzahl von GPUs, angeblich mehr als 10.000, und Alexandr Wang, CEO von Scale AI, sagte sogar, dass die Zahl 50.000 erreichen könnte.

- Andererseits rekrutiert DeepSeek nur Talente von den drei besten Universitäten in China, was bedeutet, dass DeepSeek genauso wettbewerbsfähig ist wie Alibaba und Tencent.

Allein diese beiden Tatsachen zeigen, dass DeepSeek eindeutig einen kommerziellen Erfolg erzielt hat und bekannt genug ist, um diese Mittel zu erhalten.

Was die Entwicklungskosten von DeepSeek betrifft, so sagte der Blogger, dass chinesische Technologieunternehmen eine Reihe von Subventionen erhalten können, z. B. niedrige Stromkosten und Landnutzung.

Daher ist es sehr wahrscheinlich, dass der größte Teil der Kosten von DeepSeek auf einem Konto außerhalb des Kerngeschäfts oder in Form einer Art von Subvention für den Bau von Rechenzentren "platziert" wurde.

Selbst abgesehen von den Gründern kennt niemand alle finanziellen Vereinbarungen vollständig. Einige Vereinbarungen können einfach nur "mündliche Vereinbarungen" sein, die allein aufgrund des Rufs abgeschlossen werden.

Ein paar Dinge sind jedoch klar:

- Das Modell ist ausgezeichnet, vergleichbar mit der Version, die OpenAI vor zwei Monaten veröffentlicht hat, und es ist natürlich möglich, dass es nicht so gut ist wie die neuen Modelle, die OpenAI und Anthropic noch veröffentlichen müssen.

- Aus heutiger Sicht wird die Forschungsrichtung immer noch von amerikanischen Unternehmen dominiert. Das DeepSeek-Modell ist ein "schneller Nachfolger" der o1-Version, aber DeepSeeks Forschungs- und Entwicklungsfortschritt ist sehr schnell und holt schneller auf als erwartet. Sie plagiieren oder betrügen nicht, sie betreiben höchstens Reverse Engineering.

- DeepSeek bildet hauptsächlich seine eigenen Talente aus, anstatt sich auf in Amerika ausgebildete Doktoranden zu verlassen, wodurch der Talentpool erheblich erweitert wird.

- Im Vergleich zu US-amerikanischen Unternehmen unterliegt DeepSeek weniger Zwängen in Bezug auf die Lizenzierung von geistigem Eigentum, den Datenschutz, die Sicherheit, die Politik usw., und es gibt weniger Bedenken hinsichtlich der unrechtmäßigen Verwendung von Daten, auf die die Menschen nicht geschult werden wollen. Es gibt weniger Gerichtsverfahren, weniger Anwälte und weniger Bedenken.

Es besteht kein Zweifel daran, dass immer mehr Menschen glauben, dass 2025 ein entscheidendes Jahr sein wird. In der Zwischenzeit rüsten sich die Unternehmen für dieses Jahr. Meta zum Beispiel baut ein 2GW+-Rechenzentrum mit einer geschätzten Investition von $60-65 Mrd. bis 2025 und wird bis Ende des Jahres über 1,3 Mio. GPUs verfügen.

Meta verglich sein 2-Gigawatt-Rechenzentrum sogar in einem Diagramm mit Manhattan, New York.

Aber jetzt hat es DeepSeek mit niedrigeren Kosten und weniger GPUs besser gemacht. Wie kann das die Leute nicht beunruhigen?

Yann LeCun: Wir müssen dem CTO und Mitbegründer von die offene Quelle

Hyperbolic, Yuchen Jin, dass DeepSeek-R1 uns in nur 4 Tagen 4 Fakten bewiesen hat:

- Open Source AI liegt nur 6 Monate hinter Closed Source AI zurück

- China dominiert den Open-Source-KI-Wettbewerb

- Wir treten in das goldene Zeitalter des Verstärkungslernens für große Sprachmodelle ein

- Destillationsmodelle sind sehr leistungsfähig, und wir werden hochintelligente KI auf Mobiltelefonen betreiben

Die Kettenreaktion, die durch DeepSeek ausgelöst wurde, hält noch immer an, wie z.B. die freie Verfügbarkeit von OpenAI o3-mini, die Hoffnung in der Gemeinschaft, die vagen Diskussionen über AGI/ASI zu reduzieren, und das Gerücht, dass Meta in Panik ist.

Seiner Meinung nach ist es schwierig vorherzusagen, wer letztendlich gewinnen wird, aber wir sollten nicht vergessen, wie groß der Vorteil des Nachzüglers ist. Schließlich wissen wir alle, dass es Google war, das Transformer erfunden hat, während OpenAI sein wahres Potenzial entfaltet hat.

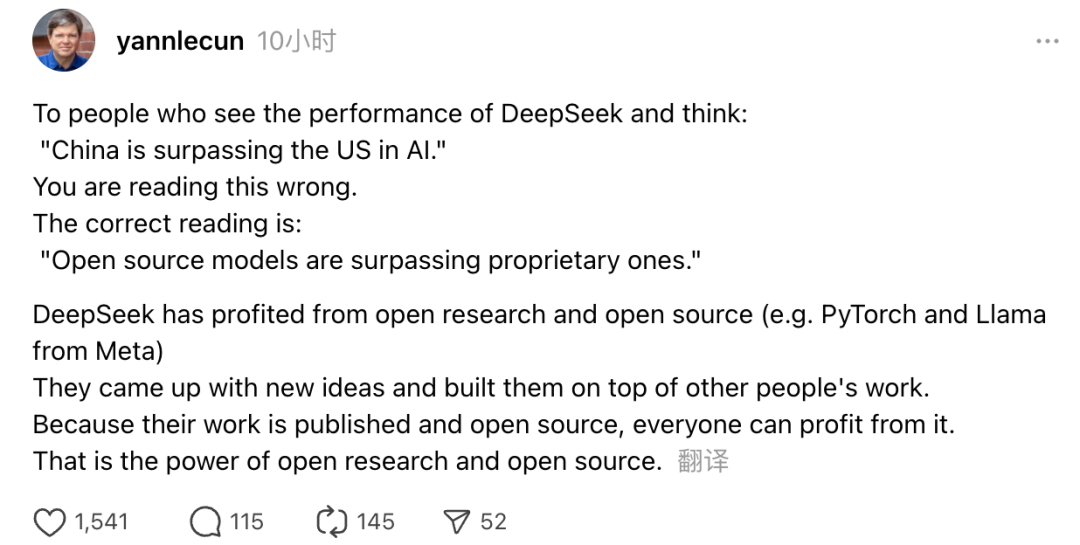

Außerdem äußerte sich der Gewinner des Turing-Preises und leitende KI-Wissenschaftler von Meta, Yann LeCun, zu diesem Thema.

"Wer beim Anblick der Leistung von DeepSeek denkt: 'China überholt die USA in Sachen KI', der irrt. Richtig ist, dass Open-Source-Modelle die proprietären Modelle überholen."

LeCun sagte, dass der Grund, warum DeepSeek dieses Mal so viel Erfolg hatte, darin liegt, dass sie von offener Forschung und Open Source (wie Metas PyTorch und Llama) profitiert haben. DeepSeek hat neue Ideen entwickelt und auf der Arbeit anderer aufgebaut. Da ihre Arbeit öffentlich zugänglich und quelloffen ist, kann jeder davon profitieren. Das ist die Stärke von offener Forschung und Open Source.

Die Überlegungen der Internetnutzer gehen weiter. Sie freuen sich zwar über die Entwicklung neuer Technologien, aber sie verspüren auch ein wenig Angst. Schließlich könnte das Auftauchen von DeepSeekers eine echte Auswirkung haben.