DeepSeek-R1 y DeepSeek-V3 han causado sensación en todo el mundo desde su lanzamiento en código abierto.

Son un regalo del equipo DeepSeek a toda la humanidad, y nos alegramos sinceramente de su éxito.

Tras días de duro trabajo por parte de los equipos de Silicon Mobility y Huawei Cloud, hoy también ofrecemos a los usuarios chinos un regalo por el Año Nuevo Chino: SiliconCloud, la plataforma de servicios en la nube de modelo a gran escala, ha lanzado DeepSeek-V3 y DeepSeek-R1, basados en el servicio en la nube Ascend de Huawei Cloud.

Cabe destacar que hemos recibido un gran apoyo por parte de DeepSeek y Huawei Cloud, tanto en la adaptación de DeepSeek-R1 & V3 en Ascend como en el proceso de lanzamiento de otros modelos anteriormente, y nos gustaría expresar nuestro profundo agradecimiento y gran respeto.

Características

Estos dos modelos lanzados por SiliconCloud incluyen principalmente cinco características principales:

Basándonos en el servicio en la nube Ascend de Huawei Cloud, hemos lanzado el DeepSeek x Silicon Mobility x Servicio de inferencia de modelos Cloud R1 y V3 de Huawei por primera vez.

A través de la innovación conjunta entre las dos partes, y con el apoyo del motor de aceleración de inferencia de desarrollo propio, el modelo DeepSeek desplegado por el equipo de Silicon Mobility basado en el servicio cloud Ascend de Huawei Cloud puede lograr el mismo efecto que un modelo de despliegue de GPU de gama alta en el mundo.

Proporcionar servicios de inferencia DeepSeek-R1 y V3 estables a nivel de producción. Esto permite a los desarrolladores ejecutarse de forma estable en entornos de producción a gran escala y satisfacer las necesidades de despliegue comercial. Los servicios Cloud Ascend AI de Huawei proporcionan potencia informática abundante, elástica y suficiente.

No hay umbral de despliegue, lo que permite a los desarrolladores centrarse más en el desarrollo de aplicaciones. Al desarrollar aplicaciones, pueden llamar directamente a la API de SiliconCloud, lo que proporciona una experiencia más sencilla y fácil de usar.

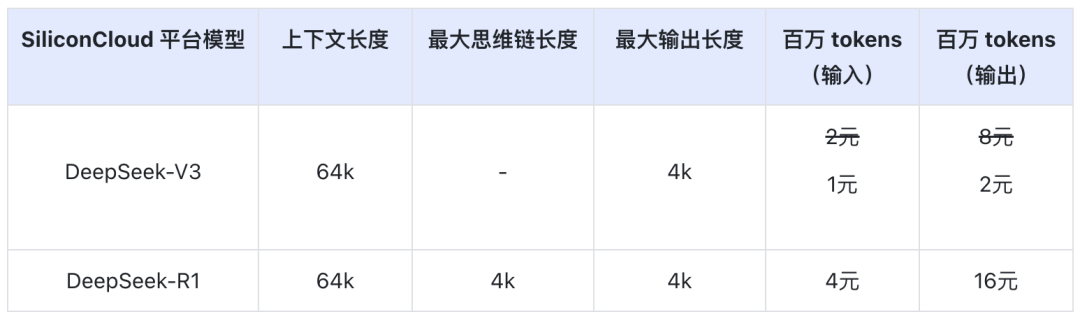

El precio del DeepSeek-V3 en SiliconCloud durante el periodo de descuento oficial (hasta las 24:00 del 8 de febrero) es de ¥1 / M tokens (entrada) & ¥2 / M tokens (salida), y el precio del DeepSeek-R1 es de ¥4 / M tokens (entrada) & ¥16 / M tokens (salida).

Experiencia en línea

DeepSeek-R1 con SiliconCloud

DeepSeek-V3 con SiliconCloud

Documentación API

Los desarrolladores pueden experimentar el efecto de DeepSeek-R1 & V3 acelerado en chips domésticos en SiliconCloud. La velocidad de salida más rápida se sigue optimizando continuamente.

Experiencia en aplicaciones cliente

Si desea experimentar el modelo DeepSeek-R1 & V3 directamente en la aplicación cliente, puede instalar los siguientes productos localmente y acceder a la API de SiliconCloud (puede personalizar y añadir estos dos modelos) para experimentar DeepSeek-R1 & V3.

- Aplicaciones para clientes de modelos grandes: ChatBox, Estudio Cherry, OneAPI, LobeChat, NextChat

- Aplicaciones de generación de código: Cursor, Windsurf, Cline

- Plataforma de desarrollo de aplicaciones para grandes modelos:Dify

- Base de conocimientos de IA:IA ObsidianayFastGPT

- Complemento de traducción:Immersive Translate, yEurodict

Para más tutoriales de acceso a escenarios y casos de aplicación, consulte aquí

Fábrica de fichas SiliconCloud

Qwen2.5 (7B), etc. Más de 20 modelos de uso gratuito

Como plataforma única de servicios en la nube para modelos de gran tamaño, SiliconCloud se compromete a proporcionar a los desarrolladores API de modelos que sean ultrarrápidas, asequibles, completas y con una experiencia suave como la seda.

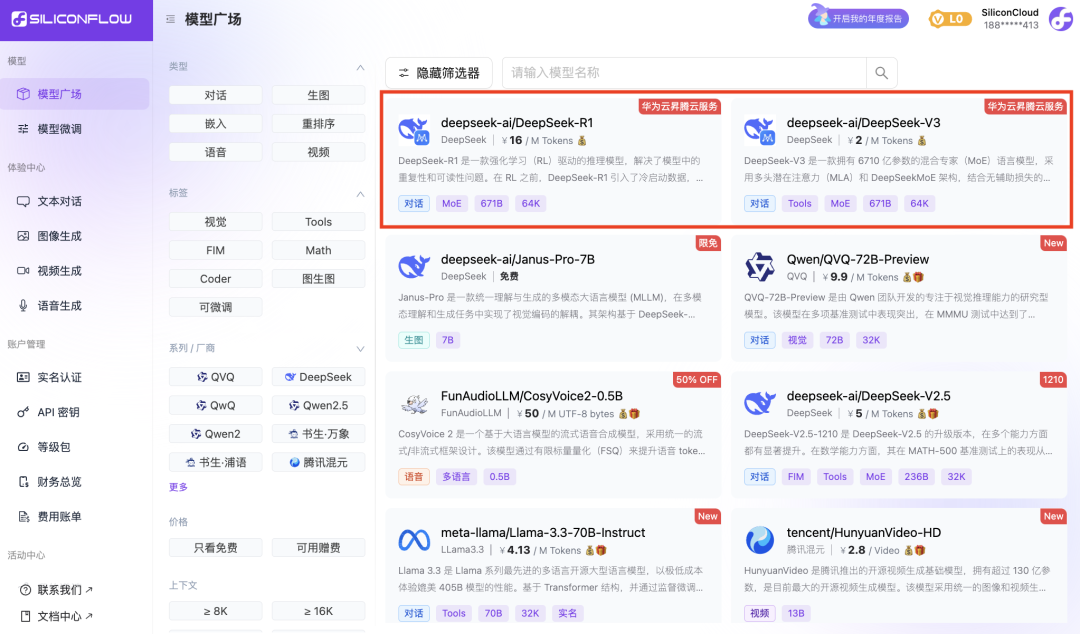

Además de DeepSeek-R1 y DeepSeek-V3, SiliconCloud también ha lanzado Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

docenas de grandes modelos lingüísticos de código abierto, modelos de generación de imágenes/vídeos, modelos del habla, modelos de código/matemáticas y modelos vectoriales y de reordenación.

La plataforma permite a los desarrolladores comparar y combinar libremente grandes modelos de varias modalidades para elegir la mejor práctica para su aplicación de IA generativa.

Entre ellas, más de 20 grandes modelos de API, como Qwen2.5 (7B) y Llama3.1 (8B), son de uso gratuito, lo que permite a los desarrolladores y jefes de producto alcanzar la "libertad de fichas" sin preocuparse por el coste de la potencia de cálculo durante la fase de investigación y desarrollo y la promoción a gran escala.