o3-mini llegó tarde por la noche, y OpenAI reveló por fin su última baza. Durante un Reddit AMA Q&A, Altman confesó profundamente que se había situado en el lado equivocado de la IA de código abierto.

Dijo que se está estudiando la estrategia interna de código abierto y que se seguirá desarrollando el modelo, pero que el liderazgo de OpenAI no será tan grande como antes.

Mientras todo el mundo seguía maravillado por la asombrosa potencia de DeepSeek, OpenAI ya no podía estarse quieta.

En la madrugada de ayer, o3-mini se puso en marcha con urgencia, estableciendo nuevos SOTA en pruebas de referencia como el código matemático y la vuelta al trono.

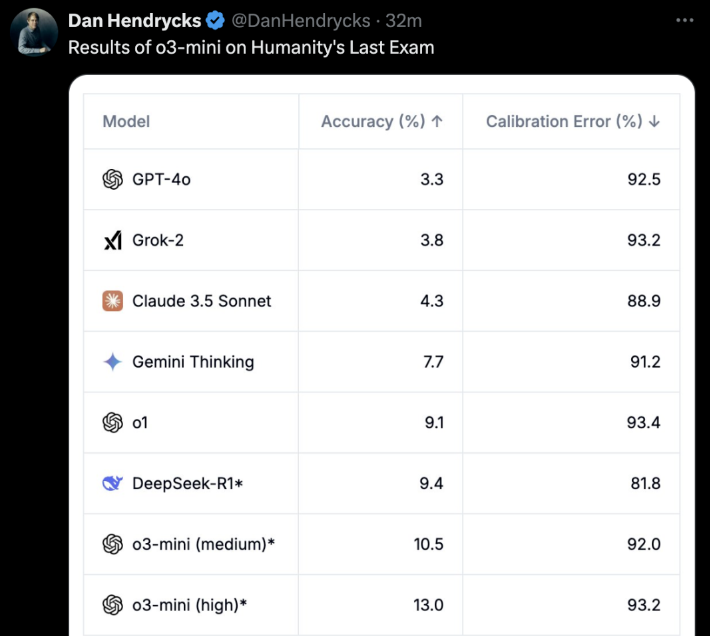

Lo más importante es que los usuarios libres también pueden experimentarlo! o3-mini no es ninguna broma. En el "último examen para humanos", o3-mini (alto) logró directamente la mejor precisión y error de calibración.

Unas horas después o3-mini en líneaOpenAI abrió oficialmente un AMA en Reddit durante aproximadamente una hora.

El propio Altman también se conectó a Internet y respondió a todas las preguntas de los internautas.

Los aspectos más destacados son:

- DeepSeek es realmente muy buenoy seguiremos desarrollando mejores modelos, pero la ventaja no será tan grande como antes.

- En comparación con hace unos años, ahora me inclino más a creer que la IA puede experimentar rápidos saltos y avances

- Estamos en el lado equivocado de la cuestión de los modelos de IA ponderada de código abierto

- Pronto habrá una actualización del modo de voz avanzado, y la llamaremos directamente GPT-5, no GPT-5o. Aún no hay un calendario concreto.

Además del propio Altman, el Director de Investigación, Mark Chen, el Director de Producto, Kevin Weil, el Vicepresidente de Ingeniería, Srinivas Narayanan, la Directora de Investigación de API, Michelle Pokrass, y el Director de Investigación, Hongyu Ren, también estuvieron en línea y respondieron atentamente a todas las preguntas de los internautas.

A continuación, echemos un vistazo a lo que dijeron todos.

Altman se arrepiente profundamente de haber tomado el bando equivocado en la batalla de la IA de código abierto

El repentino regreso de DeepSeek puede haber sido inesperado para todos.

Durante la sesión de preguntas y respuestas del AMA, el propio Altman también se arrepintió profundamente de haber tomado el bando equivocado en la batalla de la IA de código abierto y tuvo que admitir las grandes ventajas de DeepSeek.

Lo que sorprendió a muchos fue que Altman llegó a decir que el liderazgo de OpenAI ya no era tan fuerte como antes.

A continuación presentamos las respuestas clásicas que hemos recopilado de Altman.

P: Hablemos del gran tema de la semana: Deepseek. Está claro que es un modelo impresionante, y sé que probablemente se ha entrenado a partir de los resultados de otros LLM. ¿Cómo cambiará esto sus planes para futuros modelos?

Altman: ¡Es un modelo impresionante! Desarrollaremos modelos mejores, pero no podremos mantener una ventaja tan grande como en años anteriores.

P: ¿Cree que la autosuperación recursiva será un proceso gradual o un despegue repentino?

Altman: Personalmente, creo que estoy más inclinado a pensar que la IA puede progresar rápidamente que hace unos años. Quizá sea el momento de escribir algo sobre este tema...

P: ¿Podemos ver todas las fichas en las que piensa el modelo?

Altman: Sí, pronto mostraremos una versión más útil y detallada. Gracias a R1 por la actualización.

Kevin Weil, Director de Producto: Estamos trabajando para mostrar más de lo que mostramos ahora. Queda por determinar si lo mostraremos todo o no. Mostrar todas las cadenas de pensamiento (CoT) llevaría a la destilación de modelos de la competencia, pero también sabemos que los usuarios (al menos los avanzados) quieren ver esto, así que encontraremos un buen equilibrio.

P: ¿Cuándo estará disponible la versión completa de o3?

Altman: Yo calcularía que serán más de unas semanas, pero no más de unos meses.

P: ¿Se actualizará el modo de voz? ¿Es esto potencialmente un objetivo para GPT-5o? ¿Cuál es el calendario aproximado de GPT-5o?

Altman: Sí, ¡viene una actualización del modo de voz avanzado! Creo que la llamaremos GPT-5, no GPT-5o. Aún no hay un calendario concreto.

P: ¿Consideraría la posibilidad de dar a conocer algunos modelos de pesos y publicar algunas investigaciones?

Altman: Sí, lo estamos debatiendo. Personalmente, creo que estamos en el lado equivocado de esta cuestión y que necesitamos plantear una estrategia de código abierto diferente; no todo el mundo en OpenAI comparte esta opinión, y no es nuestra máxima prioridad en este momento.

Una pregunta más:

- ¿Cómo de cerca estamos de ofrecer el Operador en el programa regular Plus?

- ¿Cuáles son las principales prioridades del departamento de robótica?

- ¿Qué opina OpenAI de los chips/TPU más especializados, como Trillium, Cerebras, etc.? ¿Está OpenAI prestando atención a esto?

- ¿Qué inversiones se están realizando para protegerse de futuros riesgos en AGI y ASI?

- ¿Cuáles han sido sus vacaciones más memorables?

Altman:

- Unos meses

- producir un robot realmente bueno a pequeña escala y aprender de la experiencia

- Actualmente, el GB200 es difícil de superar.

- Una buena opción sería mejorar su estado interior: resiliencia, adaptabilidad, calma, alegría, etc.

- Es difícil elegir. Pero los dos primeros que se me ocurren son: viajar de mochilero por el Sudeste Asiático o un safari por África.

P: ¿Piensan subir el precio de la serie Plus?

Altman: En realidad, quiero reducirlo gradualmente.

P: Supongamos que estamos en el año 2030 y usted acaba de crear un sistema que la mayoría de la gente llamaría AGI. Sobresale en todas las pruebas de referencia y supera a sus mejores ingenieros e investigadores en términos de velocidad y rendimiento. ¿Y ahora qué? Aparte de "colgarlo en la web y ofrecerlo como servicio", ¿tiene algún otro plan?

Altman: El impacto más importante, en mi opinión, será acelerar los descubrimientos científicos, que creo que es el factor que más contribuirá a mejorar la calidad de vida.

4o generación de imágenes, próximamente

A continuación, se añadieron las respuestas de otros miembros de OpenAI.

P: ¿Todavía tiene previsto lanzar el generador de imágenes 4o?

Kevin Weil, Director de Producto: Sí. Y creo que la espera merece la pena.

P: ¡Genial! ¿Hay un calendario aproximado?

Kevin Weil, Jefe de Producto: Me estás pidiendo que me meta en problemas. Quizá unos meses.

Y otra pregunta similar.

P: ¿Cuándo podremos ver ChatGPT-5?

Kevin Weil, Director de Producto: Poco después de o-17 micro y GPT-(π+1).

Y surge otra pregunta:

- ¿Qué otros tipos de agentes podemos esperar?

- Y también proporcionar un agente para los usuarios libres, lo que podría acelerar la adopción...

- ¿Alguna novedad sobre la nueva versión de DALL-E?

- Una última pregunta, y es la que todo el mundo se hace... ¿Cuándo se implantará el AGI?

Kevin Weil, Director de Producto:

- Más agentes: muy, muy pronto. Creo que te alegrarás.

- Generación de imágenes basada en 4o: en unos meses, estoy deseando que lo utilices. Es genial.

- AGI: Sí

P: ¿Tienen previsto añadir la función de adjuntar archivos al modelo de razonamiento?

Srinivas Narayanan, Vicepresidente de Ingeniería: Está en desarrollo. En el futuro, el modelo de razonamiento podrá utilizar distintas herramientas, incluidas funciones de búsqueda.

Kevin Weil, Jefe de Producto: Sólo para decir, no puedo esperar a ver el modelo de razonamiento ser capaz de utilizar herramientas

P: En serio. Cuando resuelva este problema, se abrirán algunos escenarios de aplicación de la IA muy útiles. Imagínate que fuera capaz de entender el contenido de tus documentos de trabajo de 500 GB.

Cuando estés a punto de responder a un correo electrónico, se abrirá un panel junto a tu aplicación de correo electrónico que analiza continuamente toda la información relacionada con esa persona, incluida vuestra relación, los temas tratados, trabajos anteriores, etc. Tal vez se marque algo de un documento que hace tiempo que has olvidado porque es muy relevante para la conversación actual. Me encantaría tener esta función.

Srinivas Narayanan, Vicepresidente de Ingeniería: Estamos trabajando para aumentar la duración del contexto. Aún no hay fecha/anuncio en firme.

P: ¿Qué importancia tiene el proyecto Stargate para el futuro de OpenAI? Kevin Weil, Director de Producto: Muy importante. Todo lo que hemos visto sugiere que cuanta más potencia de cálculo tengamos, mejores modelos podremos construir y más productos valiosos podremos crear.

Ahora mismo estamos ampliando los modelos en dos dimensiones: un mayor preentrenamiento y más aprendizaje por refuerzo (RL)/entrenamiento "en fresa", y ambos requieren recursos informáticos.

Dar servicio a cientos de millones de usuarios también requiere recursos informáticos. Y a medida que avanzamos hacia productos con agentes más inteligentes que puedan trabajar continuamente para usted, esto también requiere recursos informáticos. Así que puedes pensar en Stargate como en nuestra fábrica, donde la electricidad y las GPU se convierten en productos increíbles.

P: A nivel interno, ¿qué modelo utilizan ahora? ¿o4, o5 u o6? ¿Cuánto más inteligentes son estos modelos internos en comparación con o3?

Michelle Pokrass, Jefa de Investigación de API: Hemos perdido la cuenta.

P: Por favor, permítenos interactuar con texto/lienzo utilizando funciones de voz avanzadas. Quiero poder hablarle y que modifique los documentos de forma iterativa.

Kevin Weil, Director de Producto: Sí. Tenemos muchas herramientas estupendas que se han desarrollado de forma relativamente independiente; el objetivo es ponerlas en tus manos lo antes posible.

El siguiente paso es integrar todas estas funciones para poder hablar con un modelo, que busque y razone al mismo tiempo, y generar un lienzo que pueda ejecutar Python. Todas las herramientas necesitan trabajar mejor juntas. Y, por cierto, todos los modelos necesitan acceso completo a las herramientas (los modelos de la serie o actualmente no pueden utilizar todas las herramientas), que también se implementará.

P: ¿Cuándo soportarán los modelos de la serie o la función de memoria en ChatGPT?

Michelle Pokrass, Jefa de Investigación de API: Está en desarrollo. Unificar todas nuestras funciones con los modelos de la serie o es nuestra máxima prioridad.

P: ¿Habrá alguna mejora importante en el 4o? Me gusta mucho la GPT personalizada, y sería genial que se pudiera actualizar, o que pudiéramos elegir qué modelo usar en la GPT personalizada (como el o3 mini).

Michelle Pokrass, Directora de Investigación API: Sí, ¡aún no hemos terminado con la serie 4o!