La historia de Géminisnyo 2.0 se está acelerando.

La versión experimental de Flash Thinking de diciembre trajo a los desarrolladores un modelo funcional con baja latencia y alto rendimiento.

A principios de este año, se actualizó 2.0 Flash Thinking Experimental en Google AI Studio para mejorar aún más el rendimiento al combinar la velocidad de Flash con capacidades de inferencia mejoradas.

La semana pasada, la versión actualizada 2.0 Flash se lanzó por completo en las aplicaciones de escritorio y móviles de Gemini.

Hoy se han presentado al mismo tiempo tres nuevos miembros: la versión experimental de Gemini 2.0 Pro, que hasta ahora ha obtenido el mejor rendimiento en codificación e indicaciones complejas, la económica 2.0 Flash-Lite y la versión mejorada para pensamiento 2.0 Flash Thinking.

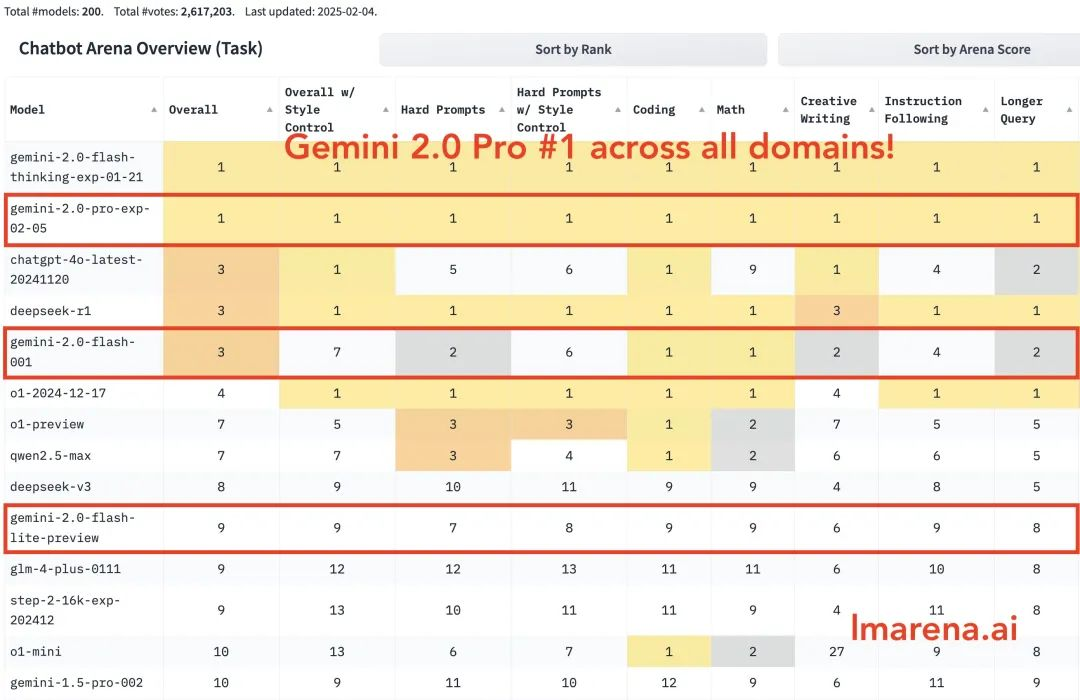

Gemini 2.0 Pro ocupa el primer puesto en todas las categorías. Gemini-2.0-Flash se sitúa entre los tres primeros en programación, matemáticas y rompecabezas. Flash-lite se sitúa entre los diez primeros en todas las categorías.

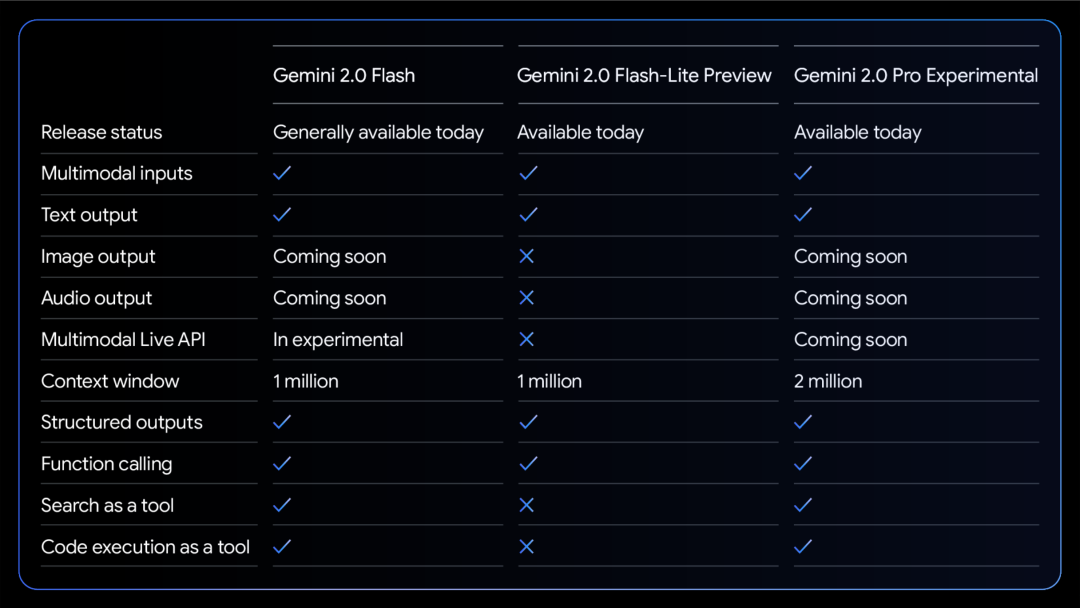

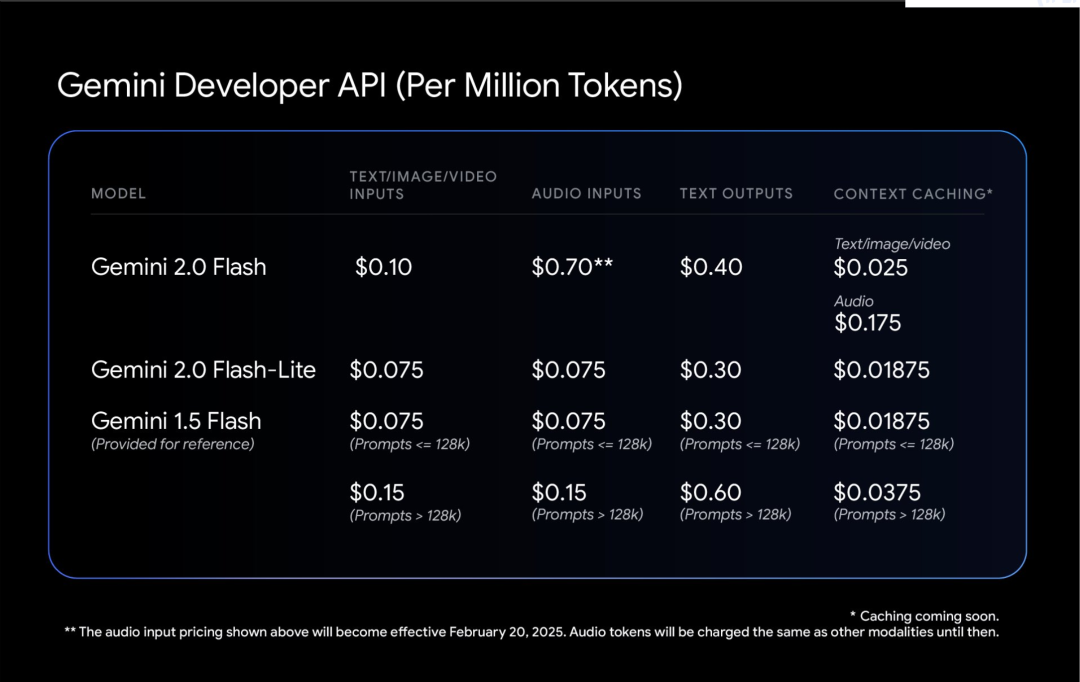

Cuadro comparativo de las capacidades de los tres modelos:

Todos los modelos admiten texto de entrada y salida multimodal.

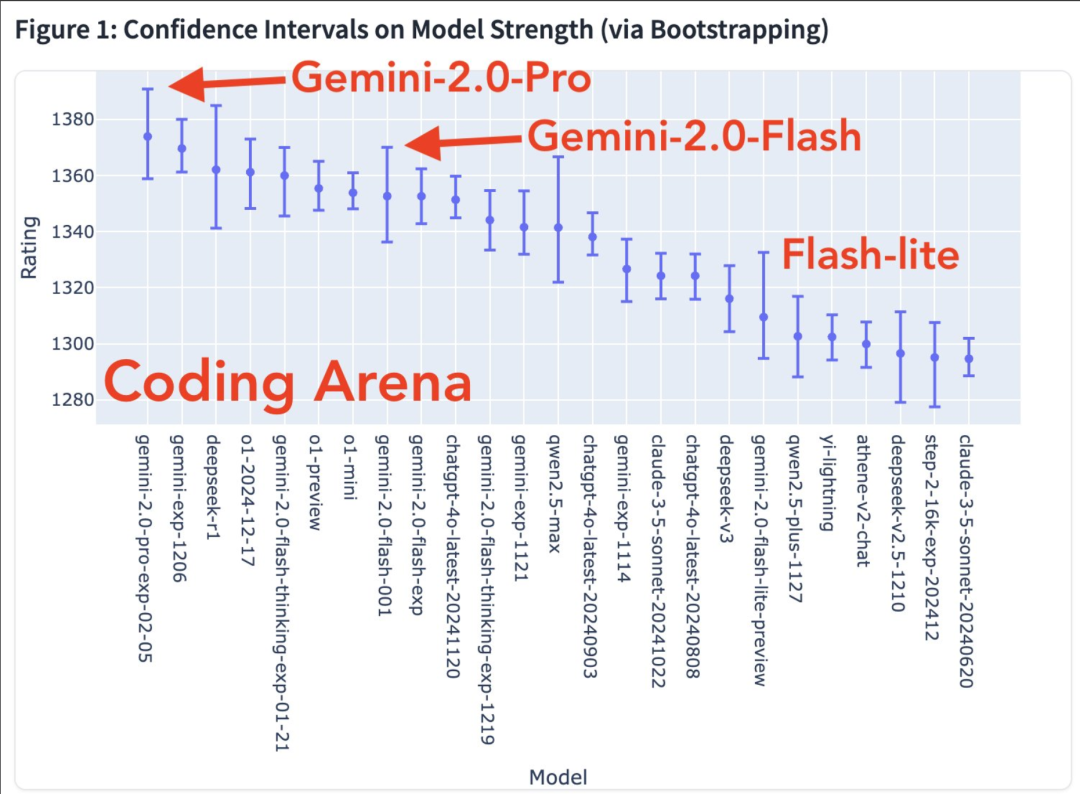

Están por llegar más habilidades modales. Cuadro de fortalezas de modelos en el ámbito de la codificación

Mapa de calor de la tasa de victorias

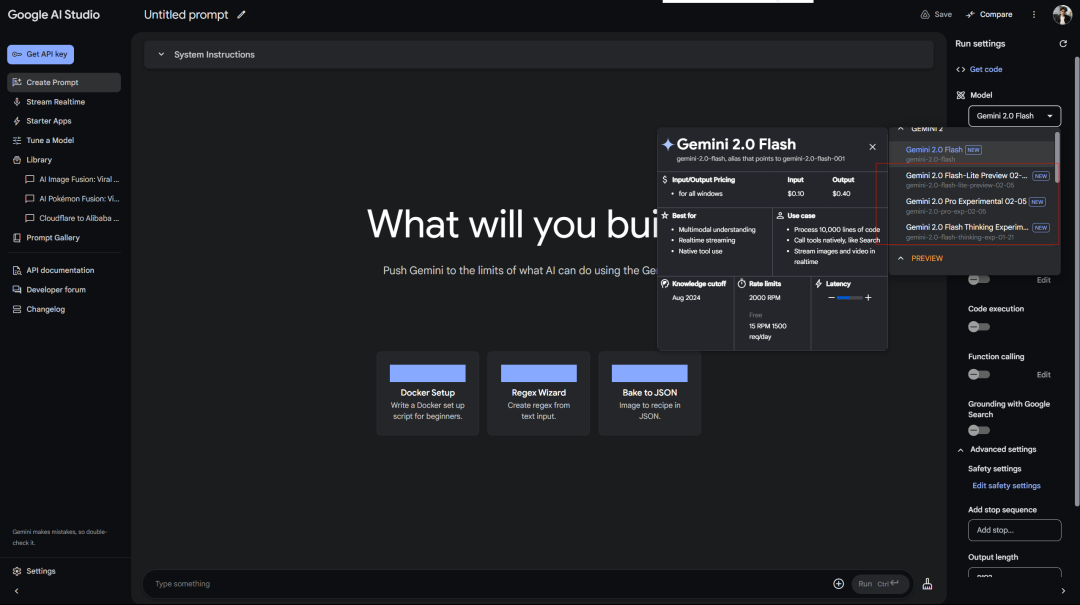

Google trata mejor a los usuarios gratuitos que a los usuarios de OpenAI Plus. Acceso gratuito a Gemini 2.0 Pro Experimental en AI Studio:

El servicio Deepseek siempre muestra un error esperando… Recuerde que el primer modelo libre de inferencias también fue 2.0 Flash Thinking, que se utilizó en Google Aistudio.

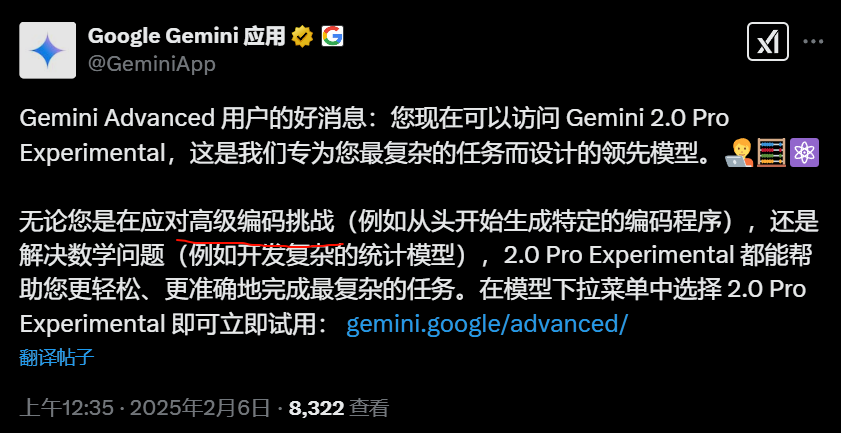

Además, existe la Versión web de Géminis:

También existe un modelo de inferencia conectado (¿por qué separarlo entonces…?)

Google lanzó la versión experimental de Gemini 2.0 Pro, y la mejora en las pruebas oficiales es bastante llamativa.

Tiene las capacidades de codificación más potentes y la capacidad de procesar indicaciones complejas, y tiene una mejor capacidad para comprender y razonar sobre el conocimiento del mundo que cualquier modelo lanzado por Google hasta ahora.

Tiene la ventana de contexto más grande (200k, y mi contexto largo es una ventaja relativamente grande del modelo Gemini), lo que le permite analizar y comprender de manera integral una gran cantidad de información y llamar a herramientas como la búsqueda de Google y la ejecución de código.

En la prueba de MATEMÁTICAS, obtuvo 91,8%, un aumento de aproximadamente 5 puntos porcentuales con respecto a la versión 1.5. La capacidad de razonamiento de GPQA alcanzó 64,7%, y la prueba de conocimiento del mundo SimpleQA incluso alcanzó 44,3%.

Lo más destacable es la capacidad de programación. Obtuvo 36,0% en la prueba LiveCodeBench y la precisión de conversión de Bird-SQL superó los 59,3%. Junto con la ventana de contexto supergrande de 2 millones de tokens, es suficiente para manejar las tareas de análisis de código más complejas.

Puedes probarlo en el cursor.

La capacidad de comprensión de varios idiomas también es impresionante, con una puntuación en la prueba MMLU global de 86,5%. La comprensión de imágenes MMMU es de 72,7% y la capacidad de análisis de vídeo es de 71,9%.

Gemini 2.0 Flash-Lite es un equilibrio interesante.

Mantiene la velocidad y el coste de 1.5 Flash, pero aporta un mejor rendimiento. La ventana de contexto con 1 millón de tokens le permite procesar más información.

Lo más práctico es su relación precio/rendimiento: generar subtítulos para 40.000 fotos cuesta menos que $1. Esto hace que la IA sea más realista.

El blogger Shrivastava mencionó: ¡La codificación de Gemini 2.0 Pro es una locura!

Consejo: usa Three.js para crear una simulación del sistema solar. Agrega una escala de tiempo, un menú desplegable de enfoque, muestra las órbitas y las etiquetas. Crea todo en un solo archivo para poder pegarlo en un editor en línea y ver el resultado.

Además, algunos usuarios mencionaron que Gemini 2.0 Flash produjo mejores resultados en una de sus propias pruebas de paradoja:

Finalmente, Google mencionó que la seguridad de Gemini 2.0, no sólo el parche, está en el centro del diseño desde el principio.

Deje que el modelo aprenda a ser autocrítico. Utilice el aprendizaje por refuerzo para que Gemini evalúe sus propias respuestas y proporcione comentarios más precisos. Esto lo hace más sólido al tratar temas delicados.

La prueba automatizada del equipo rojo es interesante. Está diseñada específicamente para evitar la inyección de palabras de aviso indirectas, lo que equivale a dotar a la IA de un sistema inmunológico para evitar que alguien oculte comandos maliciosos en los datos.