Ninguno de nosotros esperaba que así empezaría el año 2025 en el campo de la IA.

DeepSeek R1 ¡es realmente asombroso!

Recientemente, la "misteriosa potencia oriental" DeepSeek ha estado "controlando duramente" Silicon Valley.

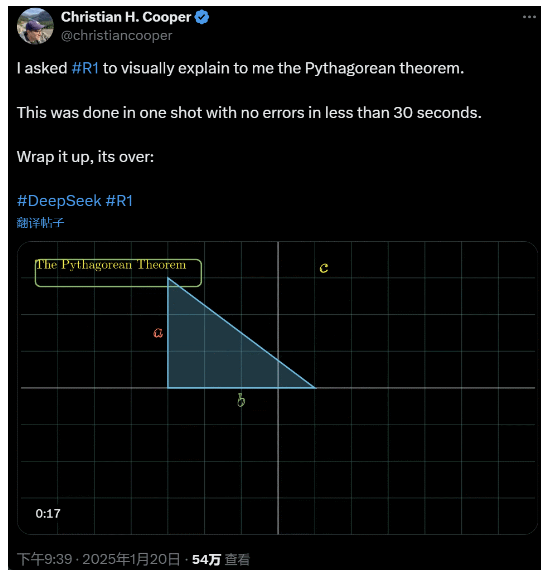

Le pedí a R1 que explicara detalladamente el teorema de Pitágoras. Todo esto lo hizo la IA en menos de 30 segundos sin ningún error. En resumen, se acabó.

En los círculos de IA nacionales y extranjeros, los internautas de a pie han descubierto la asombrosa y poderosa nueva IA (que también es de código abierto), y los expertos académicos han gritado "tenemos que ponernos al día". También hay rumores de que las empresas extranjeras de IA ya se enfrentan a una gran amenaza.

No hay más que ver este DeepSeek R1 lanzado esta semana. Su ruta de puro aprendizaje por refuerzo sin ningún tipo de entrenamiento supervisado es impactante. Desde el desarrollo de la base Deepseek-v3 en diciembre del año pasado hasta las capacidades actuales de la cadena de pensamiento comparables a OpenAI o1, parece cuestión de tiempo.

Pero mientras la comunidad de la IA está ocupada leyendo informes técnicos y comparando mediciones reales, la gente sigue teniendo dudas sobre la R1: aparte de ser capaz de superar a un montón de puntos de referencia, ¿puede realmente liderar?

¿Puede construir sus propias simulaciones de "leyes físicas"?

¿No te lo crees? ¿Dejemos que la gran modelo juegue con un pinball?

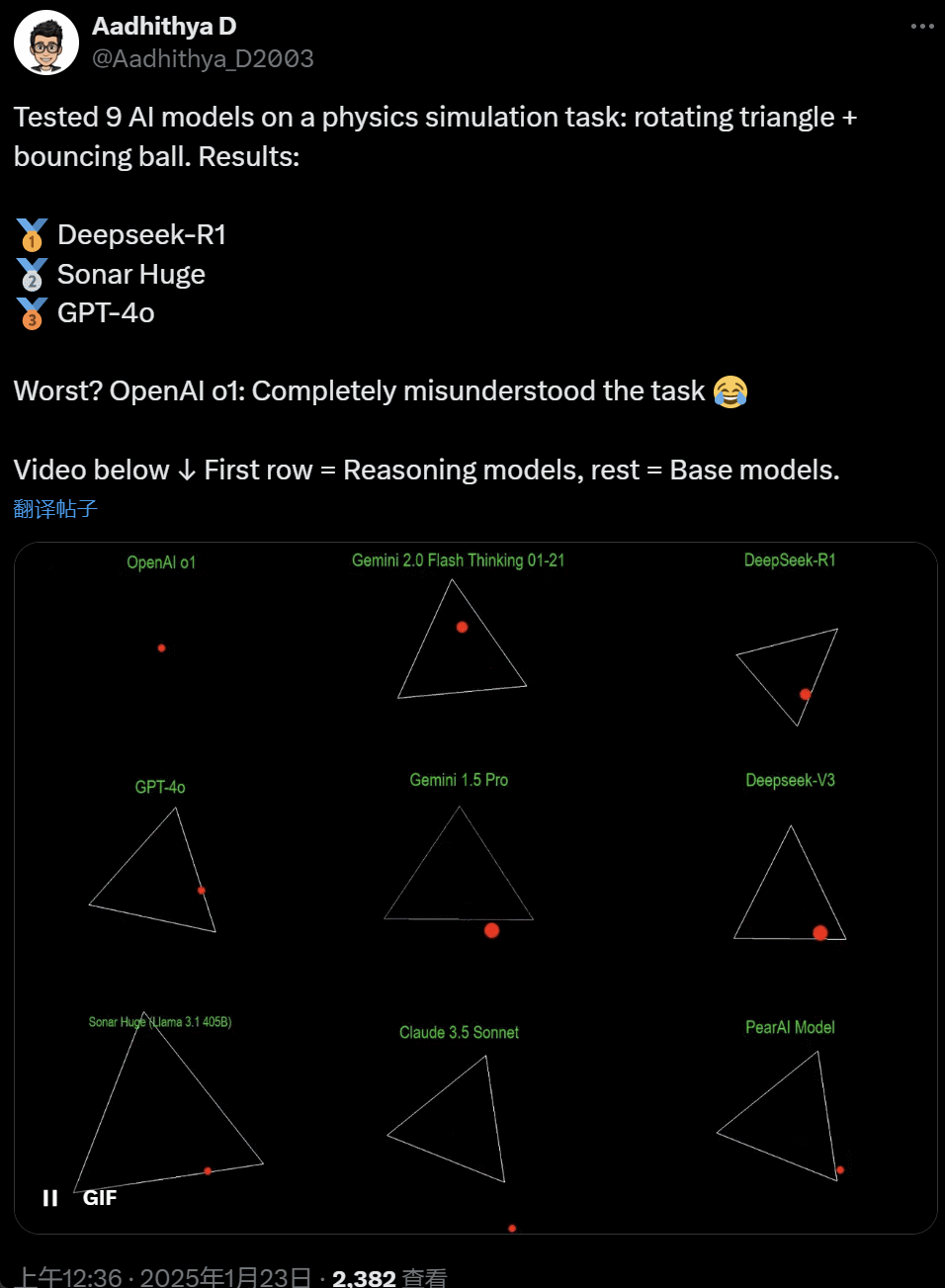

En los últimos días, algunas personas de la comunidad de la IA se han obsesionado con una prueba: probar diferentes grandes modelos de IA (especialmente los llamados modelos de razonamiento) para resolver un problema: "Escribe un script en Python para hacer que una pelota amarilla rebote dentro de una determinada forma. Haz que la forma gire lentamente y asegúrate de que la pelota permanece dentro de la forma".

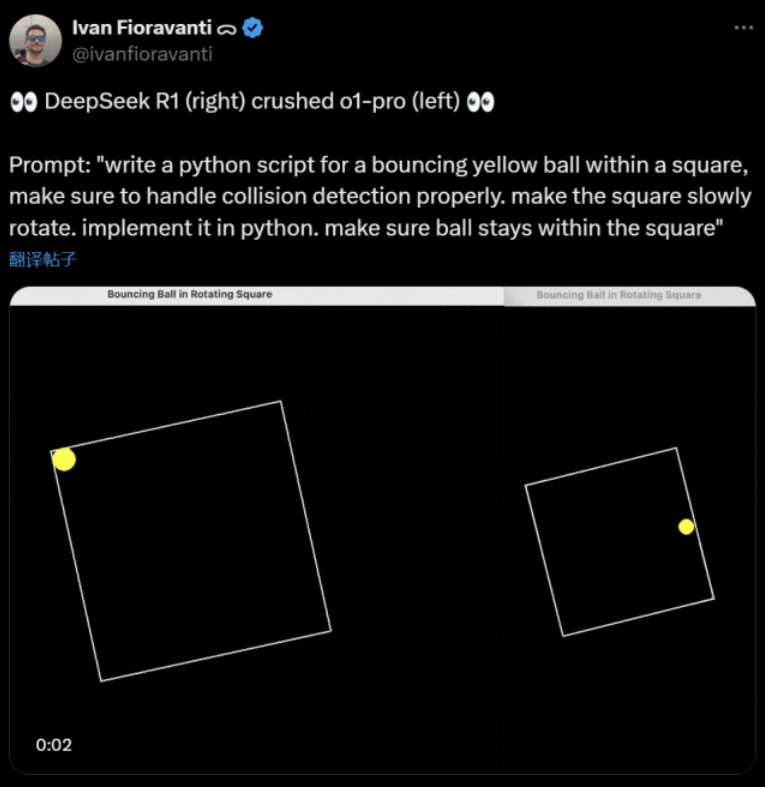

Algunos modelos superan a otros en esta prueba de "bola giratoria". Según Ivan Fioravanti, CTO de CoreView, DeepSeek, un laboratorio nacional de inteligencia artificial, tiene un modelo grande R1 de código abierto que supera al modelo o1 pro de OpenAI, que cuesta $200 al mes como parte del programa ChatGPT Pro de OpenAI.

A la izquierda está OpenAI o1, y a la derecha DeepSeek R1. Como se mencionó anteriormente, el mensaje aquí es: "escriba un script en python para una pelota amarilla rebotando dentro de un cuadrado, asegúrese de manejar la detección de colisiones correctamente. haga que el cuadrado gire lentamente. impleméntelo en python. asegúrese de que la pelota permanezca dentro del cuadrado".

Según otro usuario en X, los modelos Anthropic Claude 3.5 Sonnet y Gemini 1.5 Pro de Google hicieron juicios incorrectos sobre principios físicos, provocando que la pelota se desviara de su forma. Algunos usuarios también han informado de que el último Gemini 2.0 Flash Thinking Experimental de Google, así como el relativamente más antiguo OpenAI GPT-4o, superaron la evaluación a la primera.

Pero hay una manera de distinguirlos:

Los internautas bajo este tweet dijeron: la habilidad de o1 era originalmente muy buena, pero se volvió más débil después de que OpenAI optimizara la velocidad, incluso con la versión de membresía de $200/mes.

Simular una pelota que rebota es un reto clásico de programación. Una simulación precisa combina algoritmos de detección de colisiones, que deben identificar cuándo chocan dos objetos (como una pelota y el lateral de una forma). Un algoritmo mal escrito puede afectar al rendimiento de la simulación o provocar errores físicos evidentes.

N8 Programs, investigador de la startup de IA Nous Research, afirma que tardó unas dos horas en escribir desde cero una pelota que rebota en un heptágono giratorio. "Hay que seguir múltiples sistemas de coordenadas, entender cómo se gestionan las colisiones en cada sistema y diseñar el código desde cero para que sea robusto".

Aunque las pelotas que rebotan y las formas que giran son una prueba razonable de las habilidades de programación, siguen siendo proyectos nuevos para modelos grandes, e incluso pequeños cambios en las indicaciones pueden producir resultados diferentes. Por eso, para que acabe formando parte de las pruebas de referencia de los grandes modelos de IA, aún hay que mejorarlo.

En cualquier caso, tras esta oleada de pruebas prácticas, tenemos una idea de las diferencias de capacidades entre los grandes modelos.

DeepSeek es el nuevo "mito de Silicon Valley

DeepSeek está causando pánico" en todo el Pacífico.

Los empleados de Meta han publicado que "los ingenieros de Meta están analizando frenéticamente DeepSeek para intentar copiar todo lo que puedan de él."

Alexandr Wang, fundador de la startup de tecnología de IA Scale AI, también declaró públicamente que el rendimiento del gran modelo de IA de DeepSeek es aproximadamente equivalente al mejor modelo de Estados Unidos.

También cree que Estados Unidos puede haber estado por delante de China en la competición por la IA durante la última década, pero el lanzamiento de DeepSeek de su gran modelo de IA puede "cambiarlo todo".

X Blogger @8teAPi cree que DeepSeek no es un "proyecto paralelo", sino que es como los antiguos "Skunk Works" de Lockheed Martin.

Los llamados "Skunk Works" se refieren a un pequeño equipo altamente confidencial y relativamente independiente que Lockheed Martin creó originalmente para desarrollar muchas aeronaves avanzadas, dedicadas a la investigación y el desarrollo de tecnologías punteras o no convencionales. Desde el avión de reconocimiento U-2 y el SR-71 Blackbird hasta el F-22 Raptor y el caza F-35 Lightning II, todos salieron de aquí.

Más tarde, el término evolucionó gradualmente hasta convertirse en un término genérico utilizado para describir equipos de innovación "pequeños pero finos", relativamente independientes y más flexibles, creados en el seno de grandes empresas u organizaciones.

Dio dos razones:

- Por un lado, DeepSeek cuenta con un gran número de GPU, al parecer más de 10.000, y Alexandr Wang, CEO de Scale AI, llegó a afirmar que podría alcanzar las 50.000.

- Por otra parte, DeepSeek sólo recluta talentos de las tres mejores universidades de China, lo que significa que DeepSeek es tan competitiva como Alibaba y Tencent.

Estos dos hechos demuestran por sí solos que DeepSeek ha logrado un claro éxito comercial y es lo suficientemente conocido como para obtener estos recursos.

En cuanto a los costes de desarrollo de DeepSeek, el bloguero dijo que las empresas tecnológicas chinas pueden recibir diversas subvenciones, como bajos costes de electricidad y uso del suelo.

Por lo tanto, es muy probable que la mayor parte de los costes de DeepSeek se hayan "colocado" en una cuenta ajena a la actividad principal o en forma de algún tipo de subvención para la construcción de centros de datos.

Incluso aparte de los fundadores, nadie entiende completamente todos los acuerdos financieros. Algunos acuerdos pueden ser simplemente "acuerdos verbales" que se finalizan basándose únicamente en la reputación.

En cualquier caso, algunas cosas están claras:

- El modelo es excelente, comparable a la versión publicada por OpenAI hace dos meses, y por supuesto es posible que no sea tan bueno como los nuevos modelos que OpenAI y Anthropic aún tienen que publicar.

- Desde la perspectiva actual, la dirección de la investigación sigue dominada por las empresas estadounidenses. El modelo DeepSeek es una "continuación rápida" de la versión o1, pero los avances en investigación y desarrollo de DeepSeek son muy rápidos, y se ponen al día antes de lo esperado. No están plagiando ni haciendo trampas, como mucho están haciendo ingeniería inversa.

- DeepSeek está formando principalmente a sus propios talentos, en lugar de depender de doctores formados en Estados Unidos, lo que amplía enormemente la reserva de talentos.

- En comparación con las empresas estadounidenses, DeepSeek está sujeta a menos restricciones en cuanto a licencias de propiedad intelectual, privacidad, seguridad, política, etc., y hay menos preocupaciones por el uso indebido de datos sobre los que la gente no quiere recibir formación. Hay menos demandas, menos abogados y menos preocupaciones.

No cabe duda de que cada vez son más los que creen que 2025 será un año decisivo. Mientras tanto, las empresas se preparan para ello. Meta, por ejemplo, está construyendo un centro de datos de 2GW+, con una inversión estimada de $60-65.000 millones para 2025, y contará con más de 1,3 millones de GPU para finales de año.

Meta incluso utilizó un gráfico para comparar su centro de datos de 2 gigavatios con el de Manhattan, Nueva York.

Pero ahora DeepSeek lo ha hecho mejor con un coste menor y menos GPU. ¿Cómo puede esto no inquietar a la gente?

Yann LeCun: Tenemos que dar las gracias al CTO y cofundador de el código abierto

Hiperbólico, Yuchen Jin, por publicar que en sólo 4 días, DeepSeek-R1 nos ha demostrado 4 hechos:

- La IA de código abierto sólo lleva 6 meses de retraso con respecto a la de código cerrado

- China domina la competición de IA de código abierto

- Estamos entrando en la edad de oro del aprendizaje por refuerzo de grandes modelos lingüísticos

- Los modelos de destilación son muy potentes, y ejecutaremos IA altamente inteligente en teléfonos móviles

La reacción en cadena desencadenada por DeepSeek aún continúa, como la puesta a disposición gratuita de OpenAI o3-mini, la esperanza en la comunidad de reducir las vagas discusiones sobre AGI/ASI, y el rumor de que Meta está presa del pánico.

Cree que es difícil predecir quién ganará finalmente, pero no debemos olvidar el poder de la ventaja del que llega tarde. Al fin y al cabo, todos sabemos que fue Google quien inventó Transformer, mientras que OpenAI desbloqueó su verdadero potencial.

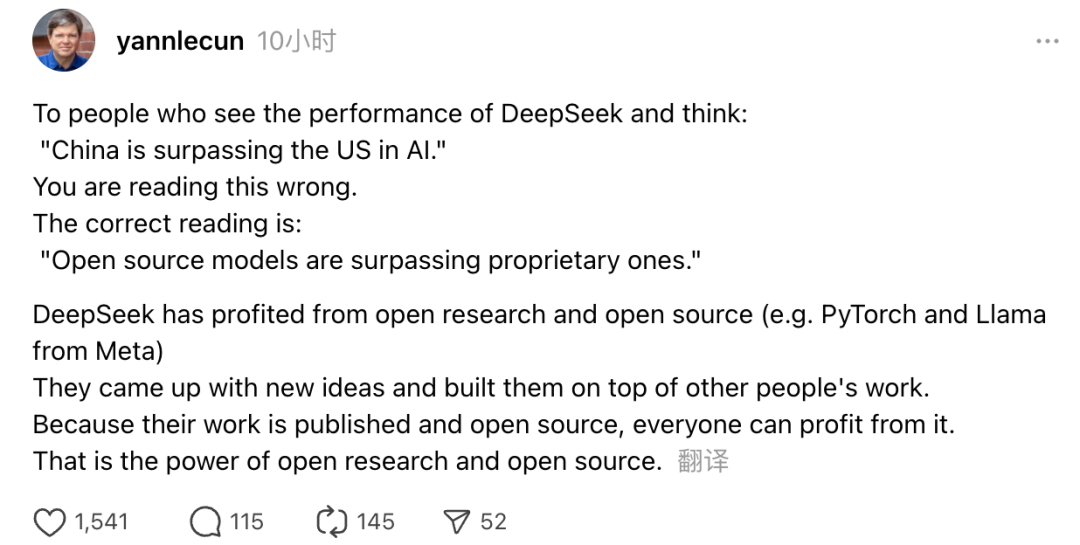

Además, Yann LeCun, ganador del premio Turing y científico jefe de IA de Meta, también expresó su opinión.

"Para quienes, al ver el rendimiento de DeepSeek, piensen: 'China está superando a EE.UU. en IA', se equivocan. Lo correcto es entender que los modelos de código abierto están superando a los modelos propietarios."

LeCun afirma que la razón por la que DeepSeek ha causado tanto revuelo esta vez es que se ha beneficiado de la investigación abierta y el código abierto (como PyTorch y Llama de Meta). DeepSeek ha aportado nuevas ideas y se ha basado en el trabajo de otros. Como su trabajo es público y de código abierto, todo el mundo puede beneficiarse de él. Este es el poder de la investigación abierta y el código abierto.

Las reflexiones de los internautas continúan. Aunque están entusiasmados con el desarrollo de las nuevas tecnologías, también sienten un poco de ansiedad. Después de todo, la aparición de DeepSeekers puede tener un impacto real.