אף אחד מאיתנו לא ציפה שכך תתחיל 2025 בתחום הבינה המלאכותית.

DeepSeek R1 הוא באמת מדהים!

לאחרונה, "הכוח המזרחי המסתורי" DeepSeek "שלט קשה" בעמק הסיליקון.

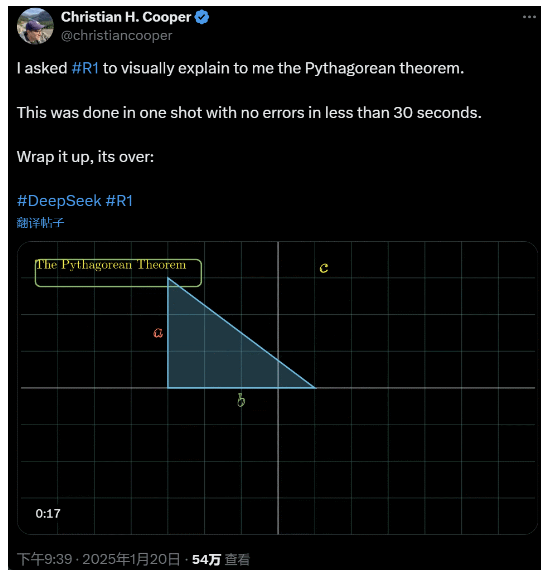

ביקשתי מ-R1 להסביר את משפט פיתגורס בפירוט. כל זה נעשה על ידי AI תוך פחות מ-30 שניות ללא טעויות. בקיצור, זה נגמר.

בחוגי ה-AI המקומיים והזרים, גולשים ברשת רגילים גילו את ה-AI החדש המדהים והעוצמתי (שהוא גם קוד פתוח), ומומחים אקדמיים צעקו "אנחנו חייבים להתעדכן". יש גם שמועה שחברות בינה מלאכותית בחו"ל כבר עומדות בפני איום גדול.

פשוט קח את ה-DeepSeek R1 הזה שיצא השבוע. מסלול לימוד החיזוק הטהור שלו ללא כל הכשרה מפוקחת מזעזע. מהפיתוח של בסיס Deepseek-v3 בדצמבר אשתקד ועד ליכולות שרשרת החשיבה הנוכחיות המשוות ל-OpenAI o1, נראה שזה עניין של זמן.

אבל בעוד שקהילת הבינה המלאכותית עסוקה בקריאת דוחות טכניים ובהשוואת מדידות בפועל, לאנשים עדיין יש ספקות לגבי R1: מלבד היכולת לעלות על מספר מדדים, האם זה באמת יכול להוביל?

האם היא יכולה לבנות סימולציות משלה של "חוקים פיזיקליים"?

אתה לא מאמין בזה? בואו ניתן לדוגמנית הגדולה לשחק עם פינבול?

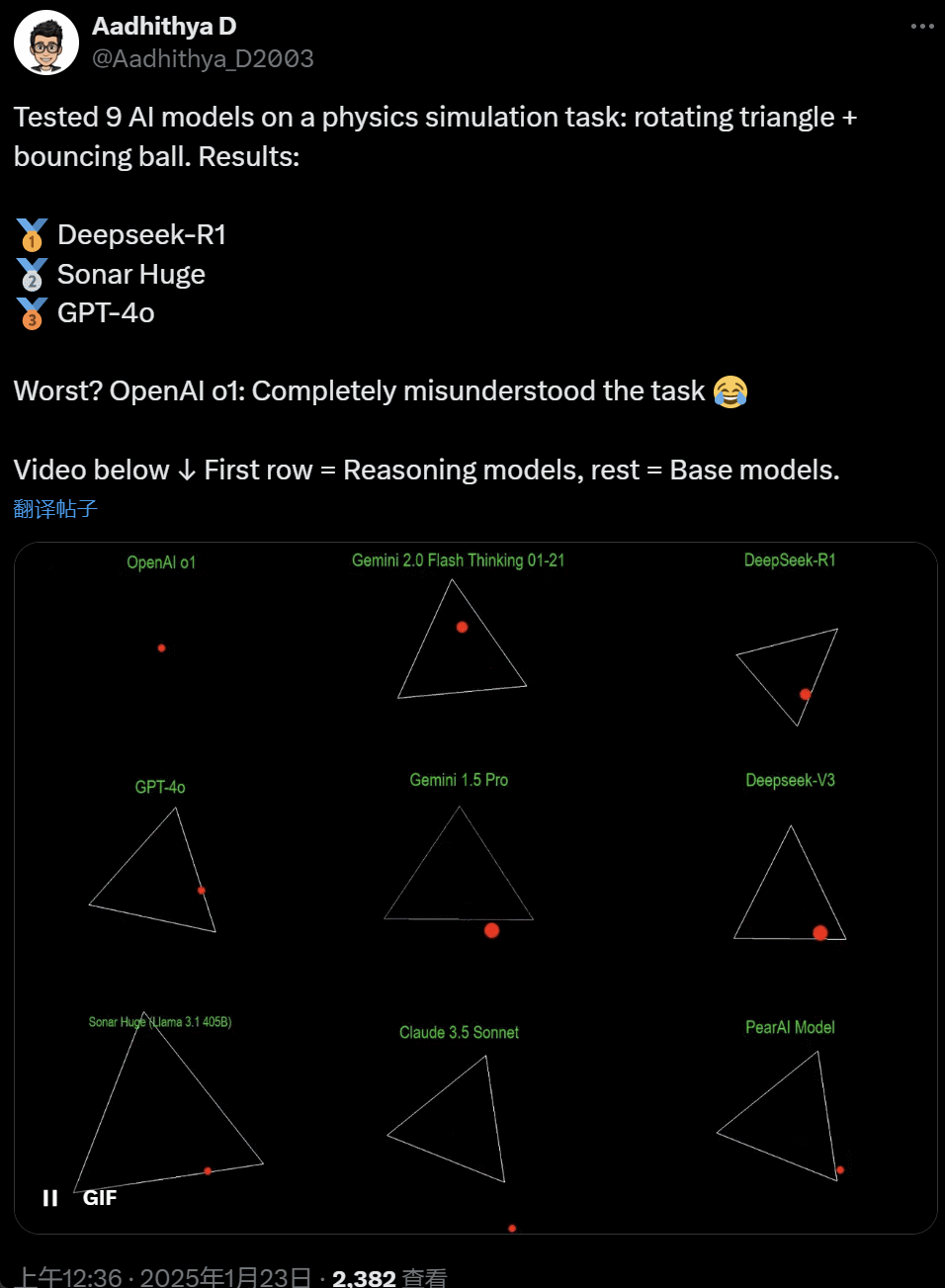

בימים האחרונים, כמה אנשים בקהילת הבינה המלאכותית הפכו אובססיביים למבחן - בדיקת מודלים גדולים של בינה מלאכותית (במיוחד מה שנקרא מודלים של חשיבה) כדי לפתור בעיה: "כתוב סקריפט של Python כדי לגרום לכדור צהוב לקפוץ בתוך מסויים צוּרָה. לגרום לצורה להסתובב לאט ולוודא שהכדור יישאר בתוך הצורה."

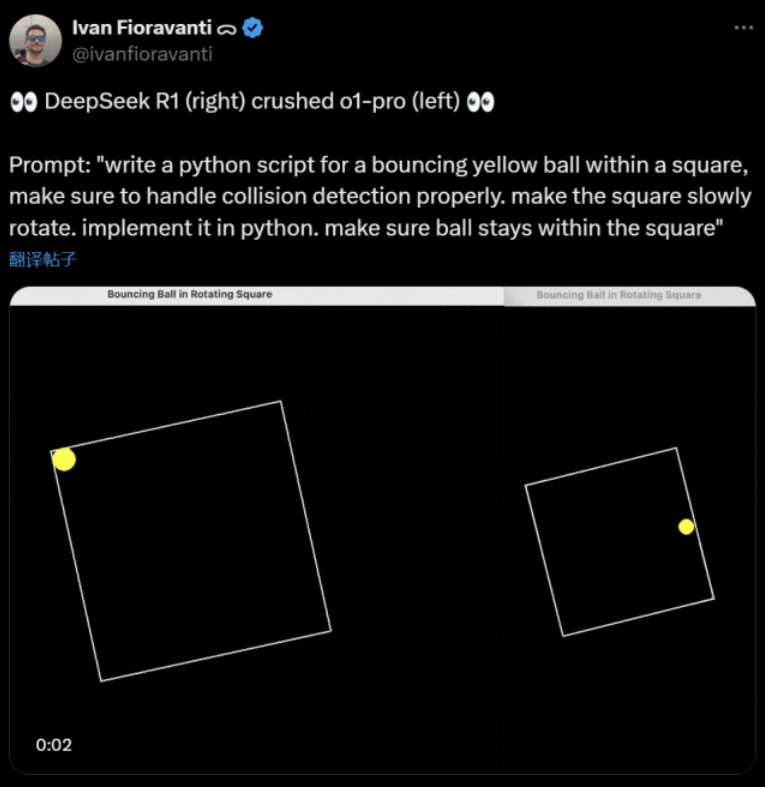

דגמים מסוימים מתגברים על אחרים במדד "כדור מסתובב" זה. על פי ה-CTO של CoreView, Ivan Fioravanti, ל-DeepSeek, מעבדת בינה מלאכותית ביתית, יש דגם גדול של קוד פתוח R1 שמנצח את דגם o1 pro של OpenAI, שעולה $200 לחודש כחלק מתוכנית ChatGPT Pro של OpenAI.

משמאל נמצא OpenAI o1, ומימין DeepSeek R1. כפי שהוזכר לעיל, ההנחיה כאן היא: "כתוב סקריפט פיתון עבור כדור צהוב מקפץ בתוך ריבוע, הקפד לטפל בזיהוי התנגשות כראוי. לגרום לריבוע להסתובב לאט. ליישם את זה בפיתון. ודא שהכדור יישאר בתוך הריבוע."

לפי משתמש אחר ב-X, הדגמים Anthropic Claude 3.5 Sonnet ודגמי Gemini 1.5 Pro של גוגל עשו שיפוט שגוי לגבי עקרונות פיזיים, מה שגרם לכדור לסטות מצורתו. חלק מהמשתמשים דיווחו גם ש-Gemini 2.0 Flash Thinking Experimental האחרון של גוגל, כמו גם OpenAI GPT-4o הישן יחסית, עברו את ההערכה בבת אחת.

אבל יש דרך להבחין בהבדל כאן:

גולשים ברשת תחת הציוץ הזה אמרו: היכולת של o1 הייתה במקור טובה מאוד, אבל היא נחלשה לאחר ש-OpenAI עשתה אופטימיזציה של המהירות, אפילו עם גרסת החברות $200/month.

הדמיית כדור קופץ הוא אתגר תכנות קלאסי. סימולציה מדויקת משלבת אלגוריתמים לזיהוי התנגשות, שצריכים לזהות מתי שני עצמים (כגון כדור וצד של צורה) מתנגשים. אלגוריתם כתוב בצורה לא נכונה יכול להשפיע על ביצועי הסימולציה או לגרום לשגיאות פיזיות ברורות.

N8 Programs, חוקר בסטארט-אפ בינה מלאכותית Nous Research, אמר שלקח לו כשעתיים לכתוב כדור מקפץ בקופטגון מסתובב מאפס. "יש לעקוב אחר מערכות קואורדינטות מרובות, נדרשת הבנה של אופן הטיפול בהתנגשויות בכל מערכת, והקוד חייב להיות מתוכנן מאפס להיות חזק".

למרות שכדורים מקפצים וצורות מסתובבות הם מבחן סביר של כישורי תכנות, הם עדיין פרויקטים חדשים עבור דגמים גדולים, ואפילו שינויים קטנים בהנחיות יכולים להניב תוצאות שונות. אז אם זה יהפוך בסופו של דבר לחלק ממבחן הבנצ'מרק עבור דגמי AI גדולים, זה עדיין צריך להשתפר.

בכל מקרה, אחרי גל המבחנים המעשיים הזה, יש לנו תחושה של הבדלי היכולות בין דגמים גדולים.

DeepSeek הוא "מיתוס עמק הסיליקון" החדש

DeepSeek גורם לפאניקה" ברחבי האוקיינוס השקט.

עובדי Meta פרסמו כי "מהנדסי Meta מנתחים בטירוף את DeepSeek כדי לנסות להעתיק ממנו כל מה שהם יכולים".

אלכסנדר וואנג, מייסד סטארט-אפ טכנולוגיית הבינה המלאכותית Scale AI, הצהיר גם הוא בפומבי כי הביצועים של דגם ה-AI הגדול של DeepSeek מקבילים בערך לדגם הטוב ביותר בארצות הברית.

הוא גם מאמין שארה"ב אולי הקדימה את סין בתחרות הבינה המלאכותית בעשור האחרון, אבל השחרור של DeepSeek של דגם ה-AI הגדול שלה עשוי "לשנות הכל".

X Blogger @8teAPi מאמין ש-DeepSeek אינו "פרויקט צדדי" אלא הוא כמו "Skunk Works" לשעבר של לוקהיד מרטין.

מה שנקרא "Skunk Works" מתייחס לצוות קטן חסוי ביותר, עצמאי יחסית, שלוקהיד מרטין הקימה במקור כדי לפתח מטוסים מתקדמים רבים, העוסקים במחקר ופיתוח טכנולוגי חדשני או לא שגרתי. ממטוסי הסיור U-2 ו-SR-71 Blackbird ועד למטוס הקרב F-22 Raptor ו-F-35 Lightning II, כולם הגיעו מכאן.

מאוחר יותר, המונח התפתח בהדרגה למונח גנרי המשמש לתיאור צוותי חדשנות עצמאיים יחסית וגמישים יותר של "קטן אבל בסדר", שהוקמו בתוך חברות או ארגונים גדולים.

הוא נתן שתי סיבות:

- מצד אחד, ל-DeepSeek יש מספר רב של GPUs, לפי הדיווחים יותר מ-10,000, ואלכסנדר וואנג, מנכ"ל Scale AI, אפילו אמר שהוא יכול להגיע ל-50,000.

- מצד שני, DeepSeek מגייסת רק כישרונות משלוש האוניברסיטאות המובילות בסין, מה שאומר ש-DeepSeek תחרותית כמו עליבאבא וטנסנט.

שתי עובדות אלו לבדן מראות ש-DeepSeek השיגה בבירור הצלחה מסחרית והיא מוכרת מספיק כדי להשיג משאבים אלו.

באשר לעלויות הפיתוח של DeepSeek, הבלוגר אמר שחברות טכנולוגיה סיניות יכולות לקבל מגוון סובסידיות, כמו עלויות חשמל נמוכות ושימוש בקרקע.

לכן, סביר מאוד שרוב העלויות של DeepSeek "הושמו" בחשבון מחוץ לעסק הליבה או בצורה של סבסוד בניית מרכז נתונים.

גם מלבד המייסדים, אף אחד לא מבין לגמרי את כל ההסדרים הפיננסיים. חלק מההסכמים עשויים להיות פשוט "הסכמים מילוליים" שמתגבשים על סמך מוניטין בלבד.

בכל מקרה, כמה דברים ברורים:

- הדגם מצוין, דומה לגרסה שהוציאה OpenAI לפני חודשיים, וכמובן יתכן שהוא לא טוב כמו הדגמים החדשים ש-OpenAI ו-Anthropic טרם הוציאו.

- מנקודת המבט הנוכחית, כיוון המחקר עדיין נשלט על ידי חברות אמריקאיות. מודל DeepSeek הוא "המשך מהיר" לגרסת o1, אך התקדמות המחקר והפיתוח של DeepSeek מהירה מאוד, ומתעדכנת מהר מהצפוי. הם לא גניבת עין או רמאות, לכל היותר הם הנדסה הפוכה.

- DeepSeek מאמנת בעיקר את הכישרון שלה, במקום להסתמך על דוקטורים שעברו הכשרה אמריקאית, מה שמרחיב מאוד את מאגר הכישרונות.

- בהשוואה לחברות אמריקאיות, DeepSeek כפוף לפחות אילוצים במונחים של רישוי קניין רוחני, פרטיות, אבטחה, פוליטיקה וכו', ויש פחות חששות לגבי שימוש לא נכון בנתונים שאנשים לא רוצים לקבל הכשרה עליהם. יש פחות תביעות, פחות עורכי דין ופחות חששות.

אין ספק שיותר ויותר אנשים מאמינים ש-2025 תהיה שנה מכרעת. בינתיים, חברות נערכים לכך. Meta, למשל, בונה מרכז נתונים 2GW+, עם השקעה משוערת של $60-65 מיליארד עד 2025, ויהיה לה יותר מ-1.3 מיליון GPUs עד סוף השנה.

Meta אפילו השתמשה בתרשים כדי להשוות את מרכז הנתונים שלה ב-2 ג'יגה-וואט עם מנהטן, ניו יורק.

אבל עכשיו DeepSeek הצליח יותר עם עלות נמוכה יותר ופחות GPUs. איך זה לא גורם לאנשים לחרדות?

יאן לקון: עלינו להודות ל-CTO ולמייסד השותף של את קוד פתוח

היפרבוליק, יוצ'ן ג'ין, על כך שפרסמתי שבתוך 4 ימים בלבד, DeepSeek-R1 הוכיח לנו 4 עובדות:

- בינה מלאכותית בקוד פתוח נמצאת רק 6 חודשים אחרי AI בקוד סגור

- סין שולטת בתחרות הבינה המלאכותית בקוד פתוח

- אנו נכנסים לתור הזהב של למידת חיזוק מודלים של שפות גדולות

- מודלים של זיקוק הם חזקים מאוד, ואנו נפעיל AI אינטליגנטי ביותר בטלפונים ניידים

תגובת השרשרת שהופעלה על ידי DeepSeek עדיין נמשכת, כמו OpenAI o3-mini שהופך זמין באופן חופשי, התקווה בקהילה לצמצם את הדיונים המעורפלים על AGI/ASI והשמועה שמטה נמצאת בפאניקה.

הוא מאמין שקשה לחזות מי ינצח בסופו של דבר, אבל אסור לשכוח את כוחו של היתרון של המאחר. אחרי הכל, כולנו יודעים שגוגל היא שהמציאה את Transformer, בעוד ש-OpenAI פתחה את הפוטנציאל האמיתי שלה.

בנוסף, זוכה פרס טיורינג ומדען הבינה המלאכותית הראשי של Meta, יאן לקון, הביע גם הוא את דעותיו.

"למי שראה את הביצועים של DeepSeek, חושב 'סין עוקפת את ארה"ב ב-AI', אתה טועה. ההבנה הנכונה היא שמודלים של קוד פתוח עוקפים מודלים קנייניים".

LeCun אמר שהסיבה לכך ש-DeepSeek עשה סנסציה כזו הפעם היא בגלל שהם נהנו ממחקר פתוח וקוד פתוח (כגון PyTorch ו-Llama של Meta). DeepSeek הגה רעיונות חדשים ונבנה על עבודתם של אחרים. מכיוון שהעבודה שלהם פורסמה לציבור וקוד פתוח, כולם יכולים להפיק מכך תועלת. זהו הכוח של מחקר פתוח וקוד פתוח.

ההרהורים של גולשים ברשת ממשיכים. הם אמנם מתלהבים מהפיתוח של טכנולוגיות חדשות, אבל הם יכולים גם להרגיש קצת אווירה של חרדה. אחרי הכל, להופעתם של DeepSeekers עשויה להיות השפעה אמיתית.