DeepSeek-R1 dan DeepSeek-V3 telah menimbulkan sensasi global sejak peluncuran open source mereka.

Mereka adalah hadiah dari tim DeepSeek untuk seluruh umat manusia, dan kami dengan tulus senang atas keberhasilan mereka.

Setelah berhari-hari bekerja keras oleh tim Silicon Mobility dan Huawei Cloud, hari ini kami juga memberikan hadiah Tahun Baru Imlek kepada pengguna di Tiongkok: platform layanan cloud model skala besar SiliconCloud telah meluncurkan DeepSeek-V3 dan DeepSeek-R1, yang didasarkan pada layanan cloud Ascend dari Huawei Cloud.

Perlu ditekankan bahwa kami telah menerima dukungan besar dari DeepSeek dan Huawei Cloud, baik dalam mengadaptasi DeepSeek-R1 & V3 di Ascend dan dalam proses peluncuran model lain sebelumnya, dan kami ingin mengucapkan terima kasih yang dalam dan rasa hormat yang tinggi.

Fitur

Kedua model yang diluncurkan oleh SiliconCloud ini, terutama mencakup lima fitur utama:

Berdasarkan layanan cloud Ascend dari Huawei Cloud, kami telah meluncurkan DeepSeek x Silicon Mobility x Layanan inferensi model Huawei Cloud R1 & V3 untuk pertama kalinya.

Melalui inovasi bersama antara kedua belah pihak, dan dengan dukungan mesin akselerasi inferensi yang dikembangkan sendiri, model DeepSeek yang digunakan oleh tim Silicon Mobility berdasarkan layanan cloud Ascend dari Huawei Cloud dapat mencapai efek yang sama dengan model penyebaran GPU kelas atas di dunia.

Menyediakan layanan inferensi DeepSeek-R1 & V3 tingkat produksi yang stabil. Hal ini memungkinkan pengembang untuk berjalan dengan stabil di lingkungan produksi berskala besar dan memenuhi kebutuhan penerapan komersial. Layanan Huawei Cloud Ascend AI menyediakan daya komputasi yang melimpah, elastis, dan memadai.

Tidak ada ambang batas penerapan, sehingga pengembang dapat lebih fokus pada pengembangan aplikasi. Ketika mengembangkan aplikasi, mereka dapat langsung memanggil API SiliconCloud, yang memberikan pengalaman yang lebih mudah dan ramah pengguna.

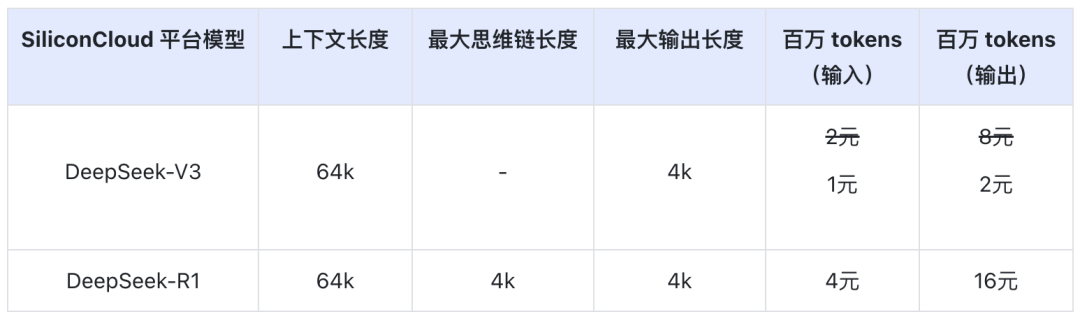

Harga DeepSeek-V3 di SiliconCloud selama periode diskon resmi (hingga pukul 24:00 tanggal 8 Februari) adalah ¥1/M token (input) & ¥2/M token (output), dan harga DeepSeek-R1 adalah ¥4/M token (input) & ¥16/M token (output).

Pengalaman online

DeepSeek-R1 dengan SiliconCloud

DeepSeek-V3 dengan SiliconCloud

Dokumentasi API

Para pengembang dapat merasakan efek akselerasi DeepSeek-R1 & V3 pada chip domestik di SiliconCloud. Kecepatan output yang lebih cepat masih terus dioptimalkan.

Pengalaman dalam aplikasi klien

Jika Anda ingin merasakan model DeepSeek-R1 & V3 secara langsung di aplikasi klien, Anda dapat menginstal produk berikut ini secara lokal dan mengakses API SiliconCloud (Anda dapat menyesuaikan dan menambahkan kedua model ini) untuk merasakan DeepSeek-R1 & V3.

- Aplikasi klien model besar: Kotak Obrolan, Cherry Studio, OneAPI, LobeChat, NextChat

- Aplikasi pembuatan kode: Kursor, Selancar Angin, Cline

- Platform pengembangan aplikasi model besar:Dify

- Basis pengetahuan AI:Obsidian AIdanFastGPT

- Plug-in terjemahan:Terjemahan Imersif, danEurodict

Untuk skenario lebih lanjut dan tutorial akses kasus aplikasi, silakan merujuk ke di sini

Pabrik Token SiliconCloud

Qwen2.5 (7B), dll. 20+ model gratis untuk digunakan

Sebagai platform layanan cloud satu atap untuk model-model besar, SiliconCloud berkomitmen untuk menyediakan API model bagi para pengembang yang sangat responsif, terjangkau, komprehensif, dan memiliki pengalaman yang sangat mulus.

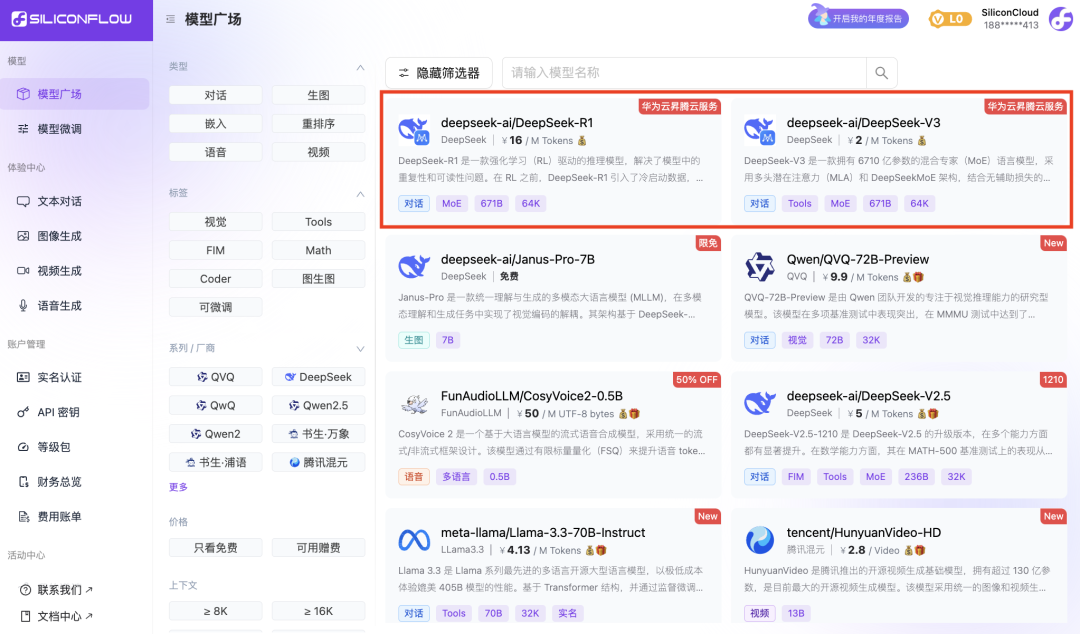

Selain DeepSeek-R1 dan DeepSeek-V3, SiliconCloud juga telah meluncurkan Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

lusinan model bahasa besar sumber terbuka, model pembuatan gambar/video, model ucapan, model kode/matematika, dan model vektor dan penyusunan ulang.

Platform ini memungkinkan pengembang untuk secara bebas membandingkan dan menggabungkan model-model besar dari berbagai modalitas untuk memilih praktik terbaik untuk aplikasi AI generatif Anda.

Di antara mereka, 20+ API model besar seperti Qwen2.5 (7B) dan Llama3.1 (8B) gratis untuk digunakan, memungkinkan pengembang dan manajer produk untuk mencapai "kebebasan token" tanpa mengkhawatirkan biaya daya komputasi selama tahap penelitian dan pengembangan serta promosi berskala besar.