OpenAI ha rilasciato il suo ultimo modello di inferenza, o3-miniche è ottimizzato per campi come la scienza, la matematica e la programmazione, fornendo una risposta più rapida, una maggiore precisione e un costo inferiore.

Rispetto al suo predecessore o1-mini, o3-mini ha migliorato significativamente le sue capacità di inferenza, soprattutto nella risoluzione di problemi complessi. I tester preferiscono le risposte di o3-mini di 56% e il tasso di errore è stato ridotto di 39%. Da oggi, ChatGPT Plus, Squadra e Pro gli utenti possono utilizzare o3-mini e utenti liberi possono sperimentare alcune delle sue caratteristiche.

Rispetto al modello di inferenza DeepSeek-R1quanto sia migliore OpenAI o3-mini di R1?

Questo articolo fornirà innanzitutto una panoramica dei punti salienti di o3-mini, quindi estrarrà i dati da entrambe le parti su ciascun benchmark e creerà un grafico per confrontarli visivamente. Inoltre, confronteremo anche il prezzo di o3-mini.

Punti salienti del nucleo

1.Ottimizzazione STEM: eccelle nei campi della matematica, della programmazione, della scienza e così via, superando in particolare o1-mini nella modalità ad alto sforzo di inferenza.

2.Funzioni dello sviluppatore: supporta funzioni come le chiamate di funzione, l'output strutturato e i messaggi degli sviluppatori per soddisfare le esigenze dell'ambiente di produzione.

3.Risposta rapida24% più veloce di o1-mini, con un tempo di risposta di 7,7 secondi per richiesta.

4.Miglioramento della sicurezza: garantisce una produzione sicura e affidabile grazie alla tecnologia di allineamento profondo.

5.Economicamente vantaggioso: capacità di inferenza e ottimizzazione dei costi vanno di pari passo, riducendo notevolmente la soglia di utilizzo dell'IA.

Confronto

Open AI Per mettere in evidenza la sua classe, il suo blog ufficiale solo il confronto con i propri modelli. Pertanto, questo articolo è una tabella estratta dal documento DeepSeek R1 e dai dati del blog ufficiale di OpenAI.

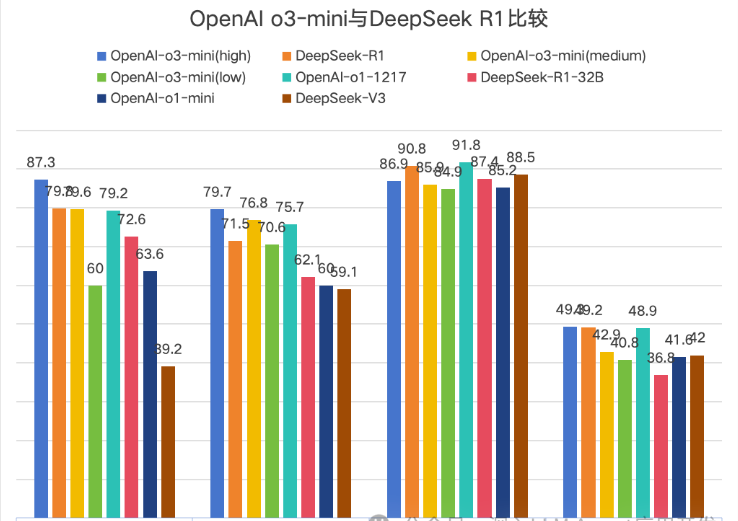

OpenAI si confronta ufficialmente o3-mini nell'elenco delle versioni, suddividendolo in tre versioni: bassa, media e alta, che indicano la forza di inferenza. Poiché DeepSeek utilizza Math-500 e OpenAI utilizza il dataset Math, questo confronto è stato rimosso.

Un grafico è più intuitivo e Codeforces è stato rimosso perché i valori sono troppo grandi per essere visualizzati in modo intuitivo. Tuttavia, il confronto su Codeforces mostra che l'elevata forza di inferenza di o3-mini non è un vantaggio.

↑1Diamante AIME2024→2GPQA→3MMLU→4SWE-bench-Verificato

Il grafico mostra un totale di 4 confronti e l'O3-mini (alto) è generalmente in testa, ma il vantaggio è molto ridotto.

Prezzo

| modello | Prezzo di ingresso | Colpo di cache | Prezzo di uscita |

| o3-mini | $1.10 | $0.55 | $4.40 |

| o1 | $15.00 | $7.50 | $60.00 |

| Deepseek R1 | $0.55 | $0.14 | $2.19 |

Sintesi

Con l'DeepSeek R1 che ha scatenato il panico dell'DeepSeek negli Stati Uniti, il primo a sentirsi minacciato è stato OpenAI, il che è particolarmente evidente nel prezzo del suo nuovo modello o3-mini.

Quando Openai o1 è stato rilasciato per la prima volta, il suo prezzo elevato ha messo sotto pressione molti sviluppatori e utenti. La comparsa dell'DeepSeek R1 ha dato a tutti più possibilità di scelta.Dalla differenza di prezzo di 30 volte tra o1 e R1 al prezzo finale di o3-mini che è il doppio di quello di R1. il prezzo di DeepSeek R1,

mostra l'impatto di DeepSeek R1 su openai.Tuttavia, gli utenti gratuiti di ChatGPT possono sperimentare o3-mini solo in modo limitato, mentre Deep Thinking di DeepSeek è attualmente disponibile per tutti gli utenti.Mi auguro inoltre che openai porti altri modelli di ai leader, riducendo al contempo i costi di utilizzo per gli utenti.

Dal punto di vista dell'esperienza personale di un blogger che utilizza R1, vorrei dire che il Deep Thinking di R1 mi apre sempre la mente. Raccomando a tutti di usarlo di più per pensare ai problemi~