o3-mini è arrivato a notte fonda e OpenAI ha finalmente svelato il suo ultimo asso nella manica. Durante una Q&A su Reddit AMA, Altman ha confessato di essersi messo dalla parte sbagliata dell'IA open source.

Ha dichiarato che si sta valutando la strategia interna dell'open source e che il modello continuerà a essere sviluppato, ma il vantaggio di OpenAI non sarà così grande come prima.

Mentre tutti si stavano ancora meravigliando dell'incredibile potenza dell'DeepSeek, OpenAI alla fine non riusciva più a stare fermo.

Nella prima mattinata di ieri, o3-mini è stato lanciato d'urgenza, stabilendo nuovi SOTA in test di riferimento come il codice matematico e il ritorno al trono.

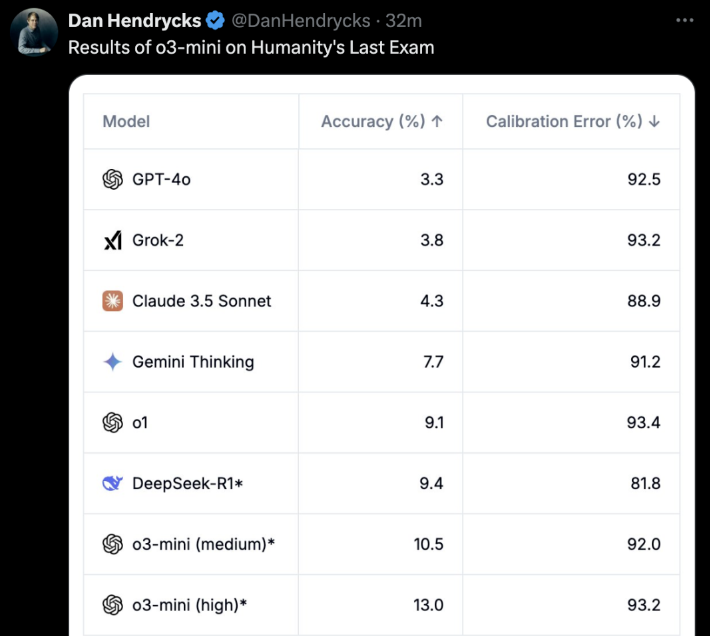

La cosa più importante è che anche gli utenti liberi possono sperimentarlo! o3-mini non scherza. Nell'"ultimo esame per gli esseri umani", o3-mini (alto) ha ottenuto direttamente la migliore precisione ed errore di calibrazione.

Poche ore dopo o3-mini è andato online, OpenAI ha aperto ufficialmente un Reddit AMA per circa un'ora.

Lo stesso Altman è andato online e ha risposto a tutte le domande dei netizen.

I punti salienti sono:

- DeepSeek è davvero molto buonoe continueremo a sviluppare modelli migliori, ma il vantaggio non sarà più così grande come prima.

- Rispetto a qualche anno fa, sono ora più propenso a credere che l'IA possa compiere rapidi balzi in avanti.

- Siamo dalla parte sbagliata della questione dell'open-sourcing dei modelli di intelligenza artificiale ponderata

- È in arrivo un aggiornamento della modalità vocale avanzata, che chiameremo direttamente GPT-5 e non GPT-5o. Non c'è ancora un calendario preciso.

Oltre allo stesso Altman, anche il Chief Research Officer Mark Chen, il Chief Product Officer Kevin Weil, il Vice President of Engineering Srinivas Narayanan, la Head of API Research Michelle Pokrass e la Head of Research Hongyu Ren erano online e hanno risposto con attenzione a tutte le domande dei netizen.

Diamo poi un'occhiata a ciò che hanno detto tutti.

Altman si pente profondamente di essersi schierato dalla parte sbagliata nella battaglia per l'IA open source

L'improvviso ritorno di DeepSeek potrebbe essere stato inaspettato per tutti.

Durante l'AMA Q&A, lo stesso Altman si è pentito profondamente di essersi schierato dalla parte sbagliata nella battaglia dell'IA open source e ha dovuto ammettere i forti vantaggi dell'DeepSeek.

Ciò che ha stupito molti è che Altman ha persino affermato che il vantaggio di OpenAI non è più così forte come un tempo.

Di seguito sono riportate tutte le risposte classiche che abbiamo raccolto da Altman.

D: Parliamo del grande argomento della settimana: Deepseek. È chiaramente un modello molto impressionante e so che probabilmente è stato addestrato sulla base dei risultati di altri LLM. Come cambieranno i vostri piani per i modelli futuri?

Altman: È un modello davvero impressionante! Svilupperemo modelli migliori, ma non saremo in grado di mantenere un vantaggio così grande come negli anni precedenti.

D: Pensa che l'auto-miglioramento ricorsivo sarà un processo graduale o un decollo improvviso?

Altman: Personalmente, credo di essere più propenso a pensare che l'IA possa fare rapidi progressi rispetto a qualche anno fa. Forse è arrivato il momento di scrivere qualcosa su questo argomento...

D: Possiamo vedere tutti i token a cui il modello pensa?

Altman: Sì, presto mostreremo una versione più utile e dettagliata. Grazie a R1 per l'aggiornamento.

Kevin Weil, Chief Product Officer: Stiamo lavorando per mostrare più di quanto facciamo ora - questo accadrà presto. Resta da stabilire se mostrare tutto o meno. Mostrare tutte le catene di pensiero (CoT) porterebbe alla distillazione dei modelli dei concorrenti, ma sappiamo anche che gli utenti (almeno quelli avanzati) vogliono vedere tutto questo, quindi troveremo un buon equilibrio.

D: Quando sarà disponibile la versione completa di o3?

Altman: Stimerei che si tratti di più di qualche settimana, ma non di più di qualche mese.

D: Ci sarà un aggiornamento della modalità vocale? È potenzialmente un obiettivo per GPT-5o? Qual è la tempistica approssimativa per GPT-5o?

Altman: Sì, è in arrivo un aggiornamento della modalità vocale avanzata! Credo che lo chiameremo GPT-5, non GPT-5o. Non c'è ancora una tempistica precisa.

D: Prendereste in considerazione la possibilità di rilasciare alcuni pesi modello e di pubblicare alcune ricerche?

Altman: Sì, ne stiamo discutendo. Personalmente penso che siamo dalla parte sbagliata della questione e che dobbiamo trovare una strategia open source diversa; non tutti in OpenAI condividono questo punto di vista, e al momento non è la nostra massima priorità.

Un'altra serie di domande:

- Quanto siamo vicini a offrire l'Operatore nel programma regolare Plus?

- Quali sono le principali priorità del dipartimento di robotica?

- Cosa ne pensa OpenAI dei chip/TPU più specializzati, come Trillium, Cerebras, ecc. OpenAI sta prestando attenzione a questo aspetto?

- Quali investimenti sono stati fatti per coprire i rischi futuri di AGI e ASI?

- Qual è stata la sua vacanza più memorabile?

Altman:

- Alcuni mesi

- produrre un robot veramente buono su piccola scala e imparare dall'esperienza.

- Il GB200 è attualmente difficile da battere!

- Una buona scelta sarebbe quella di migliorare il proprio stato interiore: resilienza, adattabilità, calma, gioia, ecc.

- È difficile scegliere! Ma le prime due che mi vengono in mente sono: un viaggio con lo zaino in spalla nel sud-est asiatico o un safari in Africa.

D: Avete intenzione di aumentare il prezzo della serie Plus?

Altman: In realtà, voglio ridurlo gradualmente.

D: Supponiamo che sia l'anno 2030 e che abbiate appena creato un sistema che la maggior parte delle persone chiamerebbe AGI. Eccelle in tutti i test di benchmark e supera i vostri migliori ingegneri e ricercatori in termini di velocità e prestazioni. E adesso? Oltre a "metterlo sul sito web e offrirlo come servizio", avete altri progetti?

Altman: L'impatto più importante, a mio avviso, sarà quello di accelerare la scoperta scientifica, che credo sia il fattore che contribuirà maggiormente a migliorare la qualità della vita.

Generazione di immagini 4o, in arrivo

Poi sono state aggiunte le risposte di altri membri di OpenAI.

D: Avete ancora intenzione di lanciare il generatore di immagini 4o?

Kevin Weil, Chief Product Officer: Sì! E credo che l'attesa ne valga la pena.

D: Ottimo! C'è un calendario di massima?

Kevin Weil, Chief Product Officer: Mi stai chiedendo di mettermi nei guai. Forse qualche mese.

E un'altra domanda simile.

D: Quando possiamo aspettarci di vedere ChatGPT-5?

Kevin Weil, Chief Product Officer: Poco dopo o-17 micro e GPT-(π+1).

E un'altra domanda sorge spontanea:

- Quali altri tipi di agenti possiamo aspettarci?

- E fornire anche un agente per gli utenti liberi, che potrebbe accelerare l'adozione...

- Qualche aggiornamento sulla nuova versione di DALL-E?

- Un'ultima domanda, quella che tutti fanno... Quando verrà implementato l'AGI?

Kevin Weil, Chief Product Officer:

- Altri agenti: molto, molto presto. Penso che sarete felici.

- Generazione di immagini basata su 4o: tra qualche mese, non vedo l'ora che lo usiate. È fantastico.

- AGI: Sì

D: Avete in programma di aggiungere al modello di ragionamento la funzionalità di allegato di file?

Srinivas Narayanan, vicepresidente dell'ufficio tecnico: È in fase di sviluppo. In futuro, il modello di ragionamento sarà in grado di utilizzare diversi strumenti, comprese le funzioni di ricerca.

Kevin Weil, Chief Product Officer: Solo per dire che non vedo l'ora di vedere il modello di ragionamento in grado di utilizzare gli strumenti

D: Davvero. Quando risolverete questo problema, si apriranno alcuni scenari di applicazione dell'intelligenza artificiale molto utili. Immaginate che sia in grado di comprendere il contenuto dei vostri documenti di lavoro da 500 GB.

Quando si sta per rispondere a un'e-mail, accanto all'app di posta elettronica si apre un pannello che analizza continuamente tutte le informazioni relative a questa persona, tra cui la vostra relazione, gli argomenti discussi, il lavoro passato, ecc. Forse qualcosa di un documento che avete dimenticato da tempo verrà segnalato perché è molto rilevante per la discussione in corso. Voglio assolutamente questa funzione.

Srinivas Narayanan, vicepresidente dell'ufficio tecnico: Stiamo lavorando per aumentare la lunghezza del contesto. Non c'è ancora una data/un annuncio preciso.

D: Quanto è importante il progetto Stargate per il futuro di OpenAI? Kevin Weil, Chief Product Officer: Molto importante. Tutto ciò che abbiamo visto ci suggerisce che più potenza di calcolo abbiamo, più modelli migliori possiamo costruire e più prodotti di valore possiamo creare.

In questo momento stiamo scalando i modelli in due dimensioni: un preallenamento più ampio e un maggiore apprendimento per rinforzo (RL)/allenamento "a fragola", che richiedono entrambi risorse di calcolo.

Servire centinaia di milioni di utenti richiede anche risorse di calcolo! E man mano che ci muoviamo verso prodotti ad agenti più intelligenti, in grado di lavorare continuamente per voi, anche questo richiede risorse di calcolo. Quindi potete pensare a Stargate come alla nostra fabbrica, dove l'elettricità/GPU viene convertita in prodotti straordinari.

D: A livello interno, quale modello utilizzate ora? o4, o5 o o6? Quanto sono più intelligenti questi modelli interni rispetto a o3?

Michelle Pokrass, responsabile della ricerca API: Abbiamo perso il conto.

D: Consentiteci di interagire con il testo/la finestra utilizzando funzioni vocali avanzate. Voglio essere in grado di parlargli e di fargli modificare iterativamente i documenti.

Kevin Weil, Chief Product Officer: Sì! Abbiamo un sacco di ottimi strumenti che sono stati sviluppati in modo relativamente indipendente: l'obiettivo è quello di farli arrivare nelle vostre mani il più rapidamente possibile.

Il passo successivo è quello di integrare tutte queste funzionalità in modo da poter parlare con un modello, che cerca e ragiona allo stesso tempo, e generare un canvas in grado di eseguire Python. Tutti gli strumenti devono lavorare meglio insieme. Inoltre, tutti i modelli hanno bisogno di un accesso completo agli strumenti (attualmente i modelli della serie o non possono utilizzare tutti gli strumenti), che sarà anch'esso implementato.

D: Quando i modelli della serie o supporteranno la funzione di memoria in ChatGPT?

Michelle Pokrass, responsabile della ricerca API: È in fase di sviluppo! L'unificazione di tutte le nostre funzioni con i modelli della serie o è la nostra massima priorità.

D: Ci saranno miglioramenti importanti per la 4o? Mi piace molto il GPT personalizzato e sarebbe bello se potesse essere aggiornato o se si potesse scegliere quale modello utilizzare nel GPT personalizzato (come l'o3 mini).

Michelle Pokrass, responsabile della ricerca API: Sì, non abbiamo ancora finito con la serie 4o!