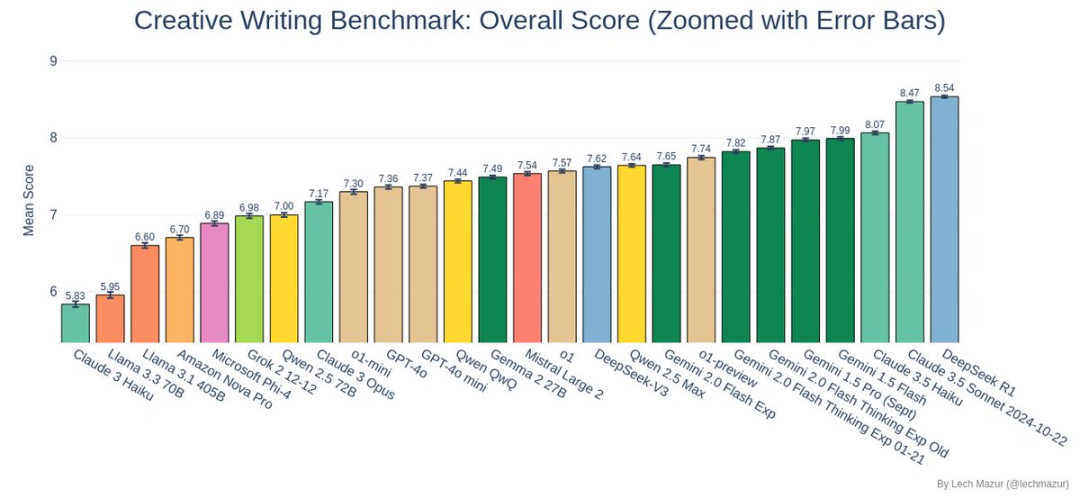

DeepSeek R1 ha vinto il campionato nel test di benchmark per la scrittura di racconti creativi, superando con successo il precedente giocatore dominante Claude 3.5 Sonnet!

Test di benchmark

Il test di riferimento ideato dal ricercatore Lech Mazur non è una gara di scrittura come le altre.

A ogni modello di IA è stato richiesto di completare 500 racconti e ogni racconto doveva incorporare abilmente 10 elementi assegnati a caso. Si è trattato di un compito di scrittura aperto e impegnativo per l'IA, che non solo ha richiesto una trama completa, ma ha anche assicurato che tutti gli elementi assegnati fossero integrati in modo naturale.

Metodo di giudizio

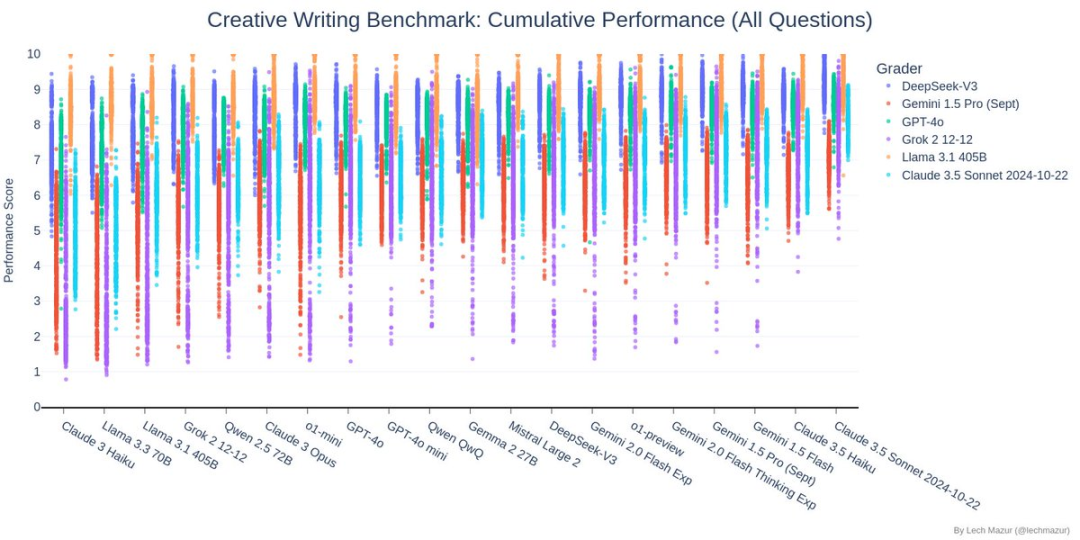

Questo test di riferimento utilizza un sistema di punteggio unico: sei modelli linguistici di alto livello fungono da giudici, assegnando un punteggio a vari aspetti della storia. In altre parole, i leader del settore dell'IA giudicano l'IA stessa, il che fornisce uno standard di valutazione relativamente equo e sistematico.

Contenuto del test

Il grafico qui sopra mostra l'analisi di correlazione dei punteggi nel test di riferimento per la scrittura creativa. DeepSeek ha un coefficiente di correlazione superiore a 0,93 con altri modelli mainstream (Claude, GPT-4o, Gemini e Grok), indicando che ha criteri di giudizio molto coerenti con altri modelli di punta nel giudicare la qualità della scrittura creativa, il che conferma indirettamente la sua affidabilità in questo test.

Il grafico qui sopra mostra i risultati del test di benchmark per la scrittura di racconti creativi. A ogni modello di intelligenza artificiale è stato richiesto di scrivere 500 racconti, ognuno dei quali doveva contenere 10 elementi casuali specificati. I punti nel grafico mostrano la distribuzione dei punteggi di ciascun modello di intelligenza artificiale partecipante per i diversi modelli di punteggio (rappresentati da colori diversi).

Nel test, ProfondoSeek (punti blu scuro) ha ottenuto buoni risultati, con la maggior parte dei suoi punti concentrati nella metà superiore del grafico e relativamente concentrati, mostrando un livello stabile ed elevato di capacità di scrittura creativa.

Queste prestazioni eccezionali gli hanno permesso di superare il precedente campione, Claude 3.5 Sonnet, e di diventare il nuovo leader dei test di benchmark.

In questo grafico, ogni riga rappresenta un modello di intelligenza artificiale e ogni colonna rappresenta una dimensione di valutazione (come caratterizzazione, coerenza della trama, ecc.). DeepSeek si trova nella parte centrale del grafico, con una tonalità arancione-gialla, che indica che ha ottenuto risultati eccellenti nella maggior parte delle dimensioni di valutazione. In particolare, ha ottenuto punteggi elevati di quasi 8 punti nelle dimensioni chiave dell'esecuzione (Q6), della caratterizzazione (TA) e dello sviluppo della trama (TJ). Sebbene non sia il giallo più brillante nelle singole dimensioni, non presenta punti deboli evidenti.

Come si può vedere nel grafico, i punteggi delle storie di DeepSeek sono per lo più distribuiti tra 7 e 9 punti, e la distribuzione è relativamente concentrata. È interessante notare che la linea di tendenza è quasi orizzontale, a indicare che la qualità del racconto di DeepSeek non è strettamente correlata alla lunghezza del racconto. In altre parole, sia che scriva un racconto lungo o un racconto breve, DeepSeek è in grado di mantenere una qualità costantemente elevata. Questo dimostra che DeepSeek si concentra più sulla qualità che sulla quantità quando crea e può mantenere prestazioni eccellenti. in storie di diversa lunghezza.

Perché DeepSeek R1 vincere?

A giudicare dai risultati dei test, l'DeepSeek R1 si è comportato in modo sorprendente:

- Funzionalità complete di integrazione della storia: R1 ha dimostrato un'incredibile flessibilità e creatività nel gestire diverse combinazioni di elementi della storia.

- Qualità di uscita stabile: A giudicare dal grafico di distribuzione dei punteggi, R1 non solo ha ottenuto un punteggio medio elevato, ma anche una performance stabile con minori fluttuazioni.

- Prestazioni creative eccezionali: In questo test di riferimento, le storie create da R1 sono state classificate tra le prime tre in assoluto, il che dimostra la sua straordinaria capacità di scrittura creativa.

Come si sono comportati gli altri concorrenti?

Oltre all'entusiasmante prova di forza tra DeepSeek R1 e Claude 3.5 Sonnet, vale la pena di notare anche le prestazioni di altri modelli:

- La serie Gemini si è comportata bene

- La serie Llama 3.x ha faticato un po' in questo test.

- L'o3-mini non si è comportato bene, piazzandosi al 22° posto.

Infine

Il successo di DeepSeek R1 in questo test ci ha mostrato le infinite possibilità dell'IA nel campo della creatività. Sebbene la creazione di IA sia ancora in fase di continuo miglioramento, questi risultati ci hanno già fatto ben sperare per il futuro.

Per chi volesse saperne di più sui dettagli del test, è possibile visitare GitHub di Lech Mazur per i dati completi e gli esempi delle storie migliori. Aspettiamo insieme altre scoperte nel campo della scrittura creativa con l'intelligenza artificiale!