La storia di Gemellinio 2.0 sta accelerando.

La versione sperimentale di Flash Thinking di dicembre ha fornito agli sviluppatori un modello funzionante con bassa latenza e alte prestazioni.

All'inizio di quest'anno, la versione 2.0 di Flash Thinking Experimental è stata aggiornata in Google AI Studio per migliorare ulteriormente le prestazioni combinando la velocità di Flash con funzionalità di inferenza avanzate.

La scorsa settimana è stata lanciata la versione aggiornata 2.0 di Flash, disponibile per le app desktop e mobili di Gemini.

Oggi sono stati presentati contemporaneamente tre nuovi membri: la versione sperimentale di Gemini 2.0 Pro, che finora ha dato i risultati migliori nella codifica e nei prompt complessi, la conveniente versione 2.0 Flash-Lite e la versione 2.0 Flash Thinking con funzionalità di pensiero avanzate.

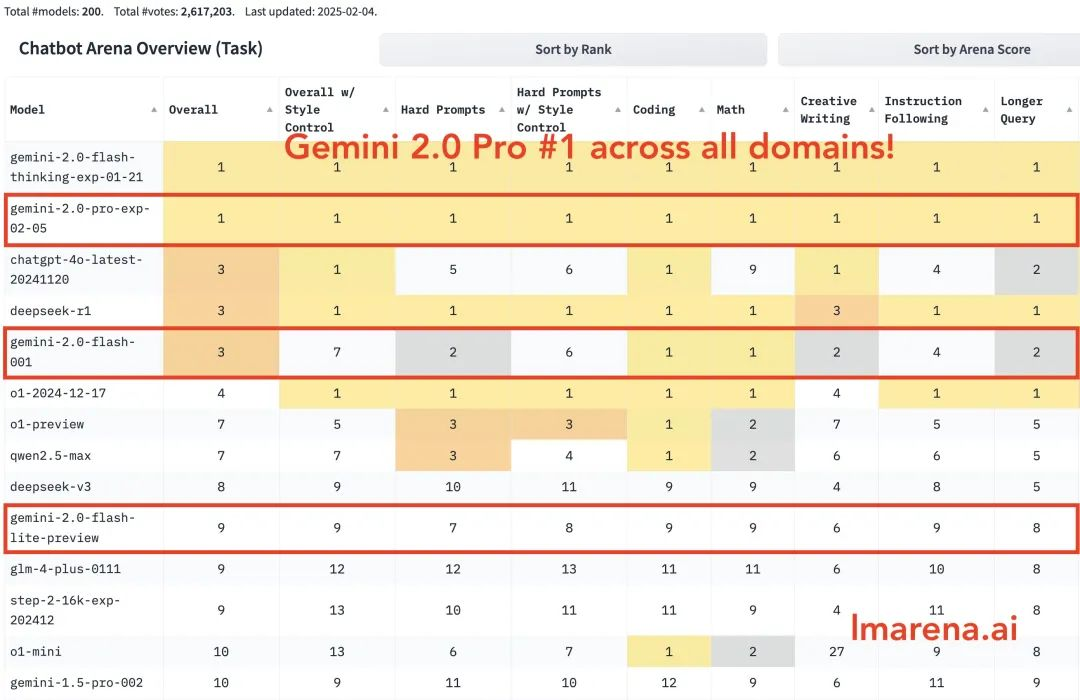

Gemini 2.0 Pro si classifica al primo posto in tutte le categorie. Gemini-2.0-Flash si classifica tra i primi tre in coding, matematica e puzzle. Flash-lite si classifica tra i primi dieci in tutte le categorie.

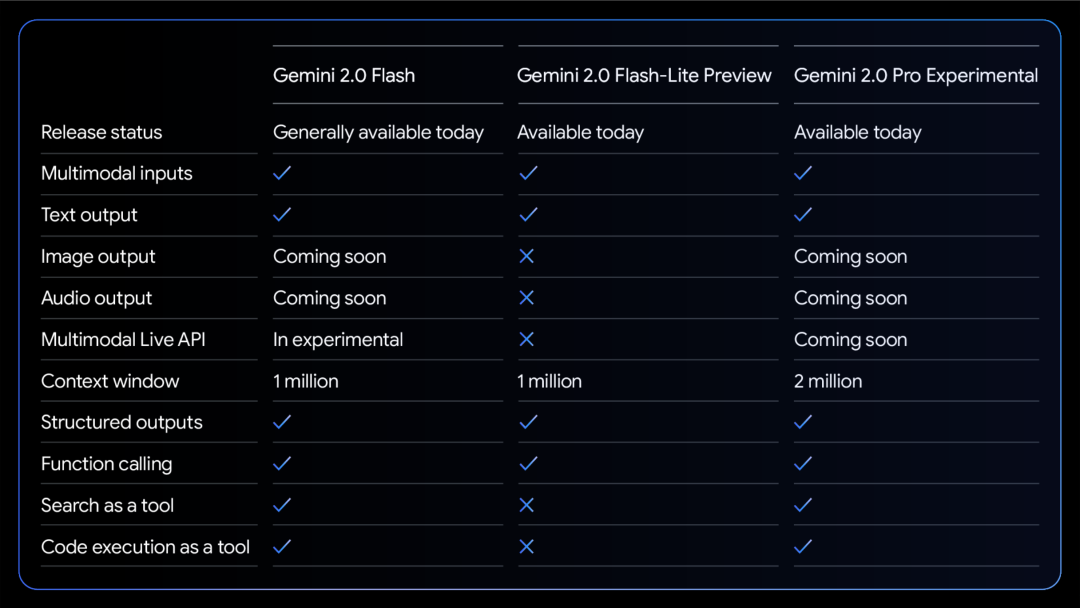

Una tabella comparativa delle capacità dei tre modelli:

Tutti i modelli supportano l'input e l'output di testo multimodale.

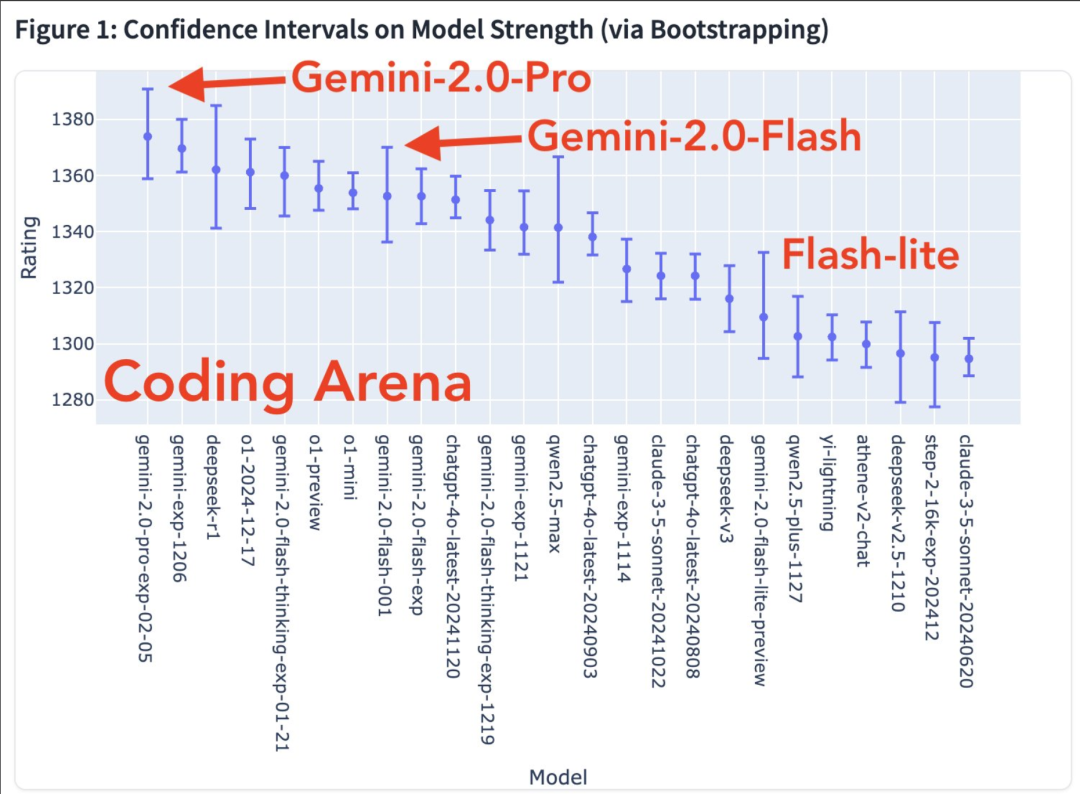

Sono in arrivo altre abilità modali. Grafico della forza del modello nell'arena di codifica

Mappa di calore del tasso di vincita

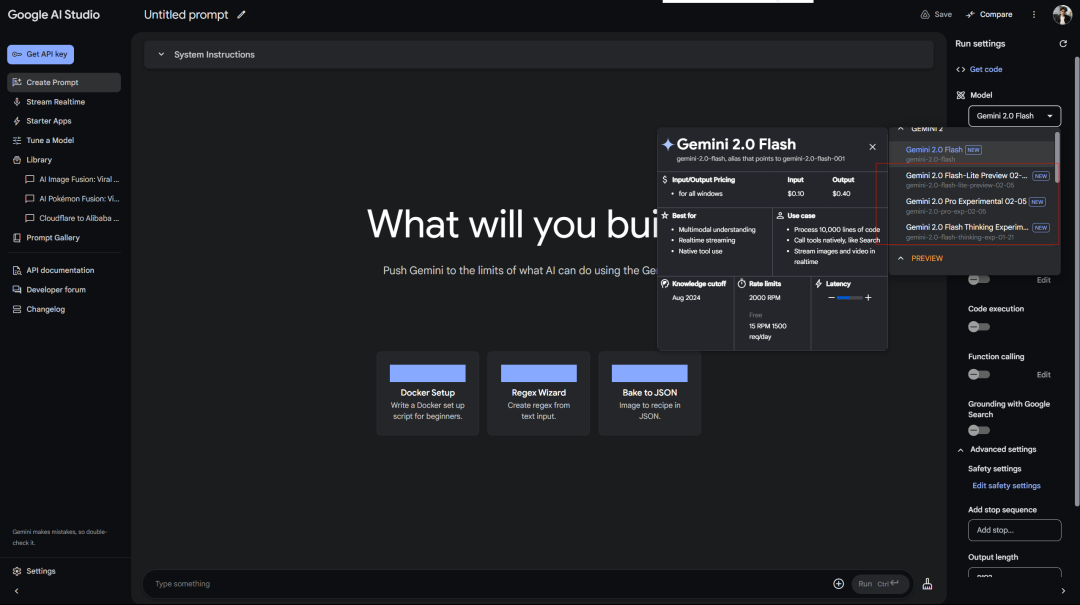

Google tratta gli utenti gratuiti meglio di quanto OpenAI tratti gli utenti Plus. Accesso gratuito a Gemini 2.0 Pro Experimental in AI Studio:

Il servizio Deepseek visualizza sempre un errore in attesa... Ricorda che il primo modello privo di inferenza era anche Flash Thinking 2.0, utilizzato in Google aistudio.

Inoltre, c'è il versione web di Gemini:

Esiste anche un modello di inferenza connesso (allora perché separarlo…)

Google ha rilasciato la versione sperimentale di Gemini 2.0 Pro e i miglioramenti nei test benchmark ufficiali sono davvero sorprendenti.

Ha le capacità di codifica più potenti e la capacità di elaborare richieste complesse, ed è più abile nel comprendere e ragionare sulla conoscenza del mondo rispetto a qualsiasi altro modello rilasciato finora da Google.

Ha la finestra di contesto più ampia (200k; il mio contesto lungo è un vantaggio relativamente grande del modello Gemini), che gli consente di analizzare e comprendere in modo completo una grande quantità di informazioni e di richiamare strumenti come la ricerca Google e l'esecuzione del codice.

Nel test MATH ha ottenuto 91,8%, con un incremento di circa 5 punti percentuali rispetto alla versione 1.5. La capacità di ragionamento GPQA ha raggiunto 64,7% e il test di conoscenza mondiale SimpleQA ha addirittura raggiunto 44,3%.

La più notevole è la capacità di programmazione. Ha raggiunto 36.0% nel test LiveCodeBench e la precisione della conversione Bird-SQL ha superato 59.3%. Insieme alla finestra di contesto super-ampia di 2 milioni di token, è sufficiente per gestire le attività di analisi del codice più complesse.

Puoi provarlo nel cursore.

Anche la capacità di comprensione multilingue è impressionante, con un punteggio nel test Global MMLU di 86,5%. La comprensione delle immagini MMMU è di 72,7% e la capacità di analisi video è di 71,9%.

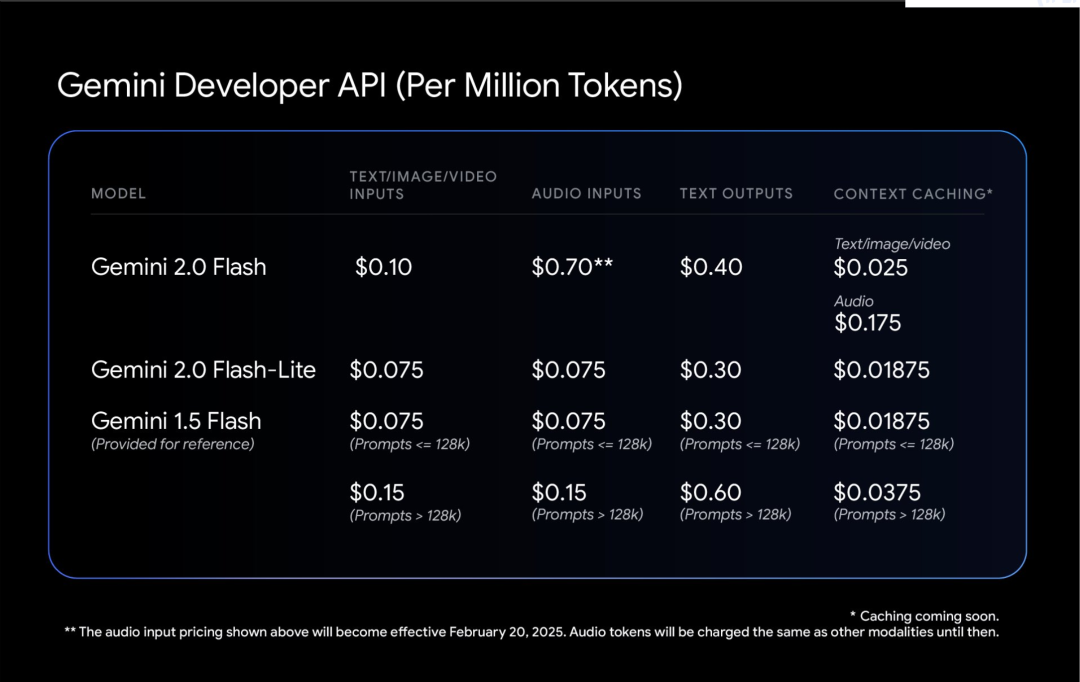

Gemini 2.0 Flash-Lite è un equilibrio interessante.

Mantiene la velocità e il costo di 1.5 Flash, ma offre prestazioni migliori. La finestra di contesto con 1 milione di token consente di elaborare più informazioni.

La cosa più pratica è il rapporto prezzo/prestazioni: la generazione di didascalie per 40.000 foto costa meno di $1. Ciò rende l'IA più concreta.

Il blogger Shrivastava ha affermato: La codifica di Gemini 2.0 Pro è pazzesca!

Suggerimento: usa Three.js per creare una simulazione del sistema solare. Aggiungi una scala temporale, un menu a discesa di messa a fuoco, mostra orbite e mostra etichette. Crea tutto in un file in modo che io possa incollarlo in un editor online e visualizzare l'output.

Inoltre, alcuni utenti hanno affermato che Gemini 2.0 Flash ha prodotto risultati migliori in uno dei loro test paradossali:

Infine, Google ha affermato che la sicurezza di Gemini 2.0, non solo la patch, è al centro della progettazione fin dall'inizio.

Lascia che il modello impari a essere autocritico. Usa l'apprendimento per rinforzo per far sì che Gemini valuti le proprie risposte e fornisca un feedback più accurato. Ciò lo rende più robusto quando si tratta di argomenti delicati.

Il test automatizzato del team rosso è interessante. È specificamente progettato per impedire l'iniezione di parole di prompt indirette, il che è come dotare l'IA di un sistema immunitario per impedire a qualcuno di nascondere comandi dannosi nei dati.