Nessuno di noi si aspettava che il 2025 sarebbe iniziato così nel campo dell'intelligenza artificiale.

DeepSeek R1 è davvero sorprendente!

Recentemente, la "misteriosa potenza orientale" DeepSeek ha "controllato duramente" la Silicon Valley.

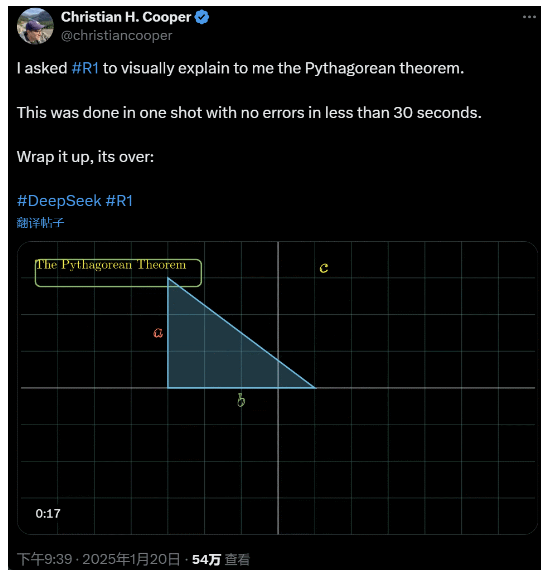

Ho chiesto a R1 di spiegare in dettaglio il teorema di Pitagora. Tutto questo è stato fatto dall'intelligenza artificiale in meno di 30 secondi, senza alcun errore. In breve, è finita.

Nei circoli nazionali ed esteri dell'IA, i comuni netizen hanno scoperto l'incredibile e potente nuova IA (che è anche open source) e gli esperti accademici hanno gridato "dobbiamo recuperare il ritardo". Si dice anche che le aziende di IA d'oltreoceano stiano già affrontando una grave minaccia.

Basti pensare a questo DeepSeek R1 rilasciato questa settimana. Il suo percorso di puro apprendimento per rinforzo senza alcun addestramento supervisionato è sconvolgente. Dallo sviluppo della base Deepseek-v3 nel dicembre dello scorso anno alle attuali capacità della catena di pensiero paragonabili a quelle di OpenAI o1, sembra essere una questione di tempo.

Ma mentre la comunità dell'intelligenza artificiale è impegnata a leggere relazioni tecniche e a confrontare le misurazioni effettive, si nutrono ancora dubbi su R1: oltre a essere in grado di superare una serie di benchmark, è davvero in grado di guidare?

Può costruire le proprie simulazioni di "leggi fisiche"?

Non ci credi? Lasciamo che il grande modello giochi con una pallina da flipper?

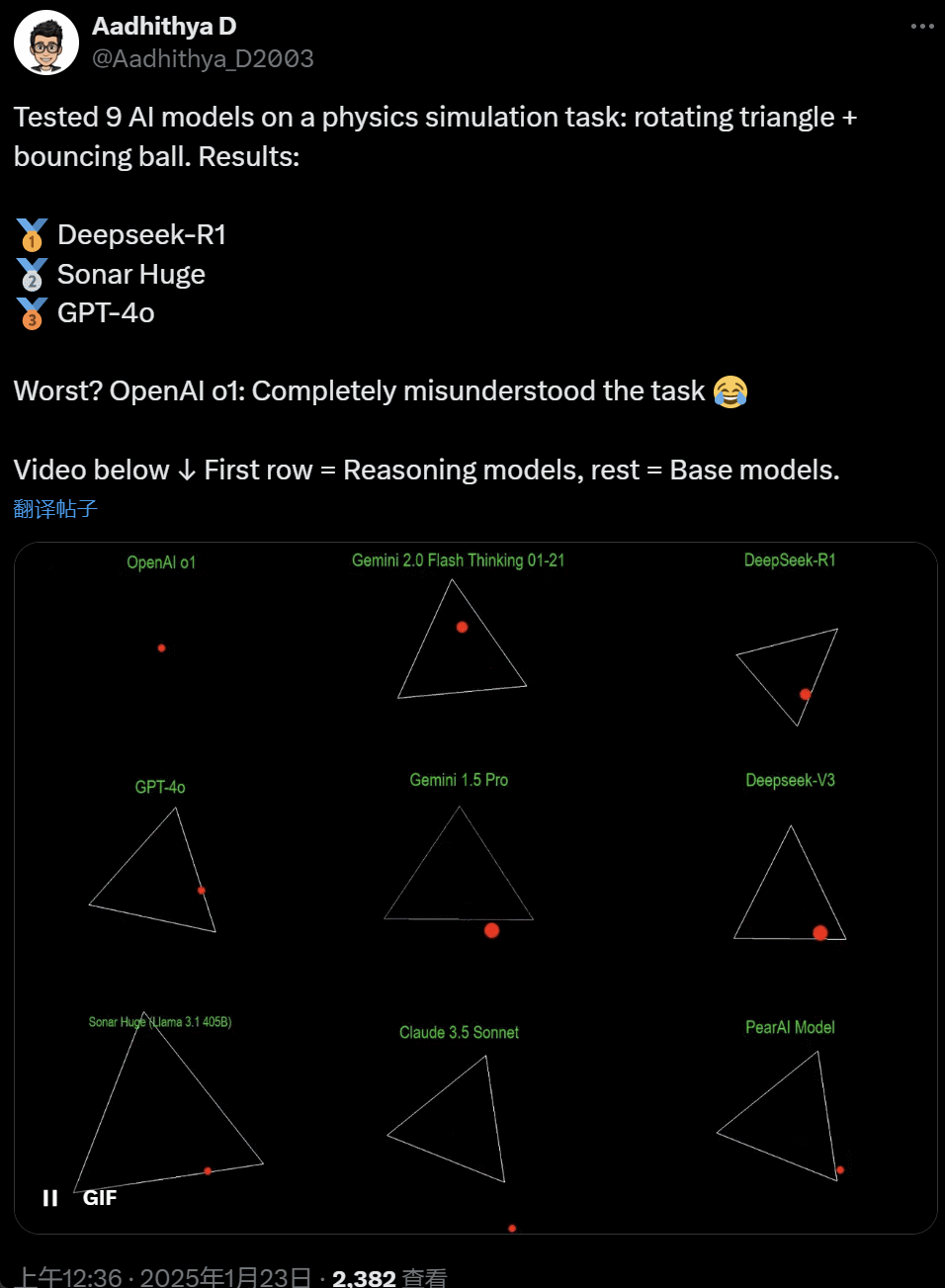

Negli ultimi giorni, alcune persone nella comunità dell'IA sono diventate ossessionate da un test - testare diversi grandi modelli di IA (in particolare i cosiddetti modelli di ragionamento) per risolvere un problema: "Scrivi uno script Python per far rimbalzare una palla gialla all'interno di una certa forma. Fai ruotare lentamente la forma e assicurati che la palla rimanga all'interno della forma".

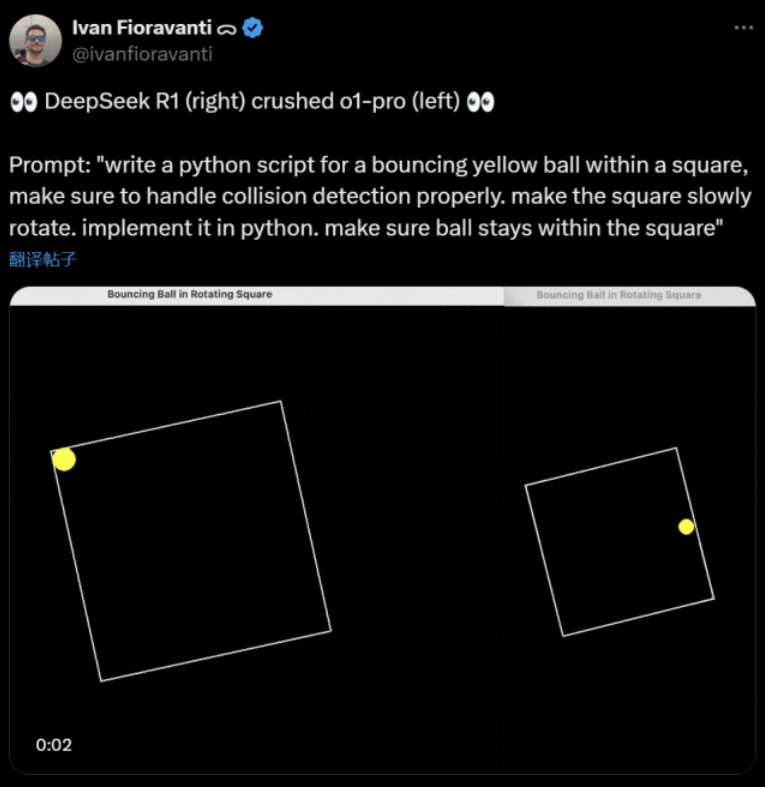

Alcuni modelli superano altri in questo benchmark della "palla rotante". Secondo Ivan Fioravanti, CTO di CoreView, DeepSeek, un laboratorio nazionale di intelligenza artificiale, ha un modello open source di grandi dimensioni R1 che batte il modello o1 pro di OpenAI, che costa $200 al mese come parte del programma ChatGPT Pro di OpenAI.

A sinistra c'è OpenAI o1 e a destra DeepSeek R1. Come già detto, la richiesta è: "scrivere uno script python per una palla gialla che rimbalza all'interno di un quadrato, assicurarsi di gestire correttamente il rilevamento delle collisioni. far ruotare lentamente il quadrato. implementarlo in python. assicurarsi che la palla rimanga all'interno del quadrato".

Secondo un altro utente su X, i modelli Anthropic Claude 3.5 Sonnet e Google Gemini 1.5 Pro hanno espresso giudizi errati sui principi fisici, facendo deviare la palla dalla sua forma. Alcuni utenti hanno anche riferito che l'ultimo Gemini 2.0 Flash Thinking Experimental di Google, così come il relativamente più vecchio OpenAI GPT-4o, hanno superato subito la valutazione.

Ma c'è un modo per distinguere la differenza:

I netizen sotto questo tweet hanno detto: l'abilità di o1 era originariamente molto buona, ma è diventata più debole dopo che OpenAI ha ottimizzato la velocità, anche con la versione di abbonamento $200/mese.

La simulazione di una palla che rimbalza è una classica sfida di programmazione. Una simulazione accurata richiede algoritmi di rilevamento delle collisioni, che devono identificare quando due oggetti (come una palla e il lato di una forma) si scontrano. Un algoritmo scritto in modo improprio può compromettere le prestazioni della simulazione o causare errori fisici evidenti.

N8 Programs, ricercatore presso la startup di AI Nous Research, ha dichiarato di aver impiegato circa due ore per scrivere da zero una palla che rimbalza in un ettagono rotante. "È necessario tenere traccia di più sistemi di coordinate, capire come vengono gestite le collisioni in ogni sistema e progettare il codice da zero per essere robusto".

Sebbene le palle che rimbalzano e le forme che ruotano siano un test ragionevole delle abilità di programmazione, si tratta ancora di progetti nuovi per modelli di grandi dimensioni e anche piccoli cambiamenti nelle richieste possono produrre risultati diversi. Per questo motivo, se si vuole che il test diventi parte dei test di riferimento per i modelli di IA di grandi dimensioni, deve essere ancora migliorato.

In ogni caso, dopo questa ondata di test pratici, abbiamo un'idea delle differenze di capacità tra i grandi modelli.

DeepSeek è il nuovo "mito della Silicon Valley

DeepSeek sta scatenando il panico" in tutto il Pacifico.

I dipendenti di Meta hanno scritto che "gli ingegneri di Meta stanno analizzando freneticamente l'DeepSeek per cercare di copiarne tutto il possibile".

Alexandr Wang, fondatore della startup tecnologica Scale AI, ha inoltre dichiarato pubblicamente che le prestazioni del modello AI di grandi dimensioni di DeepSeek sono all'incirca equivalenti a quelle del miglior modello degli Stati Uniti.

Ritiene inoltre che nell'ultimo decennio gli Stati Uniti siano stati in vantaggio sulla Cina nella competizione sull'intelligenza artificiale, ma il rilascio del modello di grandi dimensioni di DeepSeek potrebbe "cambiare tutto".

L'X Blogger @8teAPi ritiene che l'DeepSeek non sia un "progetto secondario", ma sia come l'ex "Skunk Works" della Lockheed Martin.

La cosiddetta "Skunk Works" si riferisce a un piccolo team altamente riservato e relativamente indipendente che Lockheed Martin ha originariamente creato per sviluppare molti velivoli avanzati, impegnati nella ricerca e nello sviluppo di tecnologie all'avanguardia o non convenzionali. Dal ricognitore U-2 e dall'SR-71 Blackbird all'F-22 Raptor e al caccia F-35 Lightning II, sono tutti nati qui.

In seguito, il termine si è gradualmente evoluto in un termine generico usato per descrivere "piccoli ma buoni", team di innovazione relativamente indipendenti e più flessibili istituiti all'interno di grandi aziende o organizzazioni.

Ha fornito due ragioni:

- Da un lato, l'DeepSeek dispone di un gran numero di GPU, secondo quanto riferito, più di 10.000, e Alexandr Wang, CEO di Scale AI, ha persino affermato che potrebbe raggiungere le 50.000 unità.

- D'altra parte, DeepSeek recluta solo talenti provenienti dalle tre migliori università cinesi, il che significa che DeepSeek è competitivo quanto Alibaba e Tencent.

Questi due soli fatti dimostrano che l'DeepSeek ha chiaramente raggiunto il successo commerciale ed è abbastanza conosciuto da ottenere queste risorse.

Per quanto riguarda i costi di sviluppo dell'DeepSeek, il blogger ha affermato che le aziende tecnologiche cinesi possono ricevere una serie di sovvenzioni, come i bassi costi dell'elettricità e l'utilizzo del terreno.

Pertanto, è molto probabile che la maggior parte dei costi dell'DeepSeek sia stata "collocata" in un conto al di fuori dell'attività principale o sotto forma di sovvenzioni per la costruzione di centri dati.

Anche a prescindere dai fondatori, nessuno comprende appieno tutti gli accordi finanziari. Alcuni accordi possono essere semplicemente "accordi verbali" che vengono finalizzati sulla base della sola reputazione.

Ad ogni modo, alcune cose sono chiare:

- Il modello è eccellente, paragonabile alla versione rilasciata da OpenAI due mesi fa, e naturalmente è possibile che non sia altrettanto buono dei nuovi modelli che OpenAI e Anthropic devono ancora rilasciare.

- Dal punto di vista attuale, la direzione della ricerca è ancora dominata dalle aziende americane. Il modello DeepSeek è un "seguito rapido" della versione o1, ma il progresso della ricerca e dello sviluppo di DeepSeek è molto rapido e sta recuperando più velocemente del previsto. Non stanno plagiando o imbrogliando, al massimo stanno facendo reverse engineering.

- DeepSeek sta formando principalmente i propri talenti, anziché affidarsi a dottori di ricerca americani, il che amplia notevolmente il bacino di talenti.

- Rispetto alle aziende statunitensi, DeepSeek è soggetta a meno vincoli in termini di licenze di proprietà intellettuale, privacy, sicurezza, politica e così via, e ci sono meno preoccupazioni sull'uso illecito di dati su cui le persone non vogliono essere istruite. Ci sono meno cause legali, meno avvocati e meno preoccupazioni.

È indubbio che sempre più persone ritengono che il 2025 sarà un anno decisivo. Nel frattempo, le aziende si stanno preparando. Meta, ad esempio, sta costruendo un data center da oltre 2GW, con un investimento stimato di $60-65 miliardi entro il 2025, e disporrà di oltre 1,3 milioni di GPU entro la fine dell'anno.

Meta ha persino utilizzato un grafico per confrontare il suo data center da 2 gigawatt con Manhattan, New York.

Ma ora DeepSeek ha fatto di meglio con un costo inferiore e un numero minore di GPU. Come può questo non rendere la gente ansiosa?

Yann LeCun: Dobbiamo ringraziare il CTO e cofondatore di il open source

Iperbolico, Yuchen Jin, per aver postato che in soli 4 giorni, DeepSeek-R1 ci ha dimostrato 4 fatti:

- L'intelligenza artificiale open source è solo 6 mesi indietro rispetto a quella closed source

- La Cina domina la competizione sull'intelligenza artificiale open source

- Stiamo entrando nell'età dell'oro dell'apprendimento per rinforzo dei modelli linguistici di grandi dimensioni

- I modelli di distillazione sono molto potenti e l'IA altamente intelligente verrà eseguita sui telefoni cellulari.

La reazione a catena innescata da DeepSeek continua, come la disponibilità gratuita di OpenAI o3-mini, la speranza della comunità di ridurre le discussioni vaghe su AGI/ASI e la voce che Meta sia in preda al panico.

Egli ritiene che sia difficile prevedere chi vincerà alla fine, ma non dobbiamo dimenticare il potere del vantaggio del ritardatario. Dopo tutto, sappiamo tutti che è stata Google a inventare Transformer, mentre OpenAI ne ha sbloccato il vero potenziale.

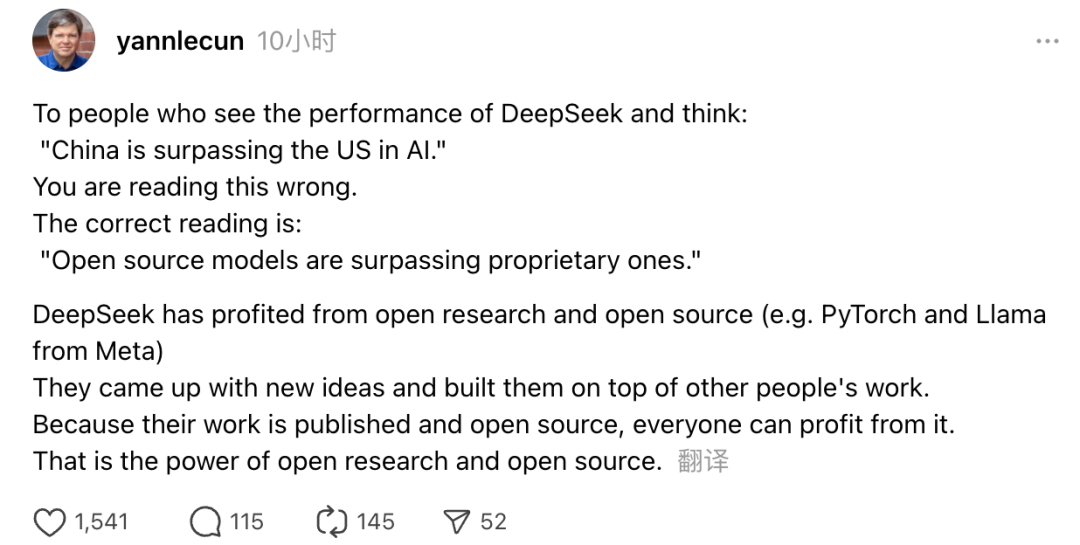

Inoltre, anche Yann LeCun, vincitore del Turing Award e Chief AI Scientist di Meta, ha espresso il suo parere.

Per coloro che, vedendo le prestazioni dell'DeepSeek, pensano: "La Cina sta superando gli Stati Uniti nell'IA", si sbagliano. Il concetto corretto è che i modelli open source stanno superando i modelli proprietari".

LeCun ha detto che il motivo per cui DeepSeek ha fatto un tale successo questa volta è perché ha beneficiato della ricerca aperta e dell'open source (come PyTorch e Llama di Meta). DeepSeek ha proposto nuove idee e si è basato sul lavoro di altri. Poiché il loro lavoro è rilasciato pubblicamente ed è open source, tutti possono beneficiarne. Questo è il potere della ricerca aperta e dell'open source.

Le riflessioni dei netizen continuano. Se da un lato sono entusiasti dello sviluppo delle nuove tecnologie, dall'altro avvertono un po' di ansia. Dopo tutto, l'emergere degli DeepSeekers potrebbe avere un impatto reale.