Nė vienas iš mūsų nesitikėjo, kad taip prasidės 2025 m. dirbtinio intelekto srityje.

"DeepSeek R1 yra tikrai nuostabi!

Pastaruoju metu "paslaptingoji Rytų jėga" DeepSeek "sunkiai kontroliuoja" Silicio slėnį.

Paprašiau R1 išsamiai paaiškinti Pitagoro teoremą. Visa tai dirbtinis intelektas atliko greičiau nei per 30 sekundžių be klaidų. Trumpai tariant, jos pabaiga.

Šalies ir užsienio dirbtinio intelekto sluoksniuose paprasti tinklininkai atrado nuostabų ir galingą naująjį dirbtinį intelektą (kuris taip pat yra atvirojo kodo), o akademiniai ekspertai šaukė: "Turime pasivyti". Taip pat pasigirdo kalbų, kad užsienio dirbtinio intelekto bendrovėms jau iškilo didelė grėsmė.

Tiesiog paimkite šią savaitę išleistą DeepSeek R1. Jo grynas mokymosi pastiprinimu būdas be jokio prižiūrimo mokymo yra šokiruojantis. Nuo "Deepseek-v3" bazės kūrimo praėjusių metų gruodį iki dabartinių mąstymo grandinės galimybių, prilygstančių "OpenAI o1", atrodo, kad tai tik laiko klausimas.

Tačiau kol dirbtinio intelekto bendruomenė užsiima techninių ataskaitų skaitymu ir faktinių matavimų palyginimu, žmonės vis dar abejoja dėl R1: ar jis gali ne tik pranokti daugybę lyginamųjų rodiklių, bet ir iš tikrųjų pirmauti?

Ar jis gali sukurti savo fizikinių dėsnių simuliacijas?

Netikite tuo? Leiskime dideliam modeliui žaisti su pinigu?

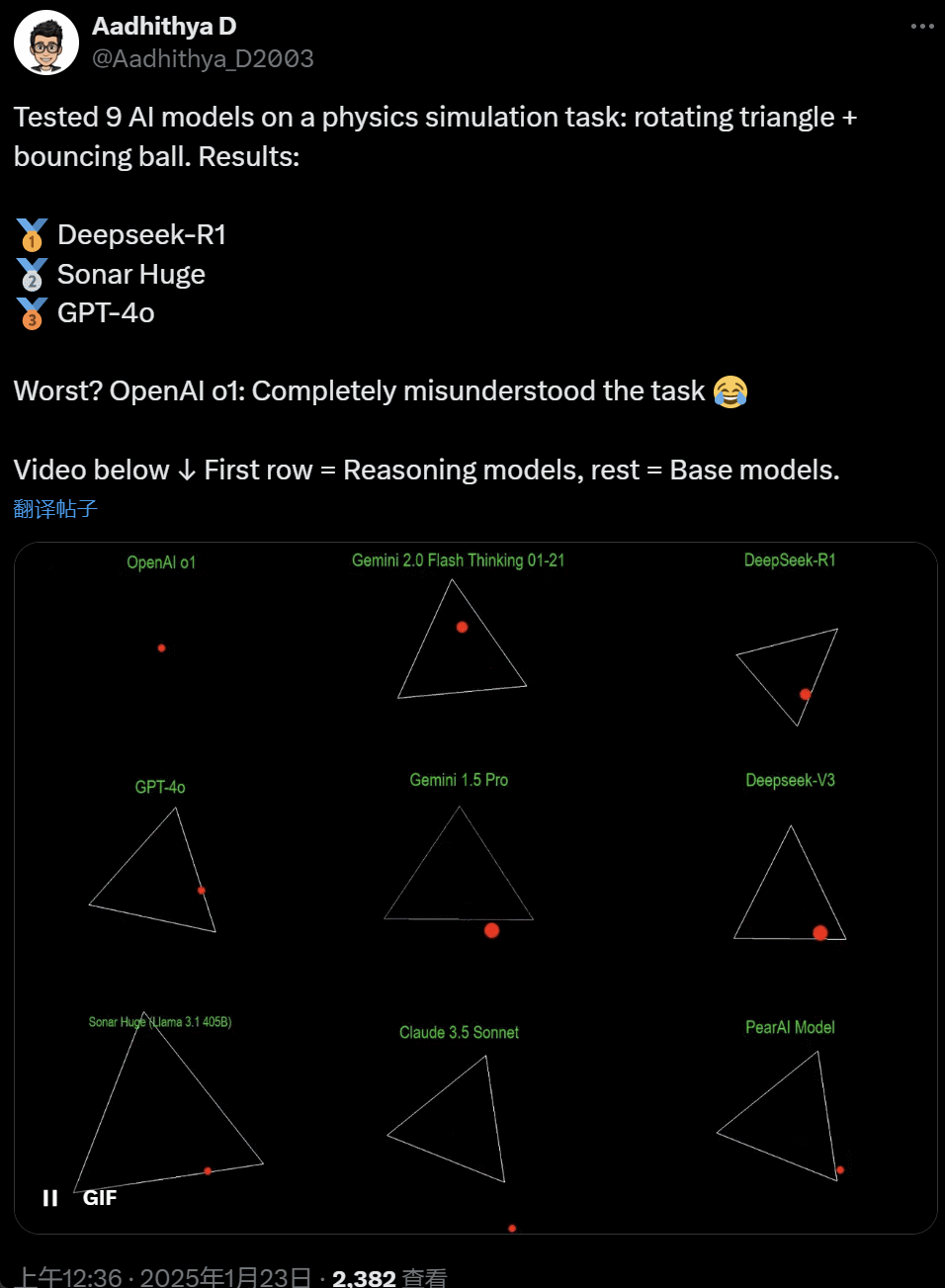

Pastarosiomis dienomis kai kurie dirbtinio intelekto bendruomenės žmonės tapo apsėsti bandymo - įvairių dirbtinio intelekto didžiųjų modelių (ypač vadinamųjų samprotavimo modelių) bandymo išspręsti problemą: "Parašykite "Python" scenarijų, kad geltonas kamuoliukas atšoktų tam tikros formos viduje. Priverskite figūrą lėtai suktis ir įsitikinkite, kad kamuoliukas lieka figūros viduje".

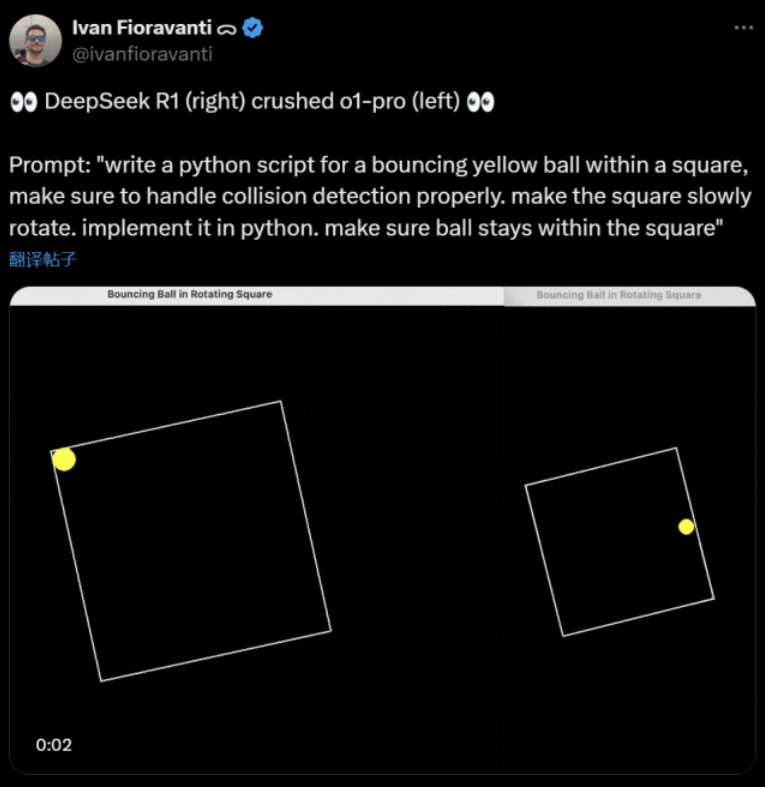

Kai kurie modeliai šiame "besisukančio kamuolio" etalone lenkia kitus. Pasak "CoreView" techninio direktoriaus Ivano Fioravanti, šalies dirbtinio intelekto laboratorija DeepSeek turi atvirojo kodo didelį modelį R1, kuris lenkia "OpenAI" modelį o1 pro, kainuojantį $200 per mėnesį kaip "OpenAI" programos "ChatGPT Pro" dalis.

Kairėje pusėje yra "OpenAI o1", o dešinėje - DeepSeek R1. Kaip minėta pirmiau, raginimas čia yra toks: "Parašykite "Python" scenarijų, skirtą kvadrato viduje šokinėjančiam geltonam kamuoliukui, pasirūpinkite, kad būtų tinkamai aptiktas susidūrimas.

Pasak kito "X" naudotojo, "Anthropic Claude 3.5 Sonnet" ir "Google" "Gemini 1.5 Pro" modeliai neteisingai įvertino fizikinius principus, todėl kamuolys nukrypo nuo savo formos. Kai kurie naudotojai taip pat pranešė, kad naujausias Google Gemini 2.0 Flash Thinking Experimental, taip pat palyginti senesnis OpenAI GPT-4o iš karto išlaikė vertinimą.

Tačiau yra būdas, kaip tai atskirti:

"Netizens" pagal šį "Twitter" sakė: "o1" gebėjimas iš pradžių buvo labai geras, tačiau po to, kai "OpenAI" optimizavo greitį, jis tapo silpnesnis, net ir naudojant $200/mėn. narystės versiją.

Imituoti šokinėjantį kamuolį - klasikinis programavimo iššūkis. Tiksliam modeliavimui naudojami susidūrimo aptikimo algoritmai, kurie turi nustatyti, kada susiduria du objektai (pvz., kamuolys ir figūros šonas). Netinkamai parašytas algoritmas gali turėti įtakos modeliavimo našumui arba sukelti akivaizdžių fizikinių klaidų.

AI startuolio "Nous Research" tyrėjas N8 Programs sakė, kad jam prireikė maždaug dviejų valandų, kad nuo nulio parašytų besisukančio kamuolio, esančio besisukančiame šešiakampyje, scenarijų. "Reikia sekti kelias koordinačių sistemas, suprasti, kaip kiekvienoje sistemoje tvarkomi susidūrimai, o kodas turi būti sukurtas nuo nulio, kad būtų patikimas."

Nors šokinėjantys kamuoliukai ir besisukančios figūros yra tinkamas programavimo įgūdžių išbandymas, tai vis dar nauji didelių modelių projektai, todėl net ir nedideli užklausų pakeitimai gali duoti skirtingus rezultatus. Taigi, jei norima, kad jis galiausiai taptų didelių dirbtinio intelekto modelių lyginamojo testo dalimi, jį dar reikia tobulinti.

Bet kokiu atveju, po šios praktinių bandymų bangos jaučiame didelių modelių galimybių skirtumus.

DeepSeek - naujasis "Silicio slėnio mitas

DeepSeek kelia paniką" visame Ramiajame vandenyne.

"Meta" darbuotojai paskelbė, kad "Meta" inžinieriai karštligiškai analizuoja DeepSeek ir bando iš jo nukopijuoti viską, ką tik gali."

Aleksandras Vangas, dirbtinio intelekto technologijų startuolio "Scale AI" įkūrėjas, taip pat viešai pareiškė, kad DeepSeek dirbtinio intelekto didelio modelio našumas maždaug prilygsta geriausiam JAV modeliui.

Jis taip pat mano, kad per pastarąjį dešimtmetį Jungtinės Amerikos Valstijos galėjo būti pranašesnės už Kiniją dirbtinio intelekto varžybose, tačiau DeepSeek išleistas didelis dirbtinio intelekto modelis gali "viską pakeisti".

X Blogeris @8teAPi mano, kad DeepSeek nėra "šalutinis projektas", bet yra kaip buvęs Lockheed Martin "Skunk Works".

Vadinamoji "Skunk Works" - tai labai konfidenciali, palyginti nepriklausoma nedidelė komanda, kurią "Lockheed Martin" iš pradžių įsteigė daugeliui pažangių orlaivių kurti ir kuri užsiėmė pažangiausių ar netradicinių technologijų tyrimais ir plėtra. Iš čia kilo visi šie orlaiviai - nuo žvalgybinio lėktuvo U-2 ir SR-71 Blackbird iki F-22 Raptor ir naikintuvo F-35 Lightning II.

Vėliau šis terminas palaipsniui virto bendriniu terminu, vartojamu apibūdinti "mažas, bet geras", santykinai nepriklausomas ir lankstesnes inovacijų grupes, įsteigtas didelėse įmonėse ar organizacijose.

Jis nurodė dvi priežastis:

- Viena vertus, "DeepSeek" turi daug GPU, kaip pranešama, daugiau nei 10 000, o bendrovės "Scale AI" generalinis direktorius Aleksandras Vangas (Alexandr Wang) netgi teigė, kad jų skaičius gali siekti 50 000.

- Kita vertus, "DeepSeek" įdarbina talentus tik iš trijų geriausių Kinijos universitetų, o tai reiškia, kad "DeepSeek" yra tokia pat konkurencinga kaip "Alibaba" ir "Tencent".

Jau vien šie du faktai rodo, kad DeepSeek neabejotinai pasiekė komercinės sėkmės ir yra pakankamai gerai žinoma, kad gautų šiuos išteklius.

Kalbėdamas apie DeepSeek kūrimo išlaidas, tinklaraštininkas teigė, kad Kinijos technologijų bendrovės gali gauti įvairių subsidijų, pavyzdžiui, mažas elektros energijos ir žemės naudojimo išlaidas.

Todėl labai tikėtina, kad didžioji dalis DeepSeek sąnaudų buvo "padėta" į sąskaitą, nesusijusią su pagrindine veikla, arba kaip tam tikra duomenų centro statybos subsidija.

Net be steigėjų niekas iki galo nesupranta visų finansinių susitarimų. Kai kurie susitarimai gali būti tiesiog "žodiniai susitarimai", kurie užbaigiami remiantis vien reputacija.

Nepaisant to, keli dalykai yra aiškūs:

- Modelis yra puikus, panašus į OpenAI prieš du mėnesius išleistą versiją, ir, žinoma, gali būti, kad jis nėra toks geras kaip nauji modeliai, kuriuos OpenAI ir Anthropic dar turi išleisti.

- Dabartiniu požiūriu mokslinių tyrimų kryptyje vis dar dominuoja Amerikos bendrovės. DeepSeek modelis yra "greitas o1 versijos tęsinys", tačiau DeepSeek mokslinių tyrimų ir technologinės plėtros pažanga yra labai sparti ir pasivijo greičiau, nei tikėtasi. Jie nėra plagiatoriai ar sukčiai, daugiausia jie atlieka atvirkštinę inžineriją.

- "DeepSeek" daugiausia rengia savo talentus, o ne pasikliauja Amerikoje apmokytais daktarais, todėl labai išsiplėtė talentų ratas.

- Palyginti su JAV bendrovėmis, DeepSeek patiria mažiau suvaržymų, susijusių su intelektinės nuosavybės licencijavimu, privatumu, saugumu, politika ir t. t. Be to, mažiau nerimaujama dėl neteisėto duomenų, kurių žmonės nenori mokytis, naudojimo. Mažiau teisminių procesų, mažiau teisininkų ir mažiau rūpesčių.

Neabejotina, kad vis daugiau žmonių mano, jog 2025 m. bus lemiami metai. Tuo tarpu įmonės tam ruošiasi. Pavyzdžiui, "Meta" stato 2GW+ duomenų centrą, į kurį iki 2025 m. planuojama investuoti $60-65 mlrd.

"Meta" net naudojo diagramą, kurioje savo 2 gigavatų galios duomenų centrą palygino su Manhatanu Niujorke.

Tačiau dabar "DeepSeek" tai padarė geriau, nes kaina yra mažesnė ir turi mažiau GPU. Kaip tai gali nesukelti žmonėms nerimo?

Yann LeCun: Turime padėkoti techniniam direktoriui ir vienam iš įkūrėjų . atviras šaltinis

Hiperbolinis, Yuchen Jin, už tai, kad vos per 4 dienas DeepSeek-R1 mums įrodė 4 faktus:

- Atvirojo kodo dirbtinis intelektas nuo uždarojo kodo dirbtinio intelekto atsilieka tik 6 mėnesiais

- Kinija dominuoja atvirojo kodo dirbtinio intelekto konkurse

- Įžengiame į didelių kalbos modelių mokymosi pastiprinant aukso amžių

- Distiliavimo modeliai yra labai galingi, todėl labai protingą dirbtinį intelektą naudosime mobiliuosiuose telefonuose.

Grandininė reakcija, kurią sukėlė DeepSeek, vis dar tęsiasi, pavyzdžiui, "OpenAI o3-mini" tapo laisvai prieinama, bendruomenė tikisi sumažinti neaiškias diskusijas apie AGI/ASI ir gandus, kad "Meta" yra apimta panikos.

Jis mano, kad sunku nuspėti, kas galiausiai laimės, tačiau nereikėtų pamiršti vėluojančio dalyvio pranašumo galios. Juk visi žinome, kad būtent "Google" išrado "Transformer", o "OpenAI" atskleidė tikrąjį jo potencialą.

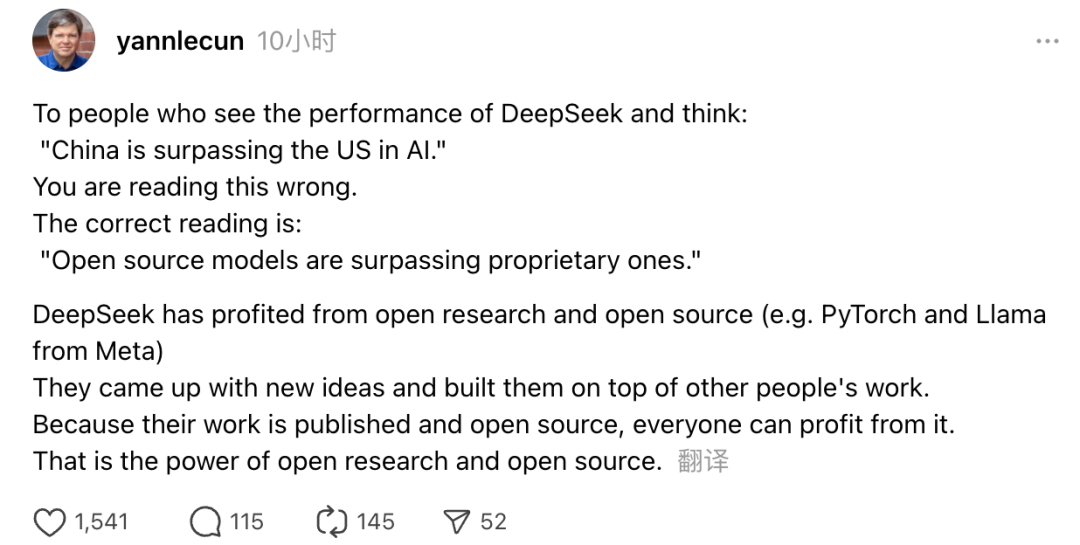

Be to, savo nuomonę išreiškė ir Tiuringo apdovanojimo laureatas bei "Meta" vyriausiasis dirbtinio intelekto mokslininkas Yannas LeCunas.

"Tiems, kurie, pamatę DeepSeek rezultatus, galvoja, kad "Kinija lenkia JAV dirbtinio intelekto srityje", klysta. Teisingas supratimas yra tas, kad atvirojo kodo modeliai lenkia nuosavybinius modelius."

LeCun teigė, kad DeepSeek šį kartą taip išpopuliarėjo todėl, kad pasinaudojo atvirųjų mokslinių tyrimų ir atvirojo kodo (pvz., "Meta" PyTorch ir Llama) privalumais. DeepSeek pasiūlė naujų idėjų ir rėmėsi kitų darbais. Kadangi jų darbas viešai skelbiamas ir yra atvirojo kodo, visi gali juo pasinaudoti. Tokia yra atvirųjų mokslinių tyrimų ir atvirojo kodo galia.

Tinklaraštininkų svarstymai tęsiasi. Nors jie džiaugiasi naujų technologijų plėtra, tačiau jaučia ir šiek tiek nerimo. Juk DeepSeekers atsiradimas gali turėti realų poveikį.