DeepSeek-R1 e DeepSeek-V3 causaram uma sensação global desde seu lançamento de código aberto.

Eles são um presente da equipe do DeepSeek para toda a humanidade, e estamos sinceramente felizes pelo seu sucesso.

Após dias de trabalho árduo das equipes da Silicon Mobility e da Huawei Cloud, hoje também estamos dando aos usuários chineses um presente de Ano Novo Chinês: A plataforma de serviço de nuvem de modelo em larga escala SiliconCloud lançou o DeepSeek-V3 e o DeepSeek-R1, que são baseados no serviço de nuvem Ascend da Huawei Cloud.

Deve-se enfatizar que recebemos um grande apoio do DeepSeek e da Huawei Cloud, tanto na adaptação do DeepSeek-R1 & V3 no Ascend quanto no processo de lançamento de outros modelos anteriormente, e gostaríamos de agradecer profundamente e respeitar muito.

Recursos

Esses dois modelos lançados pelo SiliconCloud incluem principalmente cinco recursos principais:

Com base no serviço de nuvem Ascend da Huawei Cloud, lançamos o DeepSeek x Silicon Mobility x Serviço de inferência de modelo R1 e V3 da Huawei Cloud pela primeira vez.

Por meio da inovação conjunta entre as duas partes, e com o apoio do mecanismo de aceleração de inferência desenvolvido pela própria empresa, o modelo DeepSeek implantado pela equipe da Silicon Mobility com base no serviço de nuvem Ascend da Huawei Cloud pode alcançar o mesmo efeito que um modelo de implantação de GPU de ponta no mundo.

Fornecer serviços de inferência DeepSeek-R1 e V3 estáveis em nível de produção. Isso permite que os desenvolvedores executem de forma estável em ambientes de produção em larga escala e atendam às necessidades de implantação comercial. Os serviços de IA do Huawei Cloud Ascend fornecem potência de computação abundante, elástica e suficiente.

Não há limite de implementação, permitindo que os desenvolvedores se concentrem mais no desenvolvimento de aplicativos. Ao desenvolver aplicativos, eles podem chamar diretamente a API do SiliconCloud, o que proporciona uma experiência mais fácil e amigável.

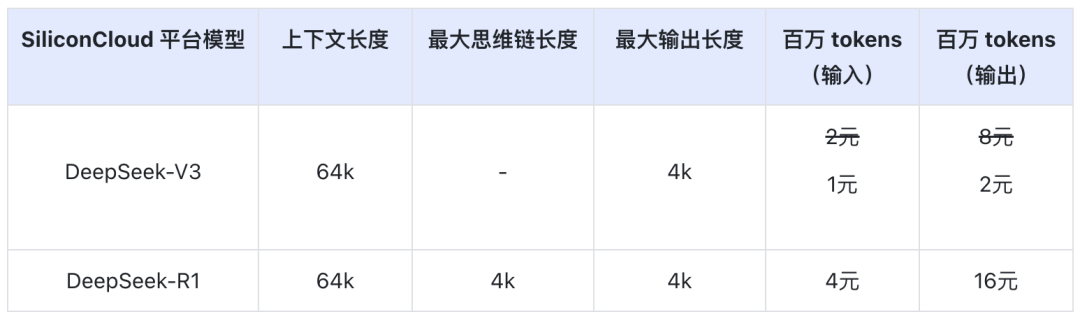

O preço do DeepSeek-V3 no SiliconCloud durante o período de desconto oficial (até as 24:00 de 8 de fevereiro) é de ¥1 / M tokens (entrada) e ¥2 / M tokens (saída), e o preço do DeepSeek-R1 é de ¥4 / M tokens (entrada) e ¥16 / M tokens (saída).

Experiência on-line

DeepSeek-R1 com o SiliconCloud

DeepSeek-V3 com o SiliconCloud

Documentação da API

Os desenvolvedores podem experimentar o efeito do DeepSeek-R1 e V3 acelerado em chips domésticos no SiliconCloud. A velocidade de saída mais rápida ainda está sendo continuamente otimizada.

Experiência em aplicativos de clientes

Se quiser experimentar o modelo DeepSeek-R1 e V3 diretamente no aplicativo cliente, você pode instalar os seguintes produtos localmente e acessar a API do SiliconCloud (você pode personalizar e adicionar esses dois modelos) para experimentar o DeepSeek-R1 e V3.

- Aplicativos de cliente de modelo grande: ChatBox, Estúdio Cherry, OneAPI, LobeChat, NextChat

- Aplicativos de geração de código: Cursor, Windsurf, Cline

- Plataforma de desenvolvimento de aplicativos de modelo grande:Dify

- Base de conhecimento de IA:IA da ObsidianeFastGPT

- Plug-in de tradução:Immersive Translate eEurodict

Para obter mais tutoriais de acesso a cenários e casos de aplicativos, consulte aqui

Fábrica de tokens SiliconCloud

Qwen2.5 (7B), etc. Mais de 20 modelos gratuitos para uso

Como uma plataforma completa de serviços em nuvem para modelos grandes, o SiliconCloud tem o compromisso de fornecer aos desenvolvedores APIs de modelos que sejam ultrarresponsivas, acessíveis, abrangentes e que tenham uma experiência suave.

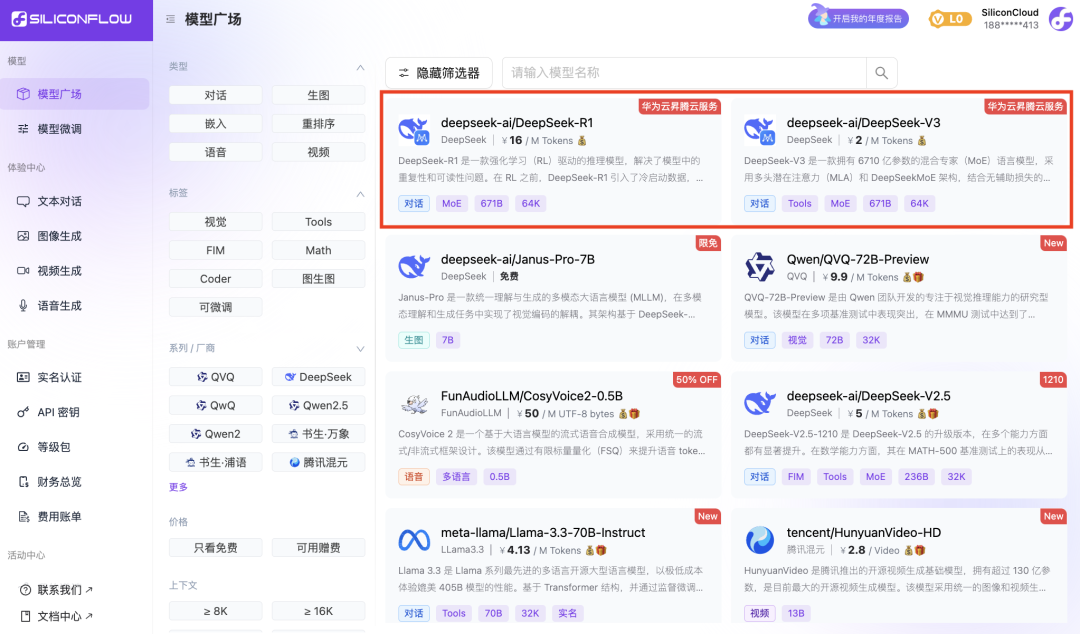

Além do DeepSeek-R1 e do DeepSeek-V3, o SiliconCloud também lançou o Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

dezenas de grandes modelos de linguagem de código aberto, modelos de geração de imagem/vídeo, modelos de fala, modelos de código/matemática e modelos vetoriais e de reordenação.

A plataforma permite que os desenvolvedores comparem e combinem livremente grandes modelos de várias modalidades para escolher a melhor prática para seu aplicativo de IA generativa.

Entre elas, mais de 20 APIs de modelos grandes, como Qwen2.5 (7B) e Llama3.1 (8B), são de uso gratuito, permitindo que os desenvolvedores e gerentes de produtos obtenham "liberdade de token" sem se preocupar com o custo da capacidade de computação durante o estágio de pesquisa e desenvolvimento e a promoção em larga escala.