A OpenAI lançou seu mais recente modelo de inferência, o3-minique é otimizado para áreas como ciências, matemática e programação, proporcionando respostas mais rápidas, maior precisão e menor custo.

Em comparação com seu antecessor o1-mini, o o3-mini melhorou significativamente seus recursos de inferência, especialmente na solução de problemas complexos. Os testadores preferem as respostas do o3-mini em 56%, e a taxa de erro foi reduzida em 39%. A partir de hoje, ChatGPT Plus, Equipe e Profissional os usuários podem usar o o3-mini, e usuários gratuitos também pode experimentar alguns de seus recursos.

Em comparação com o modelo de inferência DeepSeek-R1e o quanto melhor é OpenAI o3-mini do que o R1?

Este artigo primeiro apresentará uma visão geral dos destaques do o3-mini e, em seguida, extrairemos os dados de ambos os lados em cada benchmark e criaremos um gráfico para compará-los visualmente. Além disso, também compararemos o preço da o3-mini.

Principais destaques

1.Otimização de STEMO o1-mini é excelente nas áreas de matemática, programação, ciências etc., superando especialmente o o1-mini no modo de alto esforço de inferência.

2.Funções do desenvolvedorSuporte a funções como chamadas de função, saída estruturada e mensagens de desenvolvedor para atender às necessidades do ambiente de produção.

3.Resposta rápida24% mais rápido que o o1-mini, com um tempo de resposta de 7,7 segundos por solicitação.

4.Melhoria da segurançaO sistema de alinhamento profundo garante uma saída segura e confiável.

5.Custo-benefícioA IA é uma ferramenta de inteligência artificial que permite que os usuários utilizem os recursos de inferência e a otimização de custos de forma conjunta, reduzindo consideravelmente o limite para o uso da IA.

Comparar

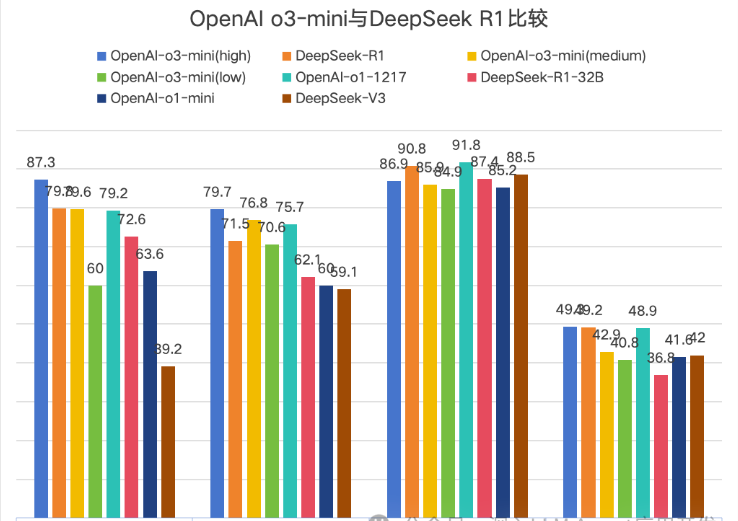

Open AI Para destacar sua classe, sua blog oficial apenas o compara com seus próprios modelos. Portanto, este artigo é uma tabela extraída do documento DeepSeek R1 e dos dados do blog oficial da OpenAI.

A OpenAI compara oficialmente o3-mini na lista de versões, dividindo-a em três versões: baixa, média e alta, que indicam a força da inferência. Como o DeepSeek usa o Math-500 e o OpenAI usa o conjunto de dados Math, essa comparação foi removida aqui.

Um gráfico é mais intuitivo, e o Codeforces foi removido porque os valores são muito grandes para serem exibidos intuitivamente. No entanto, a comparação no Codeforces mostra que a alta força de inferência do o3-mini não é uma grande vantagem.

↑1AIME2024→2GPQA Diamond→3MMLU→4SWE-bench-Verified

No gráfico, há um total de 4 comparações, e o O3-mini (high) geralmente lidera, mas a liderança é muito pequena.

Preço

| modelo | Preço de entrada | Acerto no cache | Preço de saída |

| o3-mini | $1.10 | $0.55 | $4.40 |

| o1 | $15.00 | $7.50 | $60.00 |

| Deepseek R1 | $0.55 | $0.14 | $2.19 |

Resumo

Com o DeepSeek R1 desencadeando o pânico do DeepSeek nos Estados Unidos, a primeira a se sentir ameaçada foi a OpenAI, o que é especialmente evidente no preço de seu novo modelo o3-mini.

Quando o Openai o1 foi lançado pela primeira vez, seu alto preço pressionou muitos desenvolvedores e usuários. O surgimento do DeepSeek R1 deu a todos mais opções.Desde a diferença de preço de 30 vezes entre o1 e R1 até o preço final do o3-mini ser o dobro o preço do DeepSeek R1,

mostra o impacto do DeepSeek R1 no openai.No entanto, os usuários gratuitos do ChatGPT só podem experimentar o o3-mini de forma limitada, enquanto o Deep Thinking do DeepSeek está atualmente disponível para todos os usuários.Também espero que o openai traga mais modelos de IA líderes e, ao mesmo tempo, reduza o custo de uso para os usuários.

Do ponto de vista da experiência pessoal de um blogueiro usando o R1, eu gostaria de dizer que o Deep Thinking do R1 sempre abre minha mente. Recomendo que todos o utilizem mais para pensar sobre os problemas~