o3-mini chegou tarde da noite, e a OpenAI finalmente revelou seu último trunfo. Durante uma sessão de perguntas e respostas do Reddit AMA, Altman confessou profundamente que estava do lado errado da IA de código aberto.

Ele disse que a estratégia interna de código aberto está sendo considerada, e o modelo continuará a ser desenvolvido, mas a liderança da OpenAI não será tão grande quanto antes.

Enquanto todos ainda estavam maravilhados com o incrível poder do DeepSeek, a OpenAI finalmente não conseguia mais ficar parada.

Na madrugada de ontem, o o3-mini foi lançado com urgência, estabelecendo um novo SOTA em testes de referência, como código matemático e retorno ao trono.

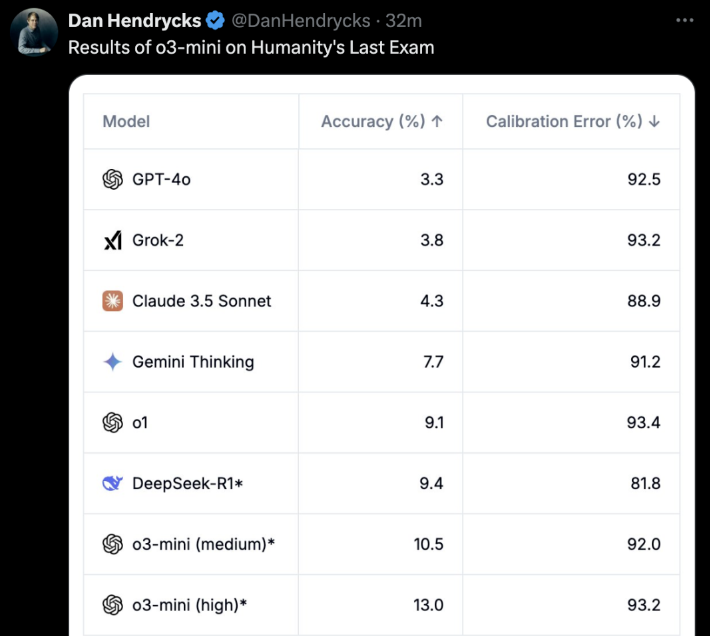

O mais importante é que os usuários gratuitos também podem experimentar! O o3-mini não é brincadeira. No "último exame para humanos", o o3-mini (high) obteve diretamente a melhor precisão e erro de calibração.

Algumas horas depois o3-mini ficou on-lineEm uma reunião com a OpenAI, ela abriu oficialmente um Reddit AMA por cerca de uma hora.

O próprio Altman também entrou na Internet e respondeu a todas as perguntas dos internautas.

Os principais destaques são:

- O DeepSeek é de fato muito bomE continuaremos a desenvolver modelos melhores, mas a liderança não será tão grande quanto antes

- Em comparação com alguns anos atrás, agora estou mais inclinado a acreditar que a IA pode dar saltos rápidos

- Estamos do lado errado da questão dos modelos de IA ponderados de código aberto

- Uma atualização para o modo de voz avançado será lançada em breve, e nós a chamaremos diretamente de GPT-5, e não GPT-5o. Ainda não há um cronograma específico.

Além do próprio Altman, o diretor de pesquisa Mark Chen, o diretor de produtos Kevin Weil, o vice-presidente de engenharia Srinivas Narayanan, a diretora de pesquisa de API Michelle Pokrass e o diretor de pesquisa Hongyu Ren também estavam on-line e responderam cuidadosamente a todas as perguntas dos internautas.

A seguir, vamos dar uma olhada no que todos eles disseram.

Altman se arrepende profundamente de ter tomado o lado errado na batalha da IA de código aberto

O retorno repentino do DeepSeek pode ter sido inesperado para todos.

Durante a sessão de perguntas e respostas da AMA, o próprio Altman também se arrependeu profundamente de ter tomado o lado errado na batalha da IA de código aberto e teve que admitir as grandes vantagens do DeepSeek.

O que surpreendeu muitas pessoas foi o fato de Altman ter dito que a liderança da OpenAI não era tão forte quanto antes.

A seguir estão todas as respostas clássicas que compilamos da Altman.

P: Vamos falar sobre o grande tópico da semana: Deepseek. É claramente um modelo impressionante, e sei que provavelmente foi treinado com base nos resultados de outros LLMs. Como isso mudará seus planos para modelos futuros?

Altman: É de fato um modelo muito impressionante! Desenvolveremos modelos melhores, mas não conseguiremos manter uma liderança tão grande como nos anos anteriores.

P: Você acha que o autoaperfeiçoamento recursivo será um processo gradual ou uma decolagem repentina?

Altman: Pessoalmente, acho que estou mais inclinado a pensar que a IA pode progredir rapidamente do que há alguns anos. Talvez seja hora de escrever algo sobre esse assunto...

P: Podemos ver todos os tokens sobre os quais o modelo pensa?

Altman: Sim, em breve estaremos mostrando uma versão mais útil e detalhada. Obrigado ao R1 pela atualização.

Kevin Weil, diretor de produtos: Estamos trabalhando para mostrar mais do que mostramos agora - isso acontecerá em breve. Ainda não sabemos se mostraremos tudo ou não. Mostrar todas as cadeias de pensamento (CoT) levaria à destilação do modelo do concorrente, mas também sabemos que os usuários (pelo menos os avançados) querem ver isso, portanto, encontraremos um bom equilíbrio.

P: Quando a versão completa do o3 estará disponível?

Altman: Eu estimaria que será mais do que algumas semanas, mas não mais do que alguns meses.

P: Haverá uma atualização para o modo de voz? Esse é potencialmente um foco para o GPT-5o? Qual é o cronograma aproximado para o GPT-5o?

Altman: Sim, uma atualização para o modo de voz avançado está chegando! Acho que vamos chamá-lo de GPT-5, e não GPT-5o. Ainda não há um cronograma específico.

P: Você consideraria a possibilidade de liberar alguns pesos de modelo e publicar algumas pesquisas?

Altman: Sim, estamos discutindo isso. Pessoalmente, acho que estamos do lado errado dessa questão e precisamos criar uma estratégia de código aberto diferente; nem todos na OpenAI compartilham dessa opinião, e essa não é nossa maior prioridade no momento.

Mais um conjunto de perguntas:

- Quanto falta para oferecermos a Operator no programa regular Plus?

- Quais são as principais prioridades do departamento de robótica?

- O que a OpenAI acha de chips/TPUs mais especializados, como Trillium, Cerebras, etc.? A OpenAI está prestando atenção a isso?

- Que investimentos estão sendo feitos para se proteger contra riscos futuros na AGI e na ASI?

- Quais foram suas férias mais memoráveis?

Altman:

- Alguns meses

- produzir um robô realmente bom em pequena escala e aprender com a experiência

- Atualmente, é difícil superar o GB200!

- Uma boa opção seria melhorar seu estado interno - resiliência, adaptabilidade, calma, alegria, etc.

- É difícil escolher! Mas as duas primeiras que me vêm à mente são: fazer um mochilão no sudeste da Ásia ou um safári na África

P: Vocês planejam aumentar o preço da série Plus?

Altman: Na verdade, quero reduzi-lo gradualmente.

P: Suponha que estamos no ano de 2030 e que você acabou de criar um sistema que a maioria das pessoas chamaria de AGI. Ele se destaca em todos os testes de benchmark e supera seus melhores engenheiros e pesquisadores em termos de velocidade e desempenho. O que vem a seguir? Além de "colocá-lo no site e oferecê-lo como um serviço", você tem outros planos?

Altman: O impacto mais importante, em minha opinião, será acelerar a descoberta científica, que, em minha opinião, é o fator que mais contribuirá para melhorar a qualidade de vida.

4o geração de imagens, em breve

Em seguida, foram adicionadas as respostas de outros membros da OpenAI.

P: Vocês ainda planejam lançar o gerador de imagens 4o?

Kevin Weil, diretor de produtos: Sim! E acho que a espera vale a pena.

P: Ótimo! Há um cronograma aproximado?

Kevin Weil, diretor de produtos: Você está me pedindo para ter problemas. Talvez por alguns meses.

E outra pergunta semelhante.

P: Quando podemos esperar ver o ChatGPT-5?

Kevin Weil, diretor de produtos: Pouco depois de o-17 micro e GPT-(π+1).

E surge outra pergunta:

- Que outros tipos de agentes podemos esperar?

- E também fornecer um agente para usuários gratuitos, o que poderia acelerar a adoção...

- Alguma novidade sobre a nova versão de DALL-E?

- Uma última pergunta, que é a que todos fazem... Quando a AGI será implementada?

Kevin Weil, diretor de produtos:

- Mais agentes: muito, muito em breve. Acho que você ficará feliz.

- Geração de imagens com base no 4o: em alguns meses, mal posso esperar para que você o use. É ótimo.

- AGI: Sim

P: Vocês planejam adicionar a funcionalidade de anexação de arquivos ao modelo de raciocínio?

Srinivas Narayanan, vice-presidente de engenharia: Está em desenvolvimento. No futuro, o modelo de raciocínio poderá usar diferentes ferramentas, incluindo funções de pesquisa.

Kevin Weil, diretor de produtos: Só para dizer que mal posso esperar para ver o modelo de raciocínio que permite o uso de ferramentas

P: Realmente. Quando você resolver esse problema, alguns cenários de aplicativos de IA muito úteis serão abertos. Imagine que ela seja capaz de entender o conteúdo de seus 500 GB de documentos de trabalho.

Quando você estiver prestes a responder a um e-mail, será aberto um painel ao lado do aplicativo de e-mail que analisa continuamente todas as informações relacionadas a essa pessoa, incluindo seu relacionamento, os tópicos discutidos, trabalhos anteriores etc. Talvez algo de um documento que você tenha esquecido há muito tempo seja sinalizado por ser altamente relevante para a discussão atual. Eu quero muito esse recurso.

Srinivas Narayanan, vice-presidente de engenharia: Estamos trabalhando para aumentar a duração do contexto. Ainda não há uma data/anúncio firme.

P: Qual é a importância do projeto Stargate para o futuro da OpenAI? Kevin Weil, diretor de produtos: Muito importante. Tudo o que vimos sugere que quanto mais poder de computação tivermos, melhores modelos poderemos construir e mais produtos valiosos poderemos criar.

No momento, estamos dimensionando os modelos em duas dimensões - maior pré-treinamento e mais aprendizado por reforço (RL)/treinamento "strawberry" - e ambos exigem recursos de computação.

Atender a centenas de milhões de usuários também requer recursos de computação! E à medida que avançamos em direção a produtos de agentes mais inteligentes que podem trabalhar para você continuamente, isso também requer recursos de computação. Portanto, você pode pensar no Stargate como nossa fábrica, onde a eletricidade/GPUs são convertidas em produtos incríveis.

P: Internamente, qual modelo você está usando agora? o4, o5 ou o6? Esses modelos internos são muito mais inteligentes em comparação com o o3?

Michelle Pokrass, diretora de pesquisa da API: Já perdemos a conta.

P: Permita-nos interagir com texto/canvas usando recursos avançados de voz. Quero poder falar com ele e fazer com que ele modifique os documentos de forma iterativa.

Kevin Weil, diretor de produtos: Sim! Temos muitas ferramentas excelentes que foram desenvolvidas de forma relativamente independente - o objetivo é colocar essas ferramentas em suas mãos o mais rápido possível.

A próxima etapa é integrar todos esses recursos para que você possa conversar com um modelo, que pesquisa e raciocina ao mesmo tempo, e gerar uma tela que possa executar o Python. Todas as ferramentas precisam trabalhar melhor em conjunto. E, a propósito, todos os modelos precisam de acesso total às ferramentas (os modelos da série O atualmente não podem usar todas as ferramentas), o que também será implementado.

P: Quando os modelos da série O serão compatíveis com a função de memória no ChatGPT?

Michelle Pokrass, diretora de pesquisa de API: Está em desenvolvimento! Unificar todos os nossos recursos com os modelos da série O é nossa principal prioridade.

P: Haverá alguma melhoria importante no 4o? Gosto muito do GPT personalizado e seria ótimo se ele pudesse ser atualizado ou se pudéssemos escolher o modelo a ser usado no GPT personalizado (como o o3 mini).

Michelle Pokrass, diretora de pesquisa da API: Sim, ainda não terminamos a série 4o!