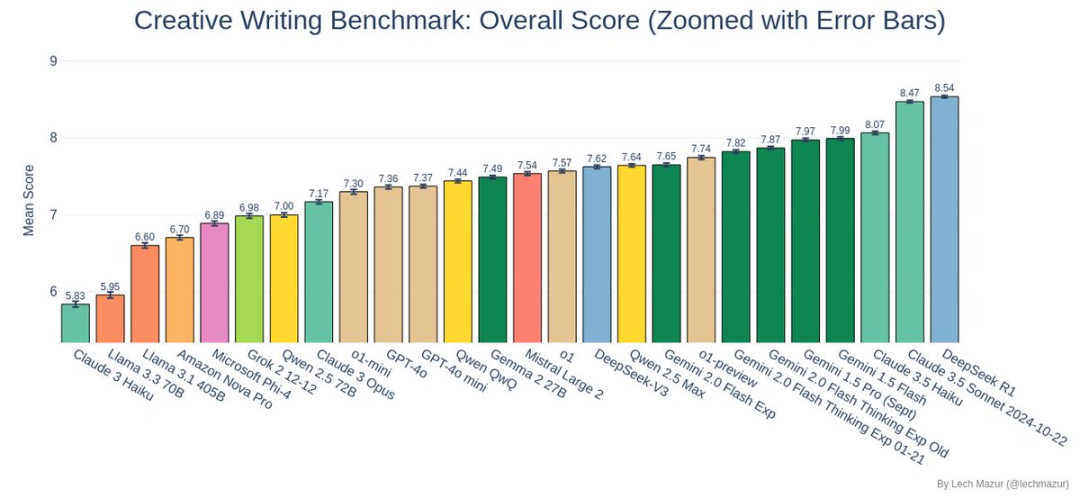

O DeepSeek R1 ganhou o campeonato no teste de benchmark de escrita de contos criativos, superando com sucesso o jogador dominante anterior, o Claude 3.5 Sonnet!

Teste de benchmark

O teste de referência elaborado pelo pesquisador Lech Mazur não é um concurso de redação comum.

Cada modelo de IA teve de completar 500 contos, e cada conto teve de incorporar de forma inteligente 10 elementos atribuídos aleatoriamente. Essa foi uma tarefa desafiadora de escrita aberta para a IA, que não só exigiu um enredo completo, mas também garantiu que todos os elementos atribuídos fossem naturalmente integrados

Método de julgamento

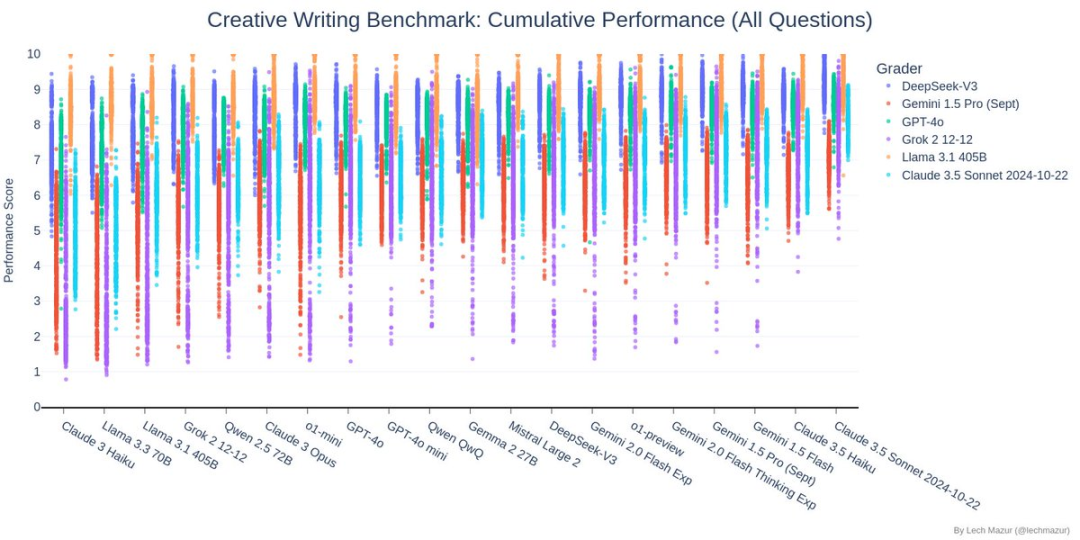

Esse teste de referência usa um sistema de pontuação exclusivo: seis dos principais modelos de linguagem atuam como juízes, pontuando vários aspectos da história. Em outras palavras, os líderes do setor de IA estão julgando a própria IA, o que, em geral, proporciona um padrão de avaliação relativamente justo e sistemático.

Conteúdo do teste

O gráfico acima mostra a análise de correlação das pontuações no teste de referência de redação criativa. DeepSeek tem um coeficiente de correlação de mais de 0,93 com outros modelos principais (Claude, GPT-4o, Gemini e Grok), indicando que ele tem critérios de julgamento altamente consistentes com outros modelos principais ao julgar a qualidade da redação criativa, o que indiretamente confirma sua confiabilidade nesse teste.

O gráfico acima mostra os resultados do teste de benchmark de redação de contos criativos. Cada modelo de IA foi solicitado a escrever 500 histórias, sendo que cada uma delas deve conter 10 elementos aleatórios especificados. Os pontos no gráfico mostram a distribuição da pontuação de cada modelo de IA participante para diferentes modelos de pontuação (representados por cores diferentes).

No teste, ProfundoSeek (pontos azuis escuros) teve um bom desempenho, com a maioria de seus pontos de pontuação concentrada na metade superior do gráfico e relativamente concentrada, mostrando um nível alto e estável de habilidade de redação criativa.

Esse desempenho excepcional permitiu que ele superasse com sucesso o campeão anterior, o Claude 3.5 Sonnet, e se tornasse o novo líder em testes de benchmark.

Nesse gráfico, cada linha representa um modelo de IA e cada coluna representa uma dimensão de avaliação (como caracterização, coerência do gráfico etc.). O DeepSeek está localizado na parte superior central do gráfico, com uma tonalidade laranja-amarela geral, indicando que obteve excelentes resultados na maioria das dimensões de avaliação. Em particular, obteve pontuações altas de quase 8 pontos nas dimensões-chave de execução (Q6), caracterização (TA) e desenvolvimento do enredo (TJ). Embora possa não ser o amarelo mais brilhante em dimensões individuais, não apresenta nenhum ponto fraco evidente.

Como você pode ver no gráfico, as pontuações das histórias do DeepSeek estão distribuídas principalmente entre 7 e 9 pontos, e a distribuição é relativamente concentrada. É interessante notar que sua linha de tendência é quase horizontal, indicando que a qualidade da história do DeepSeek não está intimamente relacionada ao tamanho da história. Em outras palavras, quer esteja escrevendo uma história longa ou uma história curta, o DeepSeek pode manter um resultado consistentemente de alta qualidade. Isso mostra que O DeepSeek se concentra mais na qualidade do que na quantidade ao criar, e pode manter um excelente desempenho em histórias de diferentes durações.

Por que DeepSeek R1 vencer?

A julgar pelos resultados dos testes, o DeepSeek R1 teve um desempenho surpreendente:

- Recursos abrangentes de integração de histórias: O R1 demonstrou flexibilidade e criatividade incríveis ao lidar com diferentes combinações de elementos da história.

- Qualidade de saída estável: A julgar pelo gráfico de distribuição de pontuação, o R1 não só teve uma pontuação média alta, mas também um desempenho estável com menos flutuação.

- Desempenho criativo excepcional: Nesse teste de benchmark, as histórias criadas pelo R1 foram classificadas entre as três primeiras no geral, o que prova sua excelente capacidade de escrita criativa.

Como foi o desempenho dos outros participantes?

Além do emocionante confronto entre o DeepSeek R1 e o Claude 3.5 Sonnet, o desempenho de outros modelos também merece destaque:

- A série Gemini teve um bom desempenho

- A série Llama 3.x teve um pouco de dificuldade nesse teste

- O o3-mini não teve um bom desempenho, ficando em 22º lugar

Finalmente

O avanço do DeepSeek R1 nesse teste nos mostrou as infinitas possibilidades da IA no campo da criatividade. Embora a criação de IA ainda esteja no caminho do aprimoramento contínuo, esses resultados já nos deixaram cheios de expectativas para o futuro.

Para quem quiser saber mais sobre os detalhes do teste, visite o GitHub de Lech Mazur para obter os dados completos e exemplos das melhores histórias. Vamos esperar juntos por mais avanços na escrita criativa com IA!