Nenhum de nós esperava que seria assim que 2025 começaria no campo da IA.

DeepSeek R1 é realmente incrível!

Recentemente, a "misteriosa potência oriental" DeepSeek vem "controlando duramente" o Vale do Silício.

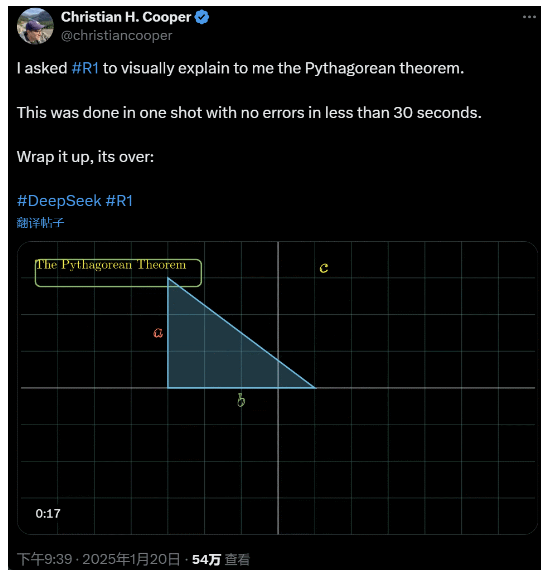

Pedi ao R1 que explicasse o teorema de Pitágoras em detalhes. Tudo isso foi feito pela IA em menos de 30 segundos, sem nenhum erro. Em resumo, acabou.

Nos círculos de IA nacionais e estrangeiros, os internautas comuns descobriram a incrível e poderosa nova IA (que também é de código aberto), e os especialistas acadêmicos gritaram "precisamos nos atualizar". Há também rumores de que as empresas estrangeiras de IA já estão enfrentando uma grande ameaça.

Basta ver o DeepSeek R1 lançado esta semana. Sua rota de aprendizagem por reforço puro sem nenhum treinamento supervisionado é chocante. Desde o desenvolvimento da base do Deepseek-v3 em dezembro do ano passado até os atuais recursos da cadeia de raciocínio comparáveis ao OpenAI o1, parece ser uma questão de tempo.

Mas, enquanto a comunidade de IA está ocupada lendo relatórios técnicos e comparando medições reais, as pessoas ainda têm dúvidas sobre o R1: além de ser capaz de superar uma série de benchmarks, ele pode realmente liderar?

Ele pode criar suas próprias simulações de "leis físicas"?

Você não acredita nisso? Vamos deixar o grande modelo brincar com uma bola de pinball?

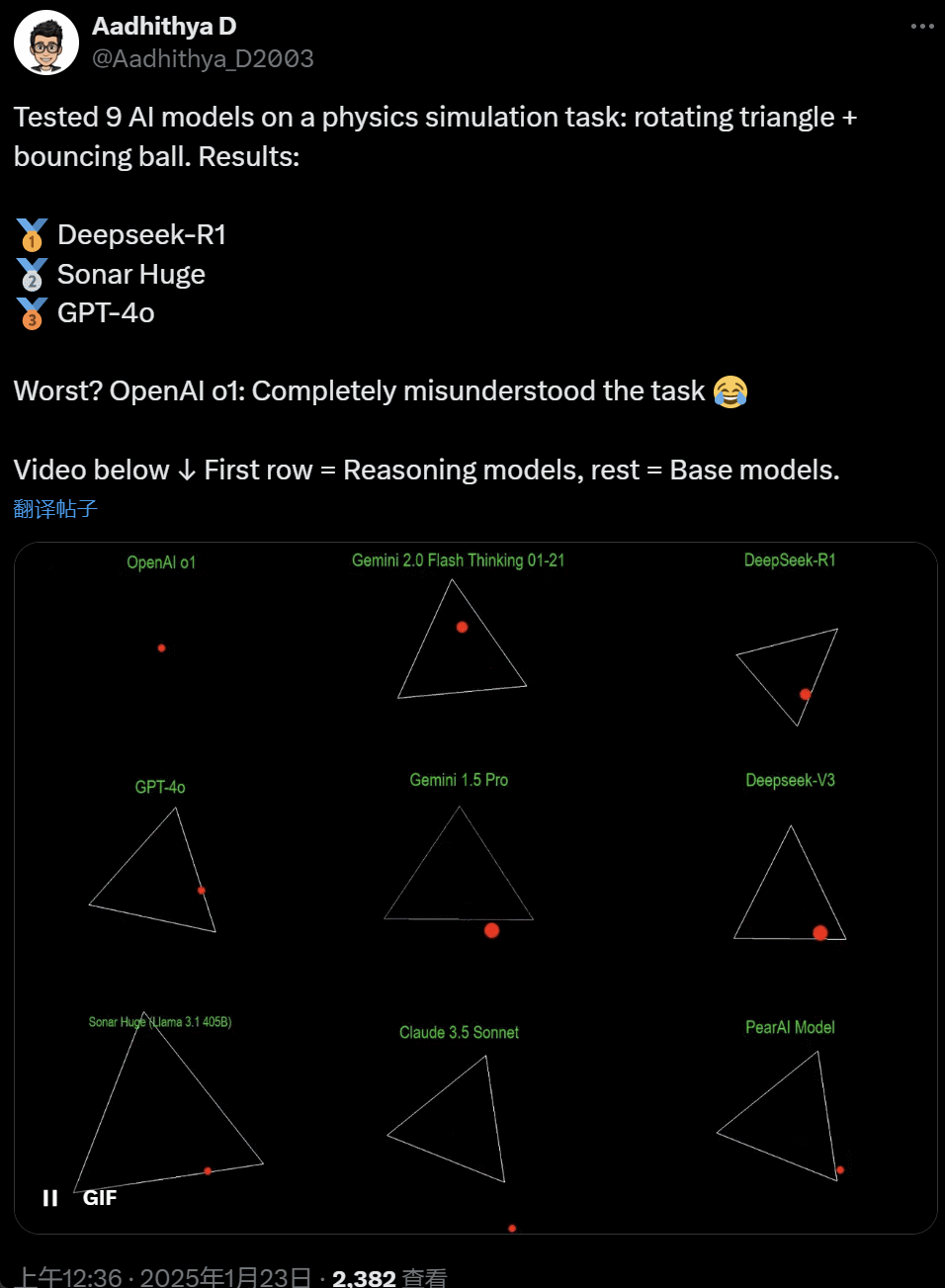

Nos últimos dias, algumas pessoas da comunidade de IA ficaram obcecadas com um teste - testar diferentes modelos grandes de IA (especialmente os chamados modelos de raciocínio) para resolver um problema: "Escreva um script Python para fazer uma bola amarela quicar dentro de uma determinada forma. Faça a forma girar lentamente e certifique-se de que a bola permaneça dentro da forma."

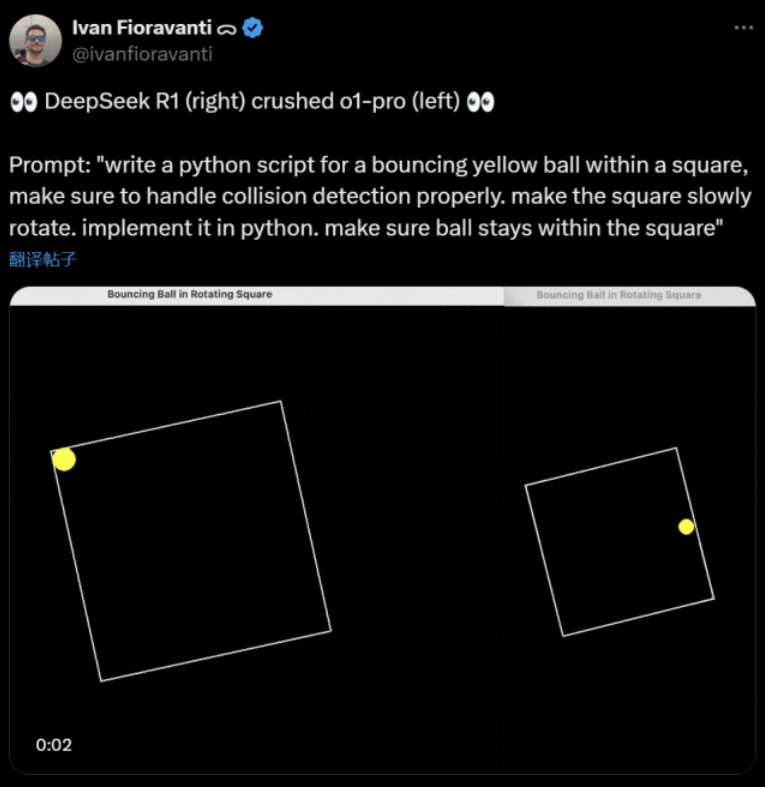

Alguns modelos superam outros nesse benchmark de "bola giratória". De acordo com o CTO da CoreView, Ivan Fioravanti, o DeepSeek, um laboratório nacional de inteligência artificial, tem um modelo grande de código aberto R1 que supera o modelo o1 pro da OpenAI, que custa $200 por mês como parte do programa ChatGPT Pro da OpenAI.

À esquerda está o OpenAI o1 e à direita o DeepSeek R1. Conforme mencionado acima, o prompt aqui é: "escreva um script em python para uma bola amarela quicando dentro de um quadrado, certifique-se de lidar corretamente com a detecção de colisão. faça o quadrado girar lentamente. implemente-o em python. certifique-se de que a bola permaneça dentro do quadrado".

De acordo com outro usuário do X, os modelos Anthropic Claude 3.5 Sonnet e Gemini 1.5 Pro do Google fizeram julgamentos incorretos sobre princípios físicos, fazendo com que a bola se desviasse de sua forma. Alguns usuários também relataram que o Gemini 2.0 Flash Thinking Experimental mais recente do Google, bem como o OpenAI GPT-4o, relativamente mais antigo, foram aprovados na avaliação de uma só vez.

Mas há uma maneira de perceber a diferença aqui:

Os internautas que escreveram esse tweet disseram: a capacidade da o1 era originalmente muito boa, mas ficou mais fraca depois que a OpenAI otimizou a velocidade, mesmo com a versão de assinatura de $200/mês.

A simulação de uma bola quicando é um desafio clássico de programação. Uma simulação precisa combina algoritmos de detecção de colisão, que precisam identificar quando dois objetos (como uma bola e a lateral de uma forma) colidem. Um algoritmo escrito de forma incorreta pode afetar o desempenho da simulação ou causar erros físicos óbvios.

N8 Programs, pesquisador da startup de IA Nous Research, disse que levou cerca de duas horas para escrever do zero uma bola quicando em um heptágono rotativo. "Vários sistemas de coordenadas devem ser rastreados, é necessário entender como as colisões são tratadas em cada sistema e o código deve ser projetado do zero para ser robusto."

Embora as bolas quicando e as formas giratórias sejam um teste razoável de habilidades de programação, elas ainda são projetos novos para modelos grandes, e até mesmo pequenas alterações nos prompts podem produzir resultados diferentes. Portanto, se quisermos que ele se torne parte do teste de referência para grandes modelos de IA, ele ainda precisa ser aprimorado.

De qualquer forma, após essa onda de testes práticos, temos uma noção das diferenças de recursos entre os modelos grandes.

DeepSeek é o novo "mito do Vale do Silício

O DeepSeek está causando pânico" em todo o Pacífico.

Os funcionários da Meta postaram que "os engenheiros da Meta estão analisando freneticamente o DeepSeek para tentar copiar tudo o que puderem dele".

Alexandr Wang, fundador da startup de tecnologia de IA Scale AI, também declarou publicamente que o desempenho do modelo de IA de grande porte do DeepSeek é aproximadamente equivalente ao melhor modelo dos Estados Unidos.

Ele também acredita que os Estados Unidos podem ter estado à frente da China na competição de IA na última década, mas o lançamento do modelo grande de IA da DeepSeek pode "mudar tudo".

O X Blogger @8teAPi acredita que o DeepSeek não é um "projeto paralelo", mas é como o antigo "Skunk Works" da Lockheed Martin.

A chamada "Skunk Works" refere-se a uma pequena equipe altamente confidencial e relativamente independente que a Lockheed Martin criou originalmente para desenvolver muitas aeronaves avançadas, engajadas em pesquisa e desenvolvimento de tecnologia de ponta ou não convencional. Desde o avião de reconhecimento U-2 e o SR-71 Blackbird até o F-22 Raptor e o caça F-35 Lightning II, todos vieram daqui.

Posteriormente, o termo evoluiu gradualmente para um termo genérico usado para descrever equipes de inovação "pequenas, mas excelentes", relativamente independentes e mais flexíveis, criadas dentro de grandes empresas ou organizações.

Ele apresentou dois motivos:

- Por um lado, o DeepSeek tem um grande número de GPUs, supostamente mais de 10.000, e Alexandr Wang, CEO da Scale AI, chegou a dizer que poderia chegar a 50.000.

- Por outro lado, a DeepSeek só recruta talentos das três principais universidades da China, o que significa que a DeepSeek é tão competitiva quanto a Alibaba e a Tencent.

Esses dois fatos, por si só, mostram que o DeepSeek obteve claramente sucesso comercial e é conhecido o suficiente para obter esses recursos.

Quanto aos custos de desenvolvimento do DeepSeek, o blogueiro disse que as empresas de tecnologia chinesas podem receber vários subsídios, como baixos custos de eletricidade e uso de terrenos.

Portanto, é muito provável que a maior parte dos custos do DeepSeek tenha sido "colocada" em uma conta fora do negócio principal ou na forma de algum tipo de subsídio para a construção do data center.

Mesmo além dos fundadores, ninguém entende completamente todos os acordos financeiros. Alguns acordos podem ser simplesmente "acordos verbais" que são finalizados com base apenas na reputação.

Independentemente disso, algumas coisas estão claras:

- O modelo é excelente, comparável à versão lançada pela OpenAI há dois meses, e é claro que é possível que não seja tão bom quanto os novos modelos que a OpenAI e a Anthropic ainda não lançaram.

- Do ponto de vista atual, a direção da pesquisa ainda é dominada pelas empresas americanas. O modelo DeepSeek é um "acompanhamento rápido" da versão o1, mas o progresso de pesquisa e desenvolvimento do DeepSeek é muito rápido, alcançando-o mais rápido do que o esperado. Eles não estão plagiando ou trapaceando, no máximo estão fazendo engenharia reversa.

- A DeepSeek está treinando principalmente seus próprios talentos, em vez de depender de PhDs treinados nos Estados Unidos, o que amplia muito o conjunto de talentos.

- Em comparação com as empresas norte-americanas, a DeepSeek está sujeita a menos restrições em termos de licenciamento de propriedade intelectual, privacidade, segurança, política etc., e há menos preocupações com o uso indevido de dados sobre os quais as pessoas não querem ser treinadas. Há menos ações judiciais, menos advogados e menos preocupações.

Não há dúvida de que cada vez mais pessoas acreditam que 2025 será um ano decisivo. Enquanto isso, as empresas estão se preparando para ele. A Meta, por exemplo, está construindo um data center de 2GW+, com um investimento estimado de $60-65 bilhões até 2025, e terá mais de 1,3 milhão de GPUs até o final do ano.

A Meta até usou um gráfico para comparar seu data center de 2 gigawatts com o de Manhattan, em Nova York.

Mas agora o DeepSeek se saiu melhor com um custo menor e menos GPUs. Como isso pode não deixar as pessoas ansiosas?

Yann LeCun: Temos que agradecer ao CTO e cofundador da o código aberto

Hiperbólico, Yuchen Jin, por postar que, em apenas 4 dias, o DeepSeek-R1 provou 4 fatos para nós:

- A IA de código aberto está apenas 6 meses atrás da IA de código fechado

- A China está dominando a competição de IA de código aberto

- Estamos entrando na era de ouro da aprendizagem por reforço de modelos de linguagem grandes

- Os modelos de destilação são muito avançados, e executaremos IA altamente inteligente em telefones celulares

A reação em cadeia desencadeada pelo DeepSeek ainda continua, como a disponibilização gratuita do OpenAI o3-mini, a esperança da comunidade de reduzir as discussões vagas sobre AGI/ASI e o boato de que o Meta está em pânico.

Ele acredita que é difícil prever quem vencerá, mas não devemos nos esquecer do poder da vantagem do retardatário. Afinal, todos nós sabemos que foi o Google que inventou o Transformer, enquanto a OpenAI revelou seu verdadeiro potencial.

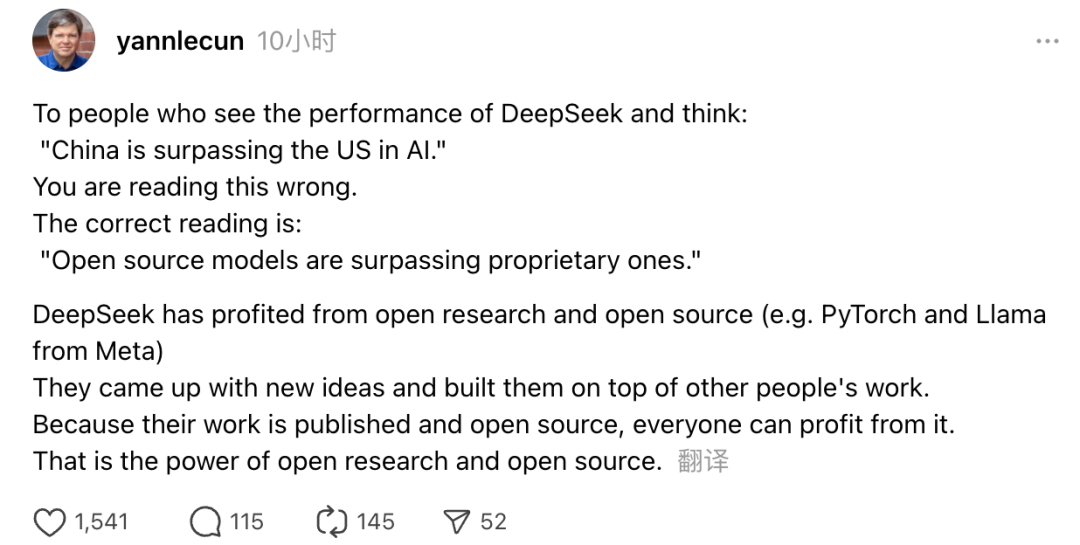

Além disso, o vencedor do Prêmio Turing e cientista-chefe de IA da Meta, Yann LeCun, também expressou suas opiniões.

"Para aqueles que, ao verem o desempenho do DeepSeek, pensam: 'A China está ultrapassando os EUA em IA', estão enganados. O entendimento correto é que os modelos de código aberto estão ultrapassando os modelos proprietários."

LeCun disse que o motivo pelo qual o DeepSeek fez tanto sucesso desta vez é que ele se beneficiou da pesquisa aberta e do código aberto (como o PyTorch e o Llama do Meta). O DeepSeek apresentou novas ideias e se baseou no trabalho de outros. Como seu trabalho é lançado publicamente e de código aberto, todos podem se beneficiar dele. Esse é o poder da pesquisa aberta e do código-fonte aberto.

As reflexões dos internautas continuam. Embora estejam entusiasmados com o desenvolvimento de novas tecnologias, eles também podem sentir uma pequena atmosfera de ansiedade. Afinal, o surgimento dos DeepSeekers pode ter um impacto real.