Nihče od nas ni pričakoval, da se bo tako začelo leto 2025 na področju umetne inteligence.

DeepSeek R1 je res neverjetno!

Pred kratkim je "skrivnostna vzhodna sila" DeepSeek "trdo nadzorovala" Silicijevo dolino.

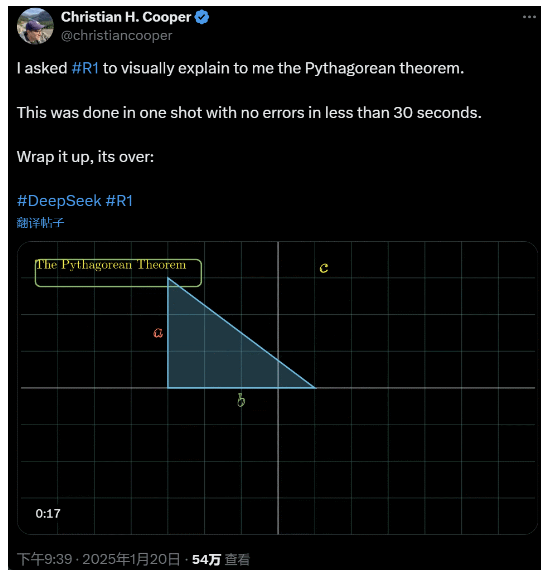

Prosil sem R1, da podrobno razloži Pitagorov izrek. Vse to je umetna inteligenca naredila v manj kot 30 sekundah brez napak. Skratka, konec je.

V domačih in tujih krogih umetne inteligence so običajni uporabniki interneta odkrili neverjetno in zmogljivo novo umetno inteligenco (ki je tudi odprtokodna), akademski strokovnjaki pa so vzklikali, da moramo dohiteti. Obstajajo tudi govorice, da se čezmorska podjetja AI že soočajo z veliko grožnjo.

Samo vzemite ta DeepSeek R1, ki je bil izdan ta teden. Njegova čista učna pot za okrepitev brez kakršnega koli nadzorovanega usposabljanja je šokantna. Zdi se, da je od razvoja baze Deepseek-v3 decembra lani do trenutnih zmogljivosti verige razmišljanja, primerljivih z OpenAI o1, vprašanje časa.

Toda medtem ko je skupnost umetne inteligence zaposlena z branjem tehničnih poročil in primerjavo dejanskih meritev, ljudje še vedno dvomijo o R1: poleg tega, da lahko preseže vrsto meril, ali lahko res vodi?

Ali lahko zgradi lastne simulacije "fizikalnih zakonov"?

ne verjameš? Pustimo velikemu modelu, da se igra s fliperjem?

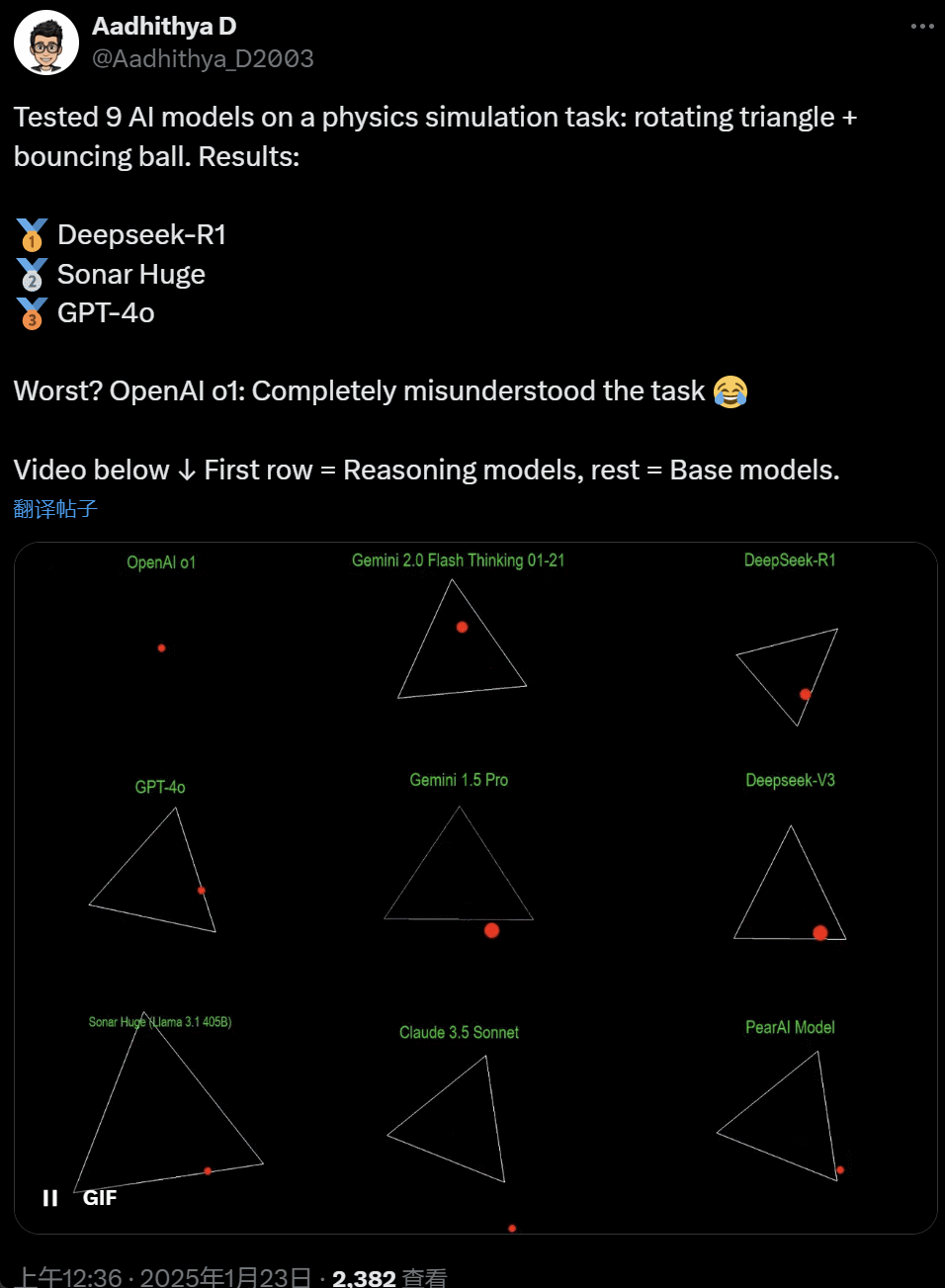

V zadnjih dneh so nekateri ljudje v skupnosti umetne inteligence postali obsedeni s testom – preizkušanjem različnih velikih modelov umetne inteligence (zlasti tako imenovanih modelov razmišljanja), da bi rešili problem: »Napišite skript Python, da bo rumena žoga odskočila znotraj določenega oblika. Naj se oblika počasi vrti in poskrbi, da žogica ostane znotraj oblike.«

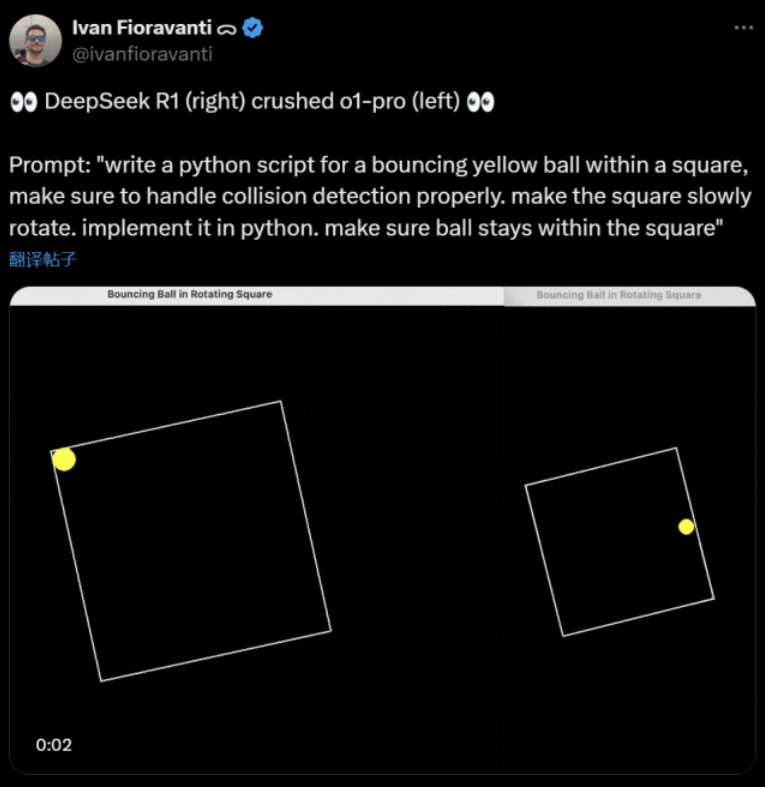

Nekateri modeli prekašajo druge pri tem merilu »vrteče se krogle«. Po besedah tehničnega direktorja CoreView Ivana Fioravantija ima DeepSeek, domači laboratorij za umetno inteligenco, odprtokodni veliki model R1, ki premaga model o1 pro OpenAI, ki stane $200 na mesec kot del programa OpenAI ChatGPT Pro.

Na levi je OpenAI o1, na desni pa DeepSeek R1. Kot je bilo omenjeno zgoraj, je tukaj poziv: »napišite skript python za odbijajočo se rumeno žogico znotraj kvadrata, poskrbite, da boste pravilno obravnavali zaznavanje trka. naj se kvadrat počasi vrti. implementirajte v python. poskrbite, da žogica ostane v kvadratu.«

Po besedah drugega uporabnika na X sta modela Anthropic Claude 3.5 Sonnet in Googlov Gemini 1.5 Pro napačno ocenila fizična načela, zaradi česar je žoga odstopala od svoje oblike. Nekateri uporabniki so tudi poročali, da sta Googlov najnovejši Gemini 2.0 Flash Thinking Experimental in razmeroma starejši OpenAI GPT-4o naenkrat prestala oceno.

Vendar obstaja način, kako ugotoviti razliko:

Netizens pod tem tvitom so povedali: sposobnost o1 je bila prvotno zelo dobra, vendar je postala šibkejša, ko je OpenAI optimiziral hitrost, tudi z različico članstva $200/mesec.

Simulacija odbijajoče se žoge je klasičen programski izziv. Natančna simulacija združuje algoritme za zaznavanje trkov, ki morajo prepoznati, kdaj trčita dva predmeta (kot sta žogica in stranica oblike). Nepravilno napisan algoritem lahko vpliva na delovanje simulacije ali povzroči očitne fizične napake.

N8 Programs, raziskovalec pri zagonu umetne inteligence Nous Research, je dejal, da je potreboval približno dve uri, da je iz nič napisal odbijajočo se žogico v vrtečem sedemkotniku. "Slediti je treba več koordinatnim sistemom, potrebno je razumevanje, kako se obravnavajo trki v vsakem sistemu, koda pa mora biti zasnovana iz nič, da bo robustna."

Čeprav so poskakujoče žogice in vrteče se oblike razumen preizkus znanja programiranja, so še vedno novi projekti za velike modele in že majhne spremembe v pozivih lahko povzročijo drugačne rezultate. Torej, če naj bi sčasoma postal del primerjalnega testa za velike modele AI, ga je treba še izboljšati.

Vsekakor imamo po tem valu praktičnih testov občutek razlik v zmogljivostih med velikimi modeli.

DeepSeek je novi »mit Silicijeve doline

DeepSeek povzroča paniko po Tihem oceanu.

Zaposleni pri Meti so objavili, da "Inženirji Mete mrzlično analizirajo DeepSeek, da bi poskušali iz njega kopirati vse, kar lahko."

Alexandr Wang, ustanovitelj zagona tehnologije umetne inteligence Scale AI, je tudi javno izjavil, da je zmogljivost velikega modela umetne inteligence DeepSeek približno enakovredna najboljšemu modelu v Združenih državah.

Verjame tudi, da so bile Združene države morda pred Kitajsko v konkurenci AI v zadnjem desetletju, vendar pa lahko izdaja DeepSeek velikega modela AI "vse spremeni."

X Blogger @8teAPi verjame, da DeepSeek ni "stranski projekt", ampak je kot nekdanji "Skunk Works" Lockheed Martina.

Tako imenovani »Skunk Works« se nanaša na zelo zaupno, razmeroma neodvisno majhno ekipo, ki jo je Lockheed Martin prvotno ustanovil za razvoj številnih naprednih letal, ki se ukvarjajo z vrhunskimi ali nekonvencionalnimi tehnološkimi raziskavami in razvojem. Od izvidniškega letala U-2 in SR-71 Blackbird do F-22 Raptor in lovca F-35 Lightning II, vsi prihajajo od tu.

Kasneje se je izraz postopoma razvil v splošen izraz, ki se uporablja za opis »majhnih, a dobrih«, razmeroma neodvisnih in bolj prilagodljivih inovacijskih skupin, ustanovljenih v velikih podjetjih ali organizacijah.

Navedel je dva razloga:

- Po eni strani ima DeepSeek veliko število grafičnih procesorjev, domnevno več kot 10.000, in Alexandr Wang, izvršni direktor Scale AI, je celo dejal, da bi lahko dosegel 50.000.

- Po drugi strani pa DeepSeek zaposluje samo talente s treh najboljših univerz na Kitajskem, kar pomeni, da je DeepSeek tako konkurenčen kot Alibaba in Tencent.

Že samo ti dve dejstvi kažeta, da je DeepSeek očitno dosegel komercialni uspeh in je dovolj znan, da pridobi te vire.

Glede stroškov razvoja DeepSeek je bloger dejal, da lahko kitajska tehnološka podjetja prejmejo različne subvencije, kot so nizki stroški električne energije in raba zemljišč.

Zato je zelo verjetno, da je večina stroškov DeepSeek “položena” na račun izven osnovne dejavnosti ali v obliki neke vrste subvencije za gradnjo podatkovnega centra.

Tudi razen ustanoviteljev nihče ne razume popolnoma vseh finančnih dogovorov. Nekateri dogovori so lahko preprosto "ustni dogovori", ki so sklenjeni zgolj na podlagi ugleda.

Ne glede na to je nekaj stvari jasnih:

- Model je odličen, primerljiv z različico, ki jo je OpenAI izdal pred dvema mesecema, seveda pa je možno, da ni tako dober kot novi modeli, ki jih OpenAI in Anthropic še nista izdala.

- Iz trenutne perspektive raziskovalno smer še vedno prevladujejo ameriška podjetja. Model DeepSeek je "hitro nadaljevanje" različice o1, vendar je napredek pri raziskavah in razvoju DeepSeek zelo hiter in dohiteva hitreje, kot je bilo pričakovano. Ne gre za plagiat ali goljufanje, kvečjemu gre za obratno inženirstvo.

- DeepSeek v glavnem usposablja lastne talente, namesto da bi se zanašal na doktorje znanosti, usposobljene v Ameriki, kar močno razširi nabor talentov.

- V primerjavi z ameriškimi podjetji velja za DeepSeek manj omejitev v smislu licenciranja intelektualne lastnine, zasebnosti, varnosti, politike itd., poleg tega je manj skrbi glede napačne uporabe podatkov, o katerih ljudje nočejo biti usposobljeni. Manj je tožb, manj odvetnikov in manj skrbi.

Nobenega dvoma ni, da vse več ljudi verjame, da bo leto 2025 odločilno. Medtem se podjetja na to pripravljajo. Meta na primer gradi podatkovni center z močjo 2 GW+ z ocenjeno naložbo $60-65 milijard do leta 2025 in bo imel do konca leta več kot 1,3 milijona grafičnih procesorjev.

Meta je celo uporabila grafikon za primerjavo svojega 2-gigavatnega podatkovnega centra z Manhattnom v New Yorku.

Toda zdaj se je DeepSeek odrezal bolje z nižjimi stroški in manj grafičnimi procesorji. Kako naj to ne vznemirja ljudi?

Yann LeCun: Moramo se zahvaliti tehničnemu direktorju in soustanovitelju the odprtokodni

Hiperbolično, Yuchen Jin, za objavo, da nam je DeepSeek-R1 v samo 4 dneh dokazal 4 dejstva:

- Odprtokodni AI za zaprtokodnim AI zaostaja le 6 mesecev

- Kitajska prevladuje v konkurenci odprtokodne umetne inteligence

- Vstopamo v zlato dobo učenja s krepitvijo velikih jezikovnih modelov

- Destilacijski modeli so zelo zmogljivi in na mobilnih telefonih bomo izvajali visoko inteligentno umetno inteligenco

Verižna reakcija, ki jo je sprožil DeepSeek, se še vedno nadaljuje, na primer prosto dostopen OpenAI o3-mini, upanje v skupnosti, da bo zmanjšala nejasne razprave o AGI/ASI, in govorice, da je Meta v paniki.

Meni, da je težko napovedati, kdo bo na koncu zmagal, a ne gre pozabiti na moč prednosti zamudnika. Navsezadnje vsi vemo, da je Google izumil Transformer, medtem ko je OpenAI sprostil njegov pravi potencial.

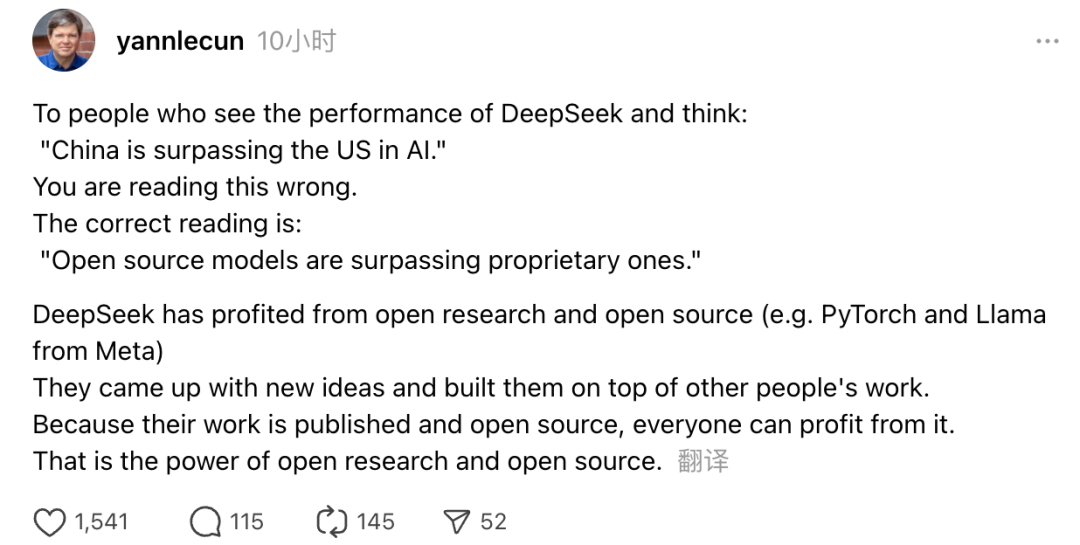

Poleg tega je svoje poglede izrazil tudi dobitnik Turingove nagrade in Metin glavni znanstvenik za umetno inteligenco Yann LeCun.

»Za tiste, ki si ob ogledu zmogljivosti DeepSeek mislijo, da 'Kitajska prehiteva ZDA v AI', se motite. Pravilno razumevanje je, da odprtokodni modeli prehitevajo lastniške modele.«

LeCun je dejal, da je razlog, da je DeepSeek tokrat poskrbel za tak pljusk, ker so imeli koristi od odprtih raziskav in odprte kode (kot sta Metin PyTorch in Llama). DeepSeek je prišel z novimi idejami in gradil na delu drugih. Ker je njihovo delo javno objavljeno in odprtokodno, lahko koristi vsem. To je moč odprtih raziskav in odprte kode.

Razmišljanja uporabnikov interneta se nadaljujejo. Medtem ko so navdušeni nad razvojem novih tehnologij, lahko občutijo tudi rahlo vzdušje tesnobe. Navsezadnje ima lahko pojav DeepSeekers resničen vpliv.