Hiçbirimiz 2025'in yapay zeka alanında böyle başlayacağını beklemiyorduk.

DeepSeek R1 gerçekten inanılmaz!

Son zamanlarda, "gizemli Doğu gücü" DeepSeek Silikon Vadisi'ni "sıkı bir şekilde kontrol ediyor".

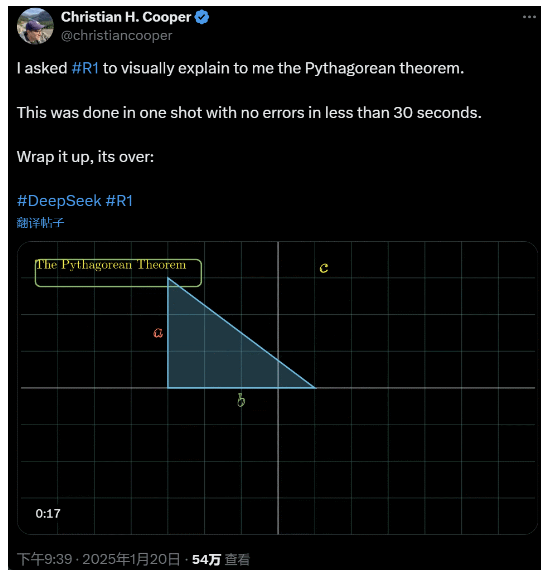

R1'den Pisagor teoremini ayrıntılı olarak açıklamasını istedim. Tüm bunlar yapay zeka tarafından 30 saniyeden kısa bir sürede hatasız bir şekilde yapıldı. Kısacası, bitti.

Yerli ve yabancı YZ çevrelerinde, sıradan internet kullanıcıları şaşırtıcı ve güçlü yeni YZ'yi (aynı zamanda açık kaynak kodlu) keşfetti ve akademik uzmanlar "yetişmeliyiz" diye bağırdı. Ayrıca denizaşırı YZ şirketlerinin şimdiden büyük bir tehditle karşı karşıya olduğuna dair söylentiler de var.

Sadece bu hafta yayınlanan DeepSeek R1'yi ele alalım. Herhangi bir denetimli eğitim olmadan saf takviye öğrenme rotası şok edici. Geçen yıl Aralık ayında Deepseek-v3 tabanının geliştirilmesinden OpenAI o1 ile karşılaştırılabilir mevcut düşünme zinciri yeteneklerine kadar, bu bir zaman meselesi gibi görünüyor.

Ancak yapay zeka topluluğu teknik raporları okumak ve gerçek ölçümleri karşılaştırmakla meşgulken, insanların R1 hakkında hala şüpheleri var: bir dizi kıyaslamadan daha iyi performans göstermenin yanı sıra, gerçekten liderlik edebilir mi?

Kendi "fizik yasaları" simülasyonlarını oluşturabilir mi?

İnanmıyor musun? Büyük modelin langırtla oynamasına izin verelim mi?

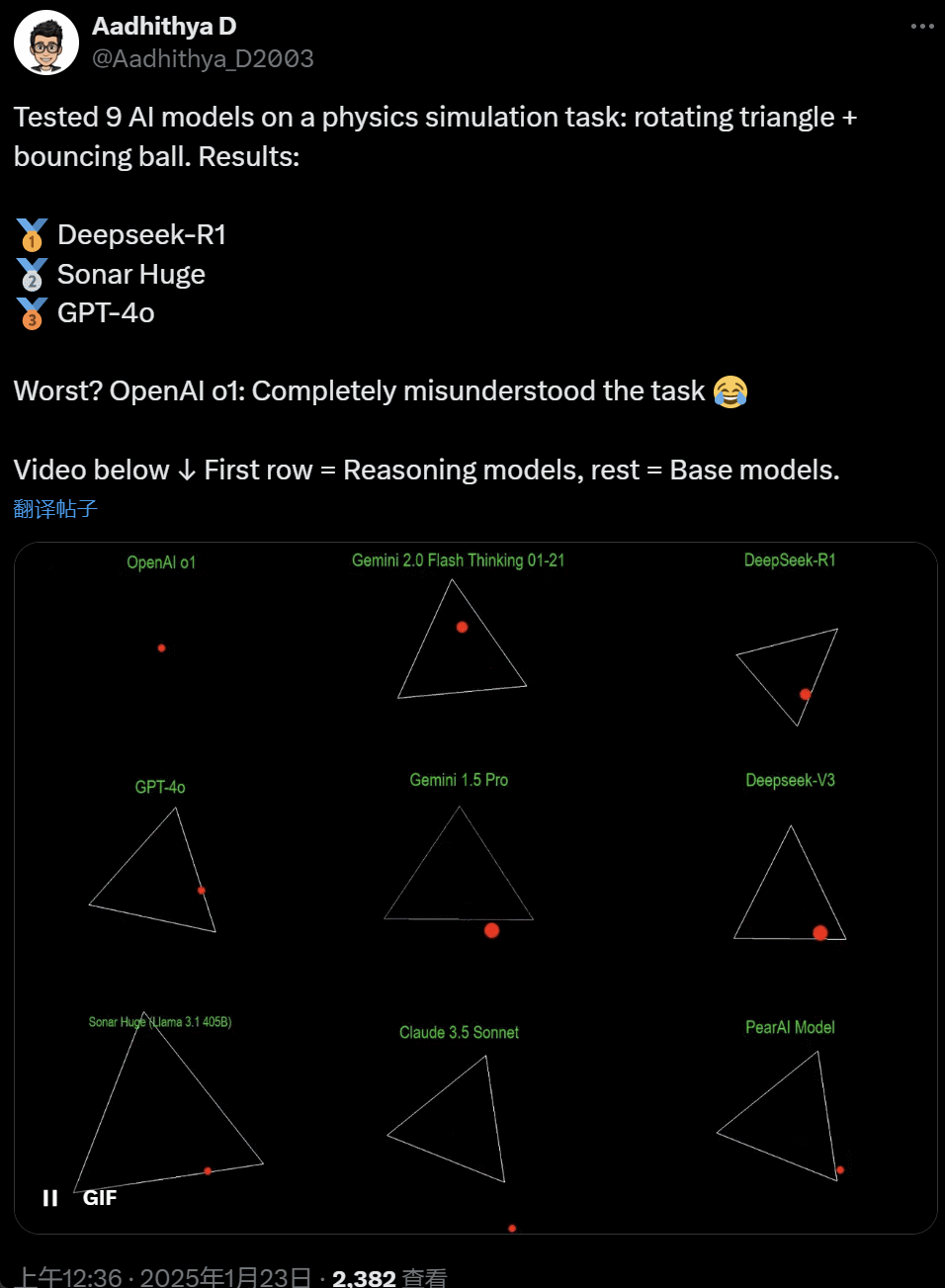

Son günlerde, YZ topluluğundaki bazı insanlar bir teste takıntılı hale geldi - bir sorunu çözmek için farklı YZ büyük modellerini (özellikle sözde akıl yürütme modellerini) test etmek: "Sarı bir topun belirli bir şeklin içinde zıplamasını sağlayacak bir Python betiği yazın. Şeklin yavaşça dönmesini sağlayın ve topun şeklin içinde kaldığından emin olun."

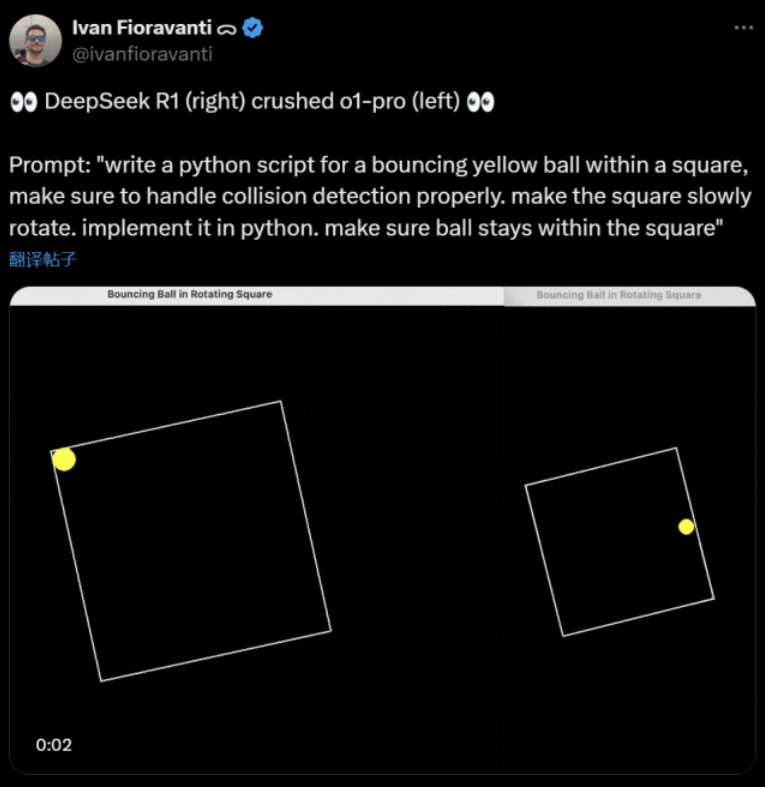

Bazı modeller bu "dönen top" kıyaslamasında diğerlerinden daha iyi performans gösteriyor. CoreView CTO'su Ivan Fioravanti'ye göre, yerli bir yapay zeka laboratuvarı olan DeepSeek, OpenAI'nin ChatGPT Pro programının bir parçası olarak aylık $200'e mal olan OpenAI'nin o1 pro modelini yenen açık kaynaklı büyük bir R1 modeline sahip.

Solda OpenAI o1 ve sağda DeepSeek R1. Yukarıda belirtildiği gibi, buradaki istem şudur: "bir kare içinde zıplayan sarı bir top için bir python betiği yazın, çarpışma algılamayı düzgün bir şekilde ele aldığınızdan emin olun. kareyi yavaşça döndürün. python'da uygulayın. topun kare içinde kaldığından emin olun."

X'teki bir başka kullanıcıya göre, Anthropic Claude 3.5 Sonnet ve Google'ın Gemini 1.5 Pro modelleri fiziksel ilkeler hakkında yanlış yargılarda bulunarak topun şeklinden sapmasına neden oldu. Bazı kullanıcılar da Google'ın en yeni Gemini 2.0 Flash Thinking Experimental ve nispeten daha eski OpenAI GPT-4o'nun değerlendirmeyi hemen geçtiğini bildirdi.

Ancak aradaki farkı anlamanın bir yolu var:

Bu tweetin altındaki netizenler şunları söyledi: o1'in yeteneği başlangıçta çok iyiydi, ancak OpenAI hızı optimize ettikten sonra, $200 / ay üyelik sürümüyle bile zayıfladı.

Zıplayan bir topu simüle etmek klasik bir programlama zorluğudur. Doğru simülasyon, iki nesnenin (top ve bir şeklin kenarı gibi) ne zaman çarpıştığını belirlemesi gereken çarpışma algılama algoritmalarını birleştirir. Yanlış yazılmış bir algoritma simülasyonun performansını etkileyebilir veya bariz fiziksel hatalara neden olabilir.

Yapay zeka girişimi Nous Research'te araştırmacı olan N8 Programs, dönen bir yedigen içinde zıplayan bir topu sıfırdan yazmanın yaklaşık iki saatini aldığını söyledi. "Birden fazla koordinat sistemi takip edilmeli, her bir sistemde çarpışmaların nasıl ele alındığının anlaşılması ve kodun sağlam olması için sıfırdan tasarlanması gerekiyor."

Zıplayan toplar ve dönen şekiller programlama becerileri için makul bir test olsa da, büyük modeller için hala yeni projelerdir ve istemlerdeki küçük değişiklikler bile farklı sonuçlar üretebilir. Bu nedenle, sonunda büyük yapay zeka modelleri için kıyaslama testinin bir parçası olacaksa, hala iyileştirilmesi gerekiyor.

Her halükarda, bu pratik test dalgasından sonra, büyük modeller arasındaki yetenek farklılıkları hakkında bir fikrimiz var.

DeepSeek yeni "Silikon Vadisi efsanesi

DeepSeek Pasifik'te paniğe neden oluyor".

Meta çalışanları "Meta mühendislerinin DeepSeek'yi çılgınca analiz ederek ondan kopyalayabilecekleri her şeyi kopyalamaya çalıştıklarını" bildirdiler.

Yapay zeka teknolojisi girişimi Scale AI'nin kurucusu Alexandr Wang da DeepSeek'nin yapay zeka büyük modelinin performansının kabaca ABD'deki en iyi modele eşdeğer olduğunu kamuoyuna açıkladı.

Ayrıca, Amerika Birleşik Devletleri'nin son on yılda yapay zeka rekabetinde Çin'in önünde yer almış olabileceğine, ancak DeepSeek'nin yapay zeka büyük modelini piyasaya sürmesinin "her şeyi değiştirebileceğine" inanıyor.

X Blogger @8teAPi, DeepSeek'nin bir "yan proje" değil, Lockheed Martin'in eski "Skunk Works "ü gibi olduğuna inanıyor.

"Skunk Works", Lockheed Martin'in başlangıçta birçok gelişmiş hava aracı geliştirmek için kurduğu, son teknoloji veya geleneksel olmayan teknoloji araştırma ve geliştirme faaliyetlerinde bulunan, son derece gizli, nispeten bağımsız küçük bir ekibi ifade eder. U-2 keşif uçağı ve SR-71 Blackbird'den F-22 Raptor ve F-35 Lightning II avcı uçağına kadar hepsi buradan çıkmıştır.

Daha sonra bu terim yavaş yavaş büyük şirketler veya kuruluşlar bünyesinde kurulan "küçük ama iyi", nispeten bağımsız ve daha esnek inovasyon ekiplerini tanımlamak için kullanılan genel bir terime dönüşmüştür.

İki neden gösterdi:

- Bir yandan, DeepSeek'nin 10.000'den fazla olduğu bildirilen çok sayıda GPU'ya sahip olduğu ve hatta Scale AI CEO'su Alexandr Wang'ın 50.000'e ulaşabileceğini söylediği bildirildi.

- Öte yandan, DeepSeek yalnızca Çin'deki en iyi üç üniversiteden yetenekleri işe alıyor; bu da DeepSeek'nin Alibaba ve Tencent kadar rekabetçi olduğu anlamına geliyor.

Sadece bu iki olgu bile DeepSeek'nin açıkça ticari başarı elde ettiğini ve bu kaynakları elde edecek kadar iyi tanındığını göstermektedir.

DeepSeek'nin geliştirme maliyetlerine gelince, blog yazarı Çinli teknoloji şirketlerinin düşük elektrik maliyetleri ve arazi kullanımı gibi çeşitli sübvansiyonlar alabildiğini söyledi.

Bu nedenle, DeepSeek'nin maliyetlerinin çoğunun ana faaliyet alanı dışındaki bir hesaba veya bir tür veri merkezi inşaatı sübvansiyonu şeklinde "yerleştirilmiş" olması çok muhtemeldir.

Kurucular dışında bile hiç kimse tüm finansal düzenlemeleri tam olarak anlayamaz. Bazı anlaşmalar sadece itibara dayalı olarak sonuçlandırılan "sözlü anlaşmalar" olabilir.

Ne olursa olsun, birkaç şey açık:

- Model mükemmel, OpenAI tarafından iki ay önce yayınlanan versiyonla karşılaştırılabilir ve elbette OpenAI ve Anthropic'in henüz yayınlamadığı yeni modeller kadar iyi olmaması mümkün.

- Mevcut perspektiften bakıldığında, araştırma yönü hala Amerikan şirketleri tarafından domine edilmektedir. DeepSeek modeli, o1 versiyonunun "hızlı bir takibi", ancak DeepSeek'nin araştırma ve geliştirme ilerlemesi çok hızlı, beklenenden daha hızlı yetişiyor. İntihal ya da hile yapmıyorlar, en fazla tersine mühendislik yapıyorlar.

- DeepSeek, yetenek havuzunu büyük ölçüde genişleten Amerikan eğitimli doktoralara güvenmek yerine, esas olarak kendi yeteneklerini eğitiyor.

- ABD'li şirketlerle karşılaştırıldığında, DeepSeek fikri mülkiyet lisansı, gizlilik, güvenlik, politika vb. açısından daha az kısıtlamaya tabidir ve insanların eğitilmek istemediği verilerin yanlış kullanımı konusunda daha az endişe vardır. Daha az dava, daha az avukat ve daha az endişe vardır.

Hiç şüphe yok ki, 2025'in belirleyici bir yıl olacağına inananların sayısı her geçen gün artıyor. Bu arada şirketler de buna hazırlanıyor. Örneğin Meta, 2025 yılına kadar tahmini $60-65 milyar yatırımla 2GW+ veri merkezi inşa ediyor ve yıl sonuna kadar 1,3 milyondan fazla GPU'ya sahip olacak.

Meta, 2 gigawatt'lık veri merkezini New York Manhattan ile karşılaştırmak için bir grafik bile kullandı.

Ancak şimdi DeepSeek daha düşük maliyet ve daha az GPU ile daha iyisini yaptı. Bu insanları nasıl endişelendirmez?

Yann LeCun: CTO'suna ve kurucu ortağına teşekkür etmeliyiz ve açık kaynak

Hiperbolik, Yuchen Jin, sadece 4 gün içinde DeepSeek-R1'in bize 4 gerçeği kanıtladığını yayınladığı için:

- Açık kaynak yapay zeka, kapalı kaynak yapay zekanın yalnızca 6 ay gerisinde

- Çin açık kaynak yapay zeka yarışını domine ediyor

- Büyük dil modeli takviyeli öğrenmenin altın çağına giriyoruz

- Damıtma modelleri çok güçlüdür ve cep telefonlarında son derece akıllı yapay zeka çalıştıracağız

OpenAI o3-mini'nin ücretsiz olarak kullanıma sunulması, toplulukta AGI/ASI hakkındaki belirsiz tartışmaların azaltılması umudu ve Meta'nın panik içinde olduğu söylentisi gibi DeepSeek tarafından tetiklenen zincirleme reaksiyon hala devam ediyor.

Nihayetinde kimin kazanacağını tahmin etmenin zor olduğuna inanıyor, ancak geç kalanın avantajının gücünü unutmamalıyız. Sonuçta hepimiz biliyoruz ki Transformer'ı icat eden Google'dı, OpenAI ise onun gerçek potansiyelini ortaya çıkardı.

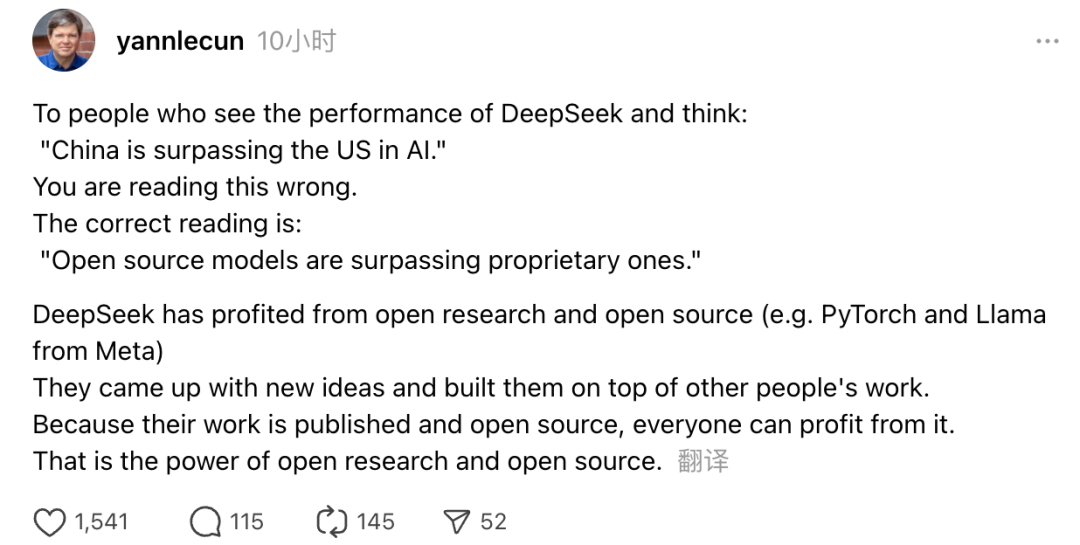

Ayrıca Turing Ödülü sahibi ve Meta'nın Baş Yapay Zeka Bilimcisi Yann LeCun da görüşlerini dile getirdi.

"DeepSeek'nin performansını gördükten sonra 'Çin yapay zekâda ABD'yi geride bırakıyor' diye düşünenler yanılıyor. Doğru anlayış, açık kaynak modellerinin tescilli modelleri geride bıraktığıdır."

LeCun, DeepSeek'nin bu kadar büyük bir sıçrama yapmasının nedeninin açık araştırma ve açık kaynaktan (Meta'nın PyTorch ve Llama'sı gibi) faydalanmaları olduğunu söyledi. DeepSeek yeni fikirler ortaya attı ve başkalarının çalışmaları üzerine inşa etti. Çalışmaları kamuya açık ve açık kaynak kodlu olduğu için herkes bundan faydalanabilir. Bu, açık araştırmanın ve açık kaynağın gücüdür.

Netizenlerin düşünceleri devam ediyor. Yeni teknolojilerin gelişmesinden heyecan duyarken, biraz da endişe havası hissedebiliyorlar. Ne de olsa DeepSeekers'ın ortaya çıkışının gerçek bir etkisi olabilir.