Không ai trong chúng ta ngờ rằng năm 2025 sẽ bắt đầu theo cách này trong lĩnh vực AI.

DeepSeek R1 thật sự tuyệt vời!

Gần đây, “thế lực bí ẩn phương Đông” DeepSeek đã “kiểm soát chặt chẽ” Thung lũng Silicon.

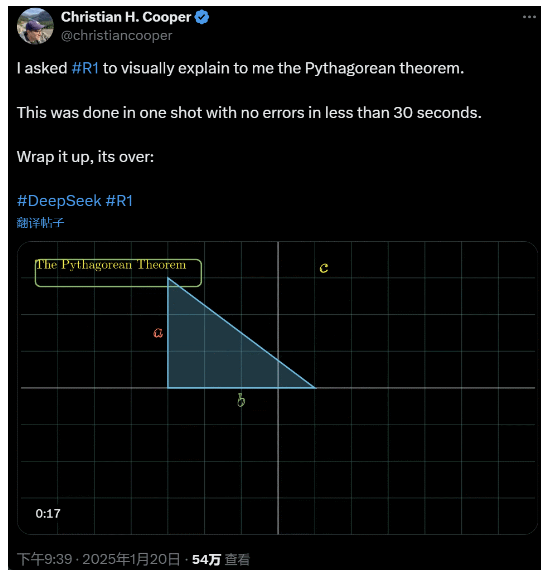

Tôi yêu cầu R1 giải thích chi tiết về định lý Pythagore. Tất cả những điều này được AI thực hiện trong vòng chưa đầy 30 giây mà không có bất kỳ lỗi nào. Tóm lại, mọi chuyện đã kết thúc.

Trong giới AI trong và ngoài nước, cư dân mạng bình thường đã phát hiện ra AI mới tuyệt vời và mạnh mẽ (cũng là mã nguồn mở), và các chuyên gia học thuật đã hét lên "chúng ta phải bắt kịp". Cũng có tin đồn rằng các công ty AI ở nước ngoài đã phải đối mặt với một mối đe dọa lớn.

Chỉ cần lấy DeepSeek R1 được phát hành tuần này. Lộ trình học tăng cường thuần túy của nó mà không có bất kỳ quá trình đào tạo có giám sát nào thật đáng kinh ngạc. Từ sự phát triển của cơ sở Deepseek-v3 vào tháng 12 năm ngoái đến khả năng của chuỗi suy nghĩ hiện tại có thể so sánh với OpenAI o1, có vẻ như chỉ là vấn đề thời gian.

Nhưng trong khi cộng đồng AI đang bận rộn đọc các báo cáo kỹ thuật và so sánh các phép đo thực tế, mọi người vẫn còn nghi ngờ về R1: ngoài khả năng vượt trội hơn một loạt các chuẩn mực, liệu nó có thực sự dẫn đầu không?

Liệu nó có thể xây dựng được mô phỏng riêng về “các định luật vật lý” không?

Bạn không tin ư? Hãy để người mẫu lớn chơi trò pinball nhé?

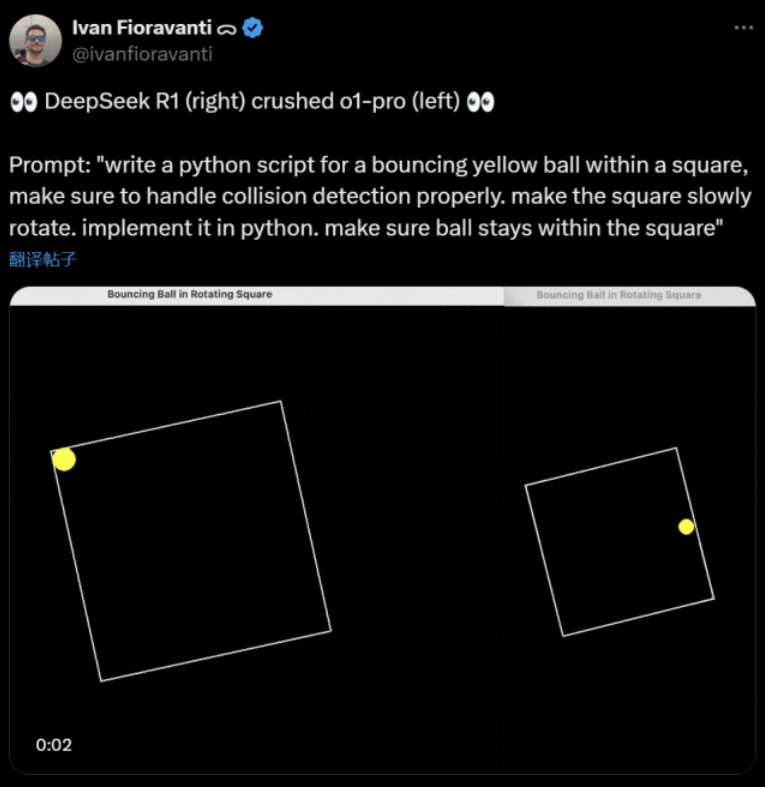

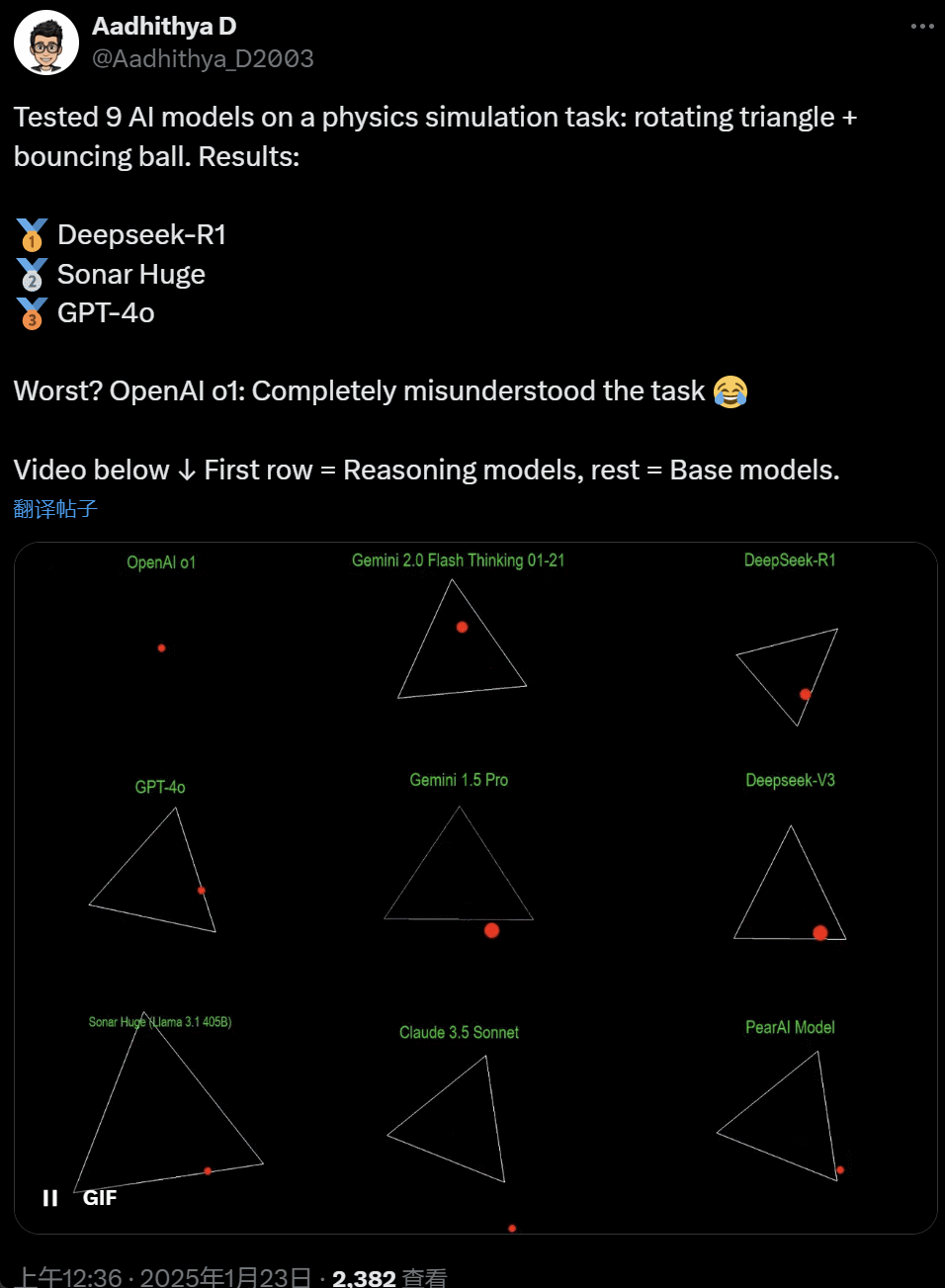

Trong những ngày gần đây, một số người trong cộng đồng AI đã trở nên ám ảnh với một bài kiểm tra – kiểm tra các mô hình AI lớn khác nhau (đặc biệt là các mô hình lý luận được gọi như vậy) để giải quyết một vấn đề: “Viết một tập lệnh Python để làm cho một quả bóng màu vàng nảy bên trong một hình dạng nhất định. Làm cho hình dạng quay chậm và đảm bảo quả bóng nằm bên trong hình dạng đó.”

Một số mô hình vượt trội hơn những mô hình khác trong chuẩn mực "quả bóng xoay" này. Theo Ivan Fioravanti, CTO của CoreView, DeepSeek, một phòng thí nghiệm trí tuệ nhân tạo trong nước, có một mô hình lớn nguồn mở R1 đánh bại mô hình o1 pro của OpenAI, có giá $200 mỗi tháng theo chương trình ChatGPT Pro của OpenAI.

Bên trái là OpenAI o1, và bên phải là DeepSeek R1. Như đã đề cập ở trên, lời nhắc ở đây là: "viết một tập lệnh python cho một quả bóng màu vàng nảy trong một hình vuông, hãy đảm bảo xử lý phát hiện va chạm đúng cách. làm cho hình vuông quay chậm. triển khai nó trong python. đảm bảo quả bóng nằm trong hình vuông."

Theo một người dùng khác trên X, Anthropic Claude 3.5 Sonnet và các mô hình Gemini 1.5 Pro của Google đã đưa ra những phán đoán không chính xác về các nguyên lý vật lý, khiến quả bóng lệch khỏi hình dạng của nó. Một số người dùng cũng báo cáo rằng Gemini 2.0 Flash Thinking Experimental mới nhất của Google, cũng như OpenAI GPT-4o tương đối cũ hơn, đã vượt qua đánh giá ngay lập tức.

Nhưng có một cách để phân biệt sự khác nhau ở đây:

Cư dân mạng bên dưới dòng tweet này cho biết: Khả năng của o1 ban đầu rất tốt, nhưng nó trở nên yếu hơn sau khi OpenAI tối ưu hóa tốc độ, ngay cả với phiên bản thành viên $200/tháng.

Mô phỏng một quả bóng nảy là một thách thức lập trình cổ điển. Mô phỏng chính xác kết hợp các thuật toán phát hiện va chạm, cần xác định thời điểm hai vật thể (như quả bóng và cạnh của hình dạng) va chạm. Một thuật toán được viết không đúng cách có thể ảnh hưởng đến hiệu suất của mô phỏng hoặc gây ra các lỗi vật lý rõ ràng.

N8 Programs, một nhà nghiên cứu tại công ty khởi nghiệp AI Nous Research, cho biết anh mất khoảng hai giờ để viết một quả bóng nảy trong một hình bảy cạnh xoay từ đầu. "Nhiều hệ tọa độ phải được theo dõi, cần hiểu cách xử lý va chạm trong từng hệ thống và mã phải được thiết kế từ đầu để mạnh mẽ."

Mặc dù bóng nảy và hình dạng quay là một bài kiểm tra hợp lý về kỹ năng lập trình, chúng vẫn là những dự án mới cho các mô hình lớn và ngay cả những thay đổi nhỏ trong lời nhắc cũng có thể tạo ra kết quả khác nhau. Vì vậy, nếu cuối cùng nó trở thành một phần của bài kiểm tra chuẩn cho các mô hình AI lớn, nó vẫn cần được cải thiện.

Trong mọi trường hợp, sau làn sóng thử nghiệm thực tế này, chúng ta có thể cảm nhận được sự khác biệt về khả năng giữa các mô hình lớn.

DeepSeek là “huyền thoại Thung lũng Silicon” mới

DeepSeek đang gây ra sự hoảng loạn” trên khắp Thái Bình Dương.

Các nhân viên của Meta đã đăng rằng "Các kỹ sư của Meta đang điên cuồng phân tích DeepSeek để cố gắng sao chép bất cứ thứ gì họ có thể từ nó."

Alexandr Wang, nhà sáng lập công ty khởi nghiệp công nghệ AI Scale AI, cũng tuyên bố công khai rằng hiệu suất của mô hình AI lớn DeepSeek gần tương đương với mô hình tốt nhất tại Hoa Kỳ.

Ông cũng tin rằng Hoa Kỳ có thể đã đi trước Trung Quốc trong cuộc cạnh tranh về AI trong thập kỷ qua, nhưng việc DeepSeek phát hành mô hình AI lớn có thể "thay đổi mọi thứ".

Blogger @8teAPi tin rằng DeepSeek không phải là một “dự án phụ” mà giống như “Skunk Works” trước đây của Lockheed Martin.

Cái gọi là “Skunk Works” ám chỉ một nhóm nhỏ tương đối độc lập, cực kỳ bí mật mà Lockheed Martin ban đầu thành lập để phát triển nhiều máy bay tiên tiến, tham gia vào nghiên cứu và phát triển công nghệ tiên tiến hoặc không theo quy ước. Từ máy bay trinh sát U-2 và SR-71 Blackbird đến máy bay chiến đấu F-22 Raptor và F-35 Lightning II, tất cả đều đến từ đây.

Sau đó, thuật ngữ này dần dần phát triển thành một thuật ngữ chung được dùng để mô tả các nhóm đổi mới “nhỏ nhưng tốt”, tương đối độc lập và linh hoạt hơn được thành lập trong các công ty hoặc tổ chức lớn.

Ông đưa ra hai lý do:

- Một mặt, DeepSeek có số lượng GPU rất lớn, được cho là hơn 10.000, và Alexandr Wang, CEO của Scale AI, thậm chí còn cho biết con số này có thể đạt tới 50.000.

- Mặt khác, DeepSeek chỉ tuyển dụng nhân tài từ ba trường đại học hàng đầu Trung Quốc, điều đó có nghĩa là DeepSeek có khả năng cạnh tranh ngang bằng với Alibaba và Tencent.

Chỉ riêng hai sự kiện này đã cho thấy DeepSeek rõ ràng đã đạt được thành công về mặt thương mại và đủ nổi tiếng để có được những nguồn tài nguyên này.

Về chi phí phát triển DeepSeek, blogger này cho biết các công ty công nghệ Trung Quốc có thể nhận được nhiều khoản trợ cấp khác nhau, chẳng hạn như chi phí điện thấp và sử dụng đất thấp.

Do đó, rất có thể phần lớn chi phí của DeepSeek đã được “chuyển” vào một tài khoản bên ngoài hoạt động kinh doanh cốt lõi hoặc dưới hình thức trợ cấp xây dựng trung tâm dữ liệu nào đó.

Ngay cả ngoài những người sáng lập, không ai hiểu đầy đủ về tất cả các thỏa thuận tài chính. Một số thỏa thuận có thể chỉ là "thỏa thuận bằng lời nói" được hoàn thiện chỉ dựa trên danh tiếng.

Dù sao đi nữa, có một vài điều rõ ràng:

- Mô hình này rất tuyệt vời, có thể so sánh với phiên bản được OpenAI phát hành cách đây hai tháng, và tất nhiên có thể không tốt bằng các mô hình mới mà OpenAI và Anthropic vẫn chưa phát hành.

- Theo góc nhìn hiện tại, hướng nghiên cứu vẫn do các công ty Mỹ thống trị. Mô hình DeepSeek là “phiên bản tiếp theo nhanh” của phiên bản o1, nhưng tiến độ nghiên cứu và phát triển của DeepSeek rất nhanh, bắt kịp nhanh hơn dự kiến. Họ không đạo văn hay gian lận, nhiều nhất là kỹ thuật đảo ngược.

- DeepSeek chủ yếu đào tạo nhân tài của mình, thay vì dựa vào các tiến sĩ được đào tạo tại Mỹ, điều này giúp mở rộng đáng kể nguồn nhân tài.

- So với các công ty Hoa Kỳ, DeepSeek ít bị ràng buộc hơn về mặt cấp phép sở hữu trí tuệ, quyền riêng tư, bảo mật, chính trị, v.v. và ít lo ngại hơn về việc sử dụng dữ liệu sai trái mà mọi người không muốn được đào tạo. Ít vụ kiện tụng hơn, ít luật sư hơn và ít lo ngại hơn.

Không còn nghi ngờ gì nữa, ngày càng nhiều người tin rằng năm 2025 sẽ là năm quyết định. Trong khi đó, các công ty đang chuẩn bị cho năm đó. Ví dụ, Meta đang xây dựng một trung tâm dữ liệu 2GW+, với khoản đầu tư ước tính là $60-65 tỷ vào năm 2025 và sẽ có hơn 1,3 triệu GPU vào cuối năm.

Meta thậm chí còn sử dụng một biểu đồ để so sánh trung tâm dữ liệu 2 gigawatt của mình với Manhattan, New York.

Nhưng hiện tại DeepSeek đã làm tốt hơn với chi phí thấp hơn và ít GPU hơn. Làm sao điều này không khiến mọi người lo lắng?

Yann LeCun: Chúng tôi phải cảm ơn CTO và đồng sáng lập của cái mã nguồn mở

Thật tuyệt vời, Yuchen Jin, đã đăng rằng chỉ trong 4 ngày, DeepSeek-R1 đã chứng minh cho chúng ta 4 sự thật:

- AI nguồn mở chỉ chậm hơn AI nguồn đóng 6 tháng

- Trung Quốc đang thống trị cuộc cạnh tranh AI nguồn mở

- Chúng ta đang bước vào thời kỳ hoàng kim của việc học tăng cường mô hình ngôn ngữ lớn

- Các mô hình chưng cất rất mạnh mẽ và chúng tôi sẽ chạy AI thông minh cao trên điện thoại di động

Phản ứng dây chuyền do DeepSeek gây ra vẫn đang tiếp diễn, chẳng hạn như OpenAI o3-mini được cung cấp miễn phí, hy vọng trong cộng đồng sẽ giảm bớt những cuộc thảo luận mơ hồ về AGI/ASI và tin đồn rằng Meta đang hoảng loạn.

Ông tin rằng rất khó để dự đoán ai sẽ chiến thắng cuối cùng, nhưng chúng ta không nên quên sức mạnh của lợi thế của người đến sau. Rốt cuộc, chúng ta đều biết rằng chính Google đã phát minh ra Transformer, trong khi OpenAI đã giải phóng tiềm năng thực sự của nó.

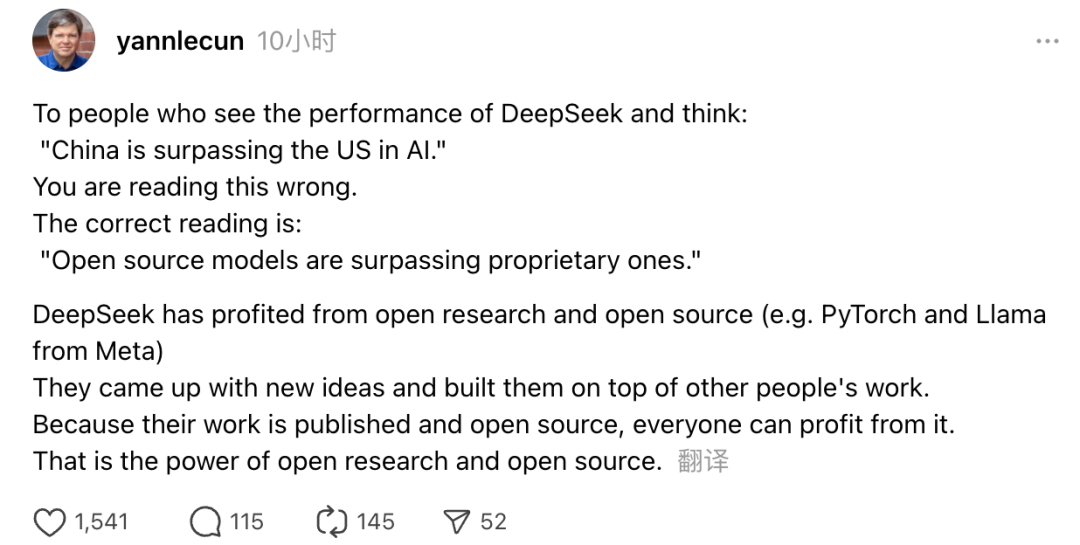

Ngoài ra, người đoạt giải Turing và là Nhà khoa học AI trưởng của Meta, Yann LeCun cũng đã bày tỏ quan điểm của mình.

“Đối với những ai khi thấy hiệu suất của DeepSeek mà nghĩ rằng 'Trung Quốc đang vượt qua Hoa Kỳ về AI' thì bạn đã nhầm. Hiểu đúng là các mô hình nguồn mở đang vượt qua các mô hình độc quyền.”

LeCun cho biết lý do DeepSeek tạo nên tiếng vang như vậy lần này là vì họ đã được hưởng lợi từ nghiên cứu mở và nguồn mở (như PyTorch và Llama của Meta). DeepSeek đã đưa ra những ý tưởng mới và xây dựng dựa trên công trình của những người khác. Vì công trình của họ được phát hành công khai và nguồn mở nên mọi người đều có thể hưởng lợi từ nó. Đây chính là sức mạnh của nghiên cứu mở và nguồn mở.

Những suy ngẫm của cư dân mạng vẫn tiếp tục. Trong khi họ phấn khích về sự phát triển của công nghệ mới, họ cũng có thể cảm thấy một chút không khí lo lắng. Rốt cuộc, sự xuất hiện của DeepSeekers có thể có tác động thực sự.