DeepSeek-R1 和DeepSeek-V3自開源發布以來就引起了全球轟動。

它們是 DeepSeek 團隊贈送全人類的禮物,我們為他們的成功感到由衷的高興。

經過Silicon Motility和華為雲端團隊連日的努力,今天我們也為中國用戶送上了一份農曆新年禮物: 大型模型雲端服務平台SiliconCloud推出了基於華為雲端Ascend雲端服務的DeepSeek-V3、DeepSeek-R1。

需要強調的是,無論是在DeepSeek-R1&V3在Ascend上的適配,還是此前其他型號的上線過程中,我們都得到了DeepSeek和華為雲的大力支持,對此我們深表感謝並致以崇高的敬意。

特徵

SiliconCloud推出的這兩款機型主要包含五個功能:

基於華為雲端Ascend雲端服務,我們推出了 DeepSeek x Silicon Mobility x 華為雲端首次推出R1&V3模型推理服務。

透過雙方聯合創新,在自研推理加速引擎的支援下,Silicon Mobility團隊基於華為雲端Ascend雲端服務部署的DeepSeek模型可以達到與高階GPU部署模型同等的效果在世界上。

提供穩定的生產級DeepSeek-R1 & V3推理服務。這使得開發人員能夠在大規模生產環境中穩定運行,並滿足商業部署的需求。華為雲端Ascend AI服務提供充裕、彈性、充足的算力。

無任何部署門檻,讓開發者更專注於應用程式開發。在開發應用程式時,可以直接呼叫SiliconCloud API,提供更簡單、更人性化的體驗。

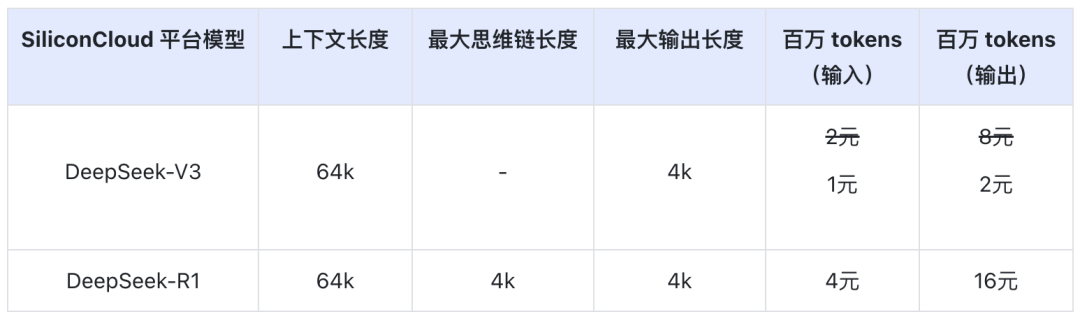

SiliconCloud 官方折扣期間(截止至 2 月 8 日 24:00)DeepSeek-V3 價格為 ¥1/M 代幣(輸入)& ¥2/M 代幣(輸出),DeepSeek-R1 價格為 ¥4/ M 個代幣(輸入)& ¥16 / M 個代幣(輸出)。

線上體驗

DeepSeek-R1 與 SiliconCloud

DeepSeek-V3 與 SiliconCloud

API 文件

開發者可以在SiliconCloud上體驗DeepSeek-R1&V3在國產晶片上加速的效果。更快的輸出速度仍在不斷優化中。

有客戶端應用經驗

如果您想在客戶端應用程式中直接體驗DeepSeek-R1 & V3模型,您可以本機安裝以下產品並存取SiliconCloud API(您可以自訂和新增這兩個模型)來體驗DeepSeek-R1 & V3。

- 大型模型客戶端應用程式: 聊天框, 櫻桃工作室, OneAPI、LobeChat、NextChat

- 程式碼生成應用程式: 游標, 風帆衝浪, 克萊恩

- 大模型應用開發平台:迪菲

- AI知識庫:黑曜石人工智慧, 和FastGPT

- 翻譯插件:沉浸式翻譯與 Eurodict

更多場景及應用程式案例接入教學請參考 這裡

代幣工廠 SiliconCloud

Qwen2.5(7B)等20+型號免費使用

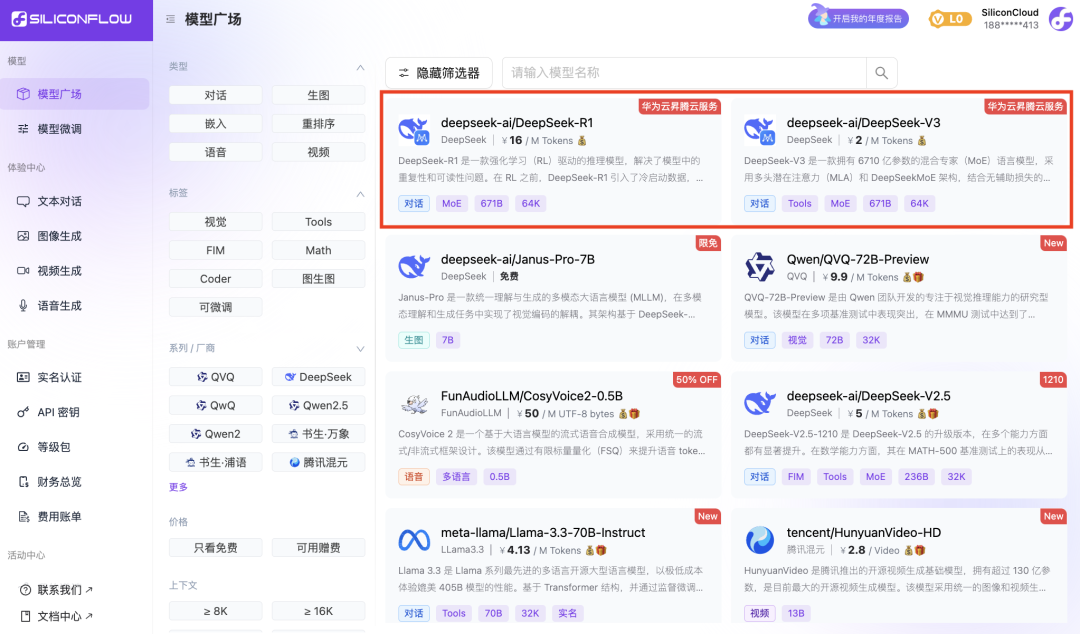

作為一站式大模型雲端服務平台,SiliconCloud致力於為開發者提供超快速響應、價格實惠、功能全面、體驗流暢的模型API。

除了DeepSeek-R1和DeepSeek-V3外,SiliconCloud還推出了Janus-Pro-7B、CosyVoice2、QVQ-72B-Preview、DeepSeek-VL2、DeepSeek-V2.5-1210、Llama-3.3-70VideoB-Instruct、Huuanuanny fish-speech-1.5、Qwen2.5 -7B/14B/32B/72B、FLUX.1、InternLM2.5-20B-聊天、BCE、BGE、SenseVoice-Small、GLM-4-9B-聊天、

數十個開源大型語言模型、圖像/視訊生成模型、語音模型、程式碼/數學模型以及向量和重新排序模型。

該平台允許開發人員自由比較和組合各種模態的大型模型,為您的生成式 AI 應用程式選擇最佳實踐。

其中Qwen2.5(7B)、Llama3.1(8B)等20+大模型API均可免費使用,讓開發者和產品經理實現“代幣自由”,無需擔心研究過程中的算力成本及發展階段和大規模推廣。