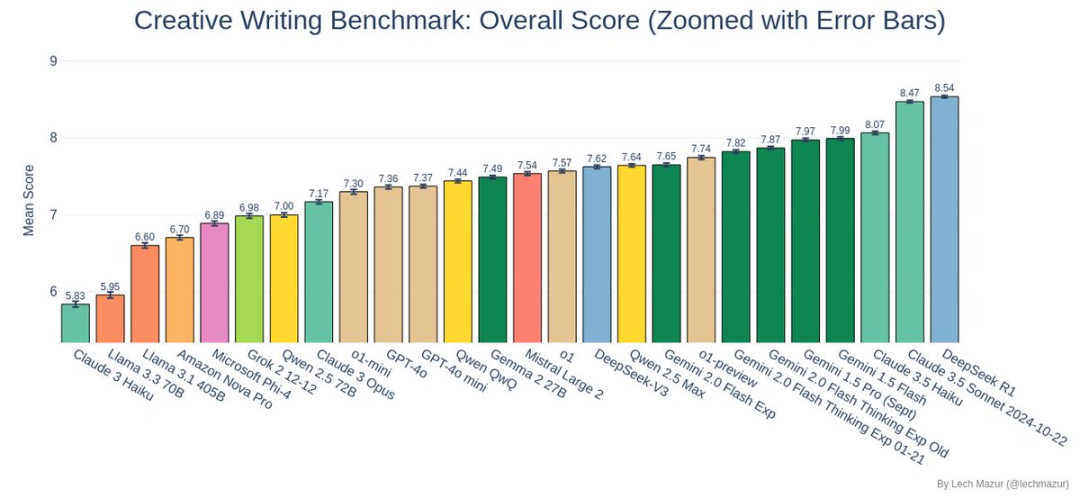

DeepSeek R1在創意短篇小說寫作基準測試中奪冠,成功超越上屆霸主Claude 3.5 Sonnet!

基準測試

研究員 Lech Mazur 設計的基準測試並不是一般的寫作比賽。

每個人工智慧模型都需要完成 500 個短篇故事,每個故事必須巧妙地融入 10 個隨機分配的元素。對於人工智慧來說,這是一項具有挑戰性的開放式寫作任務,它不僅需要完整的故事情節,還要確保所有分配的元素都能自然地融合在一起

評審方法

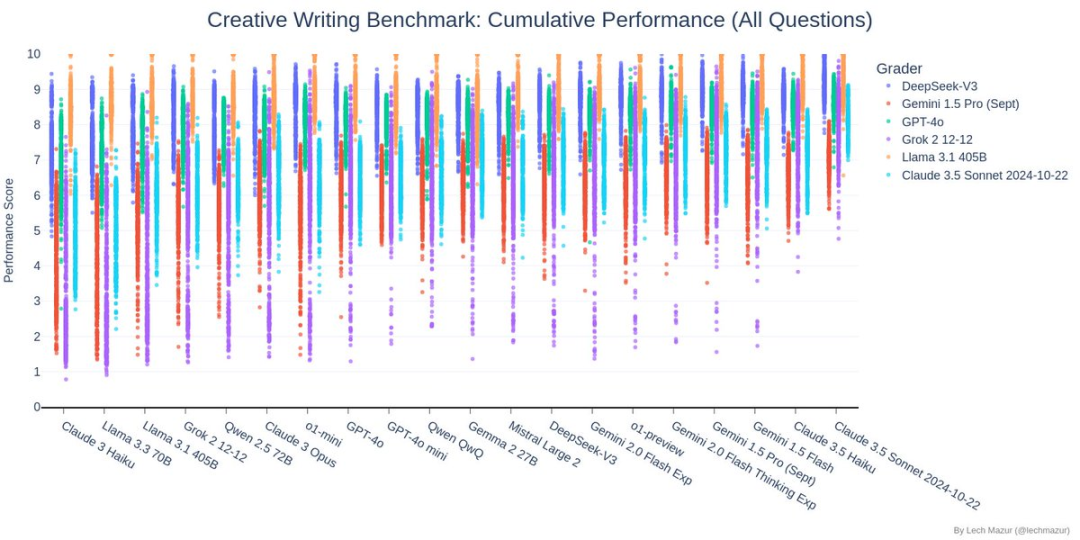

這項基準測試採用了獨特的評分系統:六種頂級語言模型充當評委,對故事的各個方面進行評分。也就是說,AI產業的領導者對AI本身進行評判,整體來說提供了一個相對公正、系統性的評價標準。

測試內容

上圖為創意寫作基準測驗中評分者的相關性分析。 DeepSeek 與其他主流模型(Claude、GPT-4o、Gemini 和Grok)的相關係數均超過0.93,說明其在評判創意寫作品質時與其他頂級模型的判斷標準高度一致,這也間接證實了其在這一領域的可靠性測試。

上圖顯示的是創意短篇小說寫作基準測驗的結果。每個人工智慧模型需要編寫500個故事,每個故事必須包含10個指定的隨機元素。圖表中的點展示了各參賽AI模型針對不同評分模型(以不同顏色表示)的分數分佈。

在測試中, 深的年代哎呀 (深藍色點)表現良好,其得分點大部分集中在圖表的上半部分,且相對集中,展現出穩定且較高的創意寫作能力水平。

如此出色的表現使得它成功超越上屆冠軍Claude 3.5 Sonnet,成為新的基準測試領導者。

在這個圖表中,每一行代表一個AI模型,每一列代表一個評價維度(例如人物塑造、情節連貫性等)。 DeepSeek位於圖表的中上位置,整體呈現橙黃色調,顯示其在大多數評測維度上都取得了優秀的成績。尤其是在執行(Q6)、人物塑造(TA)、情節發展(TJ)等關鍵維度上都取得了近8分的高分。雖然在個別維度上它可能不是最亮的黃色,但它並沒有任何明顯的弱點。

從圖表中可以看出,DeepSeek的故事得分大多分佈在7到9分之間,且分佈比較集中。有趣的是,它的趨勢線幾乎是水平的,說明DeepSeek的故事品質與故事的長度關係並不緊密。換句話說,無論是寫長篇小說還是短篇小說,DeepSeek 都能保持一致的高品質產出。這表明 DeepSeek在創作時更注重品質而不是數量,並能保持出色的性能 在不同長度的故事中。

為什麼 DeepSeek R1獲勝?

從測試結果來看,DeepSeek R1表現驚艷:

- 全面的故事整合能力:R1在處理不同故事元素組合時展現了驚人的靈活性和創造力。

- 穩定的輸出質量:從分數分佈圖來看,R1不僅平均分數較高,而且表現穩定,波動較小。

- 傑出的創意表現:在本次基準測試中,R1創作的故事總體排名進入前三名,證明了其出色的創意寫作能力。

其他選手錶現如何?

除了DeepSeek R1與Claude 3.5 Sonnet的精彩對決外,其他車款的表現也同樣值得關注:

- 雙子座系列表現優異

- Llama 3.x 系列在這個測試中表現有些掙扎

- o3-mini 表現不佳,排名第 22 位

最後

DeepSeek R1在這次測試中的突破,讓我們看到了AI在創造力領域的無限可能性。雖然AI創造還在不斷進步的道路上,但這樣的成果已經讓我們對未來充滿期待。

想要了解更多測試細節的人可以訪問 Lech Mazur 的 GitHub 以獲取完整數據和最佳故事範例。讓我們一起期待AI創意寫作的更多突破吧!