DeepSeek-R1 og DeepSeek-V3 har skabt en global sensation siden deres open source-lancering.

De er en gave fra DeepSeek-teamet til hele menneskeheden, og vi er oprigtigt glade for deres succes.

Efter flere dages hårdt arbejde fra Silicon Mobility- og Huawei Cloud-teamene giver vi i dag også kinesiske brugere en kinesisk nytårsgave: Den store model cloud service platform SiliconCloud har lanceret DeepSeek-V3 og DeepSeek-R1, som er baseret på Huawei Clouds Ascend cloud service.

Det skal understreges, at vi har modtaget stor støtte fra DeepSeek og Huawei Cloud, både i tilpasningen af DeepSeek-R1 & V3 på Ascend og i processen med at lancere andre modeller tidligere, og vi vil gerne udtrykke dyb taknemmelighed og høj respekt.

Funktioner

Disse to modeller, som SiliconCloud har lanceret, omfatter primært fem hovedfunktioner:

Baseret på Huawei Clouds Ascend-skytjeneste har vi lanceret DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 model inference service for første gang.

Gennem fælles innovation mellem de to parter og med støtte fra den selvudviklede inferensaccelerationsmotor kan DeepSeek-modellen, der er implementeret af Silicon Mobility-teamet baseret på Huawei Clouds Ascend-skytjeneste, opnå den samme effekt som en high-end GPU-distributionsmodel i verden.

Leverer stabile DeepSeek-R1- og V3-inferencetjenester på produktionsniveau. Dette giver udviklere mulighed for at køre stabilt i store produktionsmiljøer og imødekomme behovene for kommerciel implementering. Huawei Cloud Ascend AI-tjenester giver rigelig, elastisk og tilstrækkelig computerkraft.

Der er ingen implementeringstærskel, så udviklere kan fokusere mere på applikationsudvikling. Når de udvikler applikationer, kan de kalde SiliconCloud API'en direkte, hvilket giver en lettere og mere brugervenlig oplevelse.

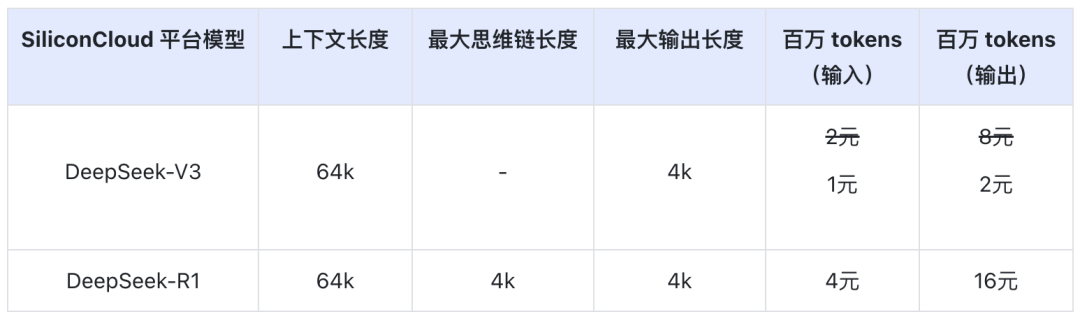

Prisen på DeepSeek-V3 på SiliconCloud i den officielle rabatperiode (indtil kl. 24.00 den 8. februar) er ¥1 / M tokens (input) & ¥2 / M tokens (output), og prisen på DeepSeek-R1 er ¥4 / M tokens (input) & ¥16 / M tokens (output).

Online-oplevelse

DeepSeek-R1 med SiliconCloud

DeepSeek-V3 med SiliconCloud

API-dokumentation

Udviklere kan opleve effekten af DeepSeek-R1 & V3 accelereret på indenlandske chips på SiliconCloud. Den hurtigere udgangshastighed optimeres stadig løbende.

Erfaring med klientapplikationer

Hvis du vil opleve DeepSeek-R1 & V3-modellen direkte i klientprogrammet, kan du installere følgende produkter lokalt og få adgang til SiliconCloud API (du kan tilpasse og tilføje disse to modeller) for at opleve DeepSeek-R1 & V3.

- Store modelklientapplikationer: Chatboks, Cherry Studio, OneAPI, LobeChat, NextChat

- Programmer til generering af kode: Markør, Windsurf, Cline

- Platform til udvikling af store modelapplikationer:Dify

- AI-videnbase:Obsidian AIogFastGPT

- Plug-in til oversættelse:Immersive Translate, ogEurodict

For flere vejledninger om adgang til scenarier og anvendelsestilfælde, se venligst her

Token Factory SiliconCloud

Qwen2.5 (7B) osv. 20+ modeller til fri afbenyttelse

Som en one-stop cloud-serviceplatform for store modeller er SiliconCloud forpligtet til at give udviklere model-API'er, der er ultra-responsive, overkommelige, omfattende og har en silkeblød oplevelse.

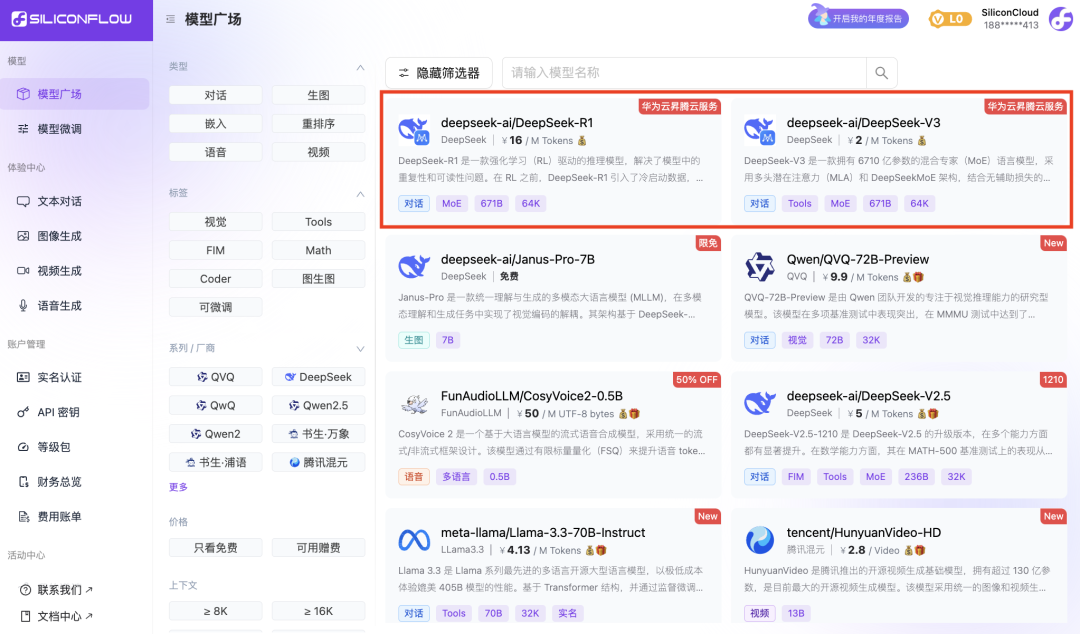

Ud over DeepSeek-R1 og DeepSeek-V3 har SiliconCloud også lanceret Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

dusinvis af store open source-sprogmodeller, billed-/videogenereringsmodeller, talemodeller, kode-/matmodeller og vektor- og omorganiseringsmodeller.

Platformen giver udviklere mulighed for frit at sammenligne og kombinere store modeller af forskellige modaliteter for at vælge den bedste praksis til din generative AI-applikation.

Blandt dem er 20+ store model-API'er som Qwen2.5 (7B) og Llama3.1 (8B) gratis at bruge, så udviklere og produktchefer kan opnå "token-frihed" uden at bekymre sig om omkostningerne ved computerkraft i forsknings- og udviklingsfasen og storstilet markedsføring.