OpenAI har udgivet sin seneste inferensmodel, o3-minisom er optimeret til områder som videnskab, matematik og programmering, og som giver hurtigere respons, større nøjagtighed og lavere omkostninger.

Sammenlignet med forgængeren o1-mini har o3-mini forbedret sine slutningsevner betydeligt, især når det gælder om at løse komplekse problemer. Testerne foretrækker o3-minis svar med 56%, og fejlprocenten er blevet reduceret med 39%. Fra i dag, ChatGPT Plus, Team og Pro brugere kan bruge o3-mini, og gratis brugere kan også opleve nogle af dens funktioner.

Sammenlignet med slutningsmodellen DeepSeek-R1hvor meget bedre er OpenAI o3-mini end R1?

Denne artikel vil først give et overblik over højdepunkterne i o3-mini, og derefter vil vi udtrække data fra begge sider på hvert benchmark og lave en graf for at sammenligne dem visuelt. Derudover vil vi også sammenligne prisen på o3-mini.

Centrale højdepunkter

1.STEM-optimering: udmærker sig inden for matematik, programmering, videnskab osv. og overgår især o1-mini i tilstanden med høj inferensindsats.

2.Udviklerens funktioner: understøtter funktioner som funktionskald, struktureret output og udviklerbeskeder for at opfylde behovene i produktionsmiljøet.

3.Hurtig respons: 24% hurtigere end o1-mini med en svartid på 7,7 sekunder pr. anmodning.

4.Forbedring af sikkerheden: sikrer et sikkert og pålideligt output ved hjælp af deep alignment-teknologi.

5.Omkostningseffektiv: Inferensfunktioner og omkostningsoptimering går hånd i hånd, hvilket i høj grad reducerer tærsklen for brug af AI.

Sammenlign

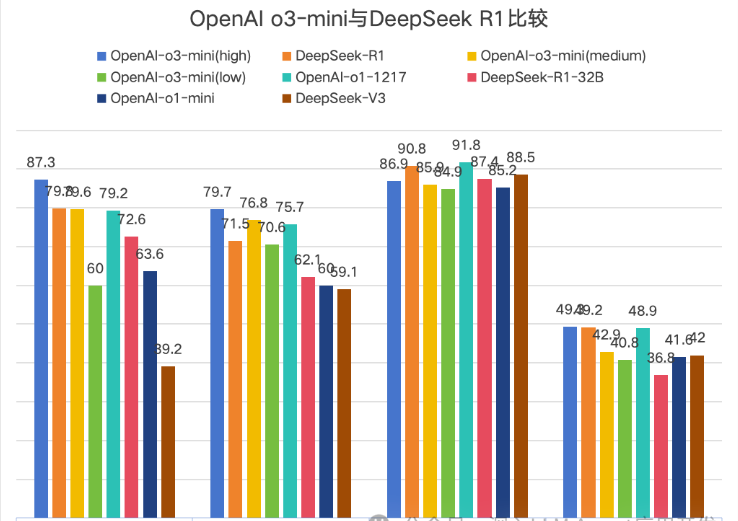

Åben AI For at fremhæve sin klasse, sin officiel blog sammenligner det kun med sine egne modeller. Derfor er denne artikel en tabel, der er hentet fra DeepSeek R1-papiret og data fra den officielle OpenAI-blog.

OpenAI sammenligner officielt o3-mini i versionslisten og opdeler den i tre versioner: lav, medium og høj, som angiver inferensstyrken. Da DeepSeek bruger Math-500, og OpenAI bruger Math-datasættet, er denne sammenligning blevet fjernet her.

Et diagram er mere intuitivt, og Codeforces er fjernet, fordi værdierne er for store til at blive vist intuitivt. Sammenligningen på Codeforces viser dog, at o3-minis høje inferensstyrke ikke er et stort forspring.

↑1AIME2024→2GPQA Diamond→3MMLU→4SWE-bench-Verified

I diagrammet er der i alt 4 sammenligninger, og O3-mini (høj) fører generelt, men forspringet er meget lille.

Pris

| model | Pris på input | Cache-hit | Produktionspris |

| o3-mini | $1.10 | $0.55 | $4.40 |

| o1 | $15.00 | $7.50 | $60.00 |

| Deepseek R1 | $0.55 | $0.14 | $2.19 |

Sammenfatning

Da DeepSeek R1 udløste DeepSeek-panikken i USA, var OpenAI den første til at føle sig truet, hvilket især er tydeligt i prissætningen af den nye model o3-mini.

Da Openai o1 først blev udgivet, lagde den høje pris pres på mange udviklere og brugere. Fremkomsten af DeepSeek R1 gav alle flere valgmuligheder.Fra den 30-dobbelte prisforskel mellem o1 og R1 til den endelige pris på o3-mini, der er dobbelt så høj. prisen på DeepSeek R1,

viser effekten af DeepSeek R1 på openai.ChatGPT-gratisbrugere kan dog kun opleve o3-mini på en begrænset måde, mens DeepSeek's Deep Thinking i øjeblikket er tilgængelig for alle brugere.Jeg ser også frem til, at openai bringer flere førende ai-modeller og samtidig reducerer brugernes omkostninger.

Ud fra en bloggers personlige erfaring med R1 vil jeg gerne sige, at R1's Deep Thinking altid åbner mit sind. Jeg anbefaler, at alle bruger den mere til at tænke over problemer~