Die Geschichte von Geminich 2.0 beschleunigt sich.

Die experimentelle Version von Flash Thinking brachte Entwicklern im Dezember ein funktionierendes Modell mit geringer Latenz und hoher Leistung.

Anfang des Jahres wurde 2.0 Flash Thinking Experimental im Google AI Studio aktualisiert, um die Leistung weiter zu verbessern, indem die Geschwindigkeit von Flash mit erweiterten Inferenzfunktionen kombiniert wurde.

Letzte Woche wurde die aktualisierte Version 2.0 Flash vollständig auf den Desktop- und Mobil-Apps von Gemini eingeführt.

Heute wurden drei neue Mitglieder gleichzeitig vorgestellt: die experimentelle Version von Gemini 2.0 Pro, die bisher beim Codieren und bei komplexen Eingabeaufforderungen die beste Leistung erbrachte, das kostengünstige 2.0 Flash-Lite und die zum Denken optimierte Version 2.0 Flash Thinking.

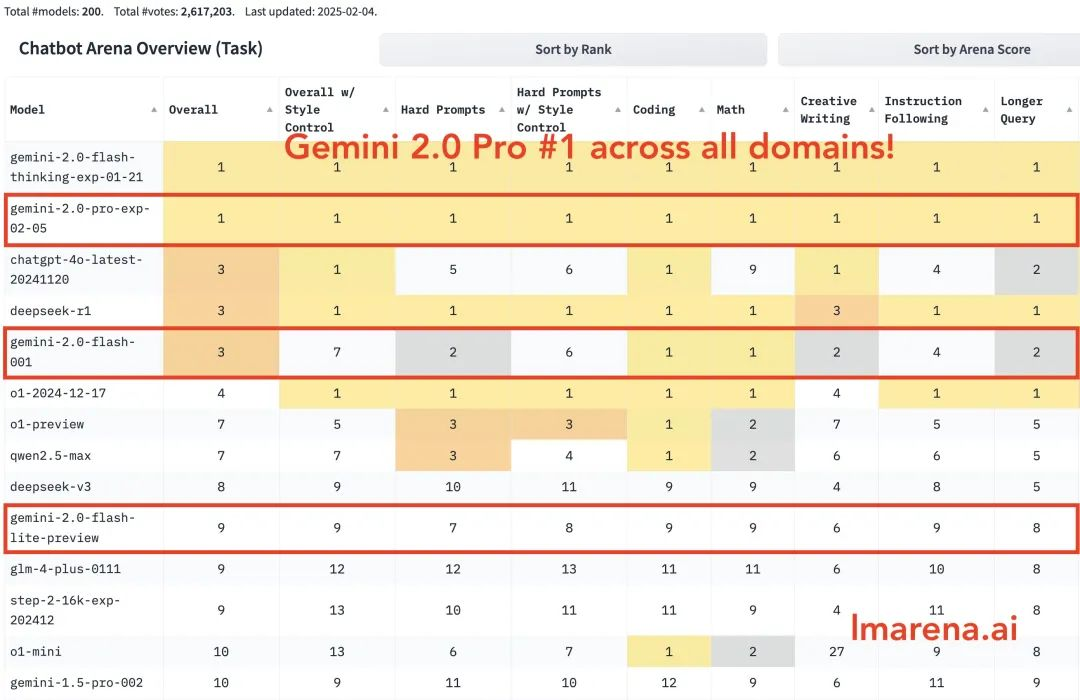

Gemini 2.0 Pro belegt in allen Kategorien den ersten Platz. Gemini-2.0-Flash belegt in den Kategorien Codierung, Mathematik und Rätsel die ersten drei Plätze. Flash-lite belegt in allen Kategorien die ersten zehn Plätze.

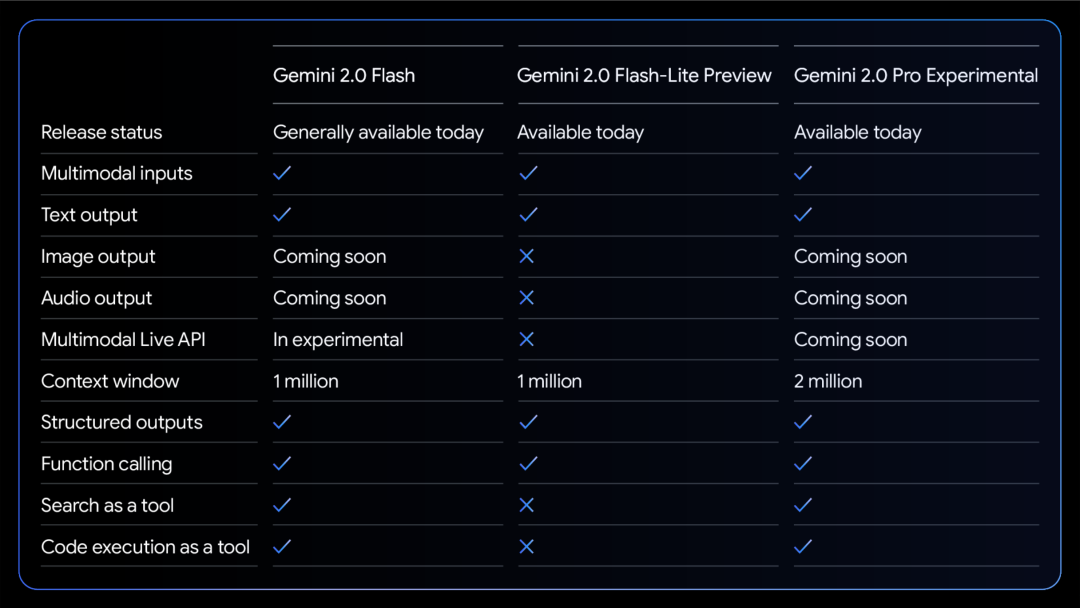

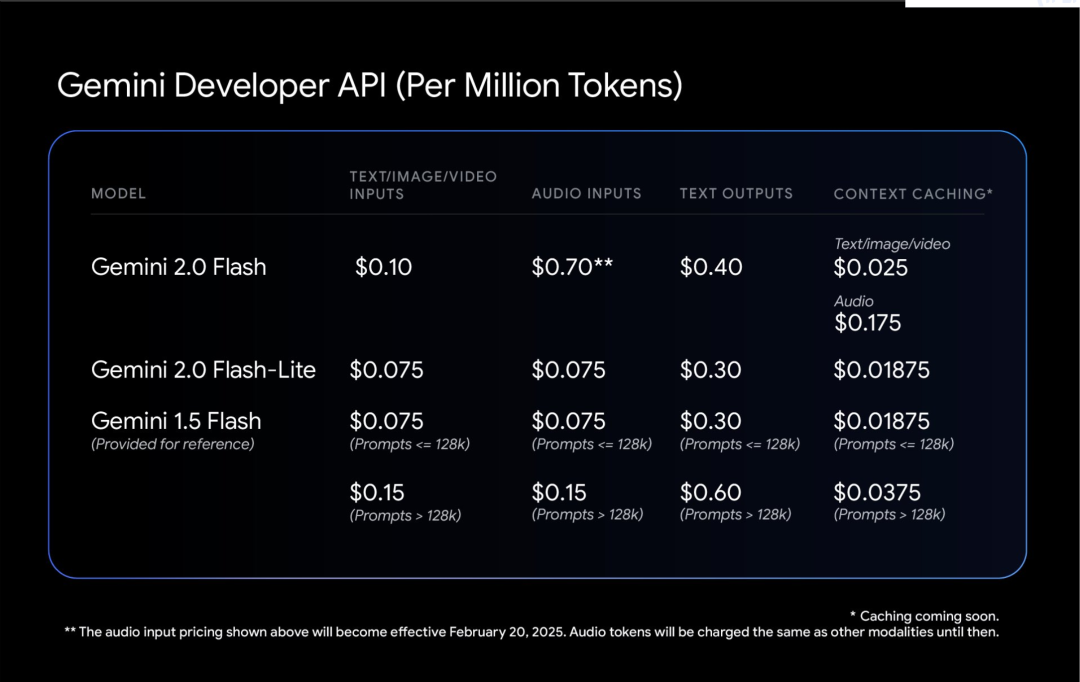

Eine Vergleichstabelle der Fähigkeiten der drei Modelle:

Alle Modelle unterstützen multimodalen Eingabe- und Ausgabetext.

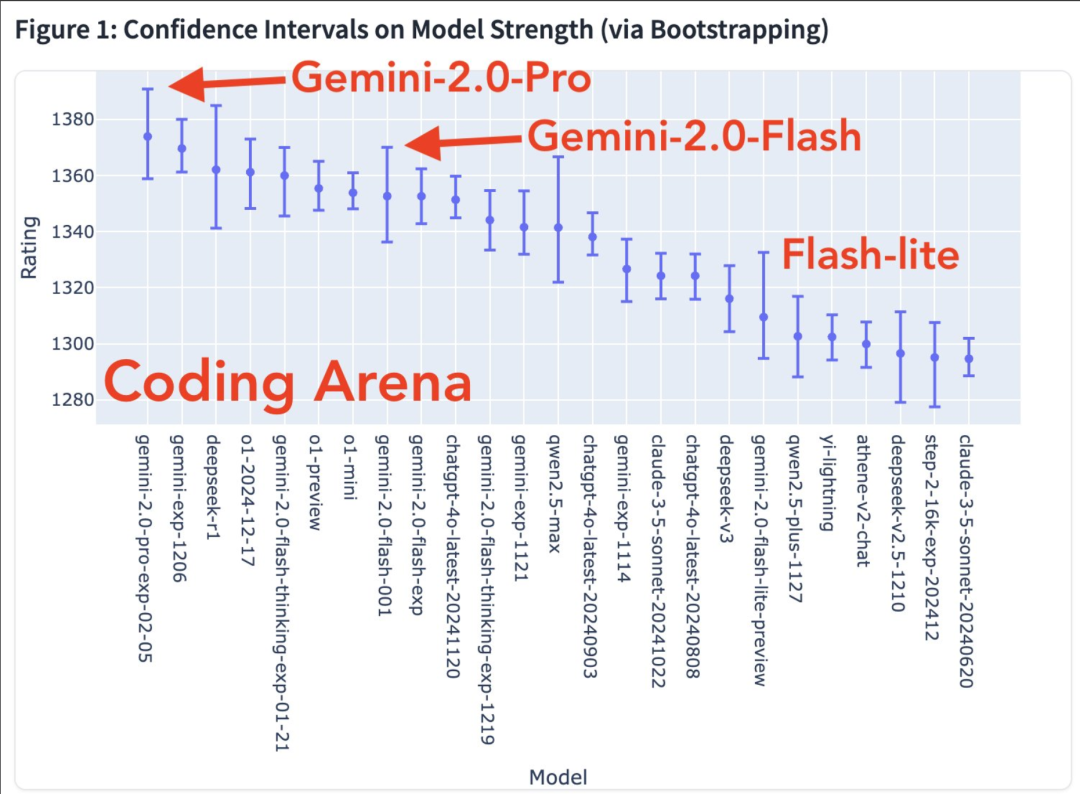

Weitere modale Fähigkeiten sind auf dem Weg. Modellstärkendiagramm im Codierbereich

Heatmap der Gewinnrate

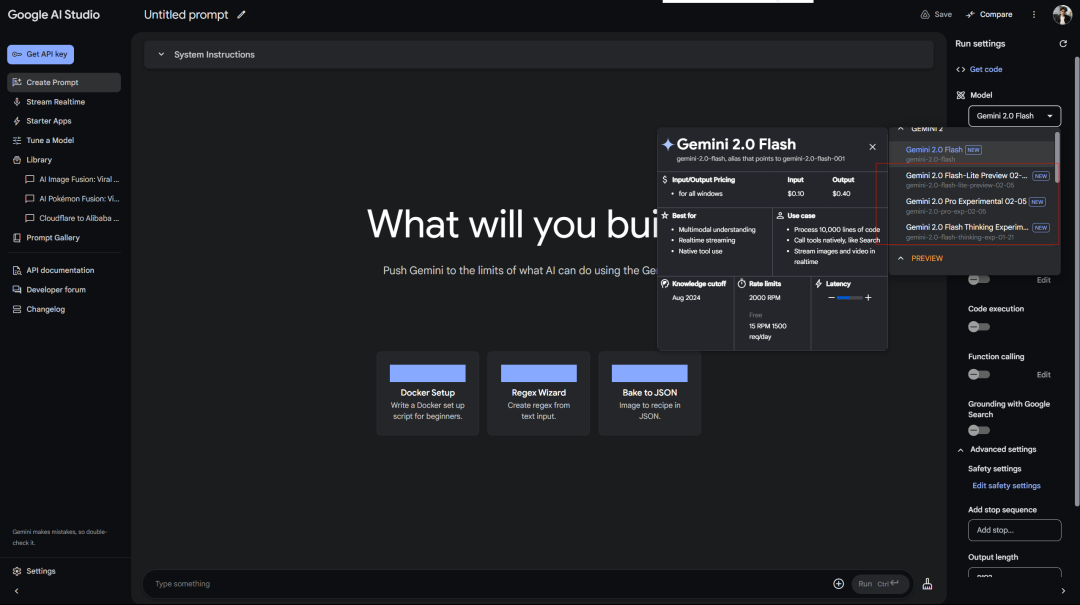

Google behandelt kostenlose Benutzer besser als OpenAI Plus-Benutzer. Kostenloser Zugriff auf Gemini 2.0 Pro Experimental in AI Studio:

Der Deepseek-Dienst zeigt beim Warten immer einen Fehler an … Denken Sie daran, dass das erste inferenzfreie Modell auch 2.0 Flash Thinking war, das in Google AIStudio verwendet wurde.

Darüber hinaus gibt es die Webversion von Gemini:

Es gibt auch ein verbundenes Inferenzmodell (warum also eine Trennung…)

Google hat die experimentelle Version von Gemini 2.0 Pro veröffentlicht und die Verbesserungen bei offiziellen Benchmarktests sind ziemlich auffällig.

Es verfügt über die leistungsstärksten Codierungsfunktionen und die Fähigkeit, komplexe Eingabeaufforderungen zu verarbeiten, und ist besser in der Lage, weltweites Wissen zu verstehen und zu begründen als jedes andere von Google bisher veröffentlichte Modell.

Es verfügt über das größte Kontextfenster (200.000, und mein langer Kontext ist ein relativ großer Vorteil des Gemini-Modells), wodurch es eine große Menge an Informationen umfassend analysieren und verstehen sowie Tools wie die Google-Suche und Codeausführung aufrufen kann.

Im MATH-Test erreichte es 91,8%, eine Steigerung von etwa 5 Prozentpunkten gegenüber Version 1.5. Die GPQA-Argumentationsfähigkeit erreichte 64,7% und der SimpleQA-Weltwissenstest erreichte sogar 44,3%.

Am bemerkenswertesten ist die Programmierfähigkeit. Im LiveCodeBench-Test wurden 36,01 TP11T erreicht, und die Bird-SQL-Konvertierungsgenauigkeit übertraf 59,31 TP11T. In Verbindung mit dem supergroßen Kontextfenster von 2 Millionen Token reicht dies aus, um die komplexesten Codeanalyseaufgaben zu bewältigen.

Sie können es im Cursor ausprobieren.

Auch die Fähigkeit zum Mehrsprachenverständnis ist beeindruckend, mit einem globalen MMLU-Testergebnis von 86,5%. Das Bildverständnis MMMU liegt bei 72,7% und die Fähigkeit zur Videoanalyse bei 71,9%.

Gemini 2.0 Flash-Lite ist ein interessanter Ausgleich.

Es behält die Geschwindigkeit und die Kosten von 1,5 Flash bei, bietet aber eine bessere Leistung. Das Kontextfenster mit 1 Million Token ermöglicht die Verarbeitung von mehr Informationen.

Am praktischsten ist das Preis-Leistungs-Verhältnis: Die Generierung von Bildunterschriften für 40.000 Fotos kostet weniger als $1. Das macht KI bodenständiger.

Blogger Shrivastava erwähnte: Die Gemini 2.0 Pro-Kodierung ist verrückt!

Tipp: Verwenden Sie Three.js, um eine Sonnensystemsimulation zu erstellen. Fügen Sie eine Zeitskala und ein Fokus-Dropdown-Menü hinzu, zeigen Sie Umlaufbahnen und Beschriftungen an. Erstellen Sie alles in einer Datei, damit ich es in einen Online-Editor einfügen und die Ausgabe anzeigen kann.

Darüber hinaus erwähnten einige Benutzer, dass Gemini 2.0 Flash in einem seiner eigenen Paradoxtests bessere Ergebnisse lieferte:

Abschließend erwähnte Google, dass die Sicherheit von Gemini 2.0 und nicht nur des Patches von Anfang an im Mittelpunkt des Designs stehe.

Lassen Sie das Modell lernen, selbstkritisch zu sein. Verwenden Sie Reinforcement Learning, damit Gemini seine eigenen Antworten auswertet und genaueres Feedback liefert. Dies macht es robuster im Umgang mit sensiblen Themen.

Interessant ist der automatisierte Red-Team-Test. Er ist speziell darauf ausgelegt, die Einfügung indirekter Eingabeaufforderungswörter zu verhindern. Das ist so, als würde man die KI mit einem Immunsystem ausstatten, um zu verhindern, dass jemand bösartige Befehle in den Daten versteckt.