o3-mini kam spät in der Nacht, und OpenAI enthüllte endlich seinen neuesten Trumpf. Während eines Reddit AMA Q&A gestand Altman ein, dass er auf der falschen Seite der Open-Source-KI gestanden hatte.

Er sagte, dass die interne Strategie von Open Source in Betracht gezogen wird und das Modell weiter entwickelt wird, aber der Vorsprung von OpenAI wird nicht mehr so groß sein wie zuvor.

Während alle noch über die erstaunliche Leistung von DeepSeek staunten, konnte OpenAI schließlich nicht mehr stillsitzen.

In den frühen Morgenstunden des gestrigen Tages wurde o3-mini eilig gestartet und setzte neue SOTA in Benchmark-Tests wie mathematischen Code und die Rückkehr auf den Thron.

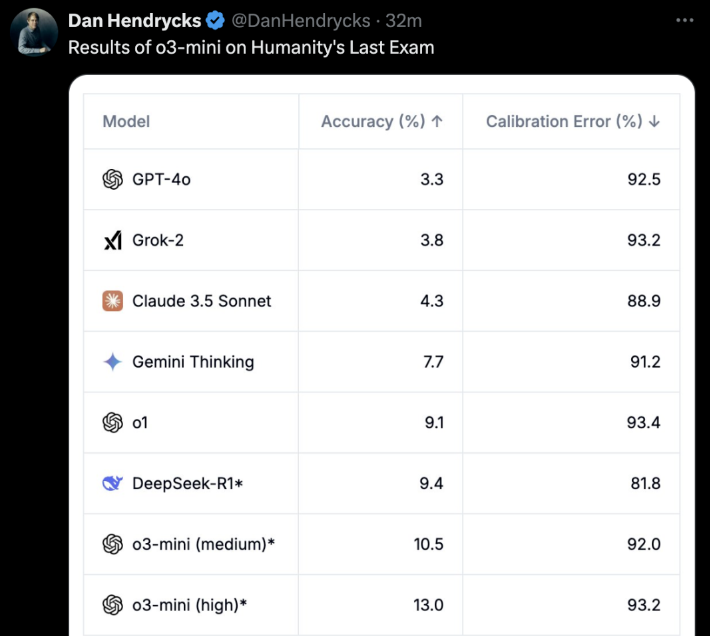

Das Wichtigste ist, dass auch freie Nutzer es erleben können! o3-mini ist kein Scherz. In der "letzten Prüfung für Menschen" erzielte o3-mini (hoch) direkt die beste Genauigkeit und den besten Kalibrierungsfehler.

Ein paar Stunden nach o3-mini ging onlineeröffnete OpenAI offiziell ein Reddit AMA für etwa eine Stunde.

Altman selbst ging ebenfalls online und beantwortete alle Fragen der Internetnutzer.

Die wichtigsten Highlights sind:

- DeepSeek ist in der Tat sehr gutund wir werden weiterhin bessere Modelle entwickeln, aber der Vorsprung wird nicht mehr so groß sein wie früher.

- Im Vergleich zu vor ein paar Jahren bin ich jetzt eher geneigt zu glauben, dass die KI rasante Sprünge machen wird

- Wir sind auf der falschen Seite, wenn es um das Open-Sourcing gewichteter KI-Modelle geht

- Ein Update für den erweiterten Sprachmodus wird bald erscheinen, und wir werden es direkt GPT-5 nennen, nicht GPT-5o. Einen konkreten Zeitplan gibt es noch nicht.

Neben Altman selbst waren auch Chief Research Officer Mark Chen, Chief Product Officer Kevin Weil, Vice President of Engineering Srinivas Narayanan, Head of API Research Michelle Pokrass und Head of Research Hongyu Ren online und beantworteten sorgfältig alle Fragen der Netizens.

Werfen wir nun einen Blick darauf, was sie alle gesagt haben.

Altman bereut zutiefst, dass er sich im Kampf um Open-Source-KI auf die falsche Seite gestellt hat

Das plötzliche Comeback von DeepSeek mag für alle unerwartet gewesen sein.

Während der AMA Q&A bereute Altman selbst zutiefst, dass er sich im Kampf um die Open-Source-KI auf die falsche Seite geschlagen hatte und musste die starken Vorteile von DeepSeek zugeben.

Was viele erstaunte, war, dass Altman sogar sagte, dass der Vorsprung von OpenAI nicht mehr so groß sei wie früher.

Im Folgenden finden Sie alle klassischen Antworten, die wir von Altman zusammengestellt haben.

F: Lassen Sie uns über das große Thema der Woche sprechen: Deepseek. Es ist eindeutig ein sehr beeindruckendes Modell, und ich weiß, dass es wahrscheinlich auf der Grundlage der Ergebnisse anderer LLMs trainiert wurde. Wie wird dies Ihre Pläne für zukünftige Modelle verändern?

Altman: Es ist in der Tat ein sehr beeindruckendes Modell! Wir werden bessere Modelle entwickeln, aber wir werden nicht in der Lage sein, einen so großen Vorsprung zu halten wie in den vergangenen Jahren.

F: Glauben Sie, dass die rekursive Selbstverbesserung ein allmählicher Prozess sein wird oder ein plötzlicher Durchbruch?

Altman: Ich persönlich glaube eher, dass die Künstliche Intelligenz rasche Fortschritte machen wird, als ich es noch vor ein paar Jahren tat. Vielleicht ist es an der Zeit, etwas zu diesem Thema zu schreiben...

F: Können wir alle Spielsteine sehen, an die das Modell denkt?

Altman: Ja, wir werden bald eine hilfreichere und ausführlichere Version zeigen. Danke an R1 für das Update.

Kevin Weil, leitender Produktmanager: Wir arbeiten daran, mehr zu zeigen als jetzt - das wird bald geschehen. Ob wir alles zeigen oder nicht, bleibt abzuwarten. Alle Gedankenketten (CoT) zu zeigen, würde zu einer Destillation von Konkurrenzmodellen führen, aber wir wissen auch, dass die Nutzer (zumindest fortgeschrittene Nutzer) dies sehen wollen, also werden wir eine gute Balance finden.

F: Wann wird die Vollversion von o3 verfügbar sein?

Altman: Ich würde schätzen, dass es mehr als ein paar Wochen sein werden, aber nicht mehr als ein paar Monate.

F: Wird es ein Update für den Sprachmodus geben? Ist dies möglicherweise ein Schwerpunkt des GPT-5o? Was ist der grobe Zeitplan für den GPT-5o?

Altman: Ja, es wird ein Update für den erweiterten Sprachmodus geben! Ich denke, wir werden es einfach GPT-5 nennen, nicht GPT-5o. Es gibt noch keinen genauen Zeitplan.

F: Würden Sie in Erwägung ziehen, einige Modellgewichte freizugeben und einige Forschungsergebnisse zu veröffentlichen?

Altman: Ja, wir diskutieren darüber. Ich persönlich bin der Meinung, dass wir in dieser Frage auf der falschen Seite stehen und eine andere Open-Source-Strategie entwickeln müssen; nicht jeder bei OpenAI teilt diese Ansicht, und es ist im Moment nicht unsere höchste Priorität.

Eine weitere Frage wird gestellt:

- Wie weit sind wir mit dem Angebot von Operator im regulären Plus-Programm?

- Was sind die wichtigsten Prioritäten der Robotikabteilung?

- Was hält OpenAI von spezielleren Chips/TPUs, wie Trillium, Cerebras usw.? Schenkt OpenAI dem Aufmerksamkeit?

- Welche Investitionen werden getätigt, um sich gegen zukünftige Risiken bei AGI und ASI abzusichern?

- Was war Ihr schönster Urlaub?

Altman:

- Ein paar Monate

- einen wirklich guten Roboter in kleinem Maßstab herzustellen und aus den Erfahrungen zu lernen

- Der GB200 ist derzeit kaum zu schlagen!

- Eine gute Wahl wäre, Ihren inneren Zustand zu verbessern - Belastbarkeit, Anpassungsfähigkeit, Ruhe, Freude usw.

- Es ist schwer zu wählen! Aber die ersten beiden, die mir einfallen, sind: Backpacking in Südostasien oder eine Safari in Afrika

F: Planen Sie eine Preiserhöhung für die Plus-Serie?

Altman: Eigentlich möchte ich sie schrittweise reduzieren.

F: Nehmen wir an, wir schreiben das Jahr 2030, und Sie haben gerade ein System entwickelt, das die meisten Menschen als AGI bezeichnen würden. Es schneidet in allen Benchmark-Tests hervorragend ab und übertrifft Ihre besten Ingenieure und Forscher in Bezug auf Geschwindigkeit und Leistung. Wie geht es nun weiter? Haben Sie außer "es auf die Website zu stellen und als Dienstleistung anzubieten" noch andere Pläne?

Altman: Die wichtigste Auswirkung wird meiner Meinung nach die Beschleunigung der wissenschaftlichen Entdeckung sein, die meiner Meinung nach am meisten zur Verbesserung der Lebensqualität beitragen wird.

4o Bilderzeugung, in Kürze

Als nächstes wurden Antworten von anderen OpenAI-Mitgliedern hinzugefügt.

F: Planen Sie immer noch die Einführung des 4o-Bildgenerators?

Kevin Weil, leitender Produktmanager: Ja! Und ich denke, das Warten hat sich gelohnt.

F: Großartig! Gibt es einen groben Zeitplan?

Kevin Weil, leitender Produktmanager: Sie bitten mich, in Schwierigkeiten zu geraten. Vielleicht ein paar Monate.

Und noch eine ähnliche Frage.

F: Wann können wir mit ChatGPT-5 rechnen?

Kevin Weil, leitender Produktmanager: Kurz nach o-17 micro und GPT-(π+1).

Und eine weitere Frage taucht auf:

- Welche anderen Arten von Mitteln können wir erwarten?

- Und bieten Sie auch einen Agenten für kostenlose Nutzer an, was die Akzeptanz beschleunigen könnte...

- Gibt es Neuigkeiten über die neue Version von DALL-E?

- Eine letzte Frage, die sich jeder stellt: Wann wird die AGI eingeführt?

Kevin Weil, Leiter der Produktabteilung:

- Weitere Agenten: sehr, sehr bald. Ich glaube, Sie werden sich freuen.

- Bilderzeugung auf der Grundlage von 4o: in ein paar Monaten, ich kann es kaum erwarten, dass Sie es benutzen. Es ist großartig.

- AGI: Ja

F: Planen Sie, das Argumentationsmodell um Funktionen für Dateianhänge zu erweitern?

Srinivas Narayanan, Vizepräsident für Technik: Es befindet sich in der Entwicklung. In Zukunft wird das Argumentationsmodell in der Lage sein, verschiedene Tools, einschließlich Suchfunktionen, zu nutzen.

Kevin Weil, Leiter des Produktmanagements: Ich möchte nur sagen, dass ich es kaum erwarten kann, das Argumentationsmodell für die Verwendung von Tools zu sehen

F: Wirklich. Wenn Sie dieses Problem lösen, werden sich einige sehr nützliche KI-Anwendungsszenarien eröffnen. Stellen Sie sich vor, dass sie in der Lage ist, den Inhalt Ihrer 500 GB großen Arbeitsdokumente zu verstehen.

Wenn Sie im Begriff sind, eine E-Mail zu beantworten, öffnet sich neben Ihrer E-Mail-App ein Fenster, das kontinuierlich alle Informationen zu dieser Person analysiert, einschließlich Ihrer Beziehung, der besprochenen Themen, früherer Arbeit usw. Vielleicht wird etwas aus einem Dokument, das Sie längst vergessen haben, markiert, weil es für die aktuelle Diskussion äußerst relevant ist. Ich wünsche mir diese Funktion so sehr.

Srinivas Narayanan, Vizepräsident für Technik: Wir arbeiten daran, die Länge des Kontextes zu erhöhen. Es gibt noch kein festes Datum/keine Ankündigung.

F: Wie wichtig ist das Stargate-Projekt für die Zukunft von OpenAI? Kevin Weil, Leiter des Produktmanagements: Das ist sehr wichtig. Alles, was wir gesehen haben, deutet darauf hin, dass wir umso bessere Modelle erstellen und wertvollere Produkte entwickeln können, je mehr Rechenleistung wir haben.

Wir skalieren unsere Modelle derzeit in zwei Dimensionen - größeres Pretraining und mehr Reinforcement Learning (RL)/"strawberry"-Training - beides erfordert Rechenressourcen.

Um Hunderte von Millionen von Nutzern zu bedienen, sind auch Rechenressourcen erforderlich! Und da wir uns in Richtung intelligenter Agentenprodukte bewegen, die kontinuierlich für Sie arbeiten können, sind auch hierfür Rechenressourcen erforderlich. Sie können sich Stargate also als unsere Fabrik vorstellen, in der Strom/GPUs in erstaunliche Produkte umgewandelt werden.

F: Welches interne Modell verwenden Sie jetzt? o4, o5 oder o6? Wie viel intelligenter sind diese internen Modelle im Vergleich zu o3?

Michelle Pokrass, Leiterin der API-Forschung: Wir haben den Überblick verloren.

F: Bitte erlauben Sie uns, mit Text/Leinwand zu interagieren und dabei erweiterte Sprachfunktionen zu verwenden. Ich möchte mit dem System sprechen können, damit es Dokumente ändern kann.

Kevin Weil, leitender Produktmanager: Ja! Wir haben eine Menge großartiger Tools, die relativ unabhängig entwickelt wurden - das Ziel ist es, diese Tools so schnell wie möglich in Ihre Hände zu bekommen.

Der nächste Schritt besteht darin, all diese Funktionen zu integrieren, so dass man mit einem Modell sprechen kann, das gleichzeitig sucht und begründet, und einen Canvas erzeugt, der mit Python ausgeführt werden kann. Alle Werkzeuge müssen besser zusammenarbeiten. Übrigens brauchen alle Modelle vollen Zugriff auf die Werkzeuge (die Modelle der o-Serie können derzeit nicht alle Werkzeuge nutzen), was ebenfalls implementiert werden wird.

F: Wann werden die Modelle der o-Serie die Speicherfunktion in ChatGPT unterstützen?

Michelle Pokrass, Leiterin der API-Forschung: Es ist in der Entwicklung! Die Vereinheitlichung aller unserer Funktionen mit den Modellen der o-Serie hat für uns oberste Priorität.

F: Wird es größere Verbesserungen für 4o geben? Ich mag das benutzerdefinierte GPT sehr, und es wäre toll, wenn es aufgerüstet werden könnte oder wenn wir wählen könnten, welches Modell wir im benutzerdefinierten GPT verwenden wollen (z. B. das o3 mini).

Michelle Pokrass, Leiterin der API-Forschung: Ja, wir sind noch nicht fertig mit der 4o-Serie!