OpenAI ha publicado su último modelo de inferencia, o3-minioptimizado para campos como la ciencia, las matemáticas y la programación, que ofrece una respuesta más rápida, mayor precisión y menor coste.

En comparación con su predecesor o1-mini, o3-mini ha mejorado significativamente su capacidad de inferencia, especialmente en la resolución de problemas complejos. Los probadores prefieren las respuestas de o3-mini en 56%, y la tasa de error se ha reducido en 39%. A partir de hoy, ChatGPT Plus, Equipo y Pro pueden utilizar o3-mini, y usuarios libres también puede experimentar algunas de sus características.

En comparación con el modelo de inferencia DeepSeek-R1¿cuánto mejor es OpenAI o3-mini que R1?

En este artículo daremos primero una visión general de los aspectos más destacados de o3-mini, y luego extraeremos los datos de ambos lados en cada punto de referencia y haremos un gráfico para compararlos visualmente. Además, también compararemos el precio de o3-mini.

Lo más destacado

1.Optimización STEM: sobresale en los campos de matemáticas, programación, ciencias, etc., superando especialmente a o1-mini en el modo de alto esfuerzo de inferencia.

2.Funciones del desarrollador: admite funciones como llamadas a funciones, salida estructurada y mensajes de desarrollador para satisfacer las necesidades del entorno de producción.

3.Respuesta rápida: 24% más rápido que o1-mini, con un tiempo de respuesta de 7,7 segundos por petición.

4.Mejora de la seguridad: garantiza una salida segura y fiable gracias a la tecnología de alineación profunda.

5.RentableLa capacidad de inferencia y la optimización de costes van de la mano, lo que reduce en gran medida el umbral para el uso de la IA.

Compara

Open AI Para destacar su clase, su blog oficial sólo lo compara con sus propios modelos. Por lo tanto, este artículo es una tabla extraída del documento DeepSeek R1 y de los datos del blog oficial de OpenAI.

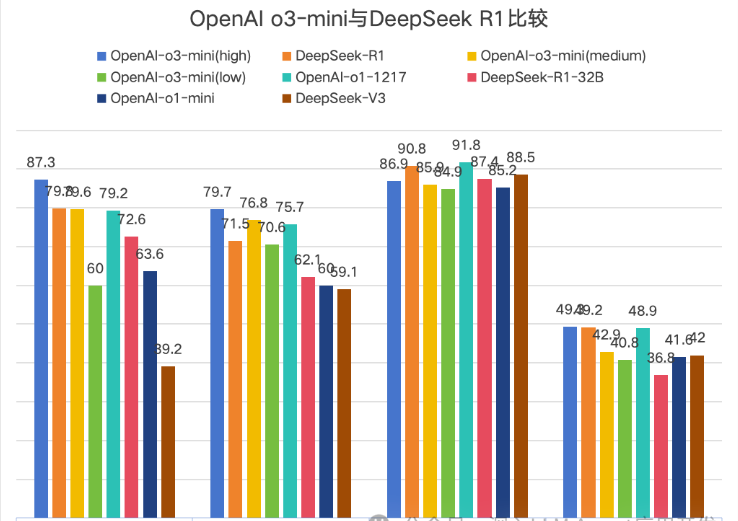

OpenAI compara oficialmente o3-mini en la lista de versiones, desglosándola en tres versiones: baja, media y alta, que indican la fuerza de inferencia. Dado que DeepSeek utiliza Math-500 y OpenAI utiliza el conjunto de datos Math, esta comparación se ha eliminado aquí.

Un gráfico es más intuitivo, y Codeforces se ha eliminado porque los valores son demasiado grandes para mostrarse de forma intuitiva. Sin embargo, la comparación en Codeforces muestra que la elevada fuerza de inferencia de o3-mini no es mucha ventaja.

↑1AIME2024→2GPQA Diamond→3MMLU→4SWE-bench-Verificado

Según el gráfico, hay un total de 4 comparaciones, y el O3-mini (alto) suele ir en cabeza, pero la ventaja es muy pequeña.

Precio

| modelo | Precio de los insumos | Golpe de caché | Precio de producción |

| o3-mini | $1.10 | $0.55 | $4.40 |

| o1 | $15.00 | $7.50 | $60.00 |

| Búsqueda Profunda R1 | $0.55 | $0.14 | $2.19 |

Resumen

Con el DeepSeek R1 desatando el pánico del DeepSeek en Estados Unidos, el primero en sentirse amenazado fue OpenAI, lo que resulta especialmente evidente en el precio de su nuevo modelo o3-mini.

Cuando Openai o1 salió al mercado, su elevado precio presionó a muchos desarrolladores y usuarios. La aparición de DeepSeek R1 dio a todos más opciones.De la diferencia de precio de 30 veces entre o1 y R1 al precio final de o3-mini que es el doble de el precio de DeepSeek R1,

muestra el impacto de DeepSeek R1 en openai.Sin embargo, los usuarios gratuitos de ChatGPT sólo pueden experimentar o3-mini de forma limitada, mientras que Deep Thinking de DeepSeek está disponible actualmente para todos los usuarios.También espero que openai aporte más modelos de ai punteros al tiempo que reduce el coste de uso para los usuarios.

Desde la perspectiva de la experiencia personal de un bloguero que utiliza R1, me gustaría decir que Deep Thinking de R1 siempre me abre la mente. Recomiendo a todo el mundo que lo utilice más para pensar en los problemas~.