Aucun d'entre nous ne s'attendait à ce que l'année 2025 commence ainsi dans le domaine de l'IA.

DeepSeek R1 est vraiment étonnante !

Récemment, la "mystérieuse puissance orientale" DeepSeek a exercé un "contrôle rigoureux" sur la Silicon Valley.

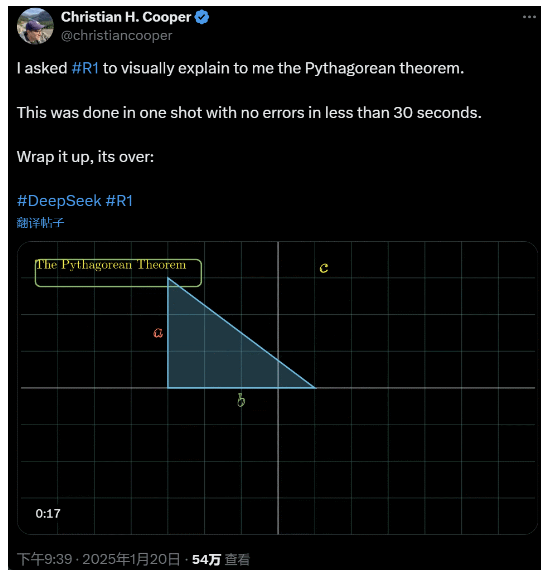

J'ai demandé à R1 d'expliquer en détail le théorème de Pythagore. Tout cela a été fait par l'IA en moins de 30 secondes sans aucune erreur. Bref, c'est terminé.

Dans les cercles nationaux et étrangers de l'IA, les internautes ordinaires ont découvert l'étonnante et puissante nouvelle IA (qui est également open source), et les experts universitaires se sont écriés "nous devons rattraper notre retard". On entend également dire que les entreprises d'IA étrangères sont déjà confrontées à une menace majeure.

Prenons par exemple le DeepSeek R1 publié cette semaine. Son parcours d'apprentissage par renforcement pur sans aucune formation supervisée est choquant. Depuis le développement de la base Deepseek-v3 en décembre de l'année dernière jusqu'aux capacités actuelles de la chaîne de réflexion, comparables à celles d'OpenAI o1, il semble que ce soit une question de temps.

Mais alors que la communauté de l'IA est occupée à lire des rapports techniques et à comparer des mesures réelles, les gens ont encore des doutes sur la R1 : au-delà de sa capacité à surpasser un certain nombre d'indices de référence, peut-elle vraiment mener ?

Peut-il construire ses propres simulations de "lois physiques" ?

Vous n'y croyez pas ? Laissons le grand modèle jouer avec une boule de flipper ?

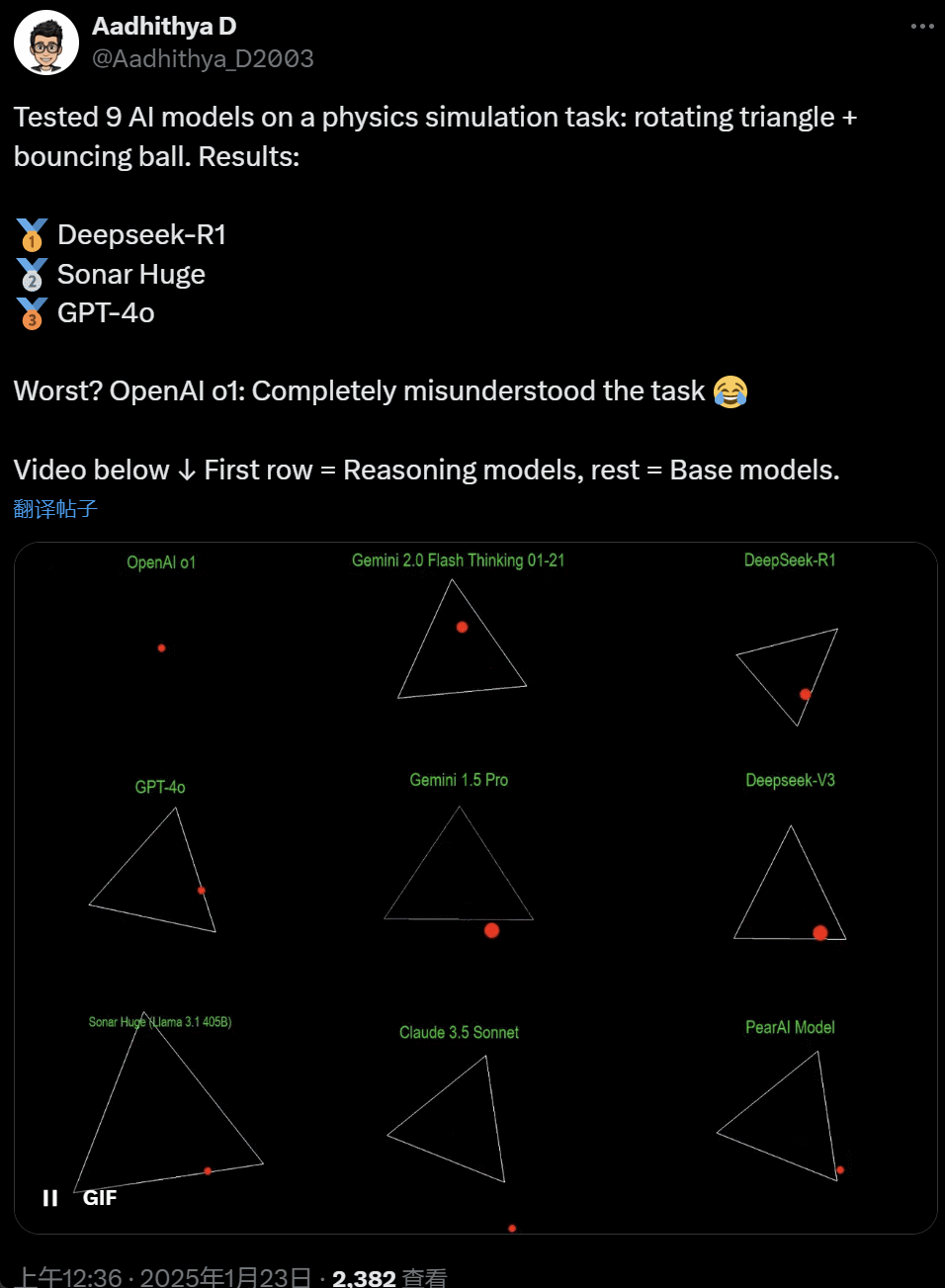

Ces derniers jours, certains membres de la communauté de l'IA sont devenus obsédés par les tests - tester différents grands modèles d'IA (en particulier les modèles dits de raisonnement) pour résoudre un problème : "Écrivez un script Python pour faire rebondir une balle jaune à l'intérieur d'une certaine forme. Faites tourner la forme lentement et assurez-vous que la balle reste à l'intérieur de la forme".

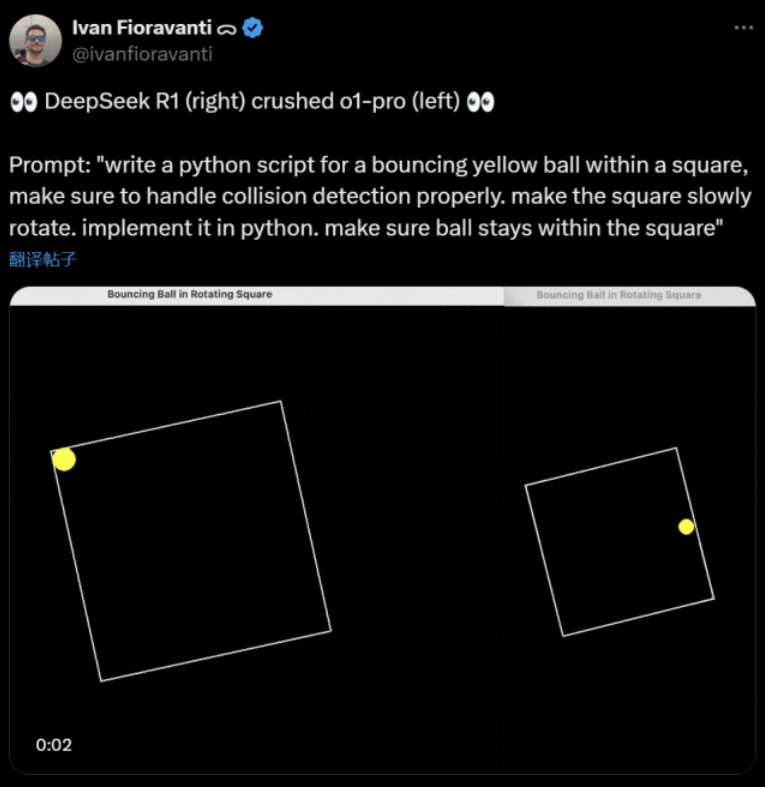

Certains modèles sont plus performants que d'autres dans ce test de référence de la "balle tournante". Selon Ivan Fioravanti, directeur technique de CoreView, DeepSeek, un laboratoire national d'intelligence artificielle, dispose d'un grand modèle R1 open source qui bat le modèle o1 pro d'OpenAI, qui coûte $200 par mois dans le cadre du programme ChatGPT Pro d'OpenAI.

À gauche, OpenAI o1, et à droite, DeepSeek R1. Comme mentionné plus haut, l'invitation est la suivante "écrire un script python pour une balle jaune rebondissant à l'intérieur d'un carré, s'assurer de gérer correctement la détection des collisions. faire tourner lentement le carré. l'implémenter en python. s'assurer que la balle reste à l'intérieur du carré".

Selon un autre utilisateur de X, les modèles Anthropic Claude 3.5 Sonnet et Gemini 1.5 Pro de Google ont fait des jugements incorrects sur les principes physiques, ce qui a fait dévier la balle de sa forme. Certains utilisateurs ont également signalé que le dernier modèle Gemini 2.0 Flash Thinking Experimental de Google, ainsi que le modèle OpenAI GPT-4o, relativement plus ancien, ont passé l'évaluation en une seule fois.

Mais il existe un moyen de faire la différence :

Les citoyens sous ce tweet ont dit : la capacité de o1 était à l'origine très bonne, mais elle est devenue plus faible après l'optimisation de la vitesse par OpenAI, même avec la version d'adhésion de $200/mois.

La simulation d'une balle qui rebondit est un défi de programmation classique. Une simulation précise fait appel à des algorithmes de détection des collisions, qui doivent identifier le moment où deux objets (tels qu'une balle et le côté d'une forme) entrent en collision. Un algorithme mal écrit peut affecter les performances de la simulation ou provoquer des erreurs physiques évidentes.

N8 Programs, chercheur à la startup d'IA Nous Research, a déclaré qu'il lui a fallu environ deux heures pour écrire une balle rebondissante dans un heptagone rotatif à partir de zéro. "Plusieurs systèmes de coordonnées doivent être suivis, il faut comprendre comment les collisions sont gérées dans chaque système, et le code doit être conçu à partir de zéro pour être robuste".

Bien que les balles qui rebondissent et les formes qui tournent constituent un test raisonnable des compétences en programmation, il s'agit encore de nouveaux projets pour les grands modèles, et même de petites modifications dans les messages-guides peuvent produire des résultats différents. Si l'on veut qu'il devienne un jour un test de référence pour les grands modèles d'IA, il doit encore être amélioré.

Quoi qu'il en soit, après cette vague de tests pratiques, nous avons une idée des différences de capacités entre les grands modèles.

DeepSeek est le nouveau "mythe de la Silicon Valley

DeepSeek sème la panique" dans le Pacifique.

Les employés de Meta ont indiqué que "les ingénieurs de Meta analysent frénétiquement DeepSeek pour essayer d'en copier tout ce qu'ils peuvent".

Alexandr Wang, fondateur de la startup de technologie d'IA Scale AI, a également déclaré publiquement que les performances du grand modèle d'IA de DeepSeek sont à peu près équivalentes à celles du meilleur modèle des États-Unis.

Il estime également que les États-Unis ont peut-être devancé la Chine dans la compétition en matière d'IA au cours de la dernière décennie, mais que le lancement par DeepSeek de son grand modèle d'IA pourrait "tout changer".

Le blogueur X @8teAPi estime que DeepSeek n'est pas un "projet secondaire" mais qu'il ressemble à l'ancien "Skunk Works" de Lockheed Martin.

L'appellation "Skunk Works" fait référence à une petite équipe hautement confidentielle et relativement indépendante que Lockheed Martin a créée à l'origine pour développer de nombreux aéronefs de pointe, en se consacrant à la recherche et au développement de technologies d'avant-garde ou non conventionnelles. De l'avion de reconnaissance U-2 et du SR-71 Blackbird au F-22 Raptor et à l'avion de combat F-35 Lightning II, ils sont tous nés ici.

Par la suite, le terme a progressivement évolué pour devenir un terme générique utilisé pour décrire des équipes d'innovation "petites mais fines", relativement indépendantes et plus flexibles, mises en place au sein de grandes entreprises ou organisations.

Il a invoqué deux raisons :

- D'une part, DeepSeek dispose d'un grand nombre de GPU, qui seraient plus de 10 000, et Alexandr Wang, PDG de Scale AI, a même déclaré que ce nombre pourrait atteindre 50 000.

- D'autre part, DeepSeek ne recrute que des talents issus des trois meilleures universités chinoises, ce qui signifie qu'elle est aussi compétitive qu'Alibaba et Tencent.

Ces deux faits montrent à eux seuls que DeepSeek a clairement obtenu un succès commercial et qu'il est suffisamment connu pour obtenir ces ressources.

En ce qui concerne les coûts de développement de DeepSeek, le blogueur a déclaré que les entreprises technologiques chinoises peuvent bénéficier de diverses subventions, telles que de faibles coûts d'électricité et d'utilisation des terrains.

Il est donc très probable que la plupart des coûts de DeepSeek ont été "placés" sur un compte extérieur à l'activité principale ou sous la forme d'une sorte de subvention à la construction d'un centre de données.

Même en dehors des fondateurs, personne ne comprend parfaitement tous les accords financiers. Certains accords peuvent n'être que des "accords verbaux" conclus sur la seule base de la réputation.

Quoi qu'il en soit, certaines choses sont claires :

- Le modèle est excellent, comparable à la version publiée par OpenAI il y a deux mois, et il est bien sûr possible qu'il ne soit pas aussi bon que les nouveaux modèles qu'OpenAI et Anthropic n'ont pas encore publiés.

- D'un point de vue actuel, la direction de la recherche est toujours dominée par les entreprises américaines. Le modèle DeepSeek est un "suivi rapide" de la version o1, mais les progrès de la recherche et du développement de DeepSeek sont très rapides, rattrapant le retard plus vite que prévu. Il ne s'agit pas de plagiat ou de tricherie, mais tout au plus d'ingénierie inverse.

- DeepSeek forme principalement ses propres talents, plutôt que de s'appuyer sur des doctorants formés aux États-Unis, ce qui élargit considérablement le vivier de talents.

- Par rapport aux entreprises américaines, DeepSeek est soumise à moins de contraintes en termes de licences de propriété intellectuelle, de protection de la vie privée, de sécurité, de politique, etc. et il y a moins d'inquiétudes quant à l'utilisation abusive de données sur lesquelles les gens ne veulent pas être formés. Il y a moins de procès, moins d'avocats et moins d'inquiétudes.

Il ne fait aucun doute que de plus en plus de personnes pensent que 2025 sera une année décisive. Entre-temps, les entreprises s'y préparent. Meta, par exemple, construit un centre de données de 2GW+, avec un investissement estimé à $60-65 milliards d'euros d'ici 2025, et disposera de plus de 1,3 million de GPU d'ici la fin de l'année.

Meta a même utilisé un graphique pour comparer son centre de données de 2 gigawatts avec Manhattan, à New York.

Mais aujourd'hui, DeepSeek a fait mieux en réduisant les coûts et le nombre de GPU. Comment cela peut-il ne pas rendre les gens anxieux ?

Yann LeCun : Nous devons remercier le directeur technique et cofondateur de les source ouverte

Hyperbolique, Yuchen Jin, pour avoir posté qu'en seulement 4 jours, DeepSeek-R1 nous a prouvé 4 faits :

- L'IA open source n'a que 6 mois de retard sur l'IA closed source

- La Chine domine le concours d'IA open source

- Nous entrons dans l'âge d'or de l'apprentissage par renforcement des grands modèles de langage.

- Les modèles de distillation sont très puissants, et nous ferons fonctionner des IA très intelligentes sur des téléphones portables.

La réaction en chaîne déclenchée par DeepSeek se poursuit, comme la mise à disposition gratuite de l'OpenAI o3-mini, l'espoir de la communauté de réduire les discussions vagues sur l'AGI/ASI et la rumeur selon laquelle Meta est en proie à la panique.

Il estime qu'il est difficile de prédire qui l'emportera en fin de compte, mais nous ne devons pas oublier le pouvoir de l'avantage du retardataire. Après tout, nous savons tous que c'est Google qui a inventé Transformer, tandis qu'OpenAI a révélé son véritable potentiel.

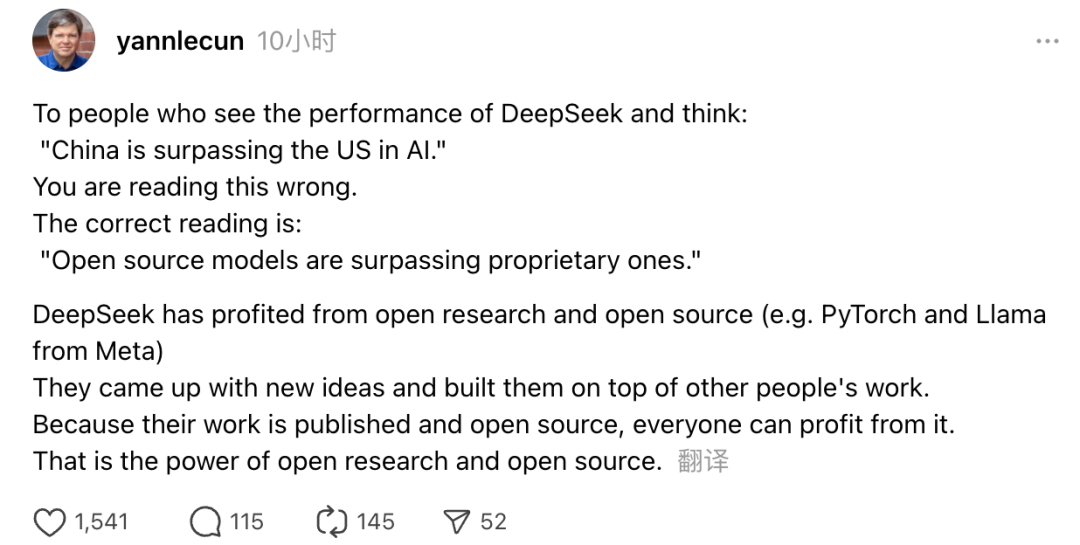

Par ailleurs, Yann LeCun, lauréat du prix Turing et responsable scientifique de Meta pour l'IA, a également exprimé son point de vue.

"Pour ceux qui, en voyant les performances de DeepSeek, pensent que la Chine est en train de dépasser les États-Unis dans le domaine de l'IA, ils se trompent. Ce qu'il faut comprendre, c'est que les modèles open source sont en train de dépasser les modèles propriétaires".

LeCun a déclaré que la raison pour laquelle DeepSeek a fait un tel tabac cette fois-ci est qu'il a bénéficié de la recherche ouverte et de l'open source (comme PyTorch et Llama de Meta). DeepSeek a proposé de nouvelles idées et s'est appuyé sur le travail d'autres personnes. Comme leur travail est rendu public et qu'il s'agit d'une source ouverte, tout le monde peut en bénéficier. C'est la force de la recherche ouverte et de l'open source.

Les réflexions des net-citoyens se poursuivent. S'ils se réjouissent du développement des nouvelles technologies, ils peuvent aussi ressentir une certaine inquiétude. Après tout, l'émergence des DeepSeekers pourrait avoir un impact réel.