DeepSeek-R1 és az DeepSeek-V3 a nyílt forráskódú bevezetésük óta világszerte nagy feltűnést keltett.

Ők az DeepSeek csapat ajándéka az egész emberiségnek, és mi őszintén örülünk a sikerüknek.

A Silicon Mobility és a Huawei Cloud csapatainak napokig tartó kemény munkája után ma a kínai felhasználóknak is adunk egy kínai újévi ajándékot: a SiliconCloud nagyszabású modellfelhő-szolgáltatási platform elindította az DeepSeek-V3 és az DeepSeek-R1 modelleket, amelyek a Huawei Cloud Ascend felhőszolgáltatásán alapulnak.

Hangsúlyozni kell, hogy nagyszerű támogatást kaptunk az DeepSeek-től és a Huawei Cloudtól, mind az DeepSeek-R1 & V3 Ascendre való adaptálásában, mind a többi modell korábbi elindításának folyamatában, és szeretnénk mély hálánkat és nagy tiszteletünket kifejezni.

Jellemzők

A SiliconCloud által bevezetett két modell elsősorban öt fő funkciót tartalmaz:

A Huawei Cloud Ascend felhőszolgáltatására alapozva elindítottuk a DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 modellkövetkeztetési szolgáltatás első alkalommal.

A két fél közös innovációja révén és a saját fejlesztésű következtetésgyorsító motor támogatásával a Silicon Mobility csapata által a Huawei Cloud Ascend felhőszolgáltatásán alapuló DeepSeek modell a világ csúcskategóriás GPU telepítési modelljével azonos hatást érhet el.

Stabil termelési szintű DeepSeek-R1 és V3 következtetési szolgáltatások biztosítása. Ez lehetővé teszi a fejlesztők számára, hogy stabilan fussanak nagyméretű termelési környezetben, és megfeleljenek a kereskedelmi bevezetés igényeinek. A Huawei Cloud Ascend AI szolgáltatások bőséges, rugalmas és elegendő számítási teljesítményt biztosítanak.

Nincs telepítési küszöbérték, így a fejlesztők inkább az alkalmazásfejlesztésre koncentrálhatnak. Az alkalmazások fejlesztése során közvetlenül meghívhatják a SiliconCloud API-t, ami egyszerűbb és felhasználóbarátabb élményt nyújt.

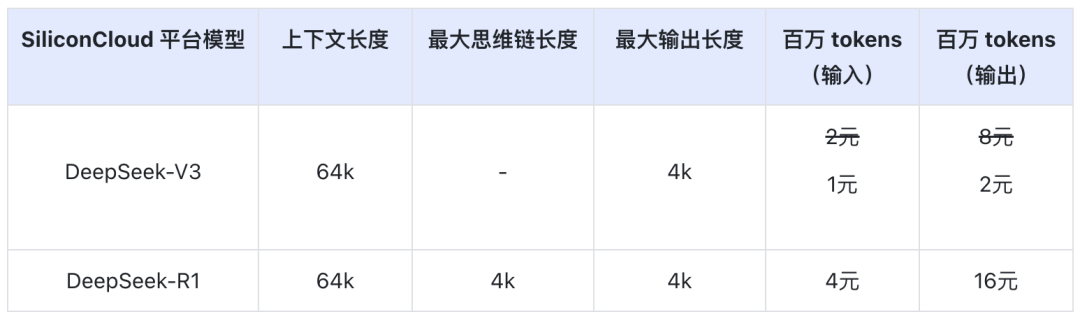

Az DeepSeek-V3 ára a SiliconCloudon a hivatalos kedvezményes időszak alatt (február 8-án 24:00-ig) 1¥ / M token (bemenet) és 2¥ / M token (kimenet), az DeepSeek-R1 ára pedig 4¥ / M token (bemenet) és 16¥ / M token (kimenet).

Online tapasztalat

DeepSeek-R1 a SiliconClouddal

DeepSeek-V3 a SiliconClouddal

API dokumentáció

A fejlesztők a SiliconCloudon megtapasztalhatják a hazai chipeken gyorsított DeepSeek-R1 & V3 hatását. A gyorsabb kimeneti sebességet még folyamatosan optimalizálják.

Tapasztalat az ügyfélalkalmazásban

Ha az DeepSeek-R1 & V3 modellt közvetlenül az ügyfélalkalmazásban szeretné megtapasztalni, akkor a következő termékeket telepítheti helyileg, és hozzáférhet a SiliconCloud API-hoz (testreszabhatja és hozzáadhatja ezt a két modellt) az DeepSeek-R1 & V3 megtapasztalásához.

- Nagyméretű modell ügyfélalkalmazások: ChatBox, Cherry Studio, OneAPI, LobeChat, NextChat

- Kódgeneráló alkalmazások: Cursor, Windsurf, Cline

- Nagy modell alkalmazásfejlesztési platform:Dify

- AI tudásbázis:Obszidián AI, ésFastGPT

- Fordítás plug-in:Immersive Translate, ésEurodict

További forgatókönyvek és alkalmazási esetek elérését bemutató útmutatókért kérjük, olvassa el a következő webhelyet itt

Token Factory SiliconCloud

Qwen2.5 (7B) stb. 20+ modell szabadon használható

A nagy modellek egyablakos felhőszolgáltatási platformjaként a SiliconCloud elkötelezett amellett, hogy a fejlesztőknek olyan modell API-kat biztosítson, amelyek rendkívül rugalmasak, megfizethetőek, átfogóak és selymes élményt nyújtanak.

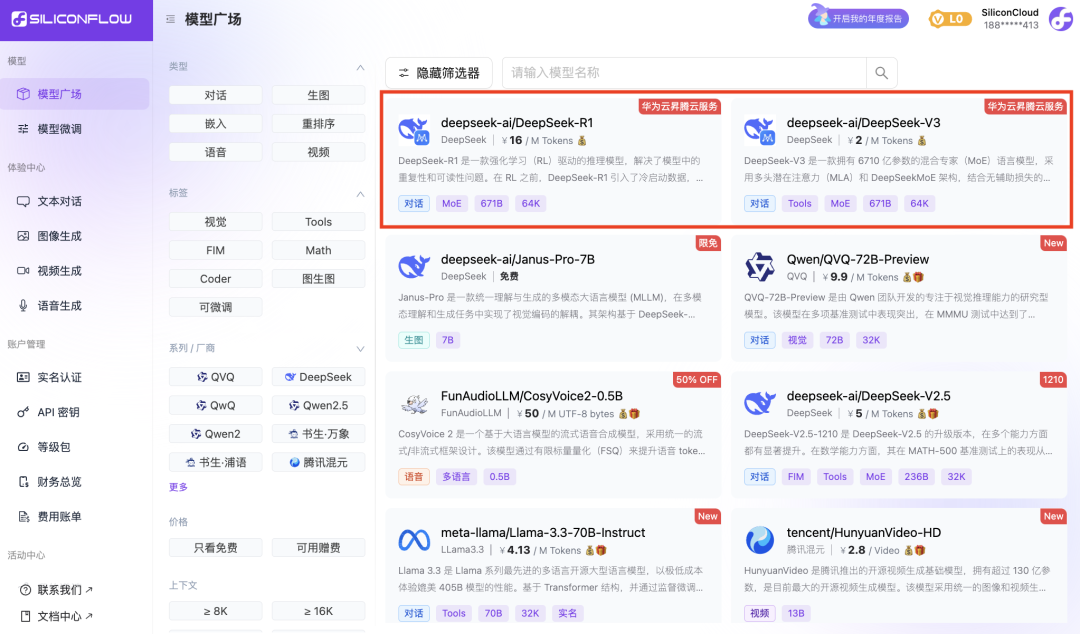

Az DeepSeek-R1 és az DeepSeek-V3 mellett a SiliconCloud a Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

több tucat nyílt forráskódú nagy nyelvi modell, kép/videó generáló modell, beszédmodell, kód/máté modell, valamint vektor és átrendező modell.

A platform lehetővé teszi a fejlesztők számára, hogy szabadon összehasonlítsák és kombinálják a különböző modalitások nagy modelljeit, hogy kiválaszthassák a legjobb gyakorlatot a generatív AI-alkalmazásukhoz.

Közülük több mint 20 nagy modell API, mint például a Qwen2.5 (7B) és a Llama3.1 (8B) ingyenesen használható, lehetővé téve a fejlesztők és a termékmenedzserek számára, hogy elérjék a "token szabadságot" anélkül, hogy aggódnának a számítási energia költségei miatt a kutatási és fejlesztési szakaszban és a nagyszabású promóció során.