Egyikünk sem számított arra, hogy így fog kezdődni 2025 a mesterséges intelligencia területén.

DeepSeek R1 igazán elképesztő!

Az utóbbi időben a "titokzatos keleti hatalom" DeepSeek "keményen irányítja" a Szilícium-völgyet.

Megkértem R1-et, hogy magyarázza el részletesen a Pitagorasz-tételt. Mindezt az AI kevesebb mint 30 másodperc alatt, hiba nélkül elvégezte. Röviden, vége.

A hazai és külföldi AI-körökben a hétköznapi netezők felfedezték a csodálatos és nagy teljesítményű új AI-t (amely ráadásul nyílt forráskódú), az akadémiai szakértők pedig azt kiáltották, hogy "fel kell zárkóznunk". Hallani olyan híreket is, hogy a tengerentúli AI-cégek máris komoly fenyegetéssel néznek szembe.

Vegyük csak ezt a héten megjelent DeepSeek R1-t. A tisztán megerősítéses tanulási útvonala mindenféle felügyelt képzés nélkül sokkoló. A Deepseek-v3 alap tavaly decemberi fejlesztésétől az OpenAI o1-hez hasonló jelenlegi gondolkodási lánc képességekig, úgy tűnik, hogy ez csak idő kérdése.

De miközben az AI közösség a technikai jelentések olvasásával és a tényleges mérések összehasonlításával van elfoglalva, az embereknek még mindig vannak kétségeik az R1-gyel kapcsolatban: azon túl, hogy képes egy csomó benchmarkot felülmúlni, vajon tényleg vezethet-e?

Tud-e saját szimulációkat készíteni a "fizikai törvényekről"?

Nem hiszed el? Hagyjuk a nagy modellt flipperrel játszani?

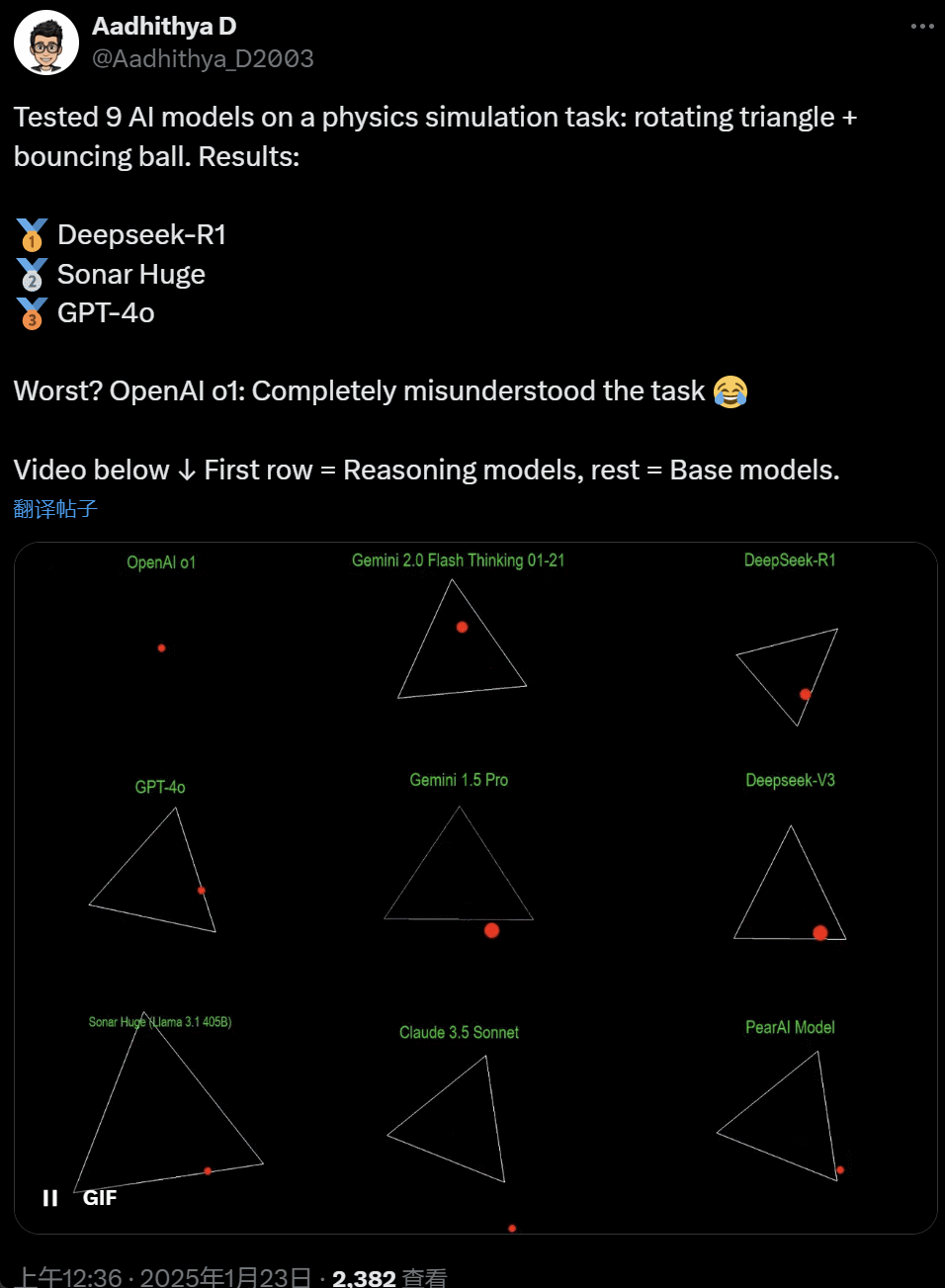

Az utóbbi napokban az AI közösségben néhányan megszállottjai lettek egy tesztnek - különböző AI nagy modellek (különösen az úgynevezett érvelő modellek) tesztelése egy probléma megoldására: "Írj egy Python szkriptet, hogy egy sárga labda egy bizonyos alakzaton belül pattogjon. Lassan forgasd el az alakzatot, és győződj meg róla, hogy a labda az alakzaton belül marad".

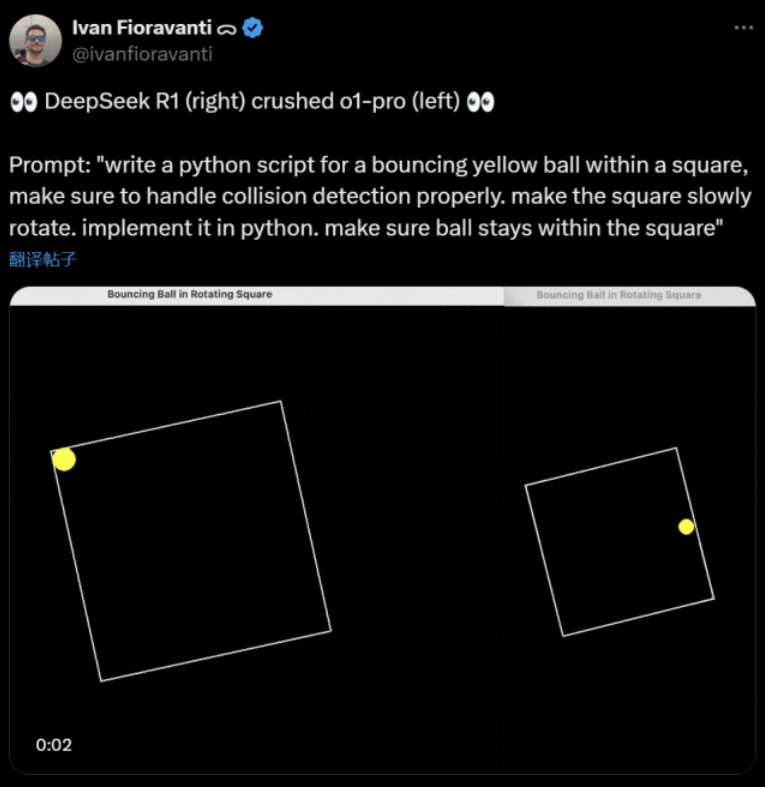

Egyes modellek jobban teljesítenek másoknál ebben a "forgó golyó" benchmarkban. A CoreView CTO-ja, Ivan Fioravanti szerint az DeepSeek, egy hazai mesterséges intelligencia laboratóriumnak van egy nyílt forráskódú nagy R1 modellje, amely veri az OpenAI o1 pro modelljét, amely az OpenAI ChatGPT Pro programjának részeként havonta $200-ba kerül.

A bal oldalon az OpenAI o1, a jobb oldalon pedig az DeepSeek R1. Mint fentebb említettük, a prompt itt a következő: "írj egy python szkriptet egy pattogó sárga labdára egy négyzetben, ügyelj arra, hogy az ütközésérzékelést megfelelően kezeld. a négyzetet lassan forgasd. implementáld pythonban. ügyelj arra, hogy a labda a négyzeten belül maradjon.".

Egy másik felhasználó szerint az X-en az Anthropic Claude 3.5 Sonnet és a Google Gemini 1.5 Pro modellek hibásan ítélték meg a fizikai elveket, ami miatt a labda eltért az alakjától. Néhány felhasználó arról is beszámolt, hogy a Google legújabb Gemini 2.0 Flash Thinking Experimental, valamint a viszonylag régebbi OpenAI GPT-4o is egyből átment az értékelésen.

De itt is meg lehet különböztetni:

A netezők a tweet alatt azt mondták: az o1 képessége eredetileg nagyon jó volt, de az OpenAI sebességének optimalizálása után gyengült, még az $200/hó tagsági verzióval is.

A pattogó labda szimulálása klasszikus programozási kihívás. A pontos szimuláció az ütközésérzékelő algoritmusokat kombinálja, amelyeknek azonosítaniuk kell, ha két objektum (például egy labda és egy alakzat oldala) ütközik. Egy helytelenül megírt algoritmus befolyásolhatja a szimuláció teljesítményét, vagy nyilvánvaló fizikai hibákat okozhat.

N8 Programs, a Nous Research AI startup kutatója elmondta, hogy körülbelül két órába telt neki, hogy a semmiből megírjon egy pattogó labdát egy forgó heptagonban. "Több koordinátarendszert kell követni, meg kell érteni, hogyan kezelik az ütközéseket az egyes rendszerekben, és a kódot a nulláról kell megtervezni, hogy robosztus legyen" - mondta.

Bár a pattogó labdák és a pörgő alakzatok a programozási készségek ésszerű tesztje, ezek még mindig új projektek a nagy modellek számára, és az utasítások kis változtatásai is eltérő eredményeket hozhatnak. Így ha végül a nagyméretű mesterséges intelligenciamodellek összehasonlító tesztjének részévé válik, akkor még javításra szorul.

Mindenesetre a gyakorlati tesztek e hulláma után már van némi érzékünk a nagy modellek közötti képességbeli különbségekről.

Az DeepSeek az új "Szilícium-völgyi mítosz".

Az DeepSeek pánikot kelt" a Csendes-óceánon.

A Meta alkalmazottai azt írták, hogy "a Meta mérnökei kétségbeesetten elemzik az DeepSeek-t, hogy megpróbáljanak bármit lemásolni belőle, amit csak tudnak".

Alexandr Wang, a Scale AI nevű AI technológiai startup alapítója szintén nyilvánosan kijelentette, hogy az DeepSeek AI nagy modelljének teljesítménye nagyjából megegyezik az Egyesült Államok legjobb modelljének teljesítményével.

Úgy véli továbbá, hogy az elmúlt évtizedben az Egyesült Államok megelőzhette Kínát az AI-versenyben, de az DeepSeek nagy AI-modelljének megjelenése "mindent megváltoztathat".

X Blogger @8teAPi úgy véli, hogy az DeepSeek nem egy "mellékprojekt", hanem olyan, mint a Lockheed Martin egykori "Skunk Works".

Az úgynevezett "Skunk Works" egy szigorúan bizalmas, viszonylag független kis csapatra utal, amelyet a Lockheed Martin eredetileg számos fejlett repülőgép kifejlesztésére hozott létre, és amely élvonalbeli vagy nem hagyományos technológiájú kutatással és fejlesztéssel foglalkozik. Az U-2 felderítő repülőgéptől és az SR-71 Blackbirdtől kezdve az F-22 Raptorig és az F-35 Lightning II vadászgépig mind innen származik.

Később a kifejezés fokozatosan általános kifejezéssé alakult, amelyet a nagyvállalatokon vagy szervezeteken belül létrehozott "kicsi, de finom", viszonylag független és rugalmasabb innovációs csapatok leírására használtak.

Két okot említett:

- Egyrészt az DeepSeek nagy számú GPU-val rendelkezik, állítólag több mint 10 000, sőt Alexandr Wang, a Scale AI vezérigazgatója szerint akár az 50 000-et is elérheti.

- Másrészt az DeepSeek csak a három legjobb kínai egyetemről toboroz tehetségeket, ami azt jelenti, hogy az DeepSeek ugyanolyan versenyképes, mint az Alibaba és a Tencent.

Már ez a két tény is azt mutatja, hogy az DeepSeek egyértelműen kereskedelmi sikert ért el, és elég ismert ahhoz, hogy ezeket a forrásokat megszerezze.

Ami az DeepSeek fejlesztési költségeit illeti, a blogger szerint a kínai technológiai vállalatok számos támogatást kaphatnak, például alacsony villamosenergia-költségeket és földhasználatot.

Ezért nagyon valószínű, hogy az DeepSeek költségeinek nagy részét az alaptevékenységen kívüli számlára vagy valamilyen adatközpont-építési támogatás formájában "helyezték el".

Még az alapítókon kívül sem érti senki teljesen az összes pénzügyi megállapodást. Egyes megállapodások egyszerűen "szóbeli megállapodások" lehetnek, amelyeket pusztán a hírnév alapján véglegesítenek.

Ettől függetlenül néhány dolog világos:

- A modell kiváló, az OpenAI által két hónappal ezelőtt kiadott változathoz hasonlítható, és természetesen lehetséges, hogy nem olyan jó, mint az új modellek, amelyeket az OpenAI és az Anthropic még nem adott ki.

- A jelenlegi szemszögből nézve a kutatási irányt még mindig az amerikai vállalatok dominálják. Az DeepSeek modell az o1 változat "gyors követése", de az DeepSeek kutatás-fejlesztési előrehaladása nagyon gyors, a vártnál gyorsabban felzárkózik. Nem plagizálnak vagy csalnak, legfeljebb visszafejlesztik.

- Az DeepSeek főként saját tehetségeket képez, és nem támaszkodik az Amerikában képzett PhD-kre, ami nagyban bővíti a tehetségek körét.

- Az amerikai vállalatokkal összehasonlítva az DeepSeek kevesebb korlátozásnak van kitéve a szellemi tulajdonjogok engedélyezése, a magánélet védelme, a biztonság, a politika stb. tekintetében, és kevesebb aggodalom merül fel az olyan adatok jogellenes felhasználásával kapcsolatban, amelyeken az emberek nem akarják, hogy képzést kapjanak. Kevesebb per, kevesebb ügyvéd és kevesebb aggály van.

Kétségtelen, hogy egyre többen hisznek abban, hogy 2025 meghatározó év lesz. Közben a vállalatok már készülnek rá. A Meta például 2GW+ adatközpontot épít, 2025-re $60-65 milliárdos becsült beruházással, és az év végére több mint 1,3 millió GPU-val fog rendelkezni.

A Meta még egy grafikonon is összehasonlította 2 gigawattos adatközpontját a New York-i Manhattannel.

De most az DeepSeek jobban teljesített alacsonyabb költséggel és kevesebb GPU-val. Hogy lehet, hogy ez nem nyugtalanítja az embereket?

Yann LeCun: Köszönetet kell mondanunk a CTO-nak és társalapítójának, a a nyílt forráskód

Hyperbolic, Yuchen Jin, hogy mindössze 4 nap alatt az DeepSeek-R1 4 tényt bizonyított nekünk:

- A nyílt forráskódú mesterséges intelligencia csak 6 hónappal van lemaradva a zárt forráskódú mesterséges intelligenciától

- Kína uralja a nyílt forráskódú mesterséges intelligencia versenyt

- A nagy nyelvi modellek megerősített tanulásának aranykorába lépünk

- A desztillációs modellek nagyon nagy teljesítményűek, és a mobiltelefonokon magas intelligenciájú mesterséges intelligenciát fogunk futtatni.

Az DeepSeek által kiváltott láncreakció még mindig tart, például az OpenAI o3-mini szabadon elérhetővé tétele, a közösség reménye, hogy csökken az AGI/ASI-val kapcsolatos homályos viták száma, és az a pletyka, hogy a Meta pánikba esett.

Úgy véli, nehéz megjósolni, hogy végül ki fog győzni, de nem szabad elfelejteni a későn érkező előnyének erejét. Elvégre mindannyian tudjuk, hogy a Google volt az, aki feltalálta a Transformert, míg az OpenAI szabadította fel annak valódi lehetőségeit.

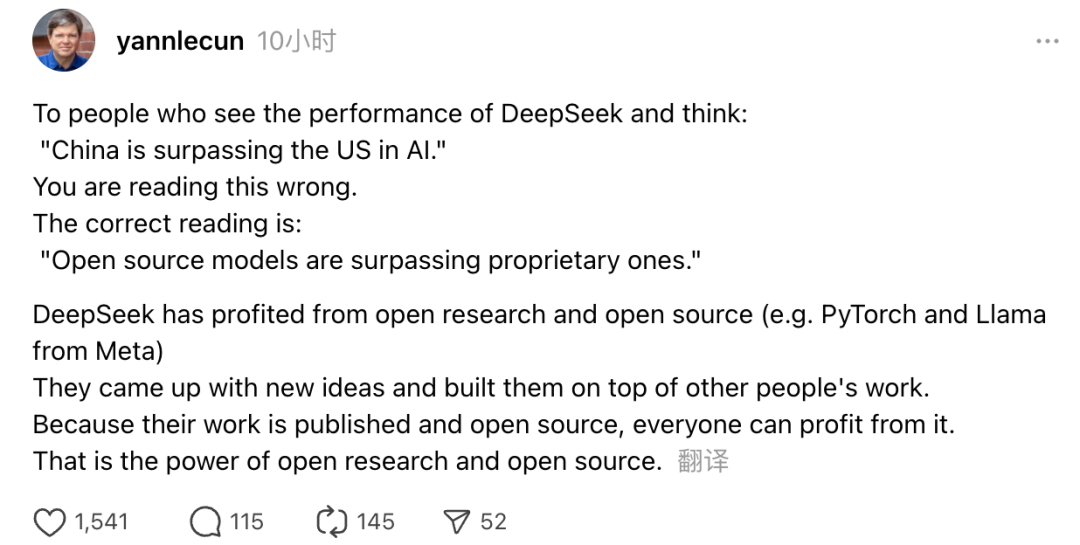

Emellett a Turing-díjas Yann LeCun, a Meta vezető mesterséges intelligencia kutatója is kifejtette véleményét.

"Azok, akik az DeepSeek teljesítményét látva azt gondolják, hogy "Kína megelőzi az USA-t a mesterséges intelligencia terén", tévednek. A helyes felfogás az, hogy a nyílt forráskódú modellek megelőzik a szabadalmaztatott modelleket."

LeCun elmondta, hogy az DeepSeek ezúttal azért tudott ekkora sikert elérni, mert a nyílt kutatás és a nyílt forráskód (például a Meta PyTorch és a Llama) jótékonyan hatott rájuk. Az DeepSeek új ötletekkel állt elő, és mások munkájára épített. Mivel a munkájuk nyilvánosan elérhető és nyílt forráskódú, mindenki profitálhat belőle. Ez a nyílt kutatás és a nyílt forráskód ereje.

A netezők reflexiói folytatódnak. Miközben izgatottak az új technológiák fejlődése miatt, egy kis szorongás hangulatát is érzik. Végül is az DeepSeekers megjelenése valódi hatással lehet.