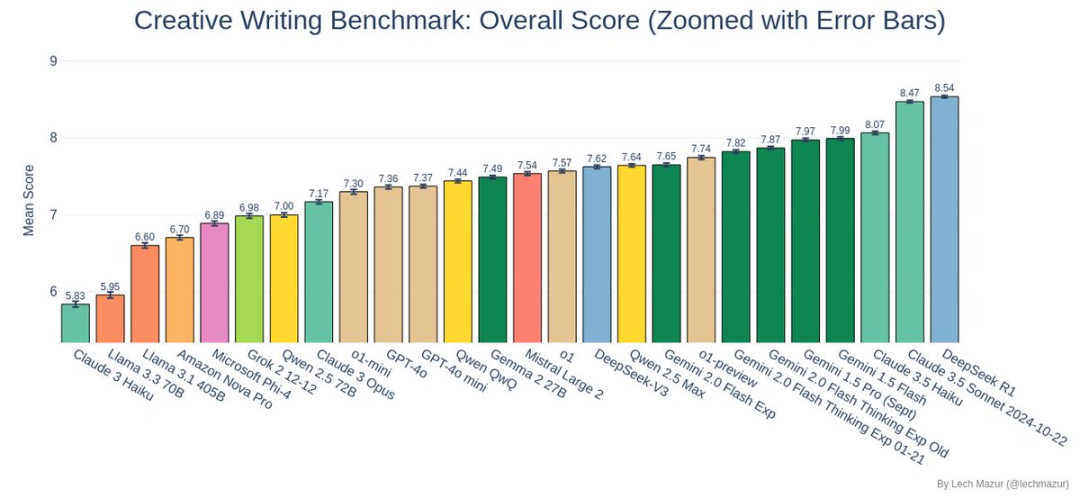

Az DeepSeek R1 nyerte a kreatív novellaírás benchmark tesztjének bajnokságát, sikeresen megelőzve a korábbi domináns játékost, Claude 3.5 Sonnet-t!

Benchmark teszt

A Lech Mazur kutató által tervezett benchmark teszt nem egy átlagos írásbeli verseny.

Minden mesterséges intelligenciamodellnek 500 rövid történetet kellett befejeznie, és minden egyes történetbe 10 véletlenszerűen kijelölt elemet kellett okosan beépíteni. Ez egy kihívást jelentő, nyílt végű írásbeli feladat volt a mesterséges intelligencia számára, amely nemcsak egy teljes történetszálat igényelt, hanem azt is biztosította, hogy az összes kijelölt elemet természetesen integrálják.

Bírálati módszer

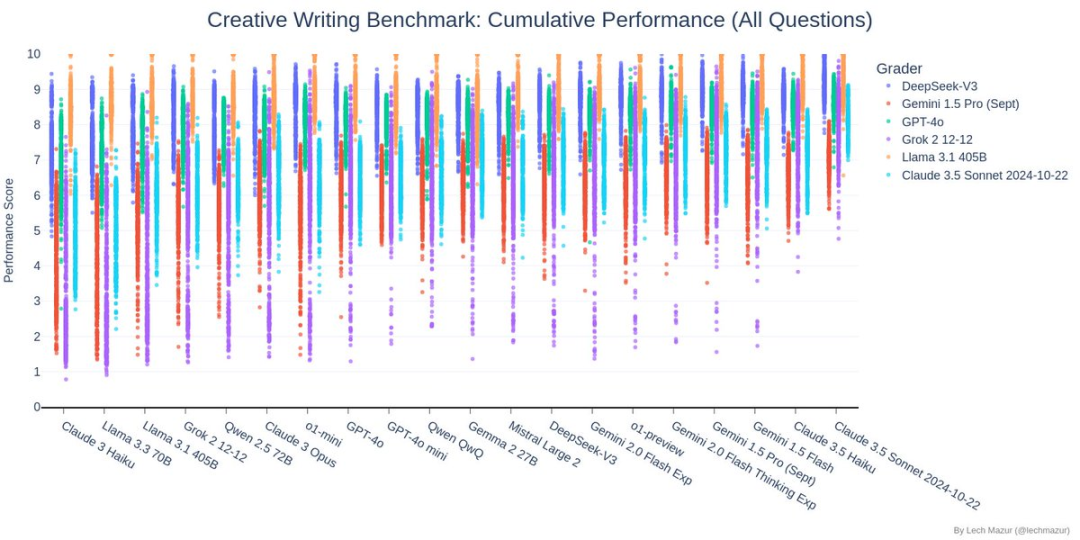

Ez az összehasonlító teszt egyedülálló pontozási rendszert használ: hat legjobb nyelvi modell bírál, akik a történet különböző szempontjait pontozzák. Más szóval a mesterséges intelligencia iparági vezetői magát a mesterséges intelligenciát bírálják, ami összességében viszonylag igazságos és szisztematikus értékelési mércét biztosít.

Teszt tartalma

A fenti ábra a kreatív írás teljesítményteszt pontszámainak korrelációs elemzését mutatja. DeepSeek több mint 0,93-as korrelációs együtthatóval rendelkezik más mainstream modellekkel (Claude, GPT-4o, Gemini és Grok), ami azt jelzi, hogy a kreatív írás minőségének megítélése során a többi csúcsmodellel igen konzisztens értékelési kritériumokkal rendelkezik, ami közvetve megerősíti megbízhatóságát ebben a tesztben.

A fenti táblázat a kreatív novellaírás összehasonlító tesztjének eredményeit mutatja. Minden mesterséges intelligenciamodellnek 500 történetet kellett írnia, amelyek mindegyikének 10 meghatározott véletlenszerű elemet kellett tartalmaznia. A diagram pontjai az egyes részt vevő mesterséges intelligenciamodellek pontszámának eloszlását mutatják a különböző pontozási modellek esetében (különböző színekkel ábrázolva).

A tesztben, MélySeek (sötétkék pontok) jól teljesített, pontszámainak többsége a táblázat felső felében koncentrálódott, és viszonylag koncentráltan, stabil és magas szintű kreatív íráskészséget mutat.

Ez a kiemelkedő teljesítmény lehetővé tette, hogy sikeresen megelőzze a korábbi bajnokot, a Claude 3.5 Sonnet-et, és az új benchmark tesztek vezetőjévé váljon.

Ebben a diagramban minden sor egy mesterséges intelligencia modellt, és minden oszlop egy értékelési dimenziót (például jellemzés, cselekménykoherencia stb.) jelöl. Az DeepSeek a diagram felső középső részén helyezkedik el, narancssárga árnyalattal, ami azt jelzi, hogy a legtöbb értékelési dimenzióban kiváló eredményeket ért el. Különösen a kivitelezés (Q6), a jellemzés (TA) és a cselekményfejlődés (TJ) kulcsfontosságú dimenzióiban ért el magas, közel 8 pontos pontszámot. Bár az egyes dimenziókban talán nem a legfényesebb sárga, nincsenek nyilvánvaló gyengeségei.

Amint az a diagramon látható, az DeepSeek történetének pontszámai többnyire 7 és 9 pont között oszlanak meg, és az eloszlás viszonylag koncentrált. Érdekes módon a trendvonala majdnem vízszintes, ami azt jelzi, hogy az DeepSeek történetének minősége nincs szoros összefüggésben a történet hosszával. Más szóval, akár hosszú, akár rövid történetet ír, az DeepSeek képes fenntartani az egyenletesen magas színvonalú kimenetet. Ez azt mutatja, hogy Az DeepSeek inkább a minőségre, mint a mennyiségre összpontosít a létrehozás során, és képes fenntartani a kiváló teljesítményt. különböző hosszúságú történetekben.

Miért nem DeepSeek R1 győzelem?

A teszteredmények alapján az DeepSeek R1 elképesztően jól teljesített:

- Átfogó történet-integrációs képességek: R1 elképesztő rugalmasságot és kreativitást mutatott a történet különböző elemeinek kombinálásakor.

- Stabil kimeneti minőség: A pontszámeloszlási diagram alapján az R1 nemcsak magas átlagpontszámot ért el, hanem stabil teljesítményt is, kisebb ingadozással.

- Kiemelkedő kreatív teljesítmény: Ebben a benchmark tesztben az R1 által készített történetek az első három közé kerültek, ami bizonyítja a kreatív írás kiemelkedő képességét.

Hogyan teljesített a többi versenyző?

Az DeepSeek R1 és a Claude 3.5 Sonnet közötti izgalmas leszámolás mellett más modellek teljesítményét is érdemes megemlíteni:

- A Gemini sorozat jól teljesített

- A Llama 3.x sorozat egy kicsit küszködött ebben a tesztben

- Az o3-mini nem teljesített jól, a 22. helyen végzett.

Végül

Az DeepSeek R1 áttörése ebben a tesztben megmutatta, hogy a kreativitás terén milyen végtelen lehetőségek rejlenek a mesterséges intelligenciában. Bár az AI-alkotás még mindig a folyamatos fejlődés útját járja, az ilyen eredmények már most tele vannak várakozásokkal a jövőre nézve.

Azok, akik többet szeretnének megtudni a teszt részleteiről, Lech Mazur GitHubjában megtalálják a teljes adatanyagot és a legjobb történetek példáit. Várjuk együtt a további áttöréseket az AI kreatív írás területén!