DeepSeek R1는 창작 단편 소설 쓰기 벤치마크 테스트에서 기존의 강자였던 클로드 3.5 소네트를 제치고 우승을 차지했습니다!

벤치마크 테스트

레흐 마주르 연구원이 설계한 벤치마크 테스트는 일반적인 글쓰기 대회와는 다릅니다.

각 AI 모델은 500개의 단편 스토리를 완성해야 했고, 각 스토리에는 무작위로 할당된 10개의 요소를 교묘하게 통합해야 했습니다. 이는 완전한 스토리라인이 필요할 뿐만 아니라 할당된 모든 요소가 자연스럽게 통합되어야 하는 AI에게 까다로운 개방형 글쓰기 과제였습니다.

심사 방법

이 벤치마크 테스트는 6명의 최고 언어 모델이 심사위원으로 활동하며 다양한 측면에 점수를 매기는 독특한 채점 시스템을 사용합니다. 즉, 인공지능 업계 리더들이 인공지능 자체를 평가하기 때문에 전반적으로 비교적 공정하고 체계적인 평가 기준을 제공합니다.

콘텐츠 테스트

위 차트는 창의적 글쓰기 벤치마크 테스트에서 채점자의 상관관계 분석을 보여줍니다. DeepSeek 의 상관계수는 0.93 이상으로 다른 주요 모델(클로드, GPT-4o, 제미니, 그로크)과의 상관계수가 0.93 이상으로, 창작 글의 품질을 판단할 때 다른 상위 모델과 매우 일관된 판단 기준을 가지고 있음을 나타내며 이 테스트에서 신뢰성을 간접적으로 확인할 수 있습니다.

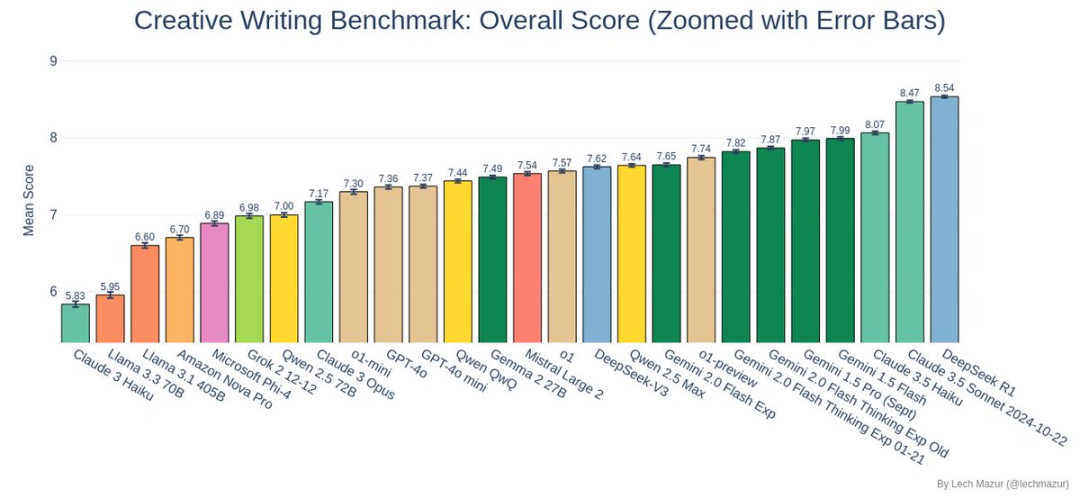

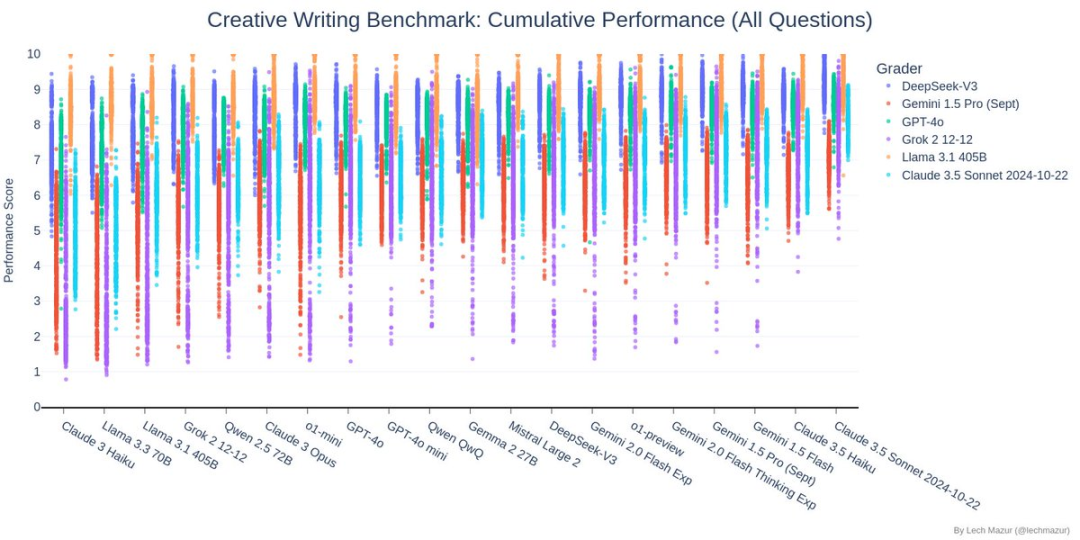

위 차트는 창작 단편 소설 쓰기 벤치마크 테스트의 결과를 보여줍니다. 각 AI 모델은 500개의 스토리를 작성해야 했으며, 각 스토리에는 10개의 지정된 무작위 요소가 포함되어야 했습니다. 차트의 점수는 각 참여 AI 모델의 점수 분포(다른 색상으로 표시)를 보여줍니다.

테스트에서, DeepSeek (진한 파란색 점수)는 대부분의 점수가 차트 상단에 집중되어 있고 상대적으로 집중도가 높아 안정적이고 높은 수준의 창의적 글쓰기 능력을 보여주며 좋은 성적을 거두었습니다.

이러한 뛰어난 성능 덕분에 이전 챔피언인 클로드 3.5 소네트를 제치고 새로운 벤치마크 테스트 리더로 등극할 수 있었습니다.

이 차트에서 각 행은 AI 모델을 나타내고 각 열은 평가 차원(예: 특성화, 플롯 일관성 등)을 나타냅니다. DeepSeek는 차트 상단 중앙에 위치하며 전체적으로 주황색-노란색을 띠고 있어 대부분의 평가 차원에서 우수한 결과를 얻었음을 나타냅니다. 특히 핵심 평가 차원인 실행(Q6), 특성화(TA), 플롯 개발(TJ)에서 8점에 가까운 높은 점수를 획득했습니다. 개별 차원에서는 가장 밝은 노란색은 아니지만, 뚜렷한 약점은 없습니다.

차트에서 볼 수 있듯이 DeepSeek의 스토리 점수는 대부분 7~9점 사이에 분포되어 있으며, 상대적으로 편중되어 있습니다. 흥미로운 점은 추세선이 거의 수평에 가깝다는 것인데, 이는 DeepSeek의 스토리 품질이 스토리의 길이와 밀접한 관련이 없음을 나타냅니다. 즉, 장편이든 단편이든 DeepSeek는 일관되게 높은 품질의 결과물을 유지할 수 있습니다. 이는 다음을 보여줍니다. DeepSeek는 제작 시 양보다 질에 더 집중하며 우수한 성능을 유지할 수 있습니다. 다양한 길이의 스토리로 구성됩니다.

왜 그랬나요? DeepSeek R1 승리?

테스트 결과를 보면 DeepSeek R1의 성능은 놀랍습니다:

- 포괄적인 스토리 통합 기능: R1은 다양한 스토리 요소의 조합을 다룰 때 놀라운 유연성과 창의성을 보여주었습니다.

- 안정적인 출력 품질: 점수 분포도를 보면 R1은 평균 점수가 높았을 뿐만 아니라 변동폭이 적고 안정적인 성능을 보였습니다.

- 뛰어난 크리에이티브 성능: 이번 벤치마크 테스트에서 R1이 제작한 스토리는 전체 상위 3위 안에 들며 크리에이티브 글쓰기에서 뛰어난 능력을 입증했습니다.

다른 참가자들의 성적은 어땠나요?

DeepSeek R1와 클로드 3.5 소네트의 흥미진진한 대결 외에도 다른 모델들의 성능도 주목할 만합니다:

- 제미니 시리즈는 좋은 성과를 거두었습니다.

- Llama 3.x 시리즈는 이 테스트에서 약간 어려움을 겪었습니다.

- o3-mini는 22위로 좋은 성적을 거두지 못했습니다.

마지막으로

이번 테스트에서 DeepSeek R1는 창의성 분야에서 AI의 무한한 가능성을 보여주었습니다. AI 창작은 아직 지속적인 개선의 길에 있지만, 이러한 결과는 이미 미래에 대한 기대감으로 가득 차 있습니다.

테스트의 세부 사항에 대해 더 자세히 알고 싶은 분들은 Lech Mazur의 GitHub를 방문하여 전체 데이터와 우수 사례의 예를 확인할 수 있습니다. AI 크리에이티브 글쓰기의 더 많은 혁신을 함께 기대해 주세요!