DeepSeek-R1 en DeepSeek-V3 hebben een wereldwijde sensatie veroorzaakt sinds hun open source lancering.

Ze zijn een geschenk van het DeepSeek team aan de hele mensheid, en we zijn oprecht blij voor hun succes.

Na dagen hard werken door de Silicon Mobility en Huawei Cloud teams, geven we vandaag ook Chinese gebruikers een Chinees Nieuwjaarscadeau: Het grootschalige model cloud service platform SiliconCloud heeft de DeepSeek-V3 en DeepSeek-R1 gelanceerd, die zijn gebaseerd op de Ascend cloud service van Huawei Cloud.

Het moet worden benadrukt dat we hebben grote steun van DeepSeek en Huawei Cloud ontvangen, zowel in het aanpassen van DeepSeek-R1 & V3 op Ascend en in het proces van de lancering van andere modellen eerder, en we willen diepe dankbaarheid en hoog respect.

Kenmerken

Deze twee door SiliconCloud gelanceerde modellen bevatten voornamelijk vijf belangrijke functies:

Op basis van Huawei Cloud's Ascend cloud service, hebben we de DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 modelinferentieservice voor de eerste keer.

Door gezamenlijke innovatie tussen de twee partijen en met de ondersteuning van de zelf ontwikkelde inferentieversnellingsengine, kan het DeepSeek-model dat door het Silicon Mobility-team wordt ingezet op basis van de Ascend-cloudservice van Huawei Cloud hetzelfde effect bereiken als een high-end GPU-implementatiemodel in de wereld.

Aanbieden van stabiele DeepSeek-R1 & V3 inferentieservices op productieniveau. Hierdoor kunnen ontwikkelaars stabiel draaien in grootschalige productieomgevingen en voldoen aan de behoeften van commerciële inzet. Huawei Cloud Ascend AI diensten bieden overvloedige, elastische en voldoende rekenkracht.

Er is geen implementatiedrempel, waardoor ontwikkelaars zich meer kunnen richten op de ontwikkeling van applicaties. Bij het ontwikkelen van applicaties kunnen ze direct de SiliconCloud API aanroepen, wat een eenvoudigere en gebruiksvriendelijkere ervaring oplevert.

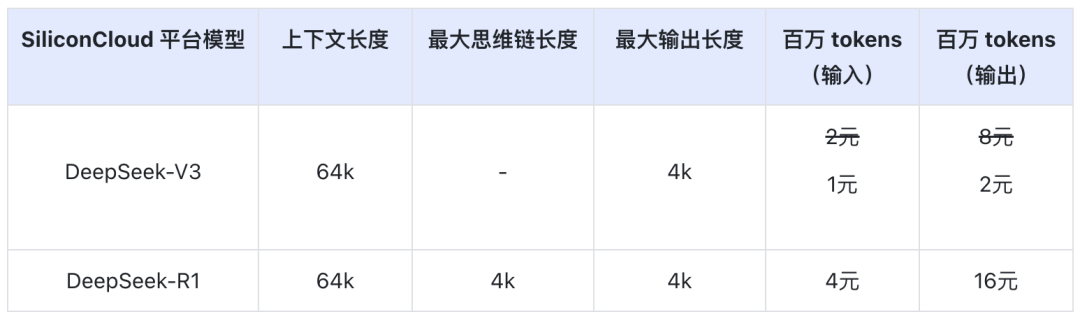

De DeepSeek-V3 prijs op SiliconCloud tijdens de officiële kortingsperiode (tot 24:00 op 8 februari) is ¥1 / M tokens (input) & ¥2 / M tokens (output), en de DeepSeek-R1 prijs is ¥4 / M tokens (input) & ¥16 / M tokens (output).

Online ervaring

DeepSeek-R1 met SiliconCloud

DeepSeek-V3 met SiliconCloud

API-documentatie

Ontwikkelaars kunnen het effect van DeepSeek-R1 & V3 versneld op binnenlandse chips ervaren op SiliconCloud. De hogere uitvoersnelheid wordt nog steeds voortdurend geoptimaliseerd.

Ervaring met klanttoepassingen

Als u het DeepSeek-R1 & V3-model rechtstreeks in de clienttoepassing wilt ervaren, kunt u de volgende producten lokaal installeren en toegang krijgen tot de SiliconCloud API (u kunt deze twee modellen aanpassen en toevoegen) om de DeepSeek-R1 & V3 te ervaren.

- Grote modelclienttoepassingen: ChatBox, Kersen Studio, OneAPI, LobeChat, NextChat

- Toepassingen voor het genereren van codes: CursorWindsurfen, Cline

- Ontwikkelplatform voor grote modeltoepassingen:Dify

- AI-kennisbank:Obsidiaan AIenFastGPT

- Vertaalplug-in:Immersief Vertalen en Eurodict

Voor meer tutorials over het openen van scenario's en toepassingsgevallen, zie hier

Tokenfabriek SiliconCloud

Qwen2.5 (7B), enz. 20+ modellen gratis te gebruiken

Als one-stop cloudserviceplatform voor grote modellen streeft SiliconCloud ernaar ontwikkelaars model-API's te bieden die ultrasnel reageren, betaalbaar en uitgebreid zijn en een zijdezachte ervaring bieden.

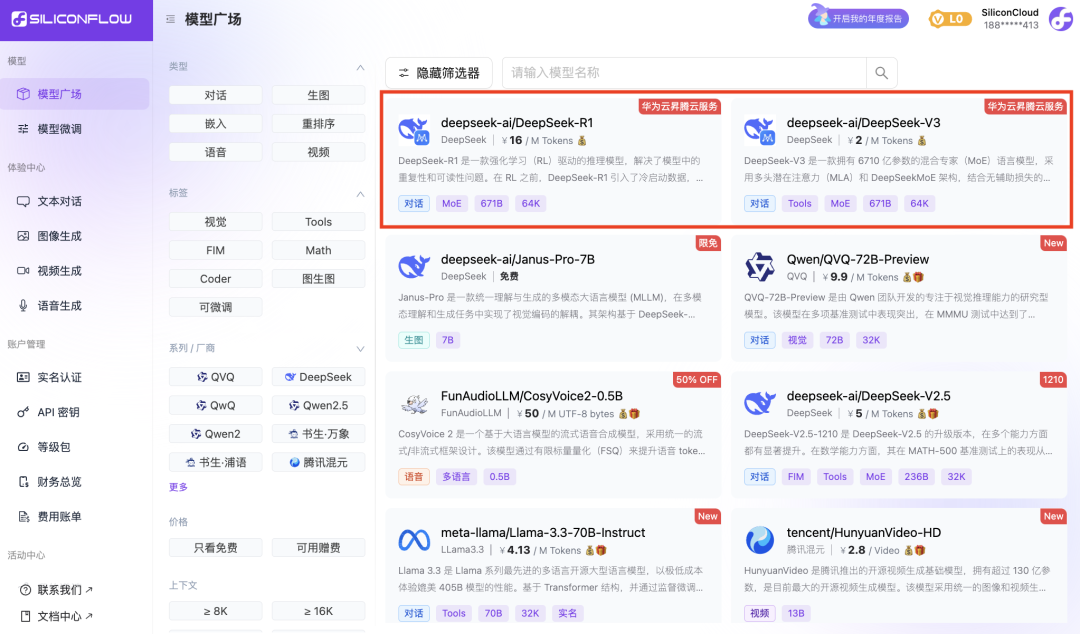

Naast DeepSeek-R1 en DeepSeek-V3 heeft SiliconCloud ook Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

tientallen open source grote taalmodellen, modellen voor het genereren van afbeeldingen/video's, spraakmodellen, code/wiskunde-modellen en vector- en herordeningsmodellen.

Met het platform kunnen ontwikkelaars vrijelijk grote modellen van verschillende modaliteiten vergelijken en combineren om de beste praktijk te kiezen voor uw generatieve AI-toepassing.

Daaronder zijn meer dan 20 grote model-API's zoals Qwen2.5 (7B) en Llama3.1 (8B) gratis te gebruiken, waardoor ontwikkelaars en productmanagers "tokenvrijheid" kunnen bereiken zonder zich zorgen te hoeven maken over de kosten van rekenkracht tijdens de onderzoeks- en ontwikkelingsfase en grootschalige promotie.