Niemand van ons had verwacht dat 2025 zo zou beginnen op het gebied van AI.

DeepSeek R1 is echt geweldig!

Onlangs heeft de "mysterieuze oosterse macht" DeepSeek Silicon Valley "hard gecontroleerd".

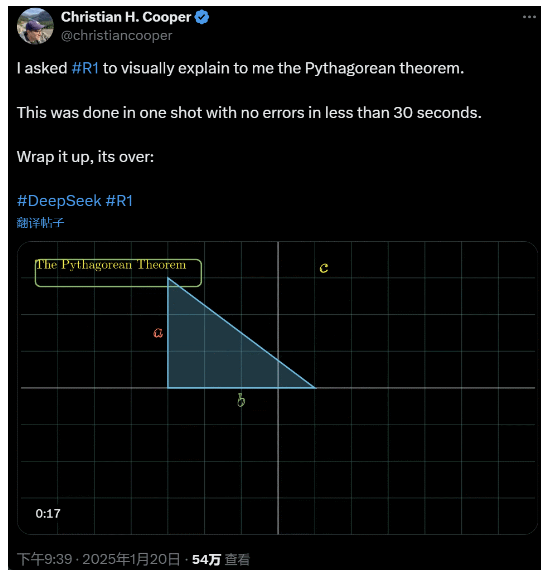

Ik vroeg R1 om de stelling van Pythagoras in detail uit te leggen. Dit alles werd door de AI gedaan in minder dan 30 seconden zonder fouten. Kortom, het is voorbij.

In binnen- en buitenlandse AI-kringen hebben gewone netizens de verbazingwekkende en krachtige nieuwe AI (die ook open source is) ontdekt en academische experts hebben geroepen "we moeten een inhaalslag maken". Er gaan ook geruchten dat overzeese AI-bedrijven al een grote bedreiging vormen.

Neem nu deze DeepSeek R1 die deze week is uitgebracht. De pure reinforcement learning-route zonder enige supervised training is schokkend. Van de ontwikkeling van de Deepseek-v3 basis in december vorig jaar tot de huidige denkketencapaciteiten vergelijkbaar met OpenAI o1, lijkt het een kwestie van tijd.

Maar terwijl de AI-gemeenschap druk bezig is met het lezen van technische rapporten en het vergelijken van daadwerkelijke metingen, hebben mensen nog steeds twijfels over R1: kan het, behalve beter presteren dan een stel benchmarks, echt leiden?

Kan het zijn eigen simulaties van "natuurkundige wetten" bouwen?

Geloof je het niet? Laten we het grote model met een flipperkast spelen?

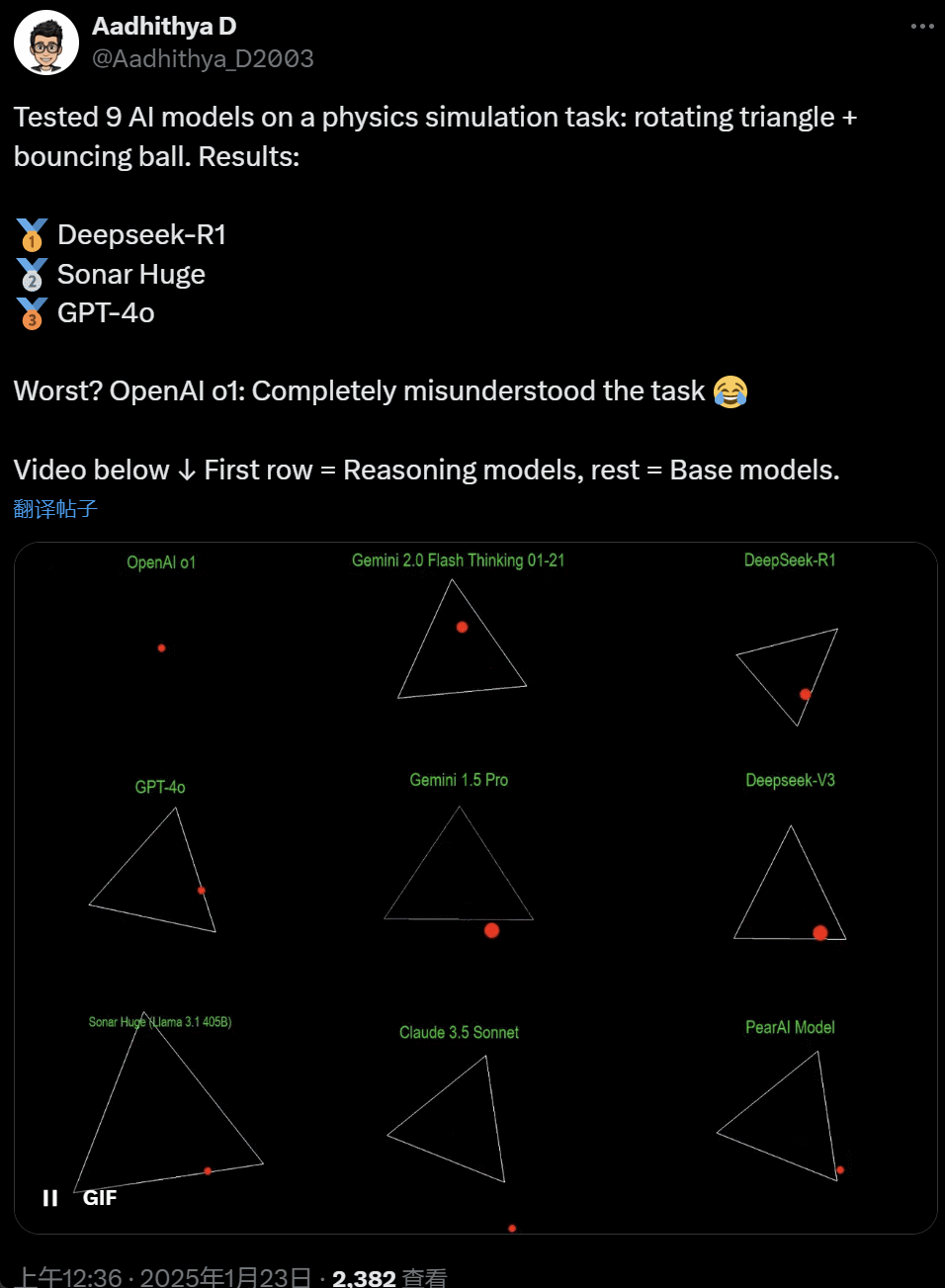

De afgelopen dagen zijn sommige mensen in de AI-gemeenschap geobsedeerd geraakt door een test - het testen van verschillende grote AI-modellen (vooral de zogenaamde redeneermodellen) om een probleem op te lossen: "Schrijf een Python-script om een gele bal binnen een bepaalde vorm te laten stuiteren. Laat de vorm langzaam draaien en zorg ervoor dat de bal binnen de vorm blijft."

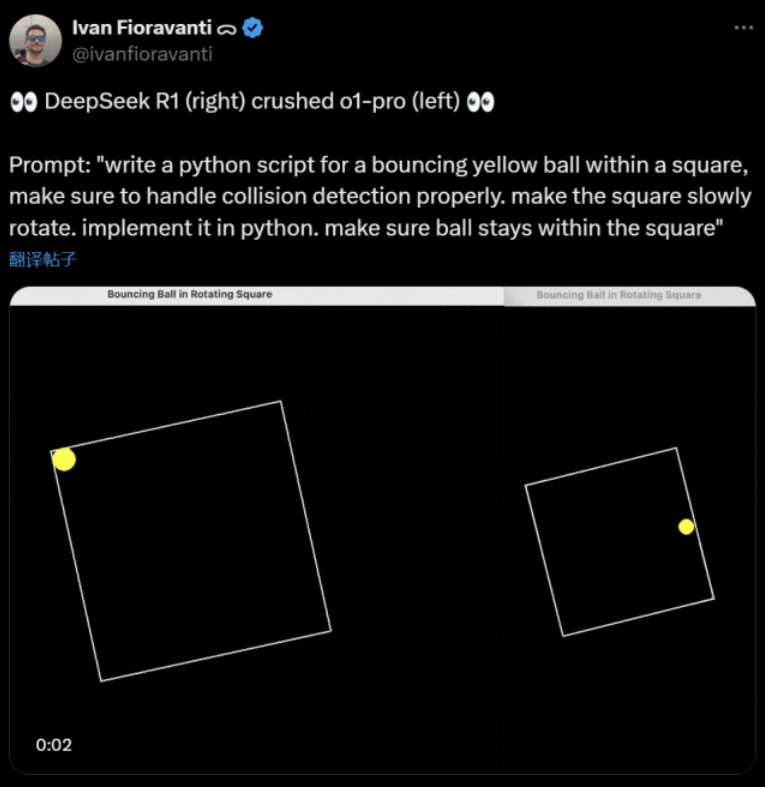

Sommige modellen presteren beter dan andere in deze "roterende bal" benchmark. Volgens CoreView CTO Ivan Fioravanti heeft DeepSeek, een laboratorium voor kunstmatige intelligentie in eigen land, een open source groot model R1 dat OpenAI's o1 pro-model verslaat, dat $200 per maand kost als onderdeel van OpenAI's ChatGPT Pro-programma.

Links staat OpenAI o1 en rechts DeepSeek R1. Zoals hierboven vermeld, is de opdracht hier: "schrijf een python script voor een stuiterende gele bal binnen een vierkant, zorg ervoor dat je botsingsdetectie goed afhandelt. laat het vierkant langzaam draaien. implementeer het in python. zorg ervoor dat bal binnen het vierkant blijft."

Volgens een andere gebruiker op X deden de modellen Anthropic Claude 3.5 Sonnet en Google's Gemini 1.5 Pro onjuiste uitspraken over natuurkundige principes, waardoor de bal afweek van zijn vorm. Sommige gebruikers meldden ook dat Google's nieuwste Gemini 2.0 Flash Thinking Experimental, evenals de relatief oudere OpenAI GPT-4o, in één keer slaagden voor de beoordeling.

Maar er is hier een manier om het verschil te zien:

Netizens onder deze tweet zeiden: o1's vermogen was oorspronkelijk erg goed, maar het werd zwakker nadat OpenAI de snelheid optimaliseerde, zelfs met de $200/maand lidmaatschapsversie.

Het simuleren van een stuiterende bal is een klassieke programmeeruitdaging. Nauwkeurige simulatie combineert botsingsdetectiealgoritmes, die moeten identificeren wanneer twee objecten (zoals een bal en de zijkant van een vorm) botsen. Een verkeerd geschreven algoritme kan de prestaties van de simulatie beïnvloeden of duidelijke fysieke fouten veroorzaken.

N8 Programs, een onderzoeker bij AI startup Nous Research, zei dat het hem ongeveer twee uur kostte om een stuiterende bal in een roterende zevenhoek vanaf nul te schrijven. "Er moeten meerdere coördinaatsystemen worden gevolgd, je moet begrijpen hoe botsingen in elk systeem worden afgehandeld en de code moet helemaal opnieuw worden ontworpen om robuust te zijn."

Hoewel stuiterende ballen en draaiende vormen een redelijke test van programmeervaardigheden zijn, zijn het nog steeds nieuwe projecten voor grote modellen, en zelfs kleine veranderingen in de aanwijzingen kunnen verschillende resultaten opleveren. Dus als het uiteindelijk onderdeel moet worden van de benchmarktest voor grote AI-modellen, moet het nog worden verbeterd.

In elk geval hebben we na deze golf van praktijktests een idee van de verschillen in mogelijkheden tussen de grote modellen.

DeepSeek is de nieuwe "Silicon Valley mythe

DeepSeek veroorzaakt paniek" over de hele Stille Oceaan.

Meta-werknemers hebben gepost dat "Meta-ingenieurs verwoed DeepSeek analyseren om te proberen er alles uit te kopiëren wat ze kunnen."

Alexandr Wang, oprichter van AI-technologie startup Scale AI, heeft ook publiekelijk verklaard dat de prestaties van DeepSeek's grote AI-model ongeveer gelijk zijn aan het beste model in de Verenigde Staten.

Hij is ook van mening dat de Verenigde Staten de afgelopen tien jaar misschien voor lagen op China in de AI-competitie, maar dat de lancering van het grote AI-model van DeepSeek "alles kan veranderen".

X Blogger @8teAPi gelooft dat DeepSeek geen "zijproject" is, maar lijkt op Lockheed Martin's vroegere "Skunk Works".

De zogenaamde "Skunk Works" verwijst naar een zeer vertrouwelijk, relatief onafhankelijk klein team dat Lockheed Martin oorspronkelijk had opgericht om veel geavanceerde vliegtuigen te ontwikkelen, die zich bezighielden met geavanceerd of onconventioneel technologisch onderzoek en ontwikkeling. Van het U-2 verkenningsvliegtuig en de SR-71 Blackbird tot de F-22 Raptor en het F-35 Lightning II gevechtsvliegtuig, ze kwamen allemaal hier vandaan.

Later evolueerde de term geleidelijk naar een algemene term die gebruikt wordt om "kleine maar fijne", relatief onafhankelijke en meer flexibele innovatieteams te beschrijven die opgezet zijn binnen grote bedrijven of organisaties.

Hij gaf twee redenen:

- Aan de ene kant heeft DeepSeek een groot aantal GPU's, naar verluidt meer dan 10.000, en Alexandr Wang, CEO van Scale AI, zei zelfs dat het er 50.000 zouden kunnen worden.

- Aan de andere kant rekruteert DeepSeek alleen talent van de drie beste universiteiten in China, wat betekent dat DeepSeek net zo concurrerend is als Alibaba en Tencent.

Deze twee feiten alleen al tonen aan dat DeepSeek duidelijk commercieel succes heeft geboekt en bekend genoeg is om deze middelen te verkrijgen.

Wat de ontwikkelingskosten van DeepSeek betreft, zei de blogger dat Chinese technologiebedrijven verschillende subsidies kunnen krijgen, zoals lage elektriciteitskosten en landgebruik.

Daarom is het zeer waarschijnlijk dat de meeste kosten van DeepSeek zijn "geplaatst" op een rekening buiten de kernactiviteiten of in de vorm van een soort subsidie voor de bouw van datacenters.

Zelfs buiten de oprichters begrijpt niemand alle financiële afspraken volledig. Sommige overeenkomsten kunnen gewoon "mondelinge overeenkomsten" zijn die alleen op basis van reputatie worden gesloten.

Hoe dan ook, een paar dingen zijn duidelijk:

- Het model is uitstekend, vergelijkbaar met de versie die OpenAI twee maanden geleden uitbracht, en het is natuurlijk mogelijk dat het niet zo goed is als de nieuwe modellen die OpenAI en Anthropic nog moeten uitbrengen.

- Vanuit het huidige perspectief wordt de onderzoeksrichting nog steeds gedomineerd door Amerikaanse bedrijven. Het DeepSeek-model is een "snelle opvolger" van de o1-versie, maar de vooruitgang in onderzoek en ontwikkeling van DeepSeek gaat erg snel en ze halen hun achterstand sneller in dan verwacht. Ze plegen geen plagiaat of bedrog, ze doen hooguit aan reverse engineering.

- DeepSeek leidt vooral eigen talent op in plaats van te vertrouwen op in Amerika opgeleide PhD's, waardoor de talentenpool enorm wordt uitgebreid.

- Vergeleken met Amerikaanse bedrijven heeft DeepSeek te maken met minder beperkingen op het gebied van licenties voor intellectueel eigendom, privacy, beveiliging, politiek, enzovoort. Er zijn minder rechtszaken, minder advocaten en minder zorgen.

Het lijdt geen twijfel dat steeds meer mensen geloven dat 2025 een beslissend jaar wordt. Ondertussen bereiden bedrijven zich erop voor. Meta, bijvoorbeeld, bouwt een 2GW+ datacenter, met een geschatte investering van $60-65 miljard tegen 2025, en zal tegen het einde van het jaar meer dan 1,3 miljoen GPU's hebben.

Meta gebruikte zelfs een grafiek om zijn datacenter van 2 gigawatt te vergelijken met Manhattan, New York.

Maar nu heeft DeepSeek het beter gedaan met lagere kosten en minder GPU's. Hoe kan dit mensen niet ongerust maken?

Yann LeCun: We moeten de CTO en medeoprichter van de open bron

Hyperbolisch, Yuchen Jin, voor het posten dat in slechts 4 dagen, DeepSeek-R1 4 feiten aan ons heeft bewezen:

- Open source AI loopt slechts 6 maanden achter op closed source AI

- China domineert de open source AI-competitie

- We gaan de gouden eeuw van het leren van grote taalmodellen in

- Destillatiemodellen zijn zeer krachtig en we zullen zeer intelligente AI op mobiele telefoons laten draaien.

De kettingreactie die door DeepSeek op gang werd gebracht, gaat nog steeds door, zoals het vrij beschikbaar stellen van OpenAI o3-mini, de hoop in de gemeenschap om de vage discussies over AGI/ASI te verminderen en het gerucht dat Meta in paniek is.

Volgens hem is het moeilijk te voorspellen wie er uiteindelijk zal winnen, maar we mogen de kracht van het voordeel van de laatkomer niet vergeten. We weten tenslotte allemaal dat het Google was die Transformer uitvond, terwijl OpenAI het ware potentieel ervan ontsloot.

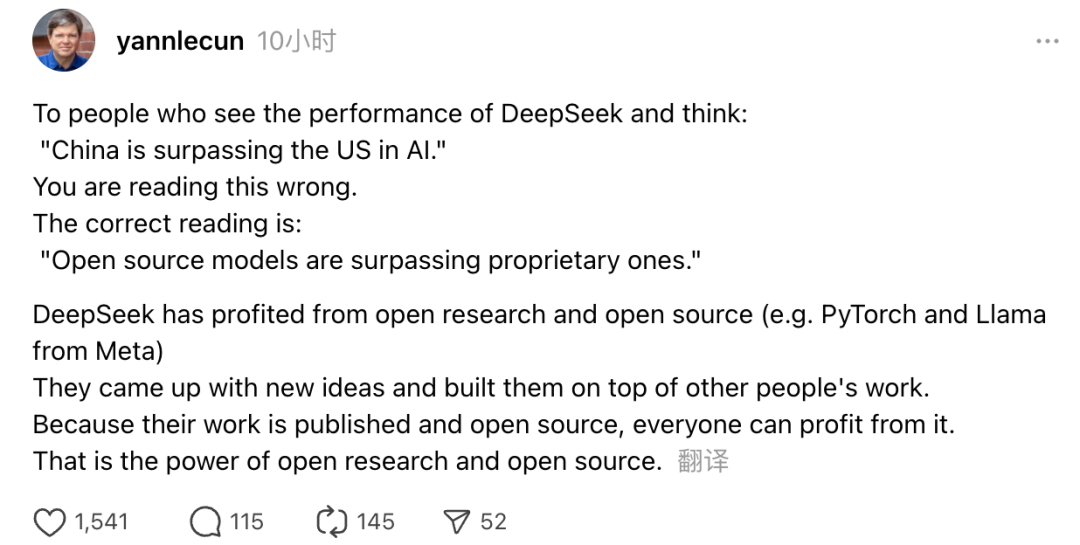

Daarnaast gaf ook Turing Award-winnaar en Meta's Chief AI Scientist Yann LeCun zijn mening.

"Wie bij het zien van de prestaties van DeepSeek denkt: 'China haalt de VS in op het gebied van AI', heeft het mis. Het juiste begrip is dat open source modellen propriëtaire modellen aan het inhalen zijn."

LeCun zei dat de reden dat DeepSeek deze keer zo'n grote sprong voorwaarts heeft gemaakt, is omdat ze hebben geprofiteerd van open onderzoek en open source (zoals PyTorch en Llama van Meta). DeepSeek is met nieuwe ideeën gekomen en heeft voortgebouwd op het werk van anderen. Omdat hun werk publiekelijk is vrijgegeven en open source is, kan iedereen ervan profiteren. Dit is de kracht van open onderzoek en open source.

De overpeinzingen van internetgebruikers gaan door. Hoewel ze enthousiast zijn over de ontwikkeling van nieuwe technologieën, voelen ze ook een kleine sfeer van bezorgdheid. De opkomst van DeepSeekers kan immers een echte impact hebben.