o3-mini przybył późno w nocy, a OpenAI w końcu ujawnił swój najnowszy atut. Podczas Reddit AMA Q&A, Altman głęboko wyznał, że stał po złej stronie open source AI.

Powiedział, że rozważana jest wewnętrzna strategia open source, a model będzie nadal rozwijany, ale przewaga OpenAI nie będzie tak duża jak wcześniej.

Podczas gdy wszyscy wciąż zachwycali się niesamowitą mocą DeepSeek, OpenAI w końcu nie mogło dłużej usiedzieć w miejscu.

Wczoraj wczesnym rankiem o3-mini został pilnie uruchomiony, ustanawiając nowe SOTA w testach porównawczych, takich jak kod matematyczny i powrót na tron.

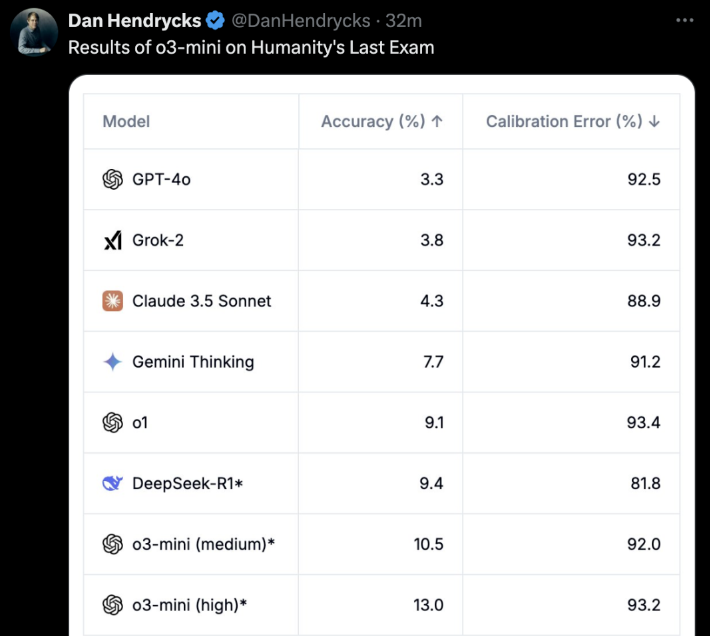

Najważniejsze jest to, że darmowi użytkownicy również mogą tego doświadczyć! o3-mini to nie żart. W "ostatnim egzaminie dla ludzi", o3-mini (wysoki) bezpośrednio osiągnął najlepszą dokładność i błąd kalibracji.

Kilka godzin później o3-mini został uruchomionyOpenAI oficjalnie otworzyło Reddit AMA na około godzinę.

Sam Altman również pojawił się w sieci i odpowiedział na wszystkie pytania internautów.

Główne atrakcje to:

- DeepSeek jest rzeczywiście bardzo dobryi będziemy nadal opracowywać lepsze modele, ale przewaga nie będzie już tak duża jak wcześniej

- W porównaniu z sytuacją sprzed kilku lat, jestem teraz bardziej skłonny wierzyć, że sztuczna inteligencja może doświadczyć gwałtownych skoków i postępów

- Jesteśmy po złej stronie kwestii open-sourcingu ważonych modeli AI

- Wkrótce pojawi się aktualizacja zaawansowanego trybu głosowego, którą nazwiemy bezpośrednio GPT-5, a nie GPT-5o. Nie ma jeszcze konkretnego harmonogramu.

Oprócz samego Altmana, Chief Research Officer Mark Chen, Chief Product Officer Kevin Weil, Vice President of Engineering Srinivas Narayanan, Head of API Research Michelle Pokrass i Head of Research Hongyu Ren również byli online i uważnie odpowiadali na wszystkie pytania internautów.

Następnie przyjrzyjmy się, co wszyscy powiedzieli.

Altman głęboko żałuje, że stanął po złej stronie w bitwie o sztuczną inteligencję open source

Nagły powrót DeepSeek mógł być nieoczekiwany dla wszystkich.

Podczas pytań i odpowiedzi na AMA sam Altman również głęboko żałował, że stanął po złej stronie w bitwie o sztuczną inteligencję open source i musiał przyznać, że DeepSeek ma duże zalety.

To, co zadziwiło wiele osób, to fakt, że Altman powiedział nawet, że przewaga OpenAI nie jest tak silna, jak kiedyś.

Poniżej znajdują się wszystkie klasyczne odpowiedzi, które zebraliśmy od Altmana.

P: Porozmawiajmy o najważniejszym temacie tygodnia: Deepseek. Jest to niewątpliwie bardzo imponujący model i wiem, że prawdopodobnie został wytrenowany na podstawie wyników innych LLM. Jak to zmieni wasze plany dotyczące przyszłych modeli?

Altman: To rzeczywiście bardzo imponujący model! Opracujemy lepsze modele, ale nie będziemy w stanie utrzymać tak dużej przewagi jak w poprzednich latach.

P: Czy uważasz, że rekurencyjne samodoskonalenie będzie procesem stopniowym czy nagłym startem?

Altman: Osobiście uważam, że jestem bardziej skłonny myśleć, że sztuczna inteligencja może poczynić szybkie postępy niż kilka lat temu. Może nadszedł czas, by napisać coś na ten temat...

P: Czy możemy zobaczyć wszystkie żetony, o których myśli model?

Altman: Tak, wkrótce pokażemy bardziej pomocną i szczegółową wersję. Dzięki R1 za aktualizację.

Kevin Weil, dyrektor ds. produktu: Pracujemy nad tym, by pokazywać więcej niż obecnie - stanie się to wkrótce. To, czy pokażemy wszystko, czy nie, pozostaje do ustalenia. Pokazanie wszystkich łańcuchów myślowych (CoT) doprowadziłoby do destylacji modeli konkurencji, ale wiemy też, że użytkownicy (przynajmniej zaawansowani) chcą to zobaczyć, więc znajdziemy dobrą równowagę.

P: Kiedy będzie dostępna pełna wersja o3?

Altman: Szacowałbym, że będzie to więcej niż kilka tygodni, ale nie więcej niż kilka miesięcy.

P: Czy pojawi się aktualizacja trybu głosowego? Czy jest to potencjalny cel dla GPT-5o? Jaki jest przybliżony harmonogram dla GPT-5o?

Altman: Tak, aktualizacja zaawansowanego trybu głosowego nadchodzi! Myślę, że nazwiemy ją po prostu GPT-5, a nie GPT-5o. Nie ma jeszcze konkretnego harmonogramu.

P: Czy rozważyłbyś wypuszczenie wzorcowych wag i opublikowanie badań?

Altman: Tak, dyskutujemy o tym. Osobiście uważam, że jesteśmy po złej stronie tej kwestii i musimy opracować inną strategię open source; nie wszyscy w OpenAI podzielają ten pogląd i nie jest to obecnie nasz najwyższy priorytet.

Jeszcze jeden zestaw pytań:

- Jak blisko jesteśmy zaoferowania Operatora w regularnym programie Plus?

- Jakie są najważniejsze priorytety działu robotyki?

- Co OpenAI sądzi o bardziej wyspecjalizowanych chipach/TPU, takich jak Trillium, Cerebras itp. Czy OpenAI zwraca na to uwagę?

- Jakie inwestycje są dokonywane w celu zabezpieczenia się przed przyszłym ryzykiem w AGI i ASI?

- Jakie były Twoje najbardziej pamiętne wakacje?

Altman:

- Kilka miesięcy

- wyprodukowanie naprawdę dobrego robota na małą skalę i wyciągnięcie wniosków z tego doświadczenia.

- GB200 jest obecnie trudny do pobicia!

- Dobrym wyborem byłoby poprawienie swojego stanu wewnętrznego - odporności, zdolności adaptacyjnych, spokoju, radości itp.

- Ciężko wybrać! Ale pierwsze dwa, które przychodzą mi do głowy to: podróż z plecakiem po Azji Południowo-Wschodniej lub safari w Afryce

P: Czy planujecie podnieść cenę serii Plus?

Altman: Właściwie to chcę ją stopniowo zmniejszać.

P: Załóżmy, że jest rok 2030 i właśnie stworzyłeś system, który większość ludzi nazwałaby AGI. Wyróżnia się on we wszystkich testach porównawczych i przewyższa najlepszych inżynierów i badaczy pod względem szybkości i wydajności. Co dalej? Poza "umieszczeniem go na stronie internetowej i oferowaniem jako usługi", czy masz jakieś inne plany?

Altman: Moim zdaniem najważniejszym skutkiem będzie przyspieszenie odkryć naukowych, co moim zdaniem jest czynnikiem, który w największym stopniu przyczyni się do poprawy jakości życia.

Generowanie obrazu 4o, już wkrótce

Następnie dodano odpowiedzi od innych członków OpenAI.

P: Czy nadal planujecie uruchomić generator obrazów 4o?

Kevin Weil, dyrektor ds. produktów: Tak! Myślę, że warto było czekać.

P: Świetnie! Czy jest jakiś przybliżony harmonogram?

Kevin Weil, dyrektor ds. produktów: Prosisz mnie o kłopoty. Może kilka miesięcy.

I jeszcze jedno podobne pytanie.

P: Kiedy możemy spodziewać się ChatGPT-5?

Kevin Weil, dyrektor ds. produktów: Krótko po o-17 micro i GPT-(π+1).

Pojawia się też inne pytanie:

- Jakich innych rodzajów agentów możemy się spodziewać?

- A także zapewnić agenta dla darmowych użytkowników, co może przyspieszyć adopcję...

- Jakieś informacje na temat nowej wersji DALL-E?

- Ostatnie pytanie, które wszyscy zadają... Kiedy AGI zostanie wdrożone?

Kevin Weil, dyrektor ds. produktu:

- Więcej agentów: bardzo, bardzo szybko. Myślę, że będziesz szczęśliwy.

- Generowanie obrazu na podstawie 4o: za kilka miesięcy, nie mogę się doczekać, aż go użyjesz. Jest świetny.

- AGI: Tak

P: Czy planujecie dodać funkcję załączania plików do modelu rozumowania?

Srinivas Narayanan, wiceprezes ds. inżynierii: Jest w fazie rozwoju. W przyszłości model wnioskowania będzie mógł korzystać z różnych narzędzi, w tym funkcji wyszukiwania.

Kevin Weil, dyrektor ds. produktu: Chcę tylko powiedzieć, że nie mogę się doczekać, aby zobaczyć model rozumowania, który umożliwia korzystanie z narzędzi

P: Naprawdę. Kiedy rozwiążesz ten problem, otworzy się kilka bardzo przydatnych scenariuszy zastosowań sztucznej inteligencji. Wyobraźmy sobie, że jest ona w stanie zrozumieć zawartość 500 GB dokumentów roboczych.

Gdy masz zamiar odpowiedzieć na wiadomość e-mail, obok aplikacji poczty e-mail otworzy się panel, który stale analizuje wszystkie informacje związane z tą osobą, w tym relacje, omawiane tematy, przeszłą pracę itp. Być może coś z dokumentu, o którym dawno zapomniałeś, zostanie oznaczone flagą, ponieważ jest bardzo istotne dla bieżącej dyskusji. Tak bardzo chcę tej funkcji.

Srinivas Narayanan, wiceprezes ds. inżynierii: Pracujemy nad zwiększeniem długości kontekstu. Nie ma jeszcze konkretnej daty/ogłoszenia.

P: Jak ważny jest projekt Stargate dla przyszłości OpenAI? Kevin Weil, dyrektor ds. produktu: Bardzo ważne. Wszystko, co widzieliśmy, sugeruje, że im większą mocą obliczeniową dysponujemy, tym lepsze modele możemy tworzyć i tym bardziej wartościowe produkty możemy tworzyć.

Obecnie skalujemy modele w dwóch wymiarach - większe szkolenie wstępne i więcej uczenia ze wzmocnieniem (RL) / szkolenie "truskawkowe" - oba wymagają zasobów obliczeniowych.

Obsługa setek milionów użytkowników również wymaga zasobów obliczeniowych! A ponieważ zmierzamy w kierunku bardziej inteligentnych produktów agentów, które mogą pracować dla Ciebie w sposób ciągły, wymaga to również zasobów obliczeniowych. Możesz więc myśleć o Stargate jako o naszej fabryce, w której energia elektryczna / procesory graficzne są przekształcane w niesamowite produkty.

P: Którego modelu wewnętrznego obecnie używasz? o4, o5 czy o6? O ile inteligentniejsze są te wewnętrzne modele w porównaniu do o3?

Michelle Pokrass, szefowa działu badań API: Straciliśmy rachubę.

P: Prosimy o umożliwienie nam interakcji z tekstem/kanwą przy użyciu zaawansowanych funkcji głosowych. Chcę mieć możliwość mówienia do niego i iteracyjnego modyfikowania dokumentów.

Kevin Weil, dyrektor ds. produktów: Tak! Mamy wiele świetnych narzędzi, które zostały opracowane stosunkowo niezależnie - naszym celem jest jak najszybsze przekazanie ich w ręce użytkowników.

Następnym krokiem jest zintegrowanie wszystkich tych funkcji, aby można było rozmawiać z modelem, który jednocześnie wyszukuje i uzasadnia, oraz generować płótno, które może uruchamiać Python. Wszystkie narzędzia muszą ze sobą lepiej współpracować. A tak przy okazji, wszystkie modele potrzebują pełnego dostępu do narzędzi (modele z serii o nie mogą obecnie korzystać ze wszystkich narzędzi), co również zostanie zaimplementowane.

P: Kiedy modele z serii o będą obsługiwać funkcję pamięci w ChatGPT?

Michelle Pokrass, kierownik działu badań API: Jest w trakcie opracowywania! Ujednolicenie wszystkich naszych funkcji z modelami z serii o jest naszym najwyższym priorytetem.

P: Czy 4o doczeka się jakichś większych ulepszeń? Naprawdę podoba mi się niestandardowy GPT i byłoby wspaniale, gdyby można go było ulepszyć lub gdybyśmy mogli wybrać model, który ma być używany w niestandardowym GPT (np. o3 mini).

Michelle Pokrass, kierownik działu badań API: Tak, jeszcze nie skończyliśmy z serią 4o!