DeepSeek-R1 și DeepSeek-V3 au provocat o senzație globală de la lansarea lor open source.

Acestea sunt un cadou din partea echipei DeepSeek pentru întreaga omenire, iar noi suntem sincer bucuroși pentru succesul lor.

După zile de muncă grea din partea echipelor Silicon Mobility și Huawei Cloud, astăzi oferim utilizatorilor chinezi un cadou de Anul Nou Chinezesc: platforma de servicii cloud de model la scară largă SiliconCloud a lansat DeepSeek-V3 și DeepSeek-R1, care sunt bazate pe serviciul cloud Ascend al Huawei Cloud.

Trebuie subliniat faptul că am primit un mare sprijin din partea DeepSeek și Huawei Cloud, atât în adaptarea DeepSeek-R1 & V3 pe Ascend, cât și în procesul de lansare a altor modele anterioare, și am dori să ne exprimăm recunoștința profundă și respectul înalt.

Caracteristici

Aceste două modele lansate de SiliconCloud includ în principal cinci caracteristici majore:

Pe baza serviciului cloud Ascend al Huawei Cloud, am lansat DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 model inference service pentru prima dată.

Prin inovare comună între cele două părți și cu sprijinul motorului de accelerare a inferențelor dezvoltat de noi, modelul DeepSeek implementat de echipa Silicon Mobility pe baza serviciului cloud Ascend al Huawei Cloud poate obține același efect ca un model de implementare GPU high-end din lume.

Furnizarea de servicii stabile de inferență DeepSeek-R1 și V3 la nivel de producție. Acest lucru permite dezvoltatorilor să ruleze stabil în medii de producție la scară largă și să îndeplinească nevoile de implementare comercială. Serviciile Huawei Cloud Ascend AI oferă putere de calcul abundentă, elastică și suficientă.

Nu există niciun prag de implementare, permițând dezvoltatorilor să se concentreze mai mult pe dezvoltarea aplicațiilor. Atunci când dezvoltă aplicații, aceștia pot apela direct API-ul SiliconCloud, care oferă o experiență mai ușoară și mai ușor de utilizat.

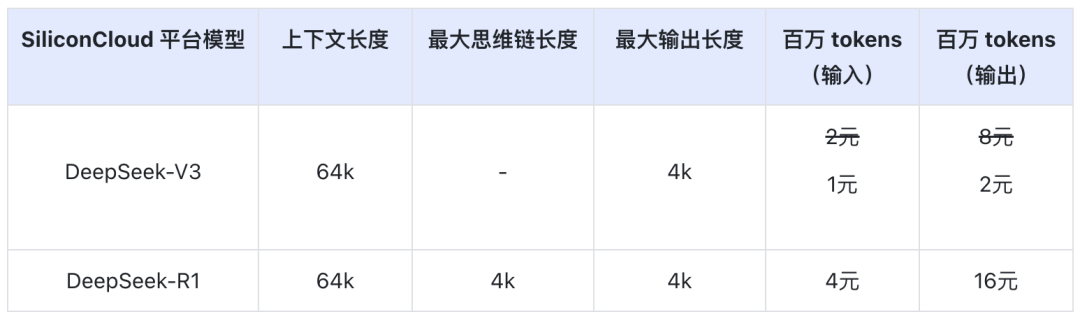

Prețul DeepSeek-V3 pe SiliconCloud în timpul perioadei oficiale de reducere (până la ora 24:00 pe 8 februarie) este de ¥1 / M jetoane (intrare) & ¥2 / M jetoane (ieșire), iar prețul DeepSeek-R1 este de ¥4 / M jetoane (intrare) & ¥16 / M jetoane (ieșire).

Experiență online

DeepSeek-R1 cu SiliconCloud

DeepSeek-V3 cu SiliconCloud

Documentație API

Dezvoltatorii pot experimenta efectul DeepSeek-R1 & V3 accelerat pe cipuri interne pe SiliconCloud. Viteza de ieșire mai rapidă este în continuare optimizată continuu.

Experiență în aplicații client

Dacă doriți să experimentați modelul DeepSeek-R1 & V3 direct în aplicația client, puteți instala local următoarele produse și puteți accesa API SiliconCloud (puteți personaliza și adăuga aceste două modele) pentru a experimenta DeepSeek-R1 & V3.

- Aplicații client model mare: ChatBox, Studioul Cherry, OneAPI, LobeChat, NextChat

- Aplicații de generare a codurilor: Cursor, Windsurf, Cline

- Platformă de dezvoltare a aplicațiilor de model mare:Dify

- Baza de cunoștințe AI:Obsidian AI, șiFastGPT

- Plug-in de traducere:Immersive Translate, șiEurodict

Pentru mai multe tutoriale de acces la scenarii și cazuri de aplicații, vă rugăm să consultați aici

Token Factory SiliconCloud

Qwen2.5 (7B), etc. 20+ modele gratuite de utilizat

În calitate de platformă unică de servicii cloud pentru modele mari, SiliconCloud se angajează să ofere dezvoltatorilor API-uri de model care sunt ultra-reactive, accesibile, cuprinzătoare și au o experiență lină ca mătasea.

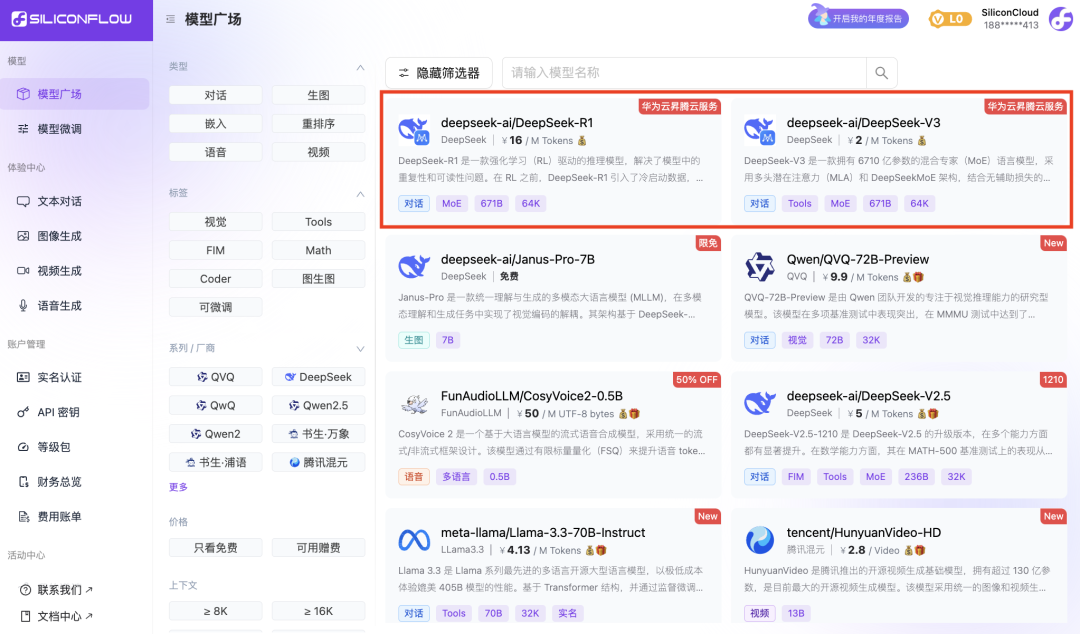

În plus față de DeepSeek-R1 și DeepSeek-V3, SiliconCloud a mai lansat Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

zeci de modele mari de limbaj, modele de generare a imaginilor/video, modele de vorbire, modele de cod/matematică și modele vectoriale și de reordonare.

Platforma permite dezvoltatorilor să compare și să combine liber modele mari din diverse modalități pentru a alege cea mai bună practică pentru aplicația dvs. de inteligență artificială generativă.

Dintre acestea, peste 20 de API-uri de model mare, cum ar fi Qwen2.5 (7B) și Llama3.1 (8B), pot fi utilizate gratuit, permițând dezvoltatorilor și managerilor de produse să obțină "libertatea token-ului" fără a se îngrijora de costul puterii de calcul în timpul etapei de cercetare și dezvoltare și de promovare la scară largă.