Costul ridicat al utilizării modelelor AI mari este un motiv major pentru care multe aplicații AI nu au fost încă implementate și promovate. Alegerea performanțelor extreme înseamnă costuri uriașe pentru puterea de calcul, ceea ce duce la costuri mari de utilizare pe care utilizatorii obișnuiți nu le pot accepta.

Competiția pentru modele mari de IA este ca un război fără fum. După ce DeepSeek a lansat și a deschis cel mai recent model R1 mare, OpenAI și-a lansat și cel mai recent model o3 sub presiune. Jucătorul mare de modele Google a trebuit, de asemenea, să se alăture competiției acerbe pentru modelele low-cost.

Noua mutare a Google: noi membri ai seriei Gemeni dezvăluiți

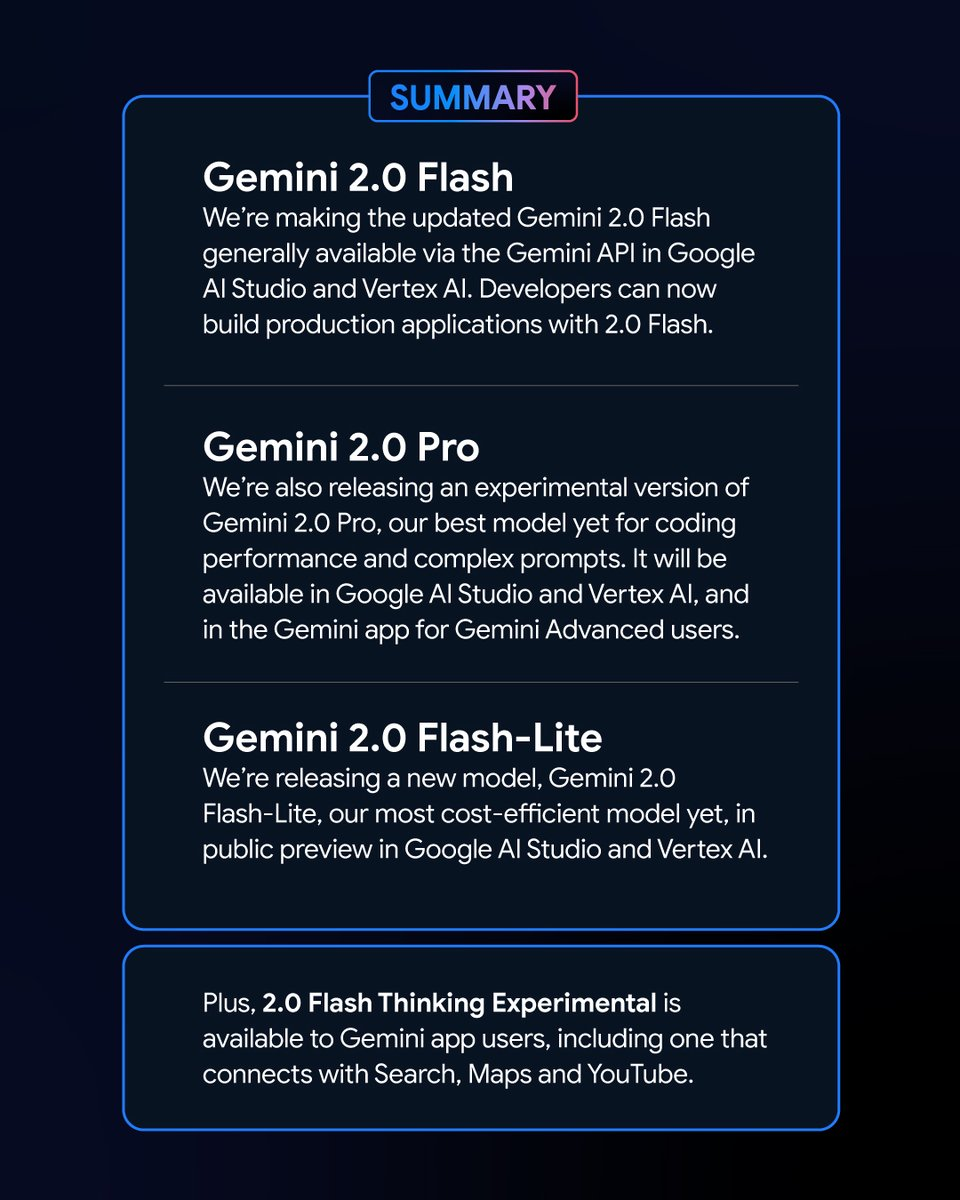

În dimineața devreme a zilei de 6 februarie, Google a lansat o serie de versiuni noi ale modelului Gemini. Printre acestea, versiunea experimentală a Gemeni 2.0 Pro și versiunea de previzualizare a Gemini 2.0 Flash – Lite au atras multă atenție, iar cea mai recentă versiune a Gemini 2.0 Flash a fost lansată oficial.

Ca variantă nouă, Google Gemini 2.0 Flash – Lite are un preț foarte atractiv de doar 0,3 USD per milion de jetoane, ceea ce îl face cel mai accesibil model Google până în prezent.

Versiunea experimentală Gemini 2.0 Pro, pe de altă parte, are capabilități multimodale native puternice care pot face conversie între text și audio și video.

Versiunea experimentală Gemini 2.0 Flash Thinking este gratuită și are, de asemenea, capacitatea de a accesa, extrage și rezuma conținutul videoclipurilor YouTube.

Logan Kilpatrick, șeful produselor Google AI Studio, a anunțat pe platforma X că aceste modele sunt „cele mai puternice modele din istoria Google” și sunt disponibile pentru toți dezvoltatorii.

Performanța și rezultatele impresionante ale noilor modele Gemini în clasament

În Chatbot Arena Large Model Leaderboard, Gemini 2.0 Flash Thinking Experimental Edition și Gemini 2.0 Pro Experimental Edition au obținut rezultate remarcabile. În comparație cu modelele Google anterioare mari, Gemini 2.0 a făcut progrese mari și, fără a fi surprinzător, au ajuns cu succes în vârful clasamentului, cu un scor combinat depășind ChatGPT-4o și DeepSeek-R1. Aceasta este o îmbunătățire uriașă.

Acest rezultat se bazează pe o evaluare cuprinzătoare a capabilităților modelelor mari în diferite domenii, inclusiv matematică, codificare și procesare multilingvă.

Preț și performanță: fiecare variantă de Gemini 2.0 are propriile avantaje

Diferitele versiuni de Gemini 2.0 au propriile lor caracteristici în ceea ce privește prețul și performanța. S-a realizat un echilibru între performanță și preț, oferind utilizatorilor mai multe opțiuni. API-urile diferitelor versiuni de Gemini 2.0 pot fi apelate prin Google AI Studio și Vertex AI. Dezvoltatorii și utilizatorii pot alege versiunea potrivită în funcție de nevoile lor.

Gemini 2.0 a făcut progrese și dezvoltare mari în comparație cu Gemini 1.5. Deși diferitele versiuni de Gemini 2.0 au diferențe, toate au fost îmbunătățite în general. Mai exact, trebuie să determinați scenariul pe care îl utilizați, iar apoi puteți alege mai bine modelul Gemeni care vi se potrivește.

În ceea ce privește prețul, Gemini 2.0 Flash și Gemini 2.0 Flash – Lite se concentrează pe implementarea ușoară. Aceștia acceptă până la 1 milion de jetoane pe lungimea ferestrei de context, iar în ceea ce privește prețul, distincția dintre procesarea textului lung și scurt în Gemini 1.5 Flash a fost eliminată, iar prețul este unificat la un preț unitar de simbol.

Gemini 2.0 Flash costă 0,4 USD per milion de jetoane pentru text, adică jumătate din prețul Gemini 1.5 Flash atunci când procesează texte lungi.

Gemini 2.0 Flash – Lite este și mai bun la optimizarea costurilor în scenarii de text la scară largă, cu un preț de ieșire de text de 0,3 USD per milion de jetoane. Chiar și CEO-ul Google, Sundar Pichai, l-a lăudat ca fiind „eficient și puternic”.

În ceea ce privește îmbunătățirea performanței, Gemini 2.0 Flash are funcții de interacțiune multimodală mai cuprinzătoare decât versiunea Lite. Este programat să accepte ieșirea imaginilor, precum și intrarea și ieșirea bidirecțională în timp real cu latență scăzută a unor modalități precum text, audio și video.

Versiunea experimentală Gemini 2.0 Pro excelează în ceea ce privește performanța de codificare și solicitările complexe. Fereastra sa de context poate ajunge până la 2 milioane de jetoane, iar capacitatea sa generală a crescut de la 75.8% la 79.1% în comparație cu generația anterioară, ceea ce reprezintă o diferență semnificativă în capacitatea de codificare și raționament cu Gemini 2.0 Flash și Gemini 2.0 Flash – Lite.

Echipa de aplicații Gemini a declarat pe platforma X că utilizatorii Gemini Advanced pot accesa versiunea experimentală Gemini 2.0 Pro prin meniul derulant al modelului, iar versiunea experimentală Gemini 2.0 Flash Thinking este gratuită pentru utilizatorii aplicației Gemini, iar această versiune poate fi folosită împreună cu YouTube, căutare Google și Google Maps.

Contracararea concurenței: Concursul de rentabilitate a modelului Google

Într-un moment în care costul dezvoltării modelelor a devenit un subiect fierbinte în industrie, lansarea open source, low-cost, de înaltă performanță DeepSeek – R1 a avut un impact asupra întregii industrii.

În timpul conferinței telefonice după lansarea raportului financiar Google din al patrulea trimestru 2024, Pichai, deși a recunoscut realizările lui DeepSeek, a subliniat, de asemenea, că seria de modele Gemini este lider în echilibrul între cost, performanță și latență și că performanța lor generală este mai bună decât cea a modelelor V3 și R1 ale lui DeepSeek.

Din perspectiva clasamentului testului de referință de performanță a modelelor mari LiveBench construit de Yang Likun și echipa sa, clasamentul general al Gemini 2.0 Flash este mai mare decât cel al lui DeepSeek V3 și al lui OpenAI o1 – mini, dar se află în spatele lui DeepSeek – R1 și OpenAI o1. Cu toate acestea, lansarea de către Google a Gemini 2.0 Flash – Lite este ca un atu. Google speră să facă cele mai recente modele mari accesibile pentru mai mulți oameni, să reducă costurile de utilizare ale utilizatorilor și speră să ocupe un loc în competiția dintre companii pentru preț/performanță.

După ce Google a lansat cel mai recent Gemini 2.0, un netizen a început să încerce să analizeze Gemini 2.0 Flash și alte modele populare deepseek și openai GPT-4o pe cont propriu. El a descoperit că noua versiune Gemini 2.0 Flash le depășește pe celelalte două modele atât din punct de vedere al performanței, cât și al costului. Acest lucru ne oferă, de asemenea, o privire asupra dezvoltării și evoluției Google și este un început bun.

Mai exact, Gemini 2.0 Flash costă 0,1 USD per milion de jetoane pentru intrare și 0,4 USD pentru ieșire, ambele fiind mult mai mici decât DeepSeek V3. Aceasta este o îmbunătățire și o dezvoltare uriașă. Netizenul a mai subliniat pe platforma X: „Versiunea oficială a Gemini 2.0 Flash costă o treime din GPT-4o-mini, în timp ce este de trei ori mai rapidă”.

O nouă tendință pe piața modelelor mari: raportul calitate-preț este rege

Astăzi, domeniul mare de modele este prins într-un nou război al prețurilor. În trecut, costul ridicat al utilizării modelelor mari a creat o oarecare rezistență la utilizarea și promovarea acestora. Impactul războiului prețurilor pentru modelele mari declanșat de DeepSeek pe piața de modele mari de peste mări continuă să fermenteze. În același timp, opțiunea open source a permis, de asemenea, mai multor utilizatori să înțeleagă și să utilizeze cele mai recente rezultate ale cercetării pe modele mari. Strategia open source + preț scăzut a pus presiune și asupra multor companii mari modele americane.

Google a lansat Gemini 2.0 Flash-Lite, iar OpenAI a pus la dispoziția tuturor utilizatorilor funcția de căutare ChatGPT, astfel încât utilizatorii să poată folosi funcția de căutare pentru a îndeplini sarcini mai diverse. Echipa internă Meta intensifică, de asemenea, cercetările privind strategiile de reducere a prețurilor modelelor mari, promovând în același timp dezvoltarea în continuare a modelelor mari Meta open source.

În acest domeniu extrem de competitiv, nicio companie nu poate sta confortabil pe primul loc. Companiile încearcă să atragă și să rețină utilizatorii prin îmbunătățirea eficienței costurilor. Această tendință va ajuta modelele mari să treacă de la dezvoltarea tehnologiei pură la aplicarea mai largă, iar viitoarea piață a modelelor mari va continua să evolueze și să se schimbe în competiția pentru rentabilitate.