DeepSeek-R1 и DeepSeek-V3 произвели фурор во всем мире с момента их выхода в свет.

Они - подарок команды DeepSeek всему человечеству, и мы искренне рады их успеху.

После нескольких дней напряженной работы команды Silicon Mobility и Huawei Cloud сегодня мы дарим китайским пользователям подарок на китайский Новый год: крупномасштабная платформа облачных сервисов SiliconCloud запустила DeepSeek-V3 и DeepSeek-R1, которые основаны на облачном сервисе Ascend от Huawei Cloud.

Следует подчеркнуть, что мы получили огромную поддержку от DeepSeek и Huawei Cloud, как в адаптации DeepSeek-R1 & V3 на Ascend, так и в процессе запуска других моделей ранее, и мы хотели бы выразить глубокую благодарность и большое уважение.

Характеристики

Эти две модели, выпущенные SiliconCloud, включают в себя пять основных функций:

На базе облачного сервиса Huawei Cloud Ascend мы запустили DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 впервые предоставила сервис вывода моделей.

Благодаря совместным инновациям двух сторон и поддержке самостоятельно разработанного механизма ускорения вывода, модель DeepSeek, развернутая командой Silicon Mobility на базе облачного сервиса Huawei Cloud Ascend, может достичь того же эффекта, что и модель развертывания GPU высокого класса в мире.

Обеспечение стабильной работы сервисов вывода DeepSeek-R1 и V3 на производственном уровне. Это позволяет разработчикам стабильно работать в крупномасштабных производственных средах и удовлетворять потребности коммерческого развертывания. Сервисы Huawei Cloud Ascend AI предоставляют обильные, эластичные и достаточные вычислительные мощности.

Отсутствует порог развертывания, что позволяет разработчикам больше сосредоточиться на разработке приложений. При разработке приложений они могут напрямую обращаться к API SiliconCloud, что обеспечивает более простой и удобный опыт.

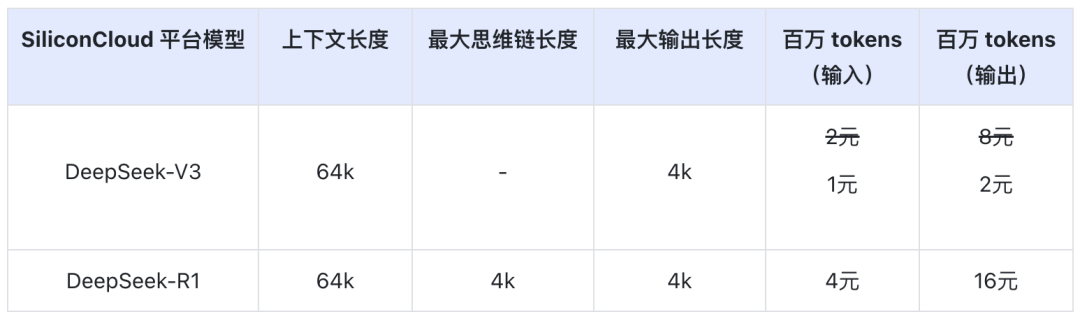

Цена DeepSeek-V3 на SiliconCloud в период официальных скидок (до 24:00 8 февраля) составляет ¥1 / M токенов (вход) и ¥2 / M токенов (выход), а цена DeepSeek-R1 - ¥4 / M токенов (вход) и ¥16 / M токенов (выход).

Опыт работы в Интернете

DeepSeek-R1 с SiliconCloud

DeepSeek-V3 с SiliconCloud

Документация по API

Разработчики могут испытать эффект ускорения DeepSeek-R1 & V3 на отечественных чипах на SiliconCloud. Более высокая скорость вывода по-прежнему постоянно оптимизируется.

Опыт работы с клиентскими приложениями

Если вы хотите испытать модель DeepSeek-R1 и V3 непосредственно в клиентском приложении, вы можете установить следующие продукты локально и получить доступ к API SiliconCloud (вы можете настроить и добавить эти две модели), чтобы испытать DeepSeek-R1 и V3.

- Большие модели клиентских приложений: ChatBox, Студия "Вишня, OneAPI, LobeChat, NextChat

- Приложения для генерации кода: КурсорВиндсерфинг, Клайн

- Платформа для разработки приложений больших моделей:Dify

- База знаний по искусственному интеллекту:Обсидиановый ИИ, иFastGPT

- Плагин для перевода:Immersive Translate иEurodict

Дополнительные руководства по доступу к сценариям и приложениям см. на сайте здесь

Фабрика токенов SiliconCloud

Qwen2.5 (7B) и др. 20+ моделей бесплатно для использования

Как универсальная платформа облачных сервисов для больших моделей, SiliconCloud стремится предоставить разработчикам модельные API, которые являются ультра-отзывчивыми, доступными, всеобъемлющими и имеют шелковисто-гладкий опыт.

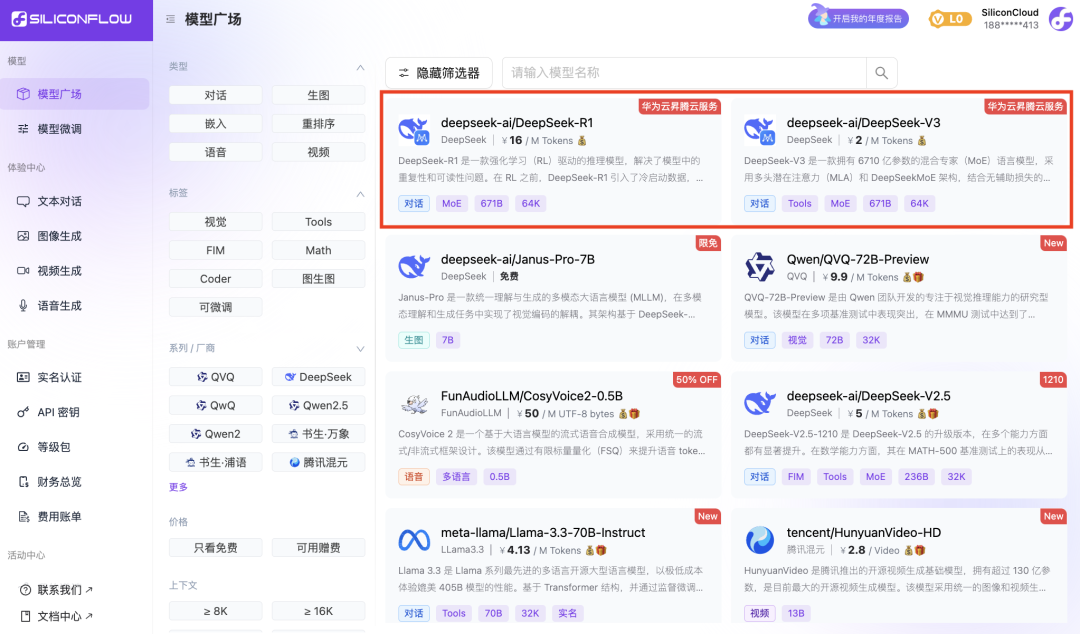

Помимо DeepSeek-R1 и DeepSeek-V3, SiliconCloud также выпустила Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

десятки открытых моделей языка, моделей генерации изображений/видео, моделей речи, моделей кода/математики, а также векторных и реорганизационных моделей.

Платформа позволяет разработчикам свободно сравнивать и комбинировать большие модели различных модальностей, чтобы выбрать лучшую практику для вашего приложения генеративного ИИ.

Среди них 20+ API крупных моделей, таких как Qwen2.5 (7B) и Llama3.1 (8B), бесплатны для использования, что позволяет разработчикам и менеджерам продуктов достичь "свободы токенов", не беспокоясь о стоимости вычислительных мощностей на этапе исследований и разработок и масштабного продвижения.