Ingen av oss trodde att det var så här 2025 skulle börja inom AI-området.

DeepSeek R1 är verkligen fantastisk!

Nyligen har den "mystiska östliga makten" DeepSeek varit "hårt kontrollerande" Silicon Valley.

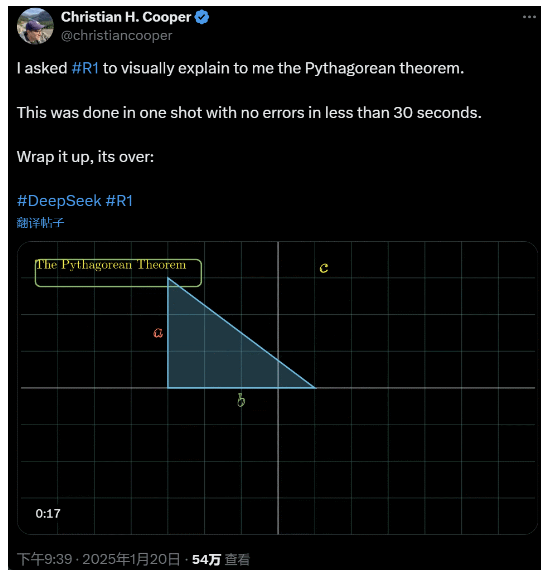

Jag bad R1 att förklara Pythagoras sats i detalj. Allt detta gjordes av AI på mindre än 30 sekunder utan några misstag. Kort sagt, det är över.

I inhemska och utländska AI-kretsar har vanliga nätanvändare upptäckt den fantastiska och kraftfulla nya AI:n (som också är öppen källkod), och akademiska experter har ropat "vi måste komma ikapp". Det finns också rykten om att utländska AI-företag redan står inför ett stort hot.

Ta bara den här DeepSeek R1 som släpptes den här veckan. Dess rena förstärkningsinlärningsväg utan någon övervakad utbildning är chockerande. Från utvecklingen av Deepseek-v3-basen i december förra året till den nuvarande tankekedjans kapacitet som kan jämföras med OpenAI o1, verkar det vara en tidsfråga.

Men medan AI-samhället är upptaget med att läsa tekniska rapporter och jämföra faktiska mätningar, tvivlar människor fortfarande på R1: bortsett från att kunna överträffa en massa benchmarks, kan det verkligen leda?

Kan den bygga sina egna simuleringar av "fysikaliska lagar"?

Du tror inte på det? Låt oss låta den stora modellen leka med en flipperkula?

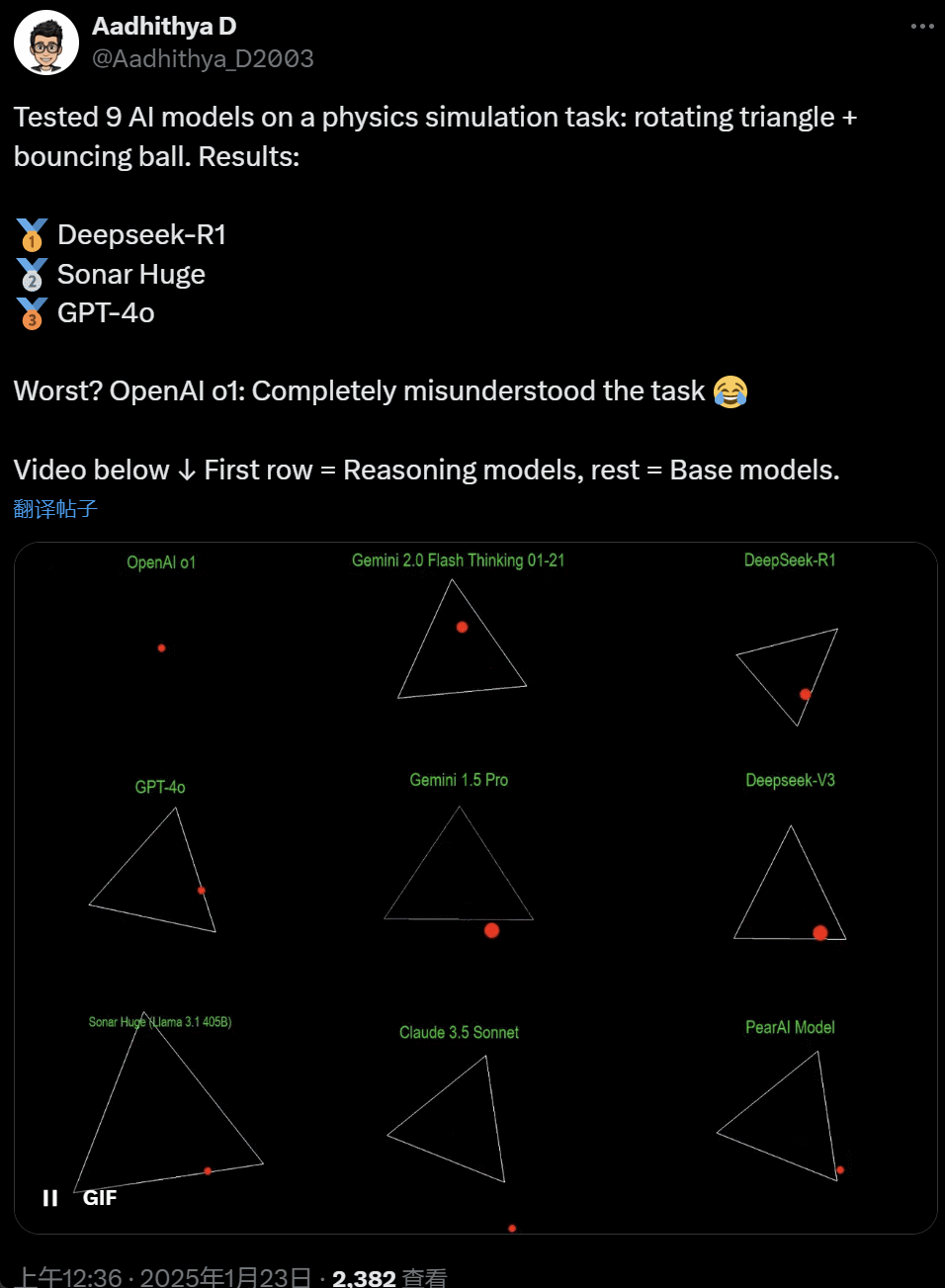

Under de senaste dagarna har vissa personer i AI-communityt blivit besatta av ett test - att testa olika stora AI-modeller (särskilt de så kallade resonerande modellerna) för att lösa ett problem: "Skriv ett Python-skript för att få en gul boll att studsa inuti en viss form. Få formen att rotera långsamt och se till att bollen stannar kvar inuti formen."

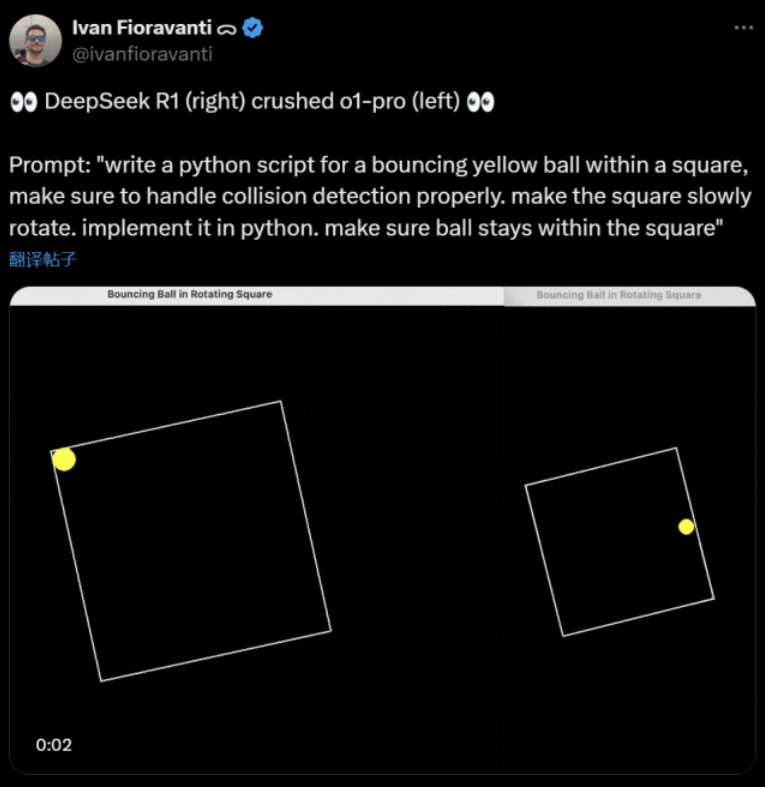

Vissa modeller överträffar andra i detta "roterande boll"-riktmärke. Enligt CoreView CTO Ivan Fioravanti har DeepSeek, ett inhemskt laboratorium för artificiell intelligens, en öppen källkod stor modell R1 som slår OpenAI: s o1 pro-modell, som kostar $200 per månad som en del av OpenAI: s ChatGPT Pro-program.

Till vänster finns OpenAI o1 och till höger finns DeepSeek R1. Som nämnts ovan är uppmaningen här: "skriv ett pythonskript för en studsande gul boll inom en kvadrat, se till att hantera kollisionsdetektering korrekt. få kvadraten att långsamt rotera. implementera det i python. se till att bollen stannar inom kvadraten."

Enligt en annan användare på X gjorde modellerna Anthropic Claude 3.5 Sonnet och Googles Gemini 1.5 Pro felaktiga bedömningar om fysiska principer, vilket fick bollen att avvika från sin form. Vissa användare har också rapporterat att Googles senaste Gemini 2.0 Flash Thinking Experimental, liksom den relativt äldre OpenAI GPT-4o, klarade bedömningen på en gång.

Men det finns ett sätt att se skillnaden här:

Netizens under denna tweet sa: o1: s förmåga var ursprungligen mycket bra, men den blev svagare efter att OpenAI optimerade hastigheten, även med medlemsversionen $200 / månad.

Att simulera en studsande boll är en klassisk programmeringsutmaning. För att simuleringen ska bli korrekt krävs algoritmer för kollisionsdetektering, som måste identifiera när två objekt (t.ex. en boll och sidan av en form) kolliderar. En felaktigt skriven algoritm kan påverka simuleringens prestanda eller orsaka uppenbara fysiska fel.

N8 Programs, forskare på AI-startupen Nous Research, säger att det tog honom ungefär två timmar att skriva en studsande boll i en roterande heptagon från grunden. "Flera koordinatsystem måste spåras, det krävs en förståelse för hur kollisioner hanteras i varje system och koden måste utformas från grunden för att vara robust."

Även om studsande bollar och snurrande former är ett rimligt test av programmeringsfärdigheter är det fortfarande nya projekt för stora modeller, och även små förändringar i uppmaningarna kan ge olika resultat. Så om det så småningom ska bli en del av benchmark-testet för stora AI-modeller måste det fortfarande förbättras.

I vilket fall som helst, efter denna våg av praktiska tester, har vi en känsla av skillnaderna i kapacitet mellan stora modeller.

DeepSeek är den nya "Silicon Valley-myten

DeepSeek orsakar panik" över Stilla havet.

Meta anställda har skrivit att "Meta ingenjörer analyserar frenetiskt DeepSeek för att försöka kopiera allt de kan från det."

Alexandr Wang, grundare av AI-teknikstartup Scale AI, uppgav också offentligt att prestandan för DeepSeek:s stora AI-modell är ungefär likvärdig med den bästa modellen i USA.

Han tror också att USA kan ha legat före Kina i AI-tävlingen under det senaste decenniet, men att DeepSeek:s lansering av sin stora AI-modell kan "förändra allt".

X Blogger @8teAPi anser att DeepSeek inte är ett "sidoprojekt" utan är som Lockheed Martins tidigare "Skunk Works".

Det så kallade "Skunk Works" är ett mycket konfidentiellt, relativt oberoende litet team som Lockheed Martin ursprungligen inrättade för att utveckla många avancerade flygplan och som ägnade sig åt forskning och utveckling av banbrytande eller okonventionell teknik. Från spaningsflygplanet U-2 och SR-71 Blackbird till stridsflygplanen F-22 Raptor och F-35 Lightning II - alla kom de härifrån.

Senare utvecklades begreppet gradvis till en generisk term som används för att beskriva "små men fina", relativt oberoende och mer flexibla innovationsteam som inrättats inom stora företag eller organisationer.

Han angav två skäl:

- Å ena sidan har DeepSeek ett stort antal GPU:er, enligt uppgift mer än 10.000, och Alexandr Wang, VD för Scale AI, sa till och med att det kunde nå 50.000.

- Å andra sidan rekryterar DeepSeek endast talanger från de tre bästa universiteten i Kina, vilket innebär att DeepSeek är lika konkurrenskraftigt som Alibaba och Tencent.

Enbart dessa två fakta visar att DeepSeek helt klart har nått kommersiell framgång och är tillräckligt välkänd för att få dessa resurser.

När det gäller DeepSeek:s utvecklingskostnader sa bloggaren att kinesiska teknikföretag kan få en mängd olika subventioner, till exempel låga elkostnader och markanvändning.

Det är därför mycket troligt att merparten av DeepSeek:s kostnader har "placerats" på ett konto utanför kärnverksamheten eller i form av någon form av subvention för uppförande av datacenter.

Även bortsett från grundarna är det ingen som helt förstår alla finansiella arrangemang. Vissa avtal kan helt enkelt vara "muntliga överenskommelser" som slutförs enbart baserat på rykte.

Oavsett vilket är några saker tydliga:

- Modellen är utmärkt, jämförbar med den version som OpenAI släppte för två månader sedan, och det är naturligtvis möjligt att den inte är lika bra som de nya modeller som OpenAI och Anthropic ännu inte har släppt.

- Ur nuvarande perspektiv domineras forskningsriktningen fortfarande av amerikanska företag. Modellen DeepSeek är en "snabb uppföljning" av o1-versionen, men DeepSeek:s forsknings- och utvecklingsframsteg är mycket snabba och kommer ikapp snabbare än väntat. De plagierar inte eller fuskar, på sin höjd är de reverse engineering.

- DeepSeek utbildar huvudsakligen sina egna talanger, snarare än att förlita sig på amerikanskutbildade doktorer, vilket kraftigt utökar talangpoolen.

- Jämfört med amerikanska företag är DeepSeek föremål för färre begränsningar när det gäller licensiering av immateriella rättigheter, integritet, säkerhet, politik etc., och det finns färre farhågor om felaktig användning av data som människor inte vill bli utbildade på. Det finns färre stämningar, färre advokater och färre bekymmer.

Det råder ingen tvekan om att allt fler tror att 2025 kommer att bli ett avgörande år. Under tiden förbereder sig företagen för det. Meta, till exempel, bygger ett 2GW+ datacenter med en beräknad investering på $60-65 miljarder fram till 2025 och kommer att ha mer än 1,3 miljoner GPU:er i slutet av året.

Meta använde till och med ett diagram för att jämföra sitt 2-gigawatt datacenter med Manhattan, New York.

Men nu har DeepSeek gjort bättre ifrån sig med lägre kostnad och färre GPU:er. Hur kan detta inte göra människor oroliga?

Yann LeCun: Vi måste tacka teknikchefen och medgrundaren av den öppen källkod

Hyperbolic, Yuchen Jin, för att du publicerar att på bara 4 dagar har DeepSeek-R1 bevisat 4 fakta för oss:

- AI med öppen källkod ligger bara 6 månader efter AI med sluten källkod

- Kina dominerar AI-tävlingen med öppen källkod

- Vi är på väg in i guldåldern för förstärkningsinlärning med stora språkmodeller

- Destillationsmodellerna är mycket kraftfulla, och vi kommer att köra högintelligent AI på mobiltelefoner

Den kedjereaktion som utlöstes av DeepSeek fortsätter fortfarande, till exempel OpenAI o3-mini som görs fritt tillgänglig, förhoppningen i samhället att minska de vaga diskussionerna om AGI/ASI och ryktet om att Meta är i panik.

Han menar att det är svårt att förutse vem som kommer att vinna i slutändan, men att vi inte får glömma bort kraften i den senkomna aktörens fördel. Vi vet ju alla att det var Google som uppfann Transformer, medan OpenAI frigjorde dess verkliga potential.

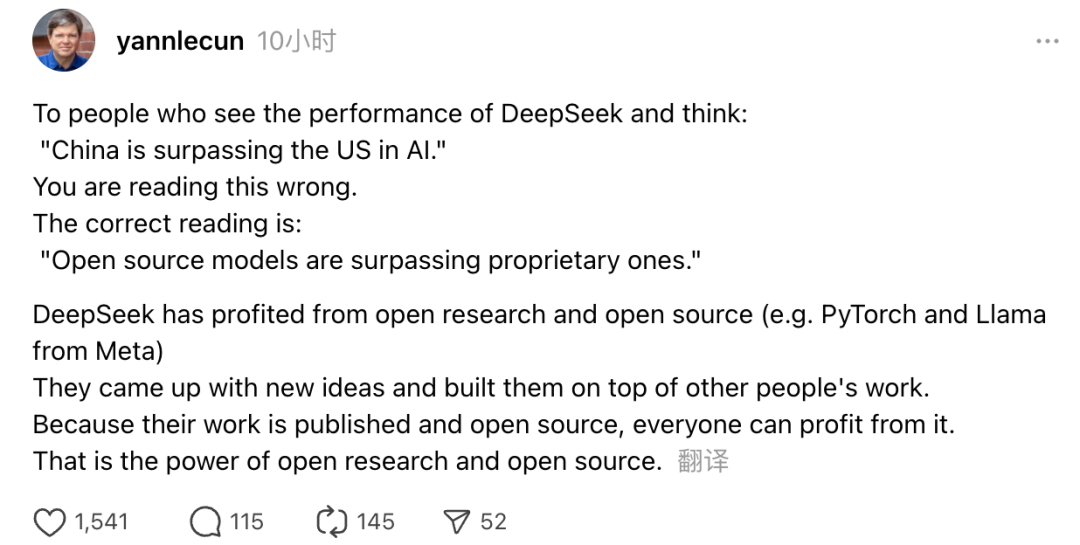

Dessutom uttryckte Turing Award-vinnaren och Metas Chief AI Scientist Yann LeCun också sina åsikter.

"För dem som, när de ser DeepSeek:s prestanda, tänker att 'Kina går om USA inom AI', har ni fel. Den korrekta uppfattningen är att modeller med öppen källkod håller på att gå om de proprietära modellerna."

LeCun sa att anledningen till att DeepSeek har gjort ett sådant stänk den här gången beror på att de har dragit nytta av öppen forskning och öppen källkod (som Metas PyTorch och Llama). DeepSeek har kommit med nya idéer och byggt vidare på andras arbete. Eftersom deras arbete är offentligt släppt och öppen källkod kan alla dra nytta av det. Detta är kraften i öppen forskning och öppen källkod.

Netizens reflektioner fortsätter. Även om de är glada över utvecklingen av ny teknik kan de också känna en liten atmosfär av ångest. När allt kommer omkring kan uppkomsten av DeepSeekers ha en verklig inverkan.