DeepSeek-R1 och DeepSeek-V3 har orsakat en global sensation sedan de lanserades med öppen källkod.

De är en gåva från DeepSeek-teamet till hela mänskligheten, och vi är uppriktigt glada över deras framgång.

Efter flera dagars hårt arbete av Silicon Mobility- och Huawei Cloud-teamen ger vi idag också kinesiska användare en kinesisk nyårspresent: den storskaliga molntjänstplattformen SiliconCloud har lanserat DeepSeek-V3 och DeepSeek-R1, som är baserade på Huawei Clouds Ascend-molntjänst.

Det bör betonas att vi har fått stort stöd från DeepSeek och Huawei Cloud, både när det gäller att anpassa DeepSeek-R1 & V3 på Ascend och i processen att lansera andra modeller tidigare, och vi vill uttrycka djup tacksamhet och hög respekt.

Funktioner

Dessa två modeller som lanserats av SiliconCloud innehåller huvudsakligen fem huvudfunktioner:

Baserat på Huawei Clouds Ascend-molntjänst har vi lanserat DeepSeek x Silicon Mobility x Huawei Cloud R1 & V3 model inference service för första gången.

Genom gemensam innovation mellan de två parterna, och med stöd av den egenutvecklade inferensaccelerationsmotorn, kan DeepSeek-modellen som distribueras av Silicon Mobility-teamet baserat på Huawei Clouds Ascend-molntjänst uppnå samma effekt som en avancerad GPU-distributionsmodell i världen.

Tillhandahålla stabila DeepSeek-R1- och V3-inferenstjänster på produktionsnivå. Detta gör det möjligt för utvecklare att köra stabilt i storskaliga produktionsmiljöer och möta behoven av kommersiell distribution. Huawei Cloud Ascend AI-tjänster tillhandahåller riklig, elastisk och tillräcklig datorkraft.

Det finns ingen distributionströskel, vilket gör det möjligt för utvecklare att fokusera mer på applikationsutveckling. När de utvecklar applikationer kan de direkt anropa SiliconCloud API, vilket ger en enklare och mer användarvänlig upplevelse.

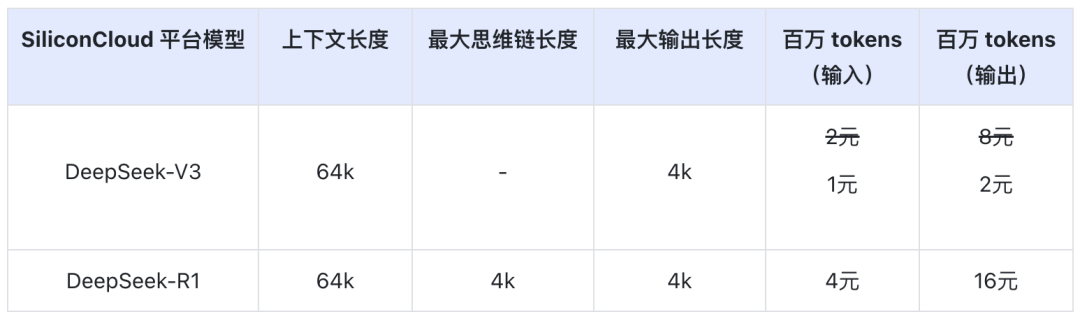

Priset för DeepSeek-V3 på SiliconCloud under den officiella rabattperioden (fram till kl. 24.00 den 8 februari) är ¥1 / M tokens (input) & ¥2 / M tokens (output), och priset för DeepSeek-R1 är ¥4 / M tokens (input) & ¥16 / M tokens (output).

Erfarenhet online

DeepSeek-R1 med SiliconCloud

DeepSeek-V3 med SiliconCloud

API-dokumentation

Utvecklare kan uppleva effekten av DeepSeek-R1 & V3 accelererad på inhemska chips på SiliconCloud. Den snabbare utmatningshastigheten optimeras fortfarande kontinuerligt.

Erfarenhet av klientapplikationer

Om du vill uppleva DeepSeek-R1 & V3-modellen direkt i klientapplikationen kan du installera följande produkter lokalt och komma åt SiliconCloud API (du kan anpassa och lägga till dessa två modeller) för att uppleva DeepSeek-R1 & V3.

- Klientapplikationer av stor modell: Chattbox, Cherry Studio, OneAPI, LobeChat, NextChat

- Applikationer för kodgenerering: Markör, Vindsurfing, Cline

- Plattform för utveckling av applikationer för stora modeller:Difiera

- Kunskapsbas för AI:Obsidian AI, ochFastGPT

- Plug-in för översättning:Immersive Translate, ochEurodict

För fler handledningar om scenarier och tillämpningsfall, se här

Token Factory SiliconCloud

Qwen2.5 (7B), etc. 20+ modeller fria att använda

Som en one-stop molntjänstplattform för stora modeller har SiliconCloud åtagit sig att förse utvecklare med modell-API: er som är extremt responsiva, prisvärda, omfattande och har en silkeslen upplevelse.

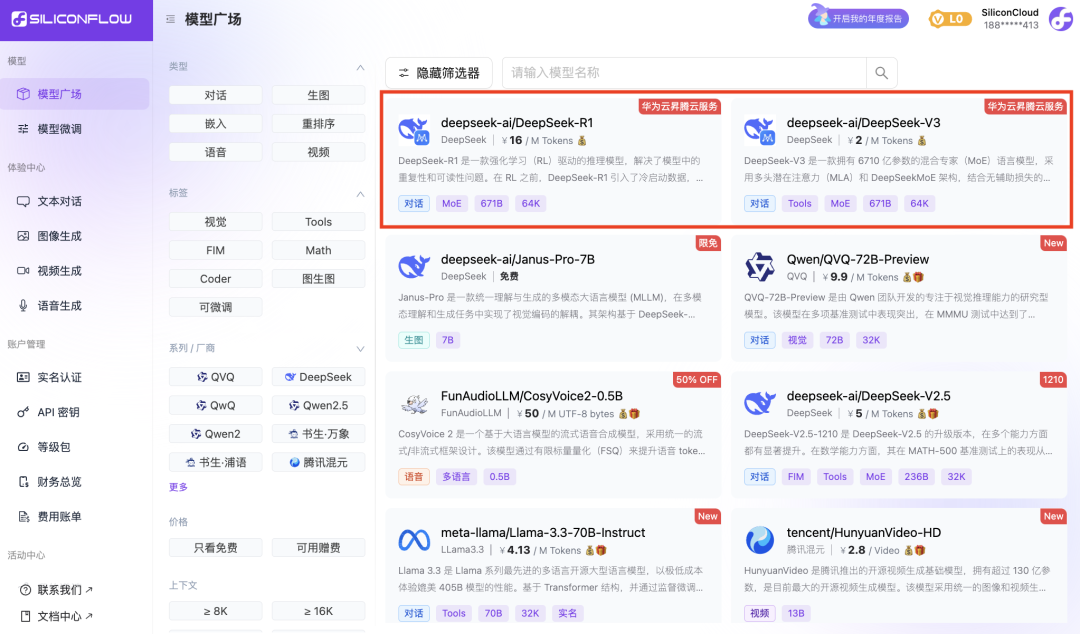

Förutom DeepSeek-R1 och DeepSeek-V3 har SiliconCloud även lanserat Janus-Pro-7B, CosyVoice2, QVQ-72B-Preview, DeepSeek-VL2, DeepSeek-V2.5-1210, Llama-3.3-70B-Instruct, HunyuanVideo, fish-speech-1.5, Qwen2.5 -7B/14B/32B/72B, FLUX.1, InternLM2.5-20B-Chat, BCE, BGE, SenseVoice-Small, GLM-4-9B-Chat,

dussintals stora språkmodeller med öppen källkod, modeller för bild-/videogenerering, talmodeller, kod-/matmodeller samt vektor- och omordningsmodeller.

Plattformen gör det möjligt för utvecklare att fritt jämföra och kombinera stora modeller av olika modaliteter för att välja den bästa metoden för din generativa AI-applikation.

Bland dem är 20+ stora modell-API: er som Qwen2.5 (7B) och Llama3.1 (8B) gratis att använda, vilket gör det möjligt för utvecklare och produktchefer att uppnå "tokenfrihet" utan att oroa sig för kostnaden för datorkraft under forsknings- och utvecklingsstadiet och storskalig marknadsföring.