OpenAI har släppt sin senaste inferensmodell, o3-minisom är optimerad för områden som vetenskap, matematik och programmering, vilket ger snabbare svar, högre noggrannhet och lägre kostnad.

Jämfört med sin föregångare o1-mini har o3-mini avsevärt förbättrat sin slutledningsförmåga, särskilt när det gäller att lösa komplexa problem. Testarna föredrar o3-minis svar med 56%, och felprocenten har minskat med 39%. Från och med idag, ChattGPT Plus, Team och Pro användare kan använda o3-mini, och fria användare kan också uppleva några av dess funktioner.

Jämfört med inferensmodellen DeepSeek-R1hur mycket bättre är det egentligen OpenAI o3-mini än R1?

Den här artikeln kommer först att ge en översikt över höjdpunkterna i o3-mini, och sedan kommer vi att extrahera data från båda sidor på varje riktmärke och göra ett diagram för att visuellt jämföra dem. Dessutom kommer vi också att jämföra priset på o3-mini.

Viktiga händelser

1.STEM-optimering: utmärker sig inom områdena matematik, programmering, vetenskap etc., och överträffar särskilt o1-mini i läget för hög inferensansträngning.

2.Funktioner för utvecklare: stöder funktioner som funktionsanrop, strukturerad utdata och meddelanden från utvecklare för att tillgodose behoven i produktionsmiljön.

3.Snabb respons: 24% snabbare än o1-mini, med en svarstid på 7,7 sekunder per förfrågan.

4.Förbättrad säkerhet: garanterar säker och tillförlitlig utmatning genom djupinriktningsteknik.

5.Kostnadseffektivt: Inferensförmåga och kostnadsoptimering går hand i hand, vilket kraftigt sänker tröskeln för AI-användning.

Jämför

Open AI För att lyfta fram sin klass, sin officiell blogg jämför det bara med sina egna modeller. Därför är den här artikeln en tabell som extraherats från DeepSeek R1-papperet och uppgifterna från den officiella OpenAI-bloggen.

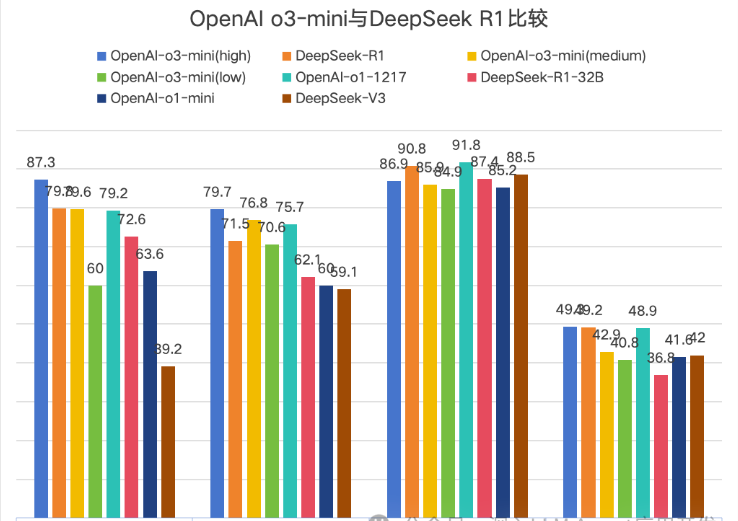

OpenAI jämför officiellt o3-mini i versionslistan och delade upp den i tre versioner: låg, medel och hög, som anger inferensstyrka. Eftersom DeepSeek använder Math-500 och OpenAI använder Math-datasetet har denna jämförelse tagits bort här.

Ett diagram är mer intuitivt, och Codeforces har tagits bort eftersom värdena är för stora för att visas intuitivt. Jämförelsen med Codeforces visar dock att o3-minis höga inferensstyrka inte är något större försprång.

↑1AIME2024→2GPQA Diamant→3MMLU→4SWE-bench-Verifierad

Av diagrammet framgår att det finns totalt 4 jämförelser och att O3-mini (hög) i allmänhet leder, men att ledningen är mycket liten.

Pris

| modell | Pris på insatsvaror | Cache träff | Utgående pris |

| o3-mini | $1.10 | $0.55 | $4.40 |

| o1 | $15.00 | $7.50 | $60.00 |

| Deepseek R1 | $0.55 | $0.14 | $2.19 |

Sammanfattning

När DeepSeek R1 utlöste DeepSeek-paniken i USA var OpenAI den första att känna sig hotad, vilket är särskilt tydligt i prissättningen av den nya modellen o3-mini.

När Openai o1 först släpptes satte dess höga pris press på många utvecklare och användare. Utseendet på DeepSeek R1 gav alla fler val.Från den 30-faldiga prisskillnaden mellan o1 och R1 till det slutliga priset på o3-mini som var två gånger priset på DeepSeek R1,

visar effekten av DeepSeek R1 på openai.ChatGPT:s gratisanvändare kan dock bara uppleva o3-mini på ett begränsat sätt, medan DeepSeek:s Deep Thinking för närvarande är tillgängligt för alla användare.Jag ser också fram emot att openai kommer att erbjuda fler ledande ai-modeller samtidigt som användarkostnaderna minskar.

Ur perspektivet av en bloggares personliga erfarenhet av att använda R1, skulle jag vilja säga att R1: s Deep Thinking alltid öppnar mitt sinne. Jag rekommenderar att alla använder det mer för att tänka på problem ~