Historien om Gemini 2,0 accelererer.

Flash Thinking Experimental-versionen i december bragte udviklere en fungerende model med lav latenstid og høj ydeevne.

Tidligere i år blev 2.0 Flash Thinking Experimental opdateret i Google AI Studio for at forbedre ydeevnen yderligere ved at kombinere Flash-hastigheden med forbedrede inferensegenskaber.

I sidste uge blev den opdaterede version 2.0 Flash fuldt lanceret på Gemini desktop- og mobilapps.

I dag er tre nye medlemmer blevet afsløret på samme tid: Den eksperimentelle version af Gemini 2.0 Pro, som hidtil har klaret sig bedst inden for kodning og komplekse prompter, den omkostningseffektive 2.0 Flash-Lite og den tankevækkende version 2.0 Flash Thinking.

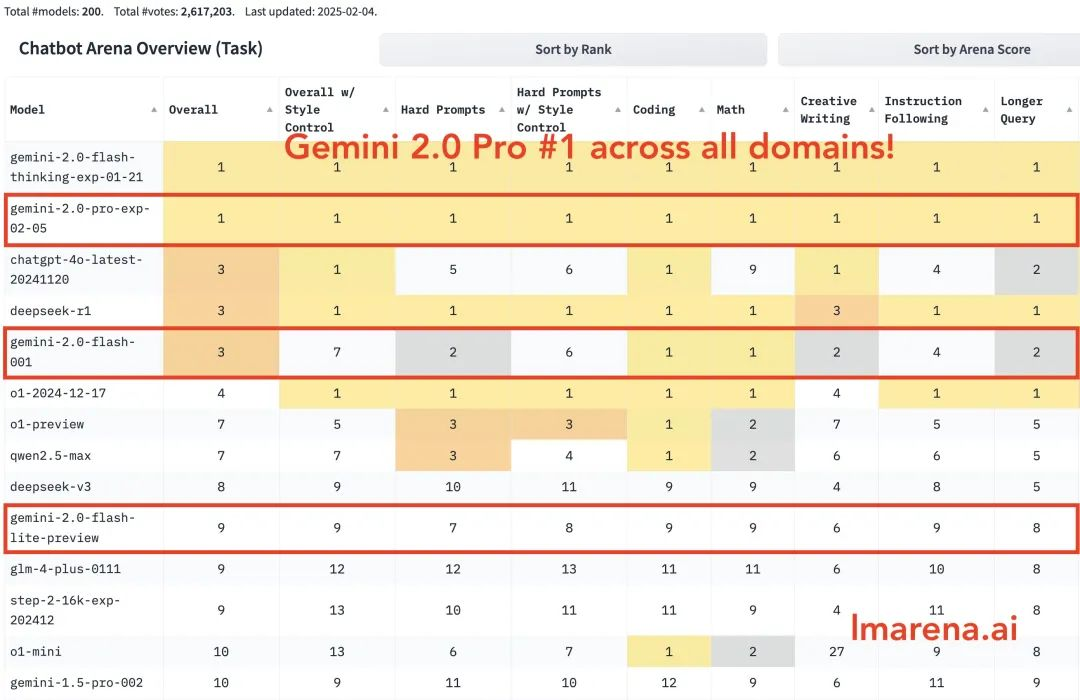

Gemini 2.0 Pro rangerer først i alle kategorier. Gemini-2.0-Flash er blandt de tre bedste inden for kodning, matematik og puslespil. Flash-lite er blandt de ti bedste i alle kategorier.

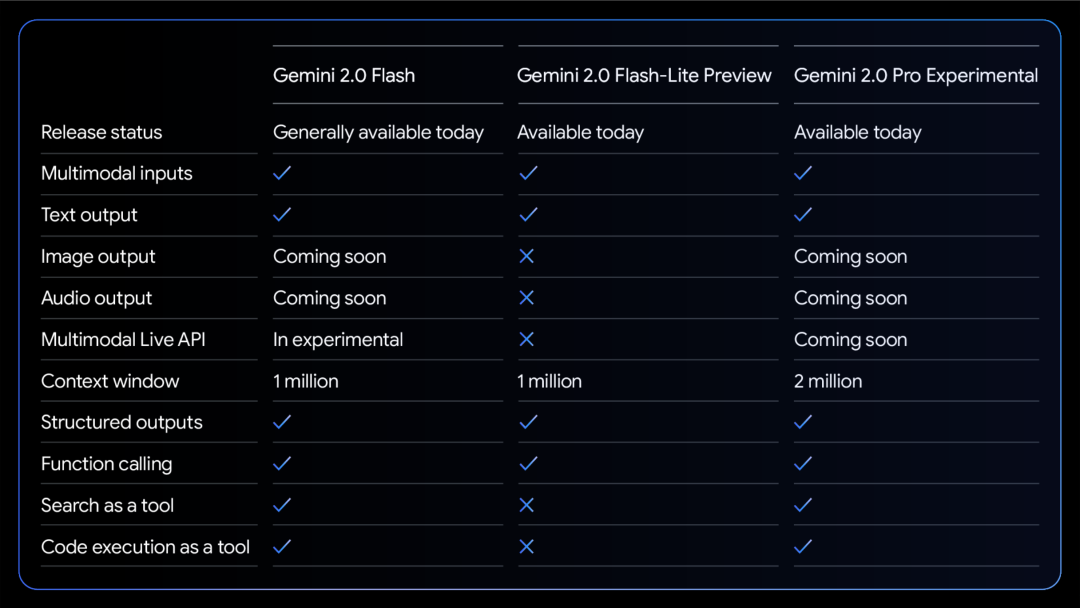

Et sammenligningsskema over de tre modellers evner:

Alle modeller understøtter multimodal input og output tekst.

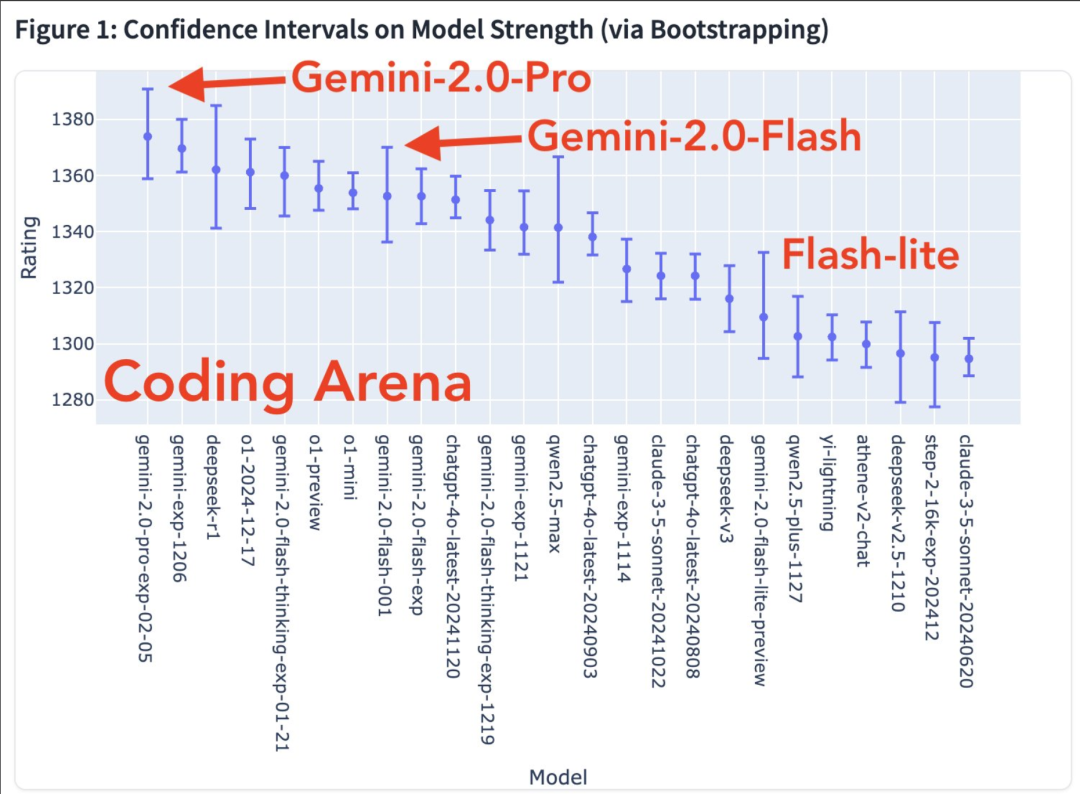

Flere modale evner er på vej. Modelstyrkediagram i kodningsarenaen

Vind rate varmekort

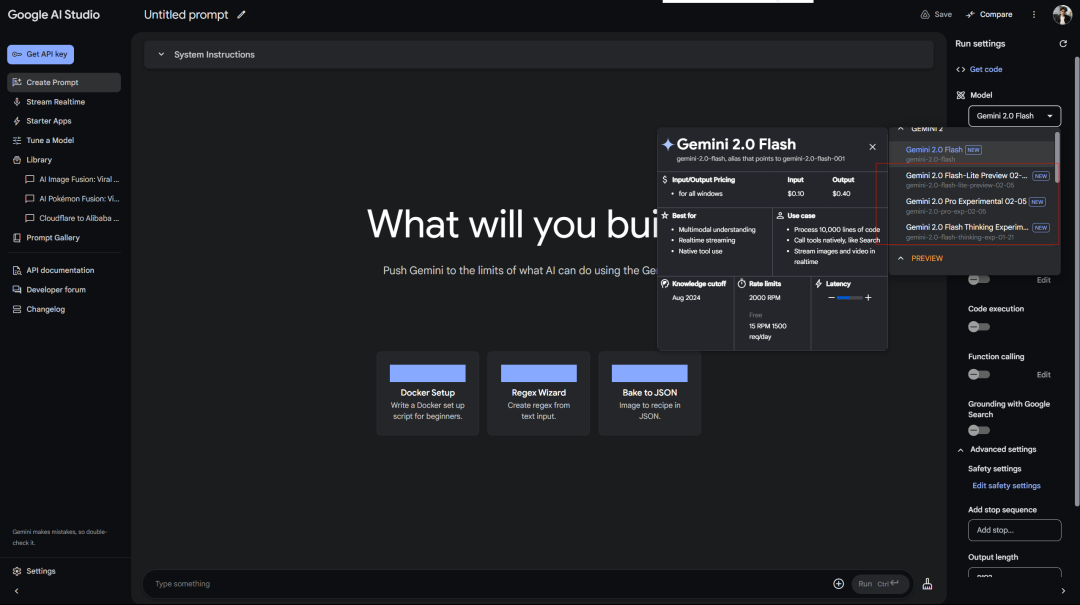

Google behandler gratis brugere bedre end OpenAI behandler Plus-brugere. Gratis adgang til Gemini 2.0 Pro Experimental i AI Studio:

Deepseek-tjenesten viser altid en fejl, der venter... Husk, at den første slutningsfri model også var 2.0 Flash Thinking, som blev brugt i Google aistudio.

Derudover er der webversion af Gemini:

Der er også en forbundet inferensmodel (så hvorfor adskille den...)

Google udgav den eksperimentelle version af Gemini 2.0 Pro, og forbedringen i officielle benchmark-tests er ret iøjnefaldende.

Den har de mest kraftfulde kodningsfunktioner og evnen til at behandle komplekse prompter og har en bedre evne til at forstå og ræsonnere om verdensviden end nogen anden model udgivet af Google indtil videre.

Den har det største kontekstvindue (200k, og min lange kontekst er en relativt stor fordel ved Gemini-modellen), hvilket gør den i stand til at analysere og forstå en stor mængde information, og at kalde værktøjer som Google-søgning og kodeeksekvering.

I MATH-testen opnåede den 91.8%, en stigning på omkring 5 procentpoint i forhold til version 1.5. GPQA-ræsonneringsevnen nåede 64.7%, og SimpleQA verdenskendskabstest nåede endda 44.3%.

Det mest bemærkelsesværdige er programmeringsevnen. Den opnåede 36.0% i LiveCodeBench-testen, og Bird-SQL-konverteringsnøjagtigheden oversteg 59.3%. Sammen med det superstore kontekstvindue på 2 millioner tokens er det nok til at håndtere de mest komplekse kodeanalyseopgaver.

Du kan prøve det i markøren.

Den flersprogede forståelsesevne er også imponerende med en global MMLU-testscore på 86.5%. Billedforståelse MMMU er 72.7%, og videoanalyseevne er 71.9%.

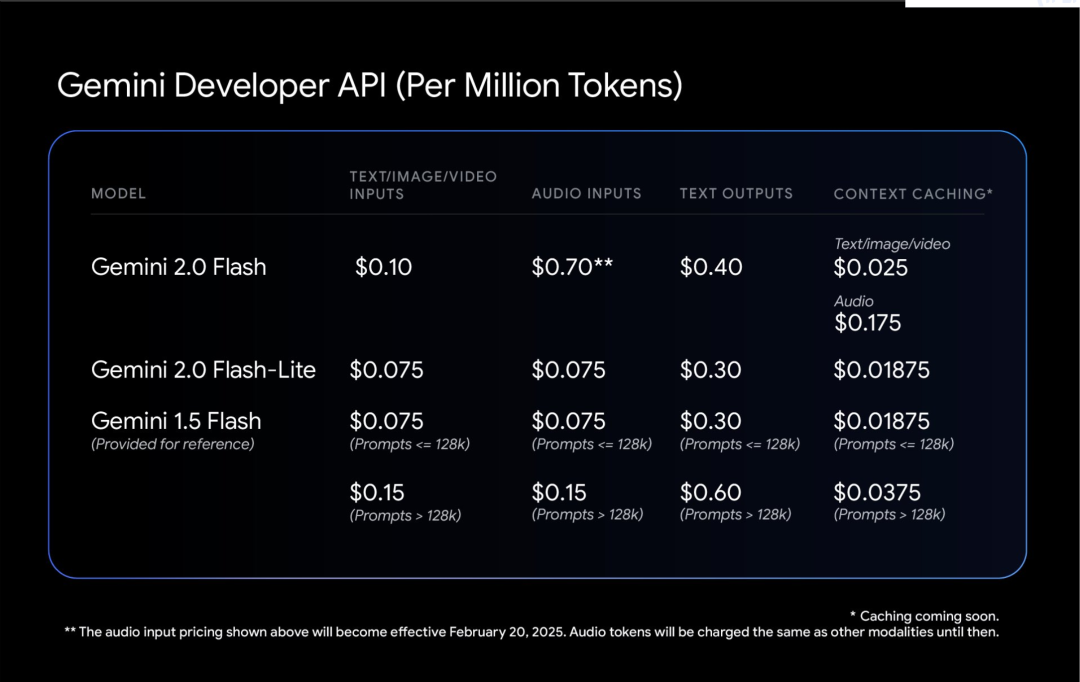

Gemini 2.0 Flash-Lite er en interessant balance.

Det bibeholder hastigheden og prisen på 1,5 Flash, men giver bedre ydeevne. Kontekstvinduet med 1 million tokens giver den mulighed for at behandle flere oplysninger.

Det mest praktiske er dets pris/ydelsesforhold: generering af billedtekster til 40.000 billeder koster mindre end $1. Dette gør AI mere jordnær.

Blogger Shrivastava nævnte: Gemini 2.0 Pro-kodning er vanvittig!

Tip: Brug Three.js til at lave en solsystemsimulering. Tilføj en tidsskala, en fokus-rullemenu, vis baner og vis etiketter. Opret alt i én fil, så jeg kan indsætte det i en online editor og se outputtet.

Derudover nævnte nogle brugere, at Gemini 2.0 Flash gav bedre resultater i en af hans egne paradokstest:

Endelig nævnte Google, at sikkerheden i Gemini 2.0, ikke kun patchen, er kernen i designet fra begyndelsen.

Lad modellen lære at være selvkritisk. Brug forstærkende læring til at lade Gemini evaluere sine egne svar og give mere præcis feedback. Dette gør det mere robust, når man beskæftiger sig med følsomme emner.

Den automatiske test af røde hold er interessant. Det er specifikt designet til at forhindre indsprøjtning af indirekte prompte ord, hvilket er som at udstyre AI med et immunsystem for at forhindre nogen i at skjule ondsindede kommandoer i dataene.