De høje omkostninger ved at bruge store AI-modeller er en væsentlig årsag til, at mange AI-applikationer endnu ikke er blevet implementeret og promoveret. At vælge ekstrem ydeevne betyder enorme omkostninger til computerkraft, hvilket fører til høje forbrugsomkostninger, som almindelige brugere ikke kan acceptere.

Konkurrencen om store AI-modeller er som en krig uden røg. Efter at DeepSeek frigav og åbnede den seneste R1 store model, udgav OpenAI også sin egen nyeste o3-model under pres. Den store modelspiller Google måtte også slutte sig til den hårde konkurrence om lavprismodeller.

Googles nye træk: nye medlemmer af Gemini-serien afsløret

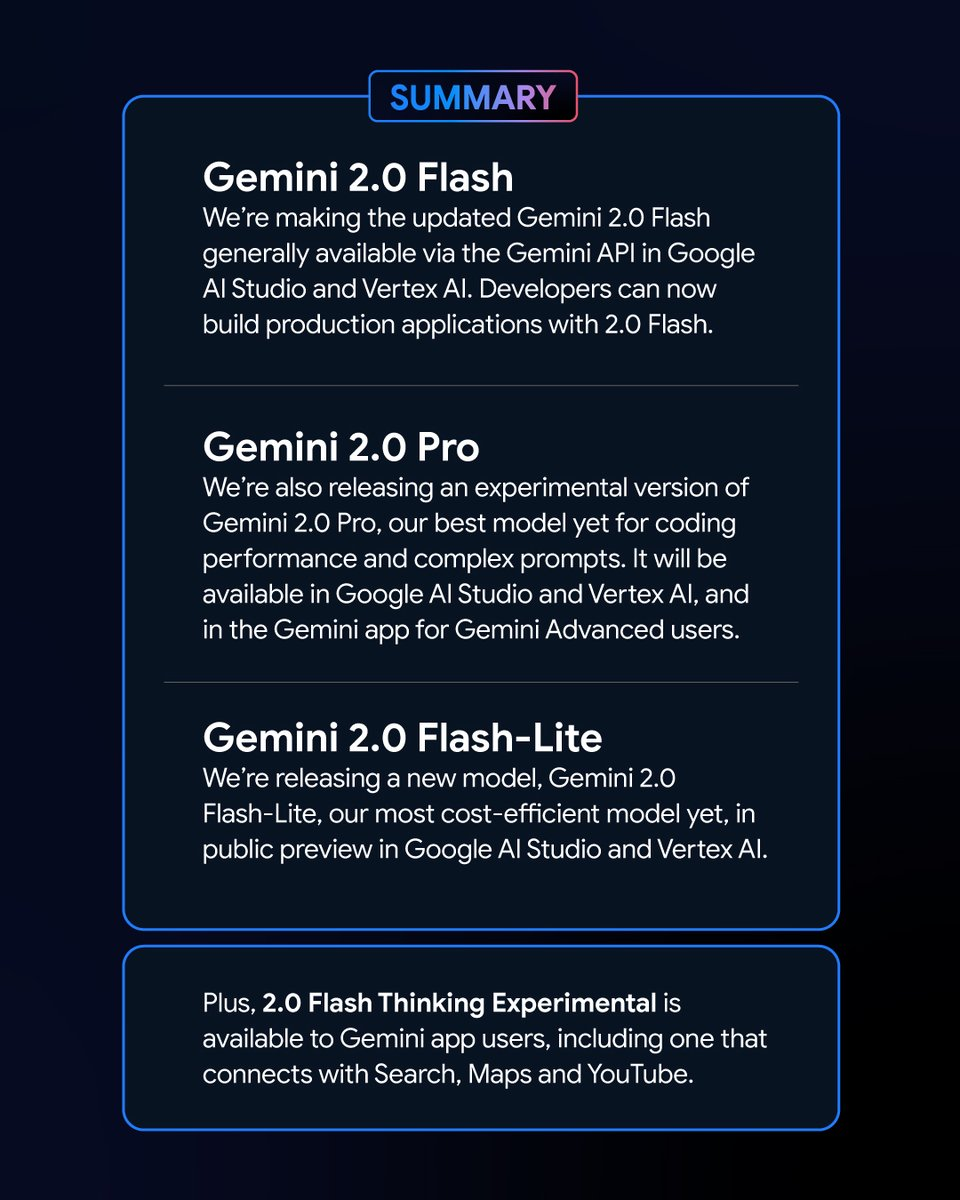

Tidligt om morgenen den 6. februar lancerede Google en række nye versioner af Gemini-modellen. Blandt dem den eksperimentelle version af Gemini 2.0 Pro og preview-versionen af Gemini 2.0 Flash – Lite vakte stor opmærksomhed, og den seneste version af Gemini 2.0 Flash blev officielt frigivet.

Som en ny variant, Google Gemini 2.0 Flash – Lite har en meget attraktiv pris på kun 0,3 USD per million tokens, hvilket gør den til Googles mest overkommelige model til dato.

Den eksperimentelle version af Gemini 2.0 Pro har på den anden side kraftfulde native multimodale muligheder, der kan konvertere mellem tekst og lyd og video.

Den eksperimentelle version af Gemini 2.0 Flash Thinking er gratis at bruge og har også mulighed for at få adgang til, udtrække og opsummere indholdet af YouTube-videoer.

Logan Kilpatrick, leder af Google AI Studio-produkter, annoncerede på X-platformen, at disse modeller er "de mest kraftfulde modeller i Googles historie" og er tilgængelige for alle udviklere.

De nye Gemini-modellers imponerende ydeevne og resultater på ranglisten

I Chatbot Arena Large Model Leaderboard har Gemini 2.0 Flash Thinking Experimental Edition og Gemini 2.0 Pro Experimental Edition opnået enestående resultater. Sammenlignet med tidligere Google store modeller har Gemini 2.0 gjort store fremskridt, og ikke overraskende har de med succes nået toppen af ranglisten, med en kombineret score, der overgår ChatGPT-4o og DeepSeek-R1. Dette er en kæmpe forbedring.

Dette resultat er baseret på en omfattende evaluering af store modellers muligheder på forskellige områder, herunder matematik, kodning og flersproget behandling.

Pris og ydeevne: hver variant af Gemini 2.0 har sine egne fordele

De forskellige versioner af Gemini 2.0 har deres egne karakteristika med hensyn til pris og ydeevne. Der er opnået en balance mellem ydeevne og pris, hvilket giver brugerne flere valgmuligheder. API'erne for de forskellige versioner af Gemini 2.0 kan kaldes gennem Google AI Studio og Vertex AI. Udviklere og brugere kan vælge den passende version efter deres behov.

Gemini 2.0 har gjort store fremskridt og udvikling sammenlignet med Gemini 1.5. Selvom de forskellige versioner af Gemini 2.0 har forskelle, er de alle blevet forbedret generelt. Helt konkret skal du bestemme det scenarie, du bruger, og så kan du bedre vælge den Gemini-model, der passer til dig.

Prismæssigt fokuserer Gemini 2.0 Flash og Gemini 2.0 Flash – Lite på letvægtsimplementering. De understøtter op til 1 million tokens i længden af kontekstvinduet, og med hensyn til prissætning er skelnen mellem lang og kort tekstbehandling i Gemini 1.5 Flash blevet fjernet, og prisen er samlet til en enhedstoken-pris.

Gemini 2.0 Flash koster 0,4 USD per million tokens til tekstoutput, hvilket er halv pris af Gemini 1.5 Flash ved behandling af lange tekster.

Gemini 2.0 Flash – Lite er endnu bedre til omkostningsoptimering i store tekstoutputscenarier med en tekstoutputpris på 0,3 USD pr. million tokens. Selv Googles administrerende direktør Sundar Pichai roste det som "effektivt og kraftfuldt".

Med hensyn til ydeevneforbedring har Gemini 2.0 Flash mere omfattende multimodale interaktionsfunktioner end Lite-versionen. Det er planlagt til at understøtte billedoutput, såvel som tovejs real-time low-latency input og output af modaliteter såsom tekst, lyd og video.

Den eksperimentelle version af Gemini 2.0 Pro udmærker sig med hensyn til kodningsydelse og komplekse prompter. Dets kontekstvindue kan nå op til 2 millioner tokens, og dets generelle evne er steget fra 75.8% til 79.1% sammenlignet med den forrige generation, hvilket er en væsentlig forskel i kodnings- og ræsonnementevne med Gemini 2.0 Flash og Gemini 2.0 Flash – Lite.

Gemini-applikationsteamet sagde på X-platformen, at Gemini Advanced-brugere kan få adgang til den eksperimentelle version af Gemini 2.0 Pro gennem rullemenuen for model, og den eksperimentelle version af Gemini 2.0 Flash Thinking er gratis for brugere af Gemini-applikationer, og denne version kan bruges sammen med YouTube, Google-søgning og Google Maps.

Konkurrencebekæmpelse: Google-konkurrence om omkostningseffektivitet

På et tidspunkt, hvor omkostningerne ved modeludvikling er blevet et varmt emne i branchen, har lanceringen af open source, lavpris, højtydende DeepSeek – R1 haft indflydelse på hele branchen.

Under konferenceopkaldet efter udgivelsen af Googles finansielle rapport for fjerde kvartal 2024, understregede Pichai, mens han anerkendte resultaterne af DeepSeek, også, at Gemini-serien af modeller er førende i balancen mellem omkostninger, ydeevne og latenstid, og at deres samlede ydeevne er bedre end DeepSeeks V3- og R1-modeller.

Fra perspektivet af rangeringen af LiveBench-benchmark-testen for store modeller, bygget af Yang Likun og hans team, er den overordnede placering af Gemini 2.0 Flash højere end for DeepSeek V3 og OpenAI's o1 – mini, men den er bag DeepSeek – R1 og OpenAI's o1. Googles lancering af Gemini 2.0 Flash – Lite er dog som et trumfkort. Google håber at gøre de nyeste store modeller overkommelige for flere mennesker, reducere brugernes forbrugsomkostninger og håber at indtage en plads i konkurrencen mellem virksomheder om pris/ydelse.

Efter at Google frigav seneste Gemini 2.0, begyndte en netbruger at prøve at analysere Gemini 2.0 Flash og andre populære deepseek og openai GPT-4o modeller på egen hånd. Han fandt ud af, at den nye version af Gemini 2.0 Flash overgår de to andre modeller med hensyn til både ydeevne og omkostninger. Dette giver os også et indblik i Googles udvikling og udvikling, og det er en god start.

Specifikt koster Gemini 2.0 Flash 0,1 USD pr. million tokens for input og 0,4 USD for output, som begge er langt lavere end DeepSeek V3. Dette er en kæmpe forbedring og udvikling. Netizen påpegede også på X-platformen: "Den officielle version af Gemini 2.0 Flash koster en tredjedel af GPT-4o-mini, mens den er tre gange så hurtig."

En ny trend på det store modelmarked: værdi for pengene er konge

I dag er det store modelfelt fanget i en ny priskrig. Tidligere har de høje omkostninger ved at bruge store modeller skabt en vis modstand mod deres brug og promovering. Virkningen af priskrigen for store modeller udløst af DeepSeek på det oversøiske marked for store modeller fortsætter stadig med at gære. Samtidig har open source-muligheden også givet flere brugere mulighed for at forstå og bruge de seneste store modelforskningsresultater. Open source + lavpris-strategien har også lagt pres på mange amerikanske store modelvirksomheder.

Google lancerede Gemini 2.0 Flash-Lite, og OpenAI gjorde ChatGPT-søgefunktionen frit tilgængelig for alle brugere, så brugerne kan bruge søgefunktionen til at udføre mere forskelligartede opgaver. Metas interne team optrapper også forskningen i prisreduktionsstrategier for store modeller, mens de fremmer den videre udvikling af Metas store open source-modeller.

I dette stærkt konkurrenceprægede felt kan ingen virksomhed sidde komfortabelt på førstepladsen. Virksomheder forsøger at tiltrække og fastholde brugere ved at forbedre omkostningseffektiviteten. Denne tendens vil hjælpe store modeller med at bevæge sig fra ren teknologisk udvikling til bredere anvendelse, og det fremtidige marked for store modeller vil fortsætte med at udvikle sig og ændre sig i konkurrencen om omkostningseffektivitet.