Ingen af os forventede, at det var sådan, 2025 ville begynde på AI-området.

DeepSeek R1 er virkelig fantastisk!

For nylig har den "mystiske østlige magt" DeepSeek "hårdt kontrolleret" Silicon Valley.

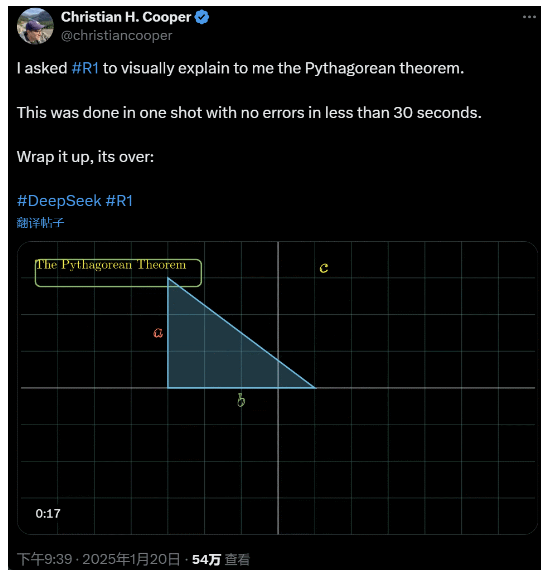

Jeg bad R1 om at forklare Pythagoras' læresætning i detaljer. Alt dette blev gjort af AI på mindre end 30 sekunder uden nogen fejl. Kort sagt, det er slut.

I indenlandske og udenlandske AI-kredse har almindelige netbrugere opdaget den fantastiske og kraftfulde nye AI (som også er open source), og akademiske eksperter har råbt "vi må indhente det forsømte". Der er også rygter om, at udenlandske AI-virksomheder allerede står over for en stor trussel.

Tag bare denne DeepSeek R1, der blev udgivet i denne uge. Dens rene forstærkningslæring uden nogen form for overvåget træning er chokerende. Fra udviklingen af Deepseek-v3-basen i december sidste år til den nuværende tankekædes kapacitet, der kan sammenlignes med OpenAI o1, ser det ud til at være et spørgsmål om tid.

Men mens AI-samfundet har travlt med at læse tekniske rapporter og sammenligne faktiske målinger, er folk stadig i tvivl om R1: Bortset fra at være i stand til at overgå en masse benchmarks, kan det så virkelig føre an?

Kan den bygge sine egne simuleringer af "fysiske love"?

Tror du ikke på det? Lad os lade den store model lege med en flipper?

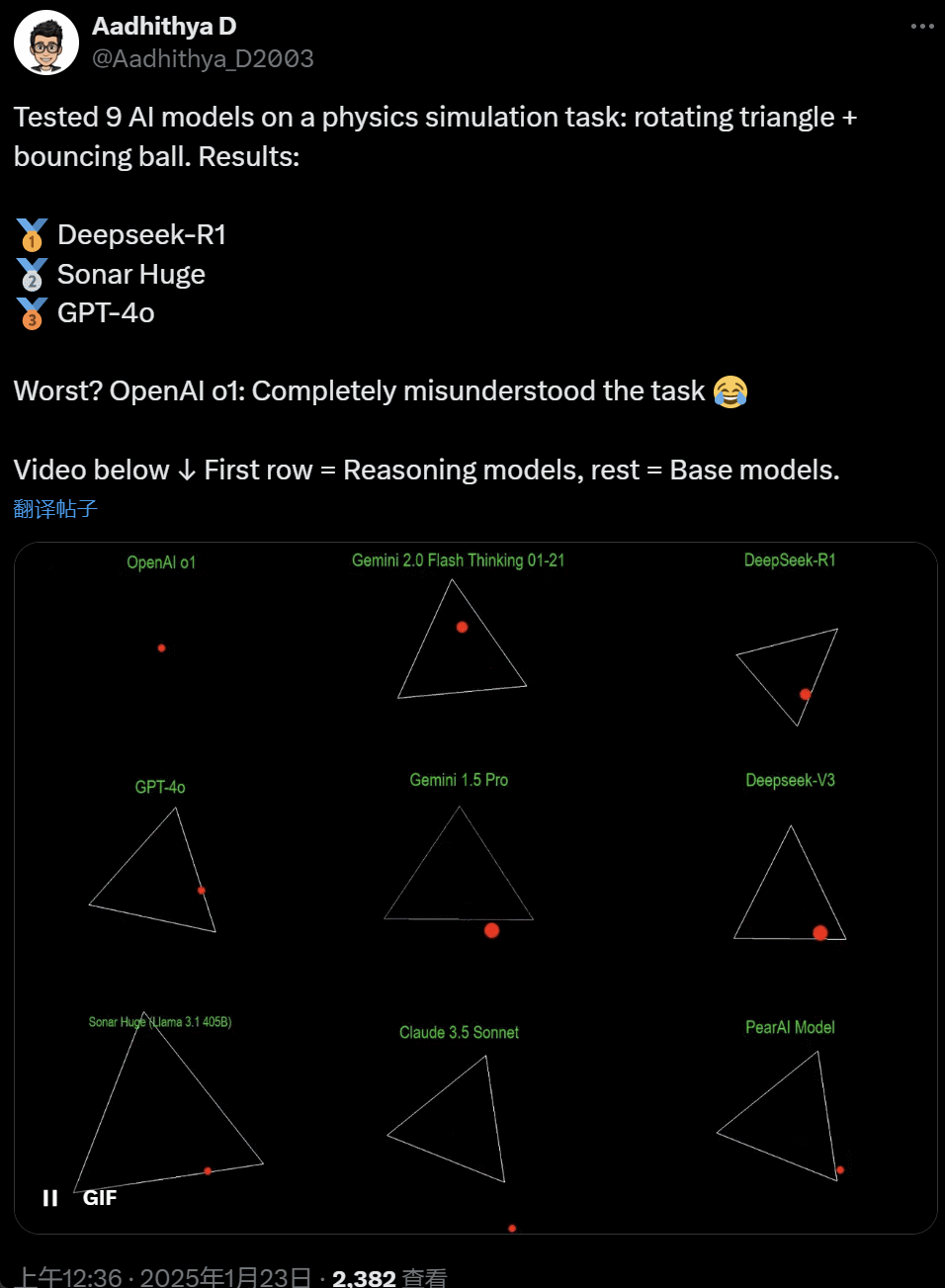

I de seneste dage er nogle mennesker i AI-samfundet blevet besat af en test - at teste forskellige store AI-modeller (især de såkaldte ræsonnerende modeller) for at løse et problem: "Skriv et Python-script for at få en gul bold til at hoppe inde i en bestemt form. Få formen til at rotere langsomt, og sørg for, at bolden bliver inde i formen."

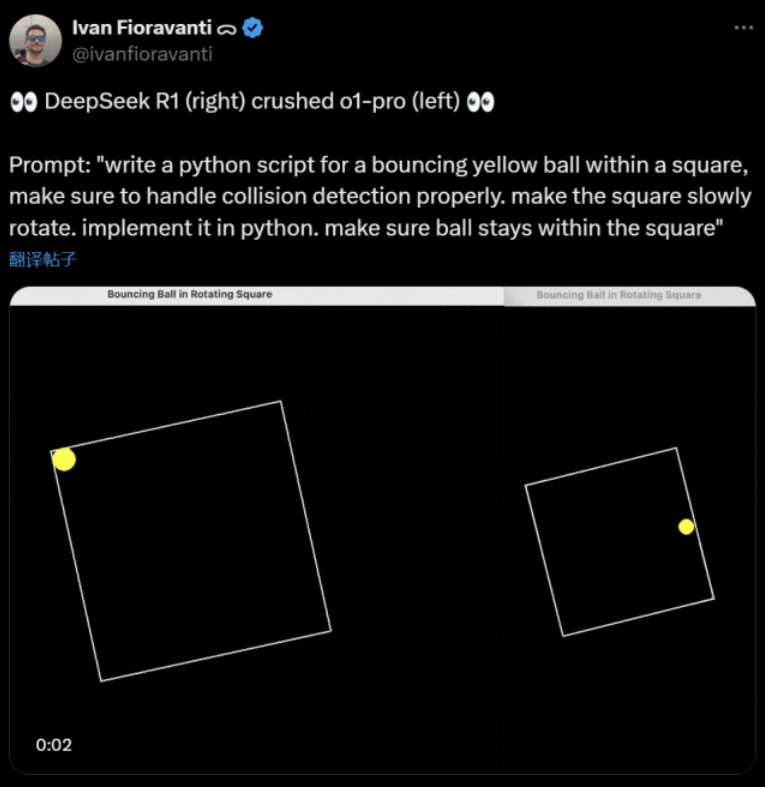

Nogle modeller klarer sig bedre end andre i denne "roterende bold"-benchmark. Ifølge CoreView CTO Ivan Fioravanti har DeepSeek, et indenlandsk laboratorium for kunstig intelligens, en stor open source-model R1, der slår OpenAI's o1 pro-model, som koster $200 pr. måned som en del af OpenAI's ChatGPT Pro-program.

Til venstre er OpenAI o1, og til højre er DeepSeek R1. Som nævnt ovenfor er opgaven her: "skriv et python-script til en hoppende gul bold inden for en firkant, sørg for at håndtere kollisionsregistrering korrekt. få firkanten til at rotere langsomt. implementer det i python. sørg for, at bolden bliver inden for firkanten."

Ifølge en anden bruger på X foretog Anthropic Claude 3.5 Sonnet og Googles Gemini 1.5 Pro-modeller forkerte bedømmelser af fysiske principper, hvilket fik bolden til at afvige fra sin form. Nogle brugere har også rapporteret, at Googles nyeste Gemini 2.0 Flash Thinking Experimental samt den relativt ældre OpenAI GPT-4o bestod vurderingen med det samme.

Men der er en måde at se forskel på her:

Netbrugere under dette tweet sagde: o1's evne var oprindeligt meget god, men den blev svagere, efter at OpenAI optimerede hastigheden, selv med medlemsversionen $200/måned.

At simulere en hoppende bold er en klassisk programmeringsudfordring. Nøjagtig simulering kombinerer kollisionsdetekteringsalgoritmer, som skal identificere, hvornår to objekter (f.eks. en bold og siden af en figur) kolliderer. En forkert skrevet algoritme kan påvirke simuleringens ydeevne eller forårsage åbenlyse fysiske fejl.

N8 Programs, en forsker hos AI-startup'en Nous Research, sagde, at det tog ham omkring to timer at skrive en hoppende bold i en roterende heptagon fra bunden. "Der skal spores flere koordinatsystemer, der kræves en forståelse af, hvordan kollisioner håndteres i hvert system, og koden skal designes fra bunden for at være robust."

Selv om hoppende bolde og snurrende figurer er en rimelig test af programmeringsfærdigheder, er det stadig nye projekter for store modeller, og selv små ændringer i anvisningerne kan give forskellige resultater. Så hvis den med tiden skal blive en del af benchmarktesten for store AI-modeller, skal den stadig forbedres.

Under alle omstændigheder har vi efter denne bølge af praktiske tests en fornemmelse af forskellene i kapacitet mellem store modeller.

DeepSeek er den nye "Silicon Valley-myte

DeepSeek skaber panik" på tværs af Stillehavet.

Meta-medarbejdere har skrevet, at "Meta-ingeniører er i fuld gang med at analysere DeepSeek for at prøve at kopiere alt, hvad de kan, fra den."

Alexandr Wang, grundlægger af AI-teknologi-startup'en Scale AI, har også offentligt udtalt, at præstationen af DeepSeek's store AI-model svarer nogenlunde til den bedste model i USA.

Han mener også, at USA måske har været foran Kina i AI-konkurrencen i løbet af det sidste årti, men DeepSeek's lancering af sin store AI-model kan "ændre alt".

X Blogger @8teAPi mener, at DeepSeek ikke er et "sideprojekt", men er som Lockheed Martins tidligere "Skunk Works".

Det såkaldte "Skunk Works" henviser til et yderst fortroligt, relativt uafhængigt lille team, som Lockheed Martin oprindeligt oprettede for at udvikle mange avancerede fly, der beskæftigede sig med banebrydende eller ukonventionel teknologiforskning og -udvikling. Fra U-2 rekognosceringsflyet og SR-71 Blackbird til F-22 Raptor og F-35 Lightning II jagerfly, de kom alle herfra.

Senere udviklede begrebet sig gradvist til et generisk begreb, der bruges til at beskrive "små, men fine", relativt uafhængige og mere fleksible innovationsteams, der er oprettet i store virksomheder eller organisationer.

Han gav to grunde:

- På den ene side har DeepSeek et stort antal GPU'er, efter sigende mere end 10.000, og Alexandr Wang, CEO for Scale AI, sagde endda, at det kunne nå op på 50.000.

- På den anden side rekrutterer DeepSeek kun talenter fra de tre bedste universiteter i Kina, hvilket betyder, at DeepSeek er lige så konkurrencedygtig som Alibaba og Tencent.

Alene disse to fakta viser, at DeepSeek tydeligvis har opnået kommerciel succes og er velkendt nok til at få disse ressourcer.

Med hensyn til DeepSeek's udviklingsomkostninger sagde bloggeren, at kinesiske teknologivirksomheder kan modtage en række tilskud, f.eks. lave elektricitetsomkostninger og brug af jord.

Derfor er det meget sandsynligt, at de fleste af DeepSeek's omkostninger er blevet "placeret" på en konto uden for kerneforretningen eller i form af en slags tilskud til opførelse af datacentre.

Selv bortset fra stifterne er der ingen, der helt forstår alle de økonomiske aftaler. Nogle aftaler er måske blot "mundtlige aftaler", som indgås alene på baggrund af omdømme.

Uanset hvad er der et par ting, der står klart:

- Modellen er fremragende og kan sammenlignes med den version, som OpenAI udgav for to måneder siden, og det er selvfølgelig muligt, at den ikke er lige så god som de nye modeller, som OpenAI og Anthropic endnu ikke har udgivet.

- Fra det nuværende perspektiv er forskningsretningen stadig domineret af amerikanske virksomheder. DeepSeek-modellen er en "hurtig opfølgning" på o1-versionen, men DeepSeek's forsknings- og udviklingsfremskridt er meget hurtige og indhenter dem hurtigere end forventet. De plagierer eller snyder ikke, de laver højst reverse engineering.

- DeepSeek uddanner hovedsageligt sine egne talenter i stedet for at stole på amerikansk uddannede ph.d.er, hvilket udvider talentmassen betydeligt.

- Sammenlignet med amerikanske virksomheder er DeepSeek underlagt færre begrænsninger med hensyn til licenser til intellektuel ejendom, privatlivets fred, sikkerhed, politik osv., og der er færre bekymringer om uretmæssig brug af data, som folk ikke ønsker at blive trænet i. Der er færre retssager, færre advokater og færre bekymringer.

Der er ingen tvivl om, at flere og flere mener, at 2025 bliver et afgørende år. I mellemtiden ruster virksomhederne sig til det. Meta bygger f.eks. et 2GW+-datacenter med en anslået investering på $60-65 milliarder i 2025 og vil have mere end 1,3 millioner GPU'er ved årets udgang.

Meta brugte endda et diagram til at sammenligne sit 2-gigawatt-datacenter med Manhattan i New York.

Men nu har DeepSeek gjort det bedre med lavere omkostninger og færre GPU'er. Hvordan kan det undgå at gøre folk nervøse?

Yann LeCun: Vi er nødt til at takke CTO'en og medstifteren af den åben kilde

Hyperbolsk, Yuchen Jin, for at skrive, at DeepSeek-R1 på bare 4 dage har bevist 4 fakta for os:

- Open source AI er kun 6 måneder bagud i forhold til closed source AI

- Kina dominerer open source-konkurrencen om kunstig intelligens

- Vi er på vej ind i guldalderen for forstærkningslæring af store sprogmodeller

- Destillationsmodeller er meget kraftfulde, og vi vil køre meget intelligent AI på mobiltelefoner

Den kædereaktion, som DeepSeek udløste, fortsætter stadig, f.eks. at OpenAI o3-mini blev gjort frit tilgængelig, håbet i samfundet om at reducere de vage diskussioner om AGI/ASI og rygtet om, at Meta er gået i panik.

Han mener, at det er svært at forudsige, hvem der i sidste ende vil vinde, men vi må ikke glemme styrken i efternølerens fordel. Vi ved jo alle, at det var Google, der opfandt Transformer, mens OpenAI frigjorde dens sande potentiale.

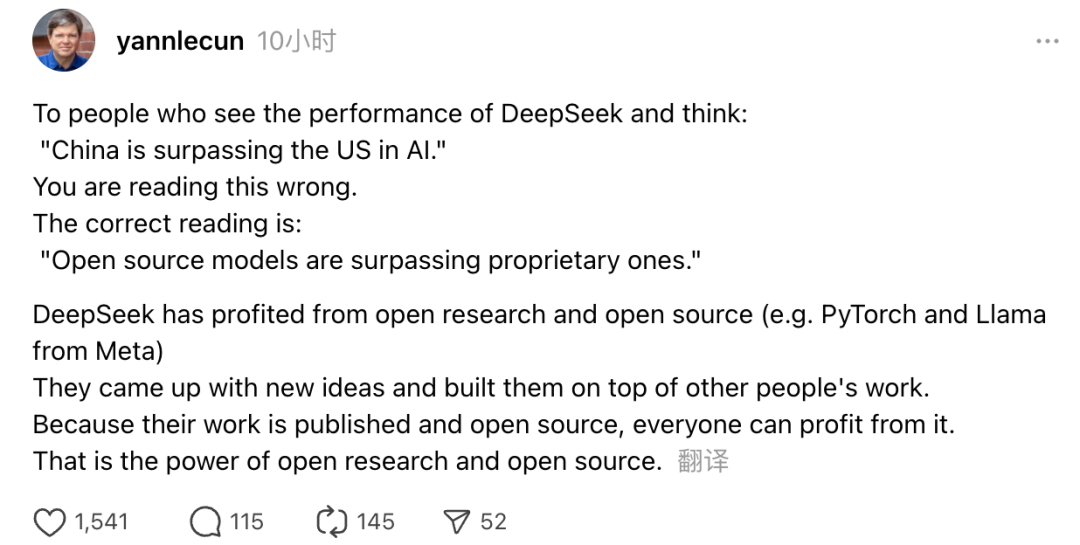

Derudover udtrykte vinderen af Turing Award og Metas Chief AI Scientist Yann LeCun også sine synspunkter.

"De, der efter at have set DeepSeek's resultater tænker: 'Kina er ved at overhale USA inden for AI', tager fejl. Den korrekte forståelse er, at open source-modeller er ved at overhale proprietære modeller."

LeCun sagde, at grunden til, at DeepSeek har gjort så meget væsen af sig denne gang, er, at de har nydt godt af åben forskning og open source (såsom Metas PyTorch og Llama). DeepSeek er kommet med nye ideer og har bygget videre på andres arbejde. Fordi deres arbejde er offentligt tilgængeligt og open source, kan alle få gavn af det. Det er styrken ved åben forskning og open source.

Netbrugernes refleksioner fortsætter. Selv om de er begejstrede for udviklingen af nye teknologier, kan de også mærke en lille atmosfære af angst. Når alt kommer til alt, kan fremkomsten af DeepSeekers have en reel indvirkning.