o3-mini est arrivé tard dans la nuit, et OpenAI a finalement révélé son dernier atout. Au cours d'une séance de questions-réponses AMA sur Reddit, Altman a profondément avoué qu'il s'était tenu du mauvais côté de l'IA open source.

Il a déclaré que la stratégie interne de l'open source était à l'étude et que le modèle continuerait à être développé, mais que l'avance d'OpenAI ne serait pas aussi importante qu'auparavant.

Alors que tout le monde s'émerveillait encore de l'incroyable puissance de DeepSeek, OpenAI n'a finalement pas pu rester sans rien faire.

Hier, au petit matin, o3-mini a été lancé en urgence, établissant de nouveaux SOTA dans des tests de référence tels que le code mathématique et le retour au trône.

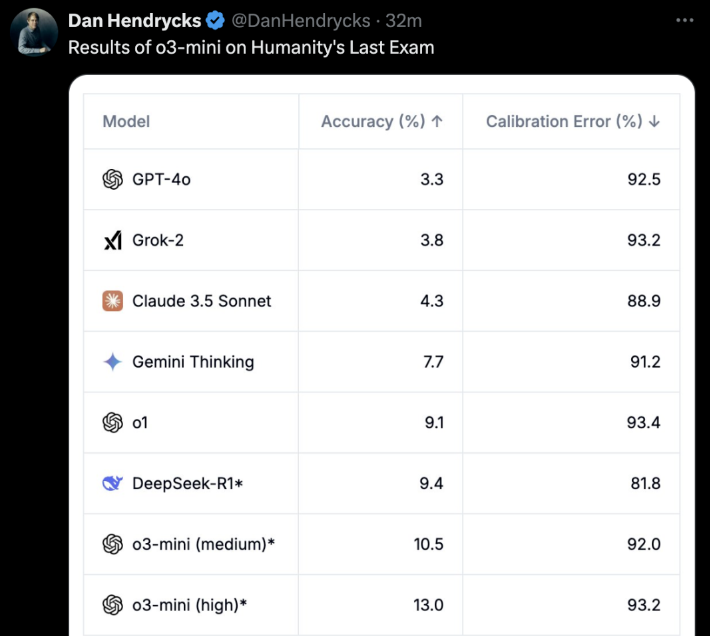

Le plus important, c'est que les utilisateurs gratuits peuvent également en faire l'expérience ! o3-mini n'est pas une plaisanterie. Lors du "dernier examen pour les humains", o3-mini (high) a obtenu directement la meilleure précision et la meilleure erreur d'étalonnage.

Quelques heures après o3-mini en ligneL'OpenAI a officiellement ouvert un AMA sur Reddit pendant environ une heure.

Altman lui-même s'est mis en ligne et a répondu à toutes les questions des internautes.

Les principaux points forts sont les suivants :

- DeepSeek est en effet très bonNous continuerons à développer de meilleurs modèles, mais l'avance ne sera pas aussi importante qu'auparavant.

- Par rapport à il y a quelques années, je suis aujourd'hui plus enclin à croire que l'IA peut faire des bonds rapides.

- Nous sommes du mauvais côté de la question de l'ouverture des modèles d'IA pondérés

- Une mise à jour du mode vocal avancé est prévue prochainement, et nous l'appellerons directement GPT-5, et non GPT-5o. Il n'y a pas encore de calendrier précis.

Outre M. Altman lui-même, Mark Chen, directeur de la recherche, Kevin Weil, directeur des produits, Srinivas Narayanan, vice-président de l'ingénierie, Michelle Pokrass, responsable de la recherche sur les API, et Hongyu Ren, responsable de la recherche, étaient également en ligne et ont répondu avec soin à toutes les questions des internautes.

Ensuite, regardons ce qu'ils ont tous dit.

Altman se repent profondément, ayant pris le mauvais parti dans la bataille de l'IA open source

Le retour soudain de DeepSeek a pu être inattendu pour tout le monde.

Au cours de la séance de questions-réponses de l'AMA, M. Altman s'est lui aussi profondément repenti d'avoir pris le mauvais parti dans la bataille de l'IA open source et a dû admettre les avantages considérables du DeepSeek.

Ce qui a étonné beaucoup de monde, c'est que M. Altman a même déclaré que l'avance d'OpenAI n'était plus aussi forte qu'auparavant.

Voici toutes les réponses classiques d'Altman que nous avons compilées.

Q : Parlons du grand sujet de la semaine : Deepseek. Il s'agit manifestement d'un modèle très impressionnant, et je sais qu'il a probablement été formé à partir des résultats d'autres LLM. En quoi cela changera-t-il vos plans pour les modèles futurs ?

Altman : C'est en effet un modèle très impressionnant ! Nous développerons de meilleurs modèles, mais nous ne pourrons pas conserver une avance aussi importante que les années précédentes.

Q : Pensez-vous que l'amélioration récursive de soi sera un processus progressif ou un décollage soudain ?

Altman : Personnellement, je pense que je suis plus enclin à penser que l'IA peut progresser rapidement que je ne l'étais il y a quelques années. Il est peut-être temps d'écrire quelque chose sur ce sujet...

Q : Peut-on voir tous les jetons auxquels le modèle pense ?

Altman : Oui, nous présenterons bientôt une version plus utile et plus détaillée. Merci à R1 pour cette mise à jour.

Kevin Weil, directeur général des produits : Nous nous efforçons de montrer plus de choses que nous ne le faisons actuellement, ce qui ne saurait tarder. Il reste à déterminer si nous montrerons tout ou non. Montrer toutes les chaînes de pensée (CoT) conduirait à une distillation des modèles des concurrents, mais nous savons aussi que les utilisateurs (au moins les utilisateurs avancés) veulent les voir, et nous trouverons donc un bon équilibre.

Q : Quand la version complète d'o3 sera-t-elle disponible ?

Altman : J'estime qu'il faudra plus de quelques semaines, mais pas plus de quelques mois.

Q : Y aura-t-il une mise à jour du mode vocal ? S'agit-il d'un objectif potentiel pour le GPT-5o ? Quel est le calendrier approximatif pour le GPT-5o ?

Altman : Oui, une mise à jour du mode vocal avancé est prévue ! Je pense que nous l'appellerons GPT-5, et non GPT-5o. Il n'y a pas encore de calendrier précis.

Q : Envisageriez-vous de publier des poids modèles et des travaux de recherche ?

Altman : Oui, nous en discutons. Personnellement, je pense que nous sommes du mauvais côté de cette question et que nous devons élaborer une stratégie différente en matière d'open source ; tout le monde à OpenAI ne partage pas ce point de vue, et ce n'est pas notre plus grande priorité pour le moment.

Une autre série de questions :

- Dans quelle mesure sommes-nous prêts à proposer Operator dans le cadre du programme régulier Plus ?

- Quelles sont les priorités du département robotique ?

- Que pense OpenAI des puces/TPU plus spécialisées, comme Trillium, Cerebras, etc. L'OpenAI y prête-t-elle attention ?

- Quels sont les investissements réalisés pour se prémunir contre les risques futurs d'AGI et d'ASI ?

- Quelles ont été vos vacances les plus mémorables ?

Altman :

- Quelques mois

- produire un très bon robot à petite échelle et tirer des enseignements de cette expérience

- Le GB200 est actuellement difficile à battre !

- Un bon choix serait d'améliorer votre état intérieur - résilience, adaptabilité, calme, joie, etc.

- Difficile de choisir ! Mais les deux premiers qui me viennent à l'esprit sont : un voyage sac au dos en Asie du Sud-Est ou un safari en Afrique.

Q : Envisagez-vous d'augmenter le prix de la série Plus ?

Altman : En fait, je veux la réduire progressivement.

Q : Supposons que nous soyons en 2030 et que vous veniez de créer un système que la plupart des gens qualifieraient d'AGI. Il excelle dans tous les tests de référence et surpasse vos meilleurs ingénieurs et chercheurs en termes de vitesse et de performance. Quelle est la prochaine étape ? À part "le mettre sur le site web et l'offrir en tant que service", avez-vous d'autres projets ?

Altman : L'impact le plus important, à mon avis, sera d'accélérer la découverte scientifique, ce qui, selon moi, est le facteur qui contribuera le plus à l'amélioration de la qualité de vie.

Génération d'images 4o, bientôt disponible

Ensuite, les réponses d'autres membres de l'OpenAI ont été ajoutées.

Q : Prévoyez-vous toujours de lancer le générateur d'images 4o ?

Kevin Weil, Directeur des produits : Oui ! Et je pense que l'attente en vaut la peine.

Q : Génial ! Y a-t-il un calendrier approximatif ?

Kevin Weil, chef de produit : Vous me demandez de m'attirer des ennuis. Peut-être quelques mois.

Et une autre question similaire.

Q : Quand pouvons-nous espérer voir le ChatGPT-5 ?

Kevin Weil, chef de produit : Peu après o-17 micro et GPT-(π+1).

Une autre question se pose :

- À quels autres types d'agents pouvons-nous nous attendre ?

- Et fournir un agent pour les utilisateurs libres, ce qui pourrait accélérer l'adoption...

- Des nouvelles de la nouvelle version de DALL-E ?

- Une dernière question, et c'est celle que tout le monde pose... Quand l'AGI sera-t-elle mise en œuvre ?

Kevin Weil, chef de produit :

- Plus d'agents : très, très bientôt. Je pense que vous serez heureux.

- Génération d'images à partir de 4o : dans quelques mois, j'ai hâte que vous l'utilisiez. C'est génial.

- AGI : Oui

Q : Prévoyez-vous d'ajouter au modèle de raisonnement une fonctionnalité de pièces jointes ?

Srinivas Narayanan, vice-président chargé de l'ingénierie : C'est en cours de développement. À l'avenir, le modèle de raisonnement pourra utiliser différents outils, y compris des fonctions de recherche.

Kevin Weil, directeur des produits : J'ai hâte de voir le modèle de raisonnement permettant d'utiliser les outils.

Q : Vraiment. Lorsque vous aurez résolu ce problème, des scénarios d'application de l'IA très utiles s'ouvriront. Imaginez qu'elle soit capable de comprendre le contenu de vos 500 Go de documents de travail.

Lorsque vous êtes sur le point de répondre à un courriel, un panneau s'ouvre à côté de votre application de messagerie qui analyse en permanence toutes les informations relatives à cette personne, y compris votre relation, les sujets abordés, les travaux antérieurs, etc. Un élément d'un document que vous avez oublié depuis longtemps sera peut-être signalé parce qu'il est très pertinent pour la discussion en cours. J'ai vraiment envie de cette fonction.

Srinivas Narayanan, vice-président chargé de l'ingénierie : Nous travaillons à l'augmentation de la durée du contexte. Il n'y a pas encore de date ou d'annonce ferme.

Q : Quelle est l'importance du projet Stargate pour l'avenir de l'OpenAI ? Kevin Weil, directeur général des produits : C'est très important. Tout ce que nous avons vu suggère que plus nous avons de puissance de calcul, plus nous pouvons construire de meilleurs modèles et créer des produits de plus grande valeur.

Nous développons actuellement des modèles dans deux dimensions : une formation préalable plus importante et un apprentissage par renforcement (RL)/une formation "fraise", qui nécessitent tous deux des ressources informatiques.

Servir des centaines de millions d'utilisateurs nécessite également des ressources informatiques ! Et comme nous évoluons vers des produits d'agents plus intelligents qui peuvent travailler pour vous en permanence, cela nécessite également des ressources de calcul. Vous pouvez donc considérer Stargate comme notre usine, où l'électricité et les GPU sont convertis en produits étonnants.

Q : En interne, quel modèle utilisez-vous actuellement ? o4, o5 ou o6 ? Dans quelle mesure ces modèles internes sont-ils plus intelligents que le modèle o3 ?

Michelle Pokrass, responsable de la recherche sur l'API : Nous avons perdu le compte.

Q : Veuillez nous permettre d'interagir avec le texte/le canevas tout en utilisant des fonctions vocales avancées. Je veux pouvoir lui parler et lui faire modifier les documents de manière itérative.

Kevin Weil, Directeur des produits : Oui ! Nous disposons d'un grand nombre d'outils formidables qui ont été développés de manière relativement indépendante - l'objectif est de mettre ces outils à votre disposition le plus rapidement possible.

La prochaine étape consistera à intégrer toutes ces fonctionnalités de manière à ce que vous puissiez parler à un modèle, qui recherche et raisonne en même temps, et générer un canevas qui peut être exécuté en Python. Tous les outils doivent mieux fonctionner ensemble. D'ailleurs, tous les modèles ont besoin d'un accès complet aux outils (les modèles de la série O ne peuvent actuellement pas utiliser tous les outils), ce qui sera également mis en œuvre.

Q : Quand les modèles de la série o prendront-ils en charge la fonction de mémoire dans ChatGPT ?

Michelle Pokrass, responsable de la recherche sur l'API : C'est en cours de développement ! L'unification de toutes nos fonctionnalités avec les modèles de la série o est notre priorité absolue.

Q : Y aura-t-il des améliorations majeures pour 4o ? J'aime beaucoup le GPT personnalisé, et ce serait bien s'il pouvait être amélioré, ou si nous pouvions choisir le modèle à utiliser dans le GPT personnalisé (comme l'o3 mini).

Michelle Pokrass, responsable de la recherche sur l'API : Oui, nous n'avons pas encore terminé la série 4o !