Nitko od nas nije očekivao da će ovako započeti 2025. godina na polju umjetne inteligencije.

DeepSeek R1 doista je nevjerojatno!

Odnedavno, "tajanstvena istočnjačka sila" DeepSeek "teško kontrolira" Silicijsku dolinu.

Zamolio sam R1 da detaljno objasni Pitagorin teorem. Sve je to AI napravio u manje od 30 sekundi bez ijedne greške. Ukratko, gotovo je.

U domaćim i stranim AI krugovima, obični netizensi su otkrili nevjerojatnu i moćnu novu AI (koja je također otvorenog koda), a akademski stručnjaci su vikali “moramo je sustići”. Također se priča da su inozemne AI tvrtke već suočene s velikom prijetnjom.

Uzmite samo ovaj DeepSeek R1 koji je objavljen ovaj tjedan. Njegova čista ruta učenja za potkrepljivanje bez ikakvog nadziranog treninga je šokantna. Od razvoja baze Deepseek-v3 u prosincu prošle godine do trenutnih sposobnosti lanca razmišljanja usporedivih s OpenAI o1, čini se da je pitanje vremena.

Ali dok je AI zajednica zauzeta čitanjem tehničkih izvješća i usporedbom stvarnih mjerenja, ljudi još uvijek sumnjaju u R1: osim što može nadmašiti hrpu mjerila, može li doista voditi?

Može li izgraditi vlastite simulacije "fizičkih zakona"?

Ne vjerujete? Pustimo veliku manekenku da se igra fliperom?

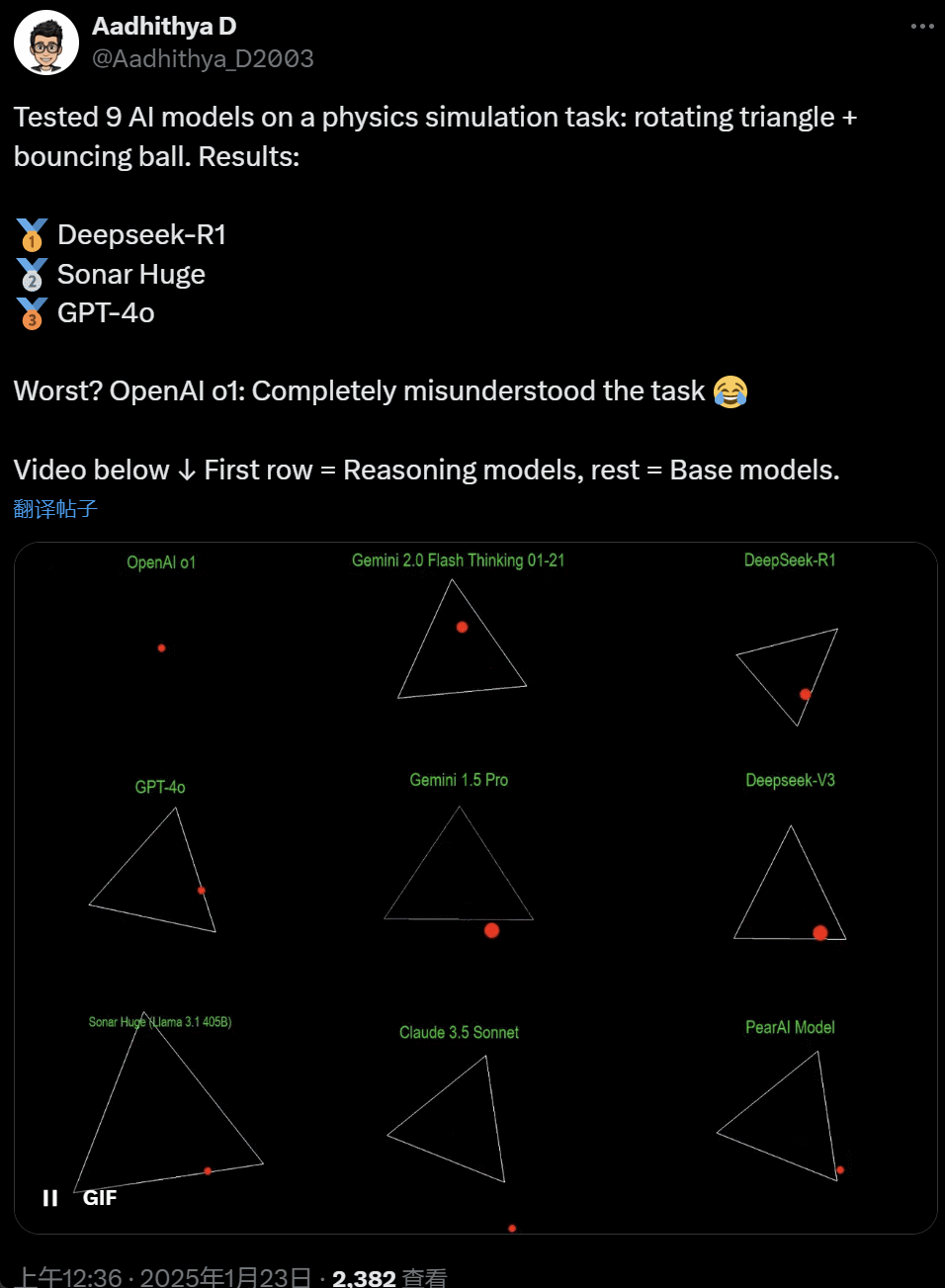

Zadnjih su dana neki ljudi u AI zajednici postali opsjednuti testom - testiranjem različitih velikih AI modela (posebno tzv. modela rasuđivanja) kako bi riješili problem: "Napišite Python skriptu da bi žuta lopta odskočila unutar određenog oblik. Neka se oblik polako okreće i pobrinite se da lopta ostane unutar oblika.”

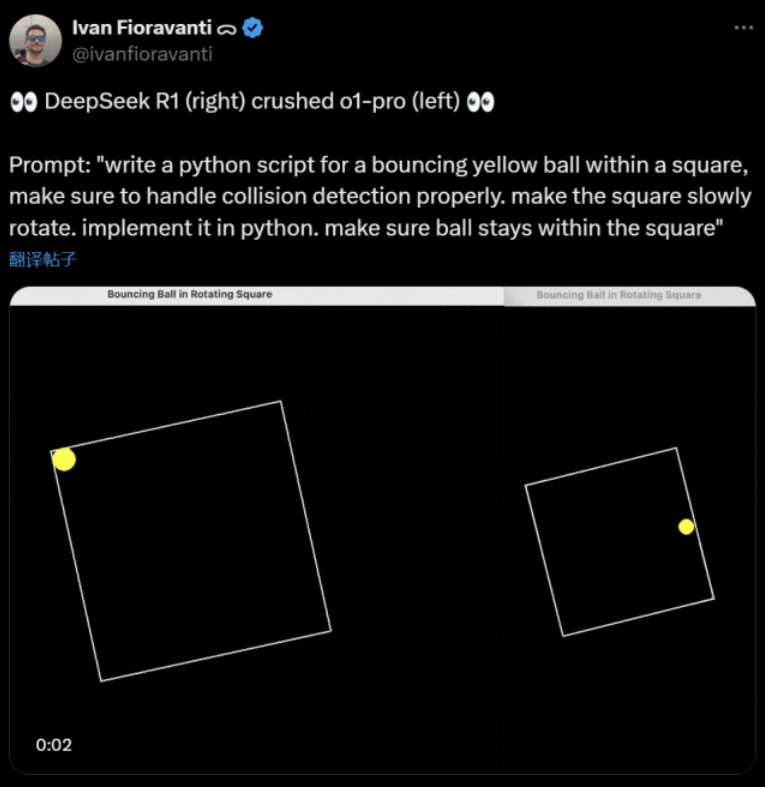

Neki modeli nadmašuju druge u ovom mjerilu "rotirajuće lopte". Prema CoreView CTO-u Ivanu Fioravantiju, DeepSeek, domaći laboratorij za umjetnu inteligenciju, ima open source veliki model R1 koji pobjeđuje OpenAI-jev o1 pro model, koji košta $200 mjesečno kao dio OpenAI-jevog ChatGPT Pro programa.

Lijevo je OpenAI o1, a desno DeepSeek R1. Kao što je gore spomenuto, upit ovdje glasi: "napišite python skriptu za žutu lopticu koja poskakuje unutar kvadrata, pobrinite se da ispravno postupite s otkrivanjem sudara. neka se kvadrat polako okreće. implementirati ga u python. pobrinite se da lopta ostane unutar kvadrata.”

Prema drugom korisniku na X-u, modeli Anthropic Claude 3.5 Sonnet i Google Gemini 1.5 Pro dali su pogrešne prosudbe o fizičkim principima, uzrokujući da lopta odstupi od svog oblika. Neki su korisnici također izvijestili da je najnoviji Googleov Gemini 2.0 Flash Thinking Experimental, kao i relativno stariji OpenAI GPT-4o, prošao procjenu odjednom.

Ali ovdje postoji način da se uoči razlika:

Korisnici mreže pod ovim tweetom rekli su: sposobnost o1 je izvorno bila vrlo dobra, ali je postala slabija nakon što je OpenAI optimizirao brzinu, čak i s verzijom članstva $200/mjesečno.

Simulacija loptice koja skače klasičan je programerski izazov. Precizna simulacija kombinira algoritme za otkrivanje sudara, koji trebaju identificirati kada se dva objekta (kao što su lopta i strana oblika) sudare. Neispravno napisan algoritam može utjecati na performanse simulacije ili uzrokovati očite fizičke pogreške.

N8 Programs, istraživač u AI startupu Nous Research, rekao je da mu je trebalo oko dva sata da od nule napiše loptu koja skače u rotirajući sedmokut. "Mora se pratiti višestruki koordinatni sustav, potrebno je razumijevanje načina na koji se rješavaju sudari u svakom sustavu, a kôd mora biti dizajniran od nule kako bi bio robustan."

Iako su loptice koje skaču i oblici koji se okreću razuman test programerskih vještina, oni su još uvijek novi projekti za velike modele, pa čak i male promjene u upitima mogu proizvesti drugačije rezultate. Dakle, ako na kraju želi postati dio benchmark testa za velike AI modele, još uvijek ga treba poboljšati.

U svakom slučaju, nakon ovog vala praktičnih testova, imamo osjećaj razlika u mogućnostima između velikih modela.

DeepSeek je novi “mit Silicijske doline

DeepSeek izaziva paniku” diljem Pacifika.

Zaposlenici Mete su objavili da "Inženjeri Mete bjesomučno analiziraju DeepSeek kako bi pokušali kopirati sve što mogu iz njega."

Alexandr Wang, osnivač pokretača AI tehnologije Scale AI, također je javno izjavio da je izvedba velikog AI modela DeepSeek otprilike jednaka najboljem modelu u Sjedinjenim Državama.

Također vjeruje da su Sjedinjene Države možda bile ispred Kine u natjecanju AI-ja tijekom proteklog desetljeća, ali DeepSeek-ovo izdanje njegovog velikog modela AI-ja moglo bi "promijeniti sve".

X Blogger @8teAPi vjeruje da DeepSeek nije "sporedni projekt", već je poput Lockheed Martinovog bivšeg "Skunk Worksa".

Takozvani "Skunk Works" odnosi se na vrlo povjerljiv, relativno neovisan mali tim koji je Lockheed Martin izvorno osnovao za razvoj mnogih naprednih zrakoplova, angažiran u istraživanju i razvoju vrhunske ili nekonvencionalne tehnologije. Od izviđačkog zrakoplova U-2 i SR-71 Blackbird do F-22 Raptora i lovca F-35 Lightning II, svi su došli odavde.

Kasnije je pojam postupno evoluirao u generički pojam koji se koristi za opisivanje "malih, ali dobrih", relativno neovisnih i fleksibilnijih inovacijskih timova uspostavljenih unutar velikih tvrtki ili organizacija.

Naveo je dva razloga:

- S jedne strane, DeepSeek ima veliki broj GPU-a, navodno više od 10.000, a Alexandr Wang, izvršni direktor Scale AI-a, čak je rekao da bi mogao doseći 50.000.

- S druge strane, DeepSeek zapošljava samo talente s tri najbolja sveučilišta u Kini, što znači da je DeepSeek jednako konkurentan kao Alibaba i Tencent.

Ove dvije činjenice same pokazuju da je DeepSeek očito postigao komercijalni uspjeh i da je dovoljno poznat da dobije te resurse.

Što se tiče troškova razvoja DeepSeek, bloger je rekao da kineske tehnološke tvrtke mogu dobiti razne subvencije, poput niskih troškova električne energije i korištenja zemljišta.

Stoga je vrlo vjerojatno da je većina troškova DeepSeek “smještena” na račun izvan osnovne djelatnosti ili u obliku neke vrste subvencije za izgradnju podatkovnog centra.

Čak osim osnivača, nitko u potpunosti ne razumije sve financijske aranžmane. Neki sporazumi mogu biti jednostavno "usmeni sporazumi" koji su finalizirani samo na temelju reputacije.

Bez obzira na to, nekoliko stvari je jasno:

- Model je izvrstan, usporediv s verzijom koju je OpenAI objavio prije dva mjeseca, a naravno moguće je da nije tako dobar kao novi modeli koje OpenAI i Anthropic tek trebaju objaviti.

- Iz trenutne perspektive, smjerom istraživanja još uvijek dominiraju američke tvrtke. Model DeepSeek je "brzi nastavak" verzije o1, ali DeepSeek napreduje u istraživanju i razvoju vrlo brzo, nadoknađujući korak brže od očekivanog. Oni ne plagiraju niti varaju, u najboljem su slučaju obrnuti inženjering.

- DeepSeek uglavnom obučava vlastite talente, umjesto da se oslanja na doktore znanosti školovane u Americi, što uvelike proširuje fond talenata.

- U usporedbi s američkim tvrtkama, DeepSeek podliježe manjem broju ograničenja u smislu licenciranja intelektualnog vlasništva, privatnosti, sigurnosti, politike itd., a postoji i manje zabrinutosti zbog pogrešne upotrebe podataka o kojima ljudi ne žele biti obučeni. Manje je tužbi, manje odvjetnika i manje briga.

Nema sumnje da sve više ljudi vjeruje da će 2025. biti odlučujuća godina. U međuvremenu, tvrtke se pripremaju za to. Meta, na primjer, gradi podatkovni centar od 2 GW+, s procijenjenim ulaganjem od $60-65 milijardi do 2025., a do kraja godine imat će više od 1,3 milijuna GPU-a.

Meta je čak upotrijebila grafikon za usporedbu svog podatkovnog centra od 2 gigavata s Manhattanom u New Yorku.

Ali sada je DeepSeek prošao bolje s nižom cijenom i manje GPU-a. Kako ovo ne učiniti ljude zabrinutima?

Yann LeCun: Moramo zahvaliti tehničkom direktoru i suosnivaču the open source

Hiperbolično, Yuchen Jin, što si objavio da nam je u samo 4 dana DeepSeek-R1 dokazao 4 činjenice:

- Umjetna inteligencija otvorenog koda zaostaje samo 6 mjeseci za umjetnom inteligencijom zatvorenog koda

- Kina dominira u konkurenciji AI otvorenog koda

- Ulazimo u zlatno doba učenja s potkrepljenjem velikih jezičnih modela

- Modeli destilacije vrlo su moćni, a mi ćemo pokrenuti visoko inteligentnu umjetnu inteligenciju na mobilnim telefonima

Lančana reakcija koju je pokrenuo DeepSeek još uvijek se nastavlja, kao što je OpenAI o3-mini koji je besplatno dostupan, nada u zajednici da će smanjiti nejasne rasprave o AGI/ASI i glasine da je Meta u panici.

Smatra da je teško prognozirati tko će na kraju pobijediti, ali ne treba zaboraviti snagu prednosti kasnopridošlice. Uostalom, svi znamo da je Google izmislio Transformer, dok je OpenAI otključao njegov pravi potencijal.

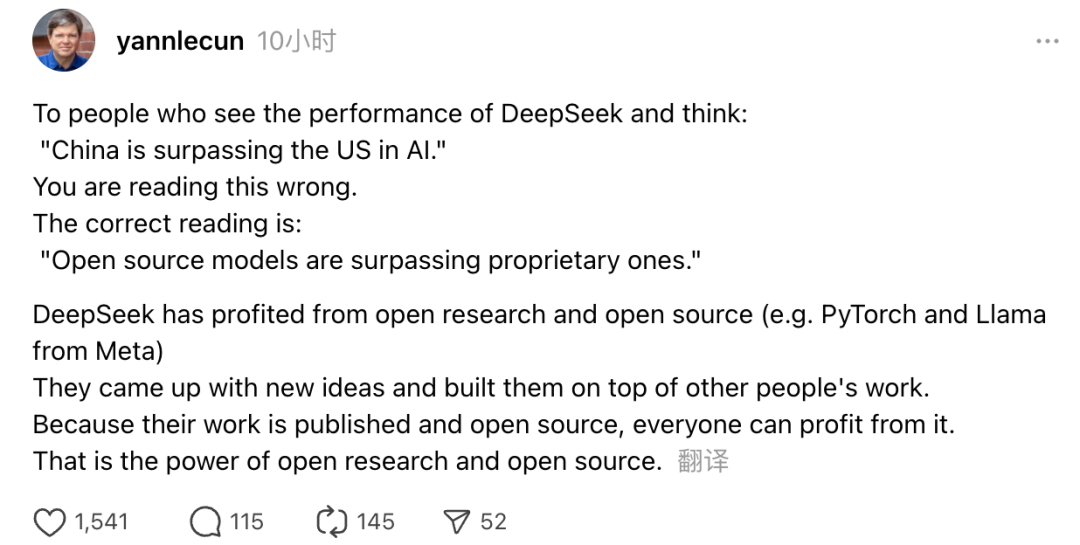

Osim toga, dobitnik Turingove nagrade i Metin glavni znanstvenik za umjetnu inteligenciju Yann LeCun također je izrazio svoje stavove.

“Za one koji, nakon što vide izvedbu DeepSeek, pomisle, 'Kina prestiže SAD u AI-u,' griješite. Ispravno shvaćanje je da modeli otvorenog koda potiskuju vlasničke modele.”

LeCun je rekao da je razlog zbog kojeg je DeepSeek ovaj put napravio toliku buku jer su imali koristi od otvorenog istraživanja i otvorenog koda (kao što su Meta's PyTorch i Llama). DeepSeek je smislio nove ideje i nadogradio ih na rad drugih. Budući da je njihov rad javno objavljen i otvorenog koda, svatko može imati koristi od njega. To je moć otvorenog istraživanja i otvorenog koda.

Razmišljanja korisnika interneta se nastavljaju. Iako su uzbuđeni zbog razvoja novih tehnologija, mogu osjetiti i malu atmosferu tjeskobe. Uostalom, pojava DeepSeekers mogla bi imati pravi utjecaj.