Nikt z nas nie spodziewał się, że tak rozpocznie się rok 2025 w dziedzinie sztucznej inteligencji.

DeepSeek R1 jest naprawdę niesamowity!

Ostatnio "tajemnicza wschodnia potęga" DeepSeek "mocno kontroluje" Dolinę Krzemową.

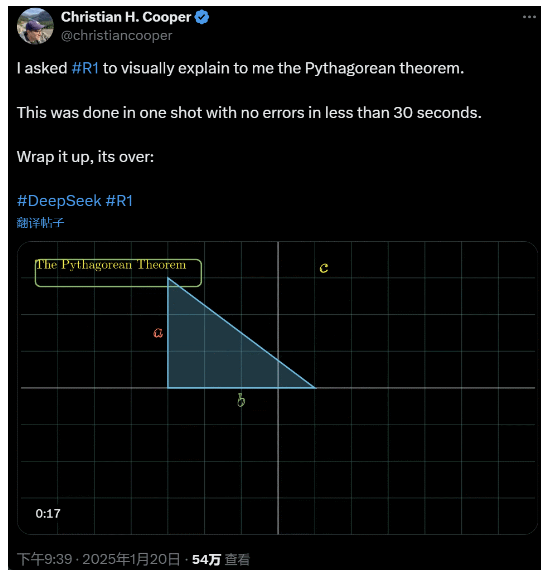

Poprosiłem R1 o szczegółowe wyjaśnienie twierdzenia Pitagorasa. Wszystko to zostało wykonane przez AI w mniej niż 30 sekund bez żadnych błędów. Krótko mówiąc, to koniec.

W krajowych i zagranicznych kręgach AI zwykli internauci odkryli niesamowitą i potężną nową sztuczną inteligencję (która jest również open source), a eksperci akademiccy krzyczeli "musimy nadrobić zaległości". Krążą również pogłoski, że zagraniczne firmy zajmujące się sztuczną inteligencją już stoją w obliczu poważnego zagrożenia.

Wystarczy wziąć pod uwagę DeepSeek R1 wydany w tym tygodniu. Jego czysta ścieżka uczenia się ze wzmocnieniem bez żadnego nadzorowanego szkolenia jest szokująca. Od opracowania bazy Deepseek-v3 w grudniu ubiegłego roku do obecnych możliwości łańcucha myślenia porównywalnych z OpenAI o1, wydaje się to być kwestią czasu.

Ale podczas gdy społeczność AI jest zajęta czytaniem raportów technicznych i porównywaniem rzeczywistych pomiarów, ludzie wciąż mają wątpliwości co do R1: poza tym, że jest w stanie przewyższyć kilka benchmarków, czy naprawdę może prowadzić?

Czy może budować własne symulacje "praw fizycznych"?

Nie wierzysz w to? Pozwólmy wielkiemu modelowi pobawić się pinballem?

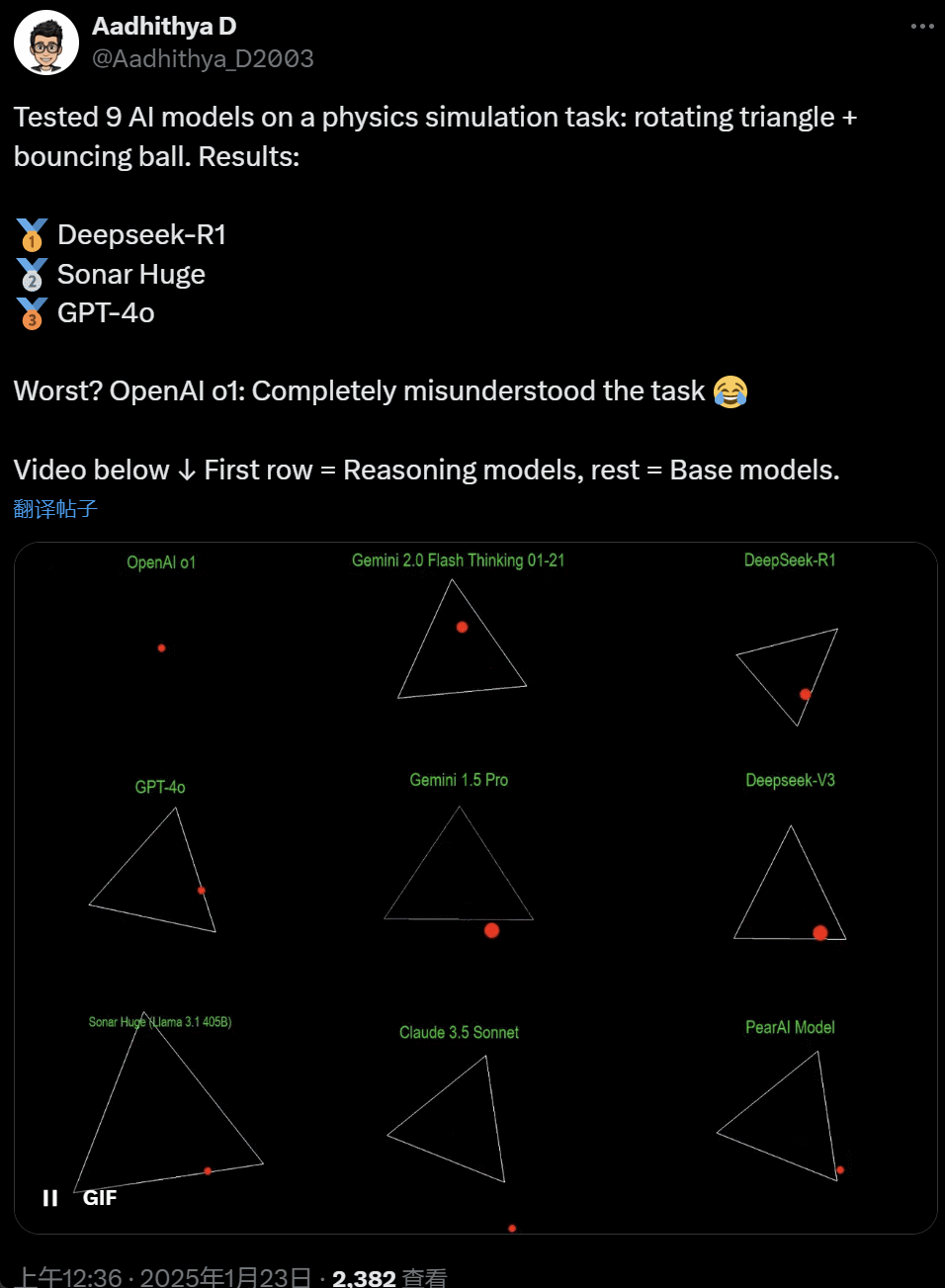

W ostatnich dniach niektórzy ludzie w społeczności AI mają obsesję na punkcie testów - testowania różnych dużych modeli AI (zwłaszcza tak zwanych modeli rozumowania) w celu rozwiązania problemu: "Napisz skrypt Pythona, aby żółta piłka odbiła się wewnątrz pewnego kształtu. Spraw, by kształt obracał się powoli i upewnij się, że piłka pozostaje wewnątrz kształtu".

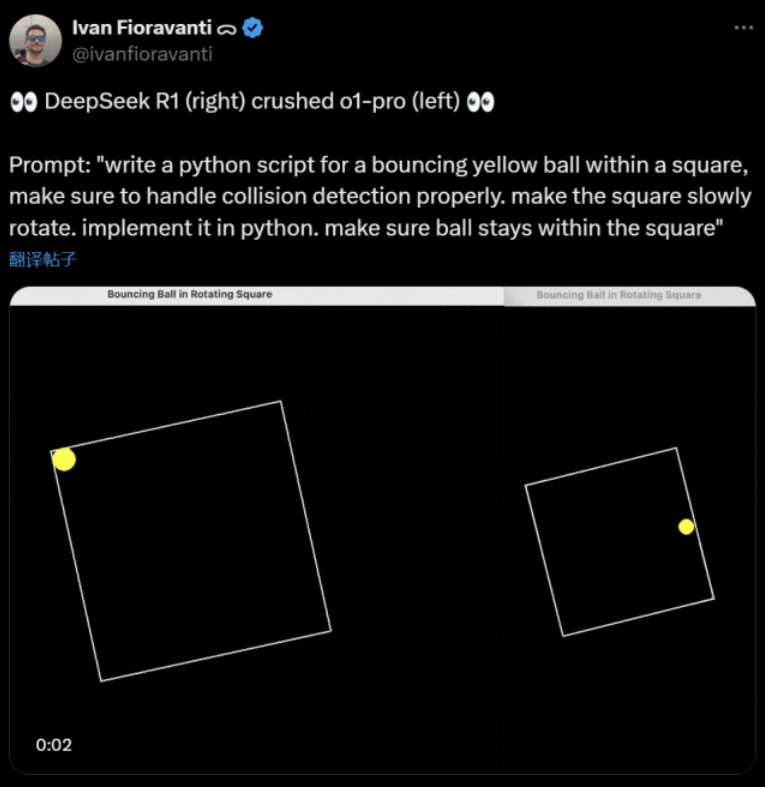

Niektóre modele przewyższają inne w tym teście porównawczym "obracającej się kuli". Według CoreView CTO Ivan Fioravanti, DeepSeek, krajowe laboratorium sztucznej inteligencji, ma duży model R1 o otwartym kodzie źródłowym, który bije model o1 pro OpenAI, który kosztuje $200 miesięcznie w ramach programu ChatGPT Pro OpenAI.

Po lewej stronie znajduje się OpenAI o1, a po prawej DeepSeek R1. Jak wspomniano powyżej, polecenie jest następujące: "napisz skrypt Pythona dla odbijającej się żółtej piłki w kwadracie, upewnij się, że prawidłowo obsługuje wykrywanie kolizji. spraw, aby kwadrat powoli się obracał. zaimplementuj to w Pythonie. upewnij się, że piłka pozostaje w kwadracie".

Według innego użytkownika na X, modele Anthropic Claude 3.5 Sonnet i Google Gemini 1.5 Pro błędnie oceniały zasady fizyczne, powodując, że piłka odbiegała od swojego kształtu. Niektórzy użytkownicy zgłosili również, że najnowszy model Google Gemini 2.0 Flash Thinking Experimental, a także stosunkowo starszy model OpenAI GPT-4o, od razu przeszły ocenę.

Jest jednak sposób, by to rozróżnić:

Internauci pod tym tweetem stwierdzili: zdolność o1 była początkowo bardzo dobra, ale osłabła po zoptymalizowaniu prędkości przez OpenAI, nawet w wersji członkostwa $200 / miesiąc.

Symulacja odbijającej się piłki to klasyczne wyzwanie programistyczne. Dokładna symulacja łączy w sobie algorytmy wykrywania kolizji, które muszą identyfikować, kiedy dwa obiekty (takie jak piłka i bok kształtu) zderzają się ze sobą. Nieprawidłowo napisany algorytm może wpływać na wydajność symulacji lub powodować oczywiste błędy fizyczne.

N8 Programs, badacz w startupie AI Nous Research, powiedział, że napisanie od podstaw odbijającej się piłki w obracającym się sześciokącie zajęło mu około dwóch godzin. "Konieczne jest śledzenie wielu układów współrzędnych, zrozumienie, w jaki sposób kolizje są obsługiwane w każdym systemie, a kod musi być zaprojektowany od podstaw, aby był solidny".

Chociaż odbijające się piłki i wirujące kształty są rozsądnym testem umiejętności programistycznych, są to wciąż nowe projekty dla dużych modeli, a nawet niewielkie zmiany w podpowiedziach mogą dawać różne wyniki. Jeśli więc ma on ostatecznie stać się częścią testu porównawczego dla dużych modeli sztucznej inteligencji, nadal wymaga ulepszenia.

W każdym razie, po tej fali testów praktycznych, mamy poczucie różnic w możliwościach między dużymi modelami.

DeepSeek to nowy "mit Doliny Krzemowej

DeepSeek wywołuje panikę" na całym Pacyfiku.

Pracownicy Meta napisali, że "inżynierowie Meta gorączkowo analizują DeepSeek, próbując skopiować z niego wszystko, co się da".

Alexandr Wang, założyciel startupu Scale AI zajmującego się technologią AI, również publicznie stwierdził, że wydajność dużego modelu AI DeepSeek jest w przybliżeniu równoważna z najlepszym modelem w Stanach Zjednoczonych.

Uważa również, że Stany Zjednoczone mogły wyprzedzić Chiny w konkurencji AI w ciągu ostatniej dekady, ale wydanie przez DeepSeek dużego modelu AI może "wszystko zmienić".

X Blogger @8teAPi uważa, że DeepSeek nie jest "projektem pobocznym", ale jest jak dawne "Skunk Works" Lockheed Martin.

"Skunk Works" odnosi się do wysoce poufnego, stosunkowo niezależnego małego zespołu, który Lockheed Martin pierwotnie utworzył w celu opracowania wielu zaawansowanych samolotów, zaangażowanych w badania i rozwój najnowocześniejszych lub niekonwencjonalnych technologii. Od samolotów zwiadowczych U-2 i SR-71 Blackbird po myśliwce F-22 Raptor i F-35 Lightning II - wszystkie one pochodzą z tego miejsca.

Później termin ten stopniowo ewoluował do ogólnego terminu używanego do opisania "małych, ale dobrych", stosunkowo niezależnych i bardziej elastycznych zespołów innowacyjnych utworzonych w dużych firmach lub organizacjach.

Podał dwa powody:

- Z jednej strony, DeepSeek ma dużą liczbę procesorów graficznych, podobno ponad 10 000, a Alexandr Wang, dyrektor generalny Scale AI, powiedział nawet, że może osiągnąć 50 000.

- Z drugiej strony, DeepSeek rekrutuje talenty tylko z trzech najlepszych uniwersytetów w Chinach, co oznacza, że DeepSeek jest tak samo konkurencyjny jak Alibaba i Tencent.

Już same te dwa fakty pokazują, że DeepSeek odniósł wyraźny sukces komercyjny i jest wystarczająco znany, aby uzyskać te zasoby.

Jeśli chodzi o koszty rozwoju DeepSeek, bloger powiedział, że chińskie firmy technologiczne mogą otrzymywać różne dotacje, takie jak niskie koszty energii elektrycznej i użytkowania gruntów.

Dlatego jest bardzo prawdopodobne, że większość kosztów DeepSeek została "umieszczona" na koncie poza główną działalnością lub w formie pewnego rodzaju dotacji na budowę centrum danych.

Nawet poza założycielami, nikt w pełni nie rozumie wszystkich ustaleń finansowych. Niektóre umowy mogą być po prostu "umowami ustnymi", które są finalizowane wyłącznie na podstawie reputacji.

Niezależnie od tego, kilka rzeczy jest jasnych:

- Model jest doskonały, porównywalny z wersją wydaną przez OpenAI dwa miesiące temu i oczywiście możliwe jest, że nie jest tak dobry jak nowe modele, które OpenAI i Anthropic jeszcze nie wydały.

- Z obecnej perspektywy kierunek badań jest nadal zdominowany przez firmy amerykańskie. Model DeepSeek jest "szybką kontynuacją" wersji o1, ale postęp badań i rozwoju DeepSeek jest bardzo szybki, nadrabiając zaległości szybciej niż oczekiwano. Nie plagiatują ani nie oszukują, co najwyżej stosują inżynierię wsteczną.

- DeepSeek szkoli głównie własne talenty, zamiast polegać na amerykańskich doktorach, co znacznie rozszerza pulę talentów.

- W porównaniu z firmami amerykańskimi, DeepSeek podlega mniejszym ograniczeniom w zakresie licencjonowania własności intelektualnej, prywatności, bezpieczeństwa, polityki itp. i istnieje mniej obaw związanych z niewłaściwym wykorzystaniem danych, na których ludzie nie chcą być szkoleni. Jest mniej pozwów sądowych, mniej prawników i mniej obaw.

Nie ma wątpliwości, że coraz więcej osób wierzy, że rok 2025 będzie decydujący. W międzyczasie firmy przygotowują się do tego. Meta, na przykład, buduje centrum danych o mocy 2 GW+, z inwestycją szacowaną na $60-65 miliardów do 2025 roku, a do końca roku będzie mieć ponad 1,3 miliona procesorów graficznych.

Meta użyła nawet wykresu, aby porównać swoje 2-gigawatowe centrum danych z Manhattanem w Nowym Jorku.

Ale teraz DeepSeek poradził sobie lepiej z niższymi kosztami i mniejszą liczbą procesorów graficznych. Jak to może nie wzbudzać niepokoju?

Yann LeCun: Musimy podziękować CTO i współzałożycielowi firmy w open source

Hiperboliczny, Yuchen Jin, za opublikowanie, że w ciągu zaledwie 4 dni DeepSeek-R1 udowodnił nam 4 fakty:

- Sztuczna inteligencja open source jest tylko 6 miesięcy za sztuczną inteligencją zamkniętą

- Chiny dominują w konkursie open source AI

- Wkraczamy w złotą erę uczenia ze wzmocnieniem dużych modeli językowych

- Modele destylacyjne są bardzo potężne i będziemy uruchamiać wysoce inteligentną sztuczną inteligencję na telefonach komórkowych

Reakcja łańcuchowa wywołana przez DeepSeek nadal trwa, na przykład udostępnienie OpenAI o3-mini, nadzieja społeczności na ograniczenie niejasnych dyskusji na temat AGI / ASI oraz plotka, że Meta jest w panice.

Uważa on, że trudno jest przewidzieć, kto ostatecznie wygra, ale nie powinniśmy zapominać o sile przewagi spóźnialskich. W końcu wszyscy wiemy, że to Google wynalazł Transformera, podczas gdy OpenAI odblokowało jego prawdziwy potencjał.

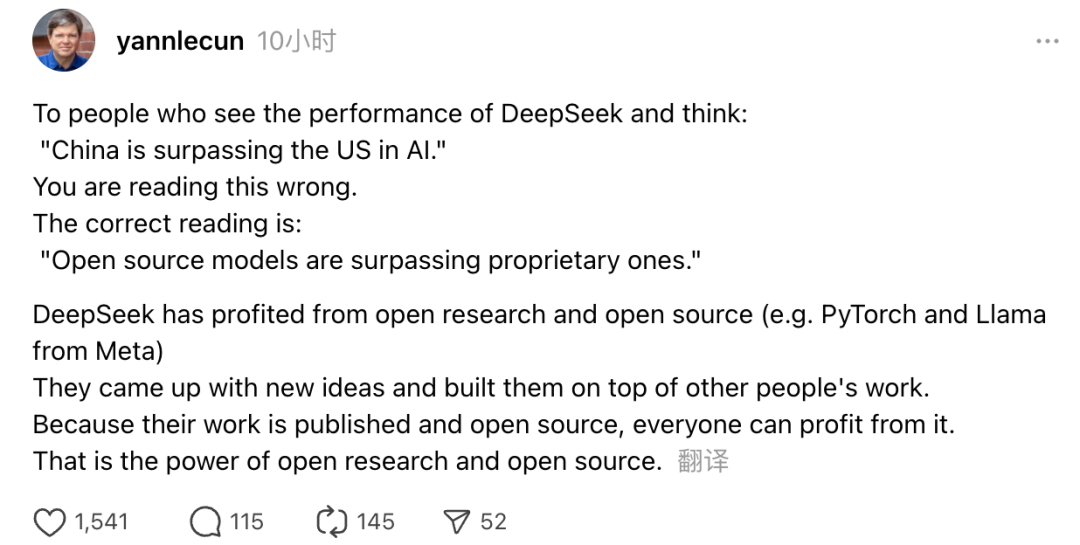

Ponadto swoje poglądy wyraził również laureat nagrody Turinga i główny naukowiec Meta ds. sztucznej inteligencji, Yann LeCun.

"Ci, którzy widząc wydajność DeepSeek, myślą: "Chiny wyprzedzają USA w dziedzinie sztucznej inteligencji", są w błędzie. Prawidłowe zrozumienie jest takie, że modele open source wyprzedzają modele własnościowe".

LeCun powiedział, że powodem, dla którego DeepSeek zrobił taki plusk tym razem, jest to, że skorzystali z otwartych badań i otwartego oprogramowania (takich jak PyTorch i Llama firmy Meta). DeepSeek wpadł na nowe pomysły i oparł się na pracy innych. Ponieważ ich praca jest publicznie dostępna i open source, każdy może z niej skorzystać. Na tym polega siła otwartych badań i otwartego oprogramowania.

Refleksje internautów nie ustają. Chociaż są podekscytowani rozwojem nowych technologii, mogą również odczuwać lekką atmosferę niepokoju. W końcu pojawienie się DeepSeekers może mieć realny wpływ.